文章目录

前言

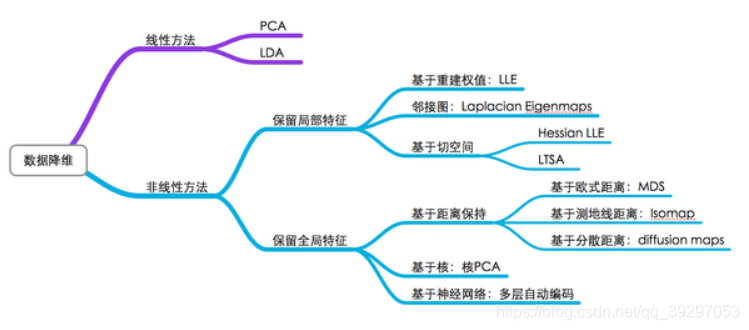

机器学习尤其是深度学习中最常见的问题就是过拟合问题,而解决过拟合问题主要有三种思路:直接提高数据集容量;正则化;降维。而降维也主要分为三种:直接降维(特征选择);线性降维(PCA,MDS);非线性降维(LLS,Isomap)

提示:本文讲解降维中的PCA和LLE算法

一、维度灾难是什么?

当维度增加时,空间的体积增加得很快,使得可用的数据变得稀疏。稀疏性对于任何要求有统计学意义的方法而言都是一个问题,为了获得在统计学上正确并且有可靠的结果,用来支撑这一结果所需要的数据量通常随着维数的提高而呈指数级增长。而且,在组织和搜索数据时也有赖于检测对象区域,这些区域中的对象通过相似度属性而形成分组。然而在高维空间中,所有的数据都很稀疏,从很多角度看都不相似,因而平常使用的数据组织策略变得极其低效。这时候便需要降维处理。

二、主成分分析法(PCA)

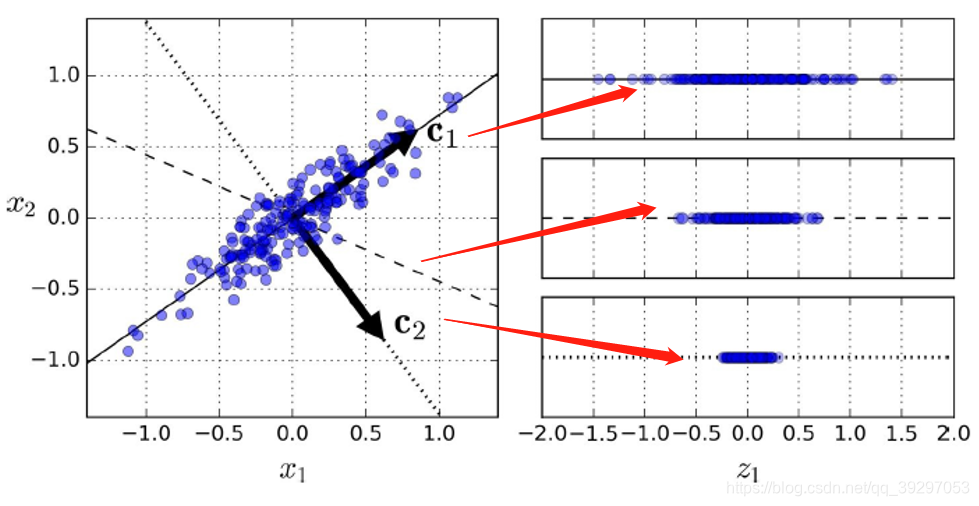

PCA最受欢迎的降维方法,它确定最靠近数据的超平面,然后将数据投影到其上。

PCA的核心理念是对原始特征空间的重构,重构的依据是最大投影方差和最小重构距离。

如图:原始的特征向量是一个二维空间(平面),PCA的目的是找到一条最佳向量如图c1,将高维的特征映射到低维空间去(线)。映射的方法就是之前提到的最大投影距离或最小重构距离。

但是,某些情况下,PCA难以找到合适的解。

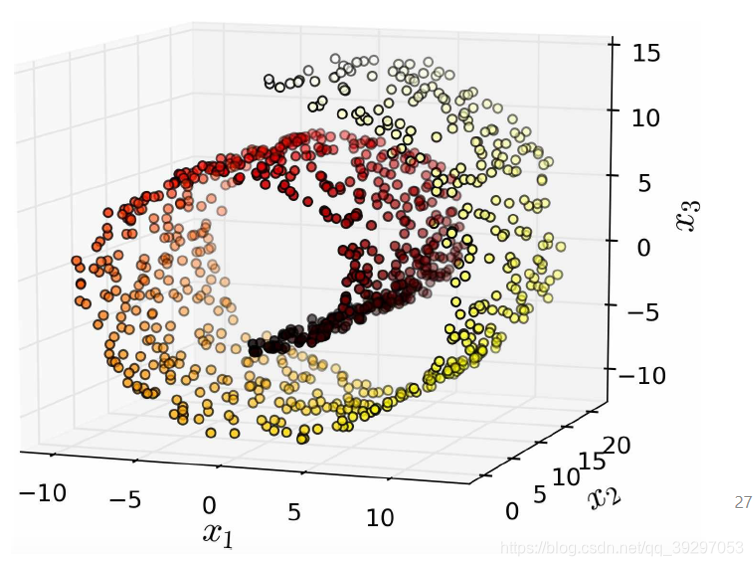

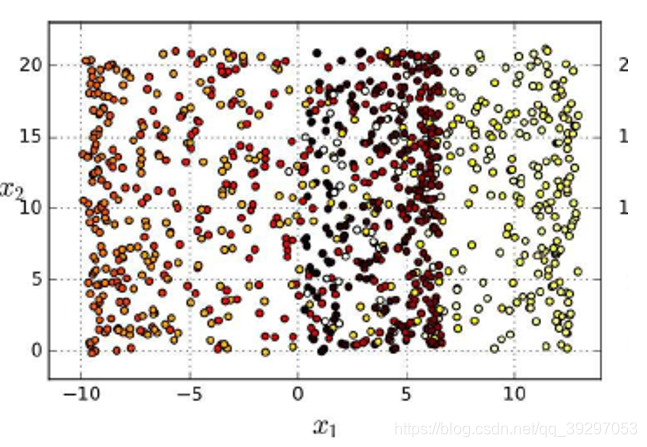

如图,对于这种流体/卷形状的特征分布,PCA难以找到一个合适的平面去降维,结果如下。此时就需要通过局部线性嵌入来解决问题。

三,局部线性嵌入

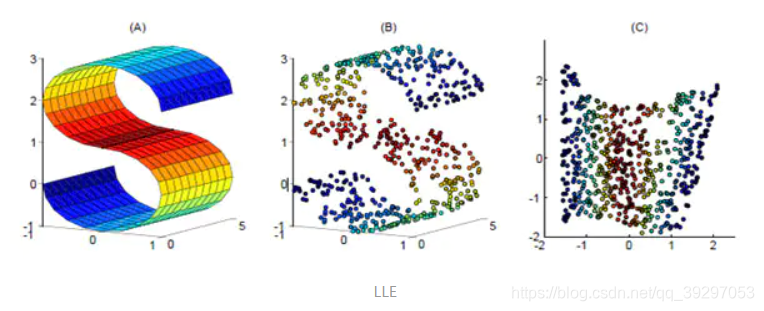

Locally linear embedding(LLE)是一种非线性降维算法,它能够使降维后的数据较好地保持原有流形结构。LLE可以说是流形学习方法最经典的工作之一。很多后续的流形学习、降维方法都与LLE有密切联系。

见图1,使用LLE将三维数据(b)映射到二维(c)之后,映射后的数据仍能保持原有的数据流形(红色的点互相接近,蓝色的也互相接近),说明LLE有效地保持了数据原有的流行结构。

但是LLE在有些情况下也并不适用,如果数据分布在整个封闭的球面上,LLE则不能将它映射到二维空间,且不能保持原有的数据流形。那么我们在处理数据中,首先假设数据不是分布在闭合的球面或者椭球面上。

总结

除了以上介绍的降维方式,其他的降维手段总汇如图所示: