版权声明:转载请注明出处网址 :) https://blog.csdn.net/qq_36810398/article/details/89788639

1.PCA降维的计算过程

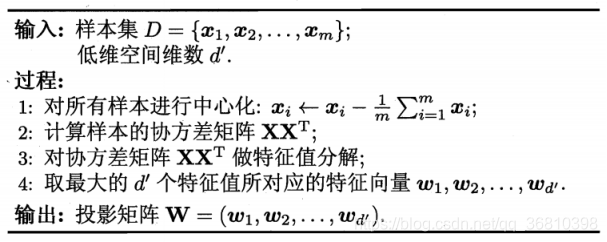

下图是从西瓜书里截取的PCA降维过程的图片。

需要说明的是,算法中的向量为列向量。假设原始维度为d,样本数目为m,因此特征矩阵X的维度为d×m,W的维度为d×d’。降维的时候,transpose(W)*X得到 d’×m的矩阵,它的每一列,即为降维后的向量。

2.数学推导

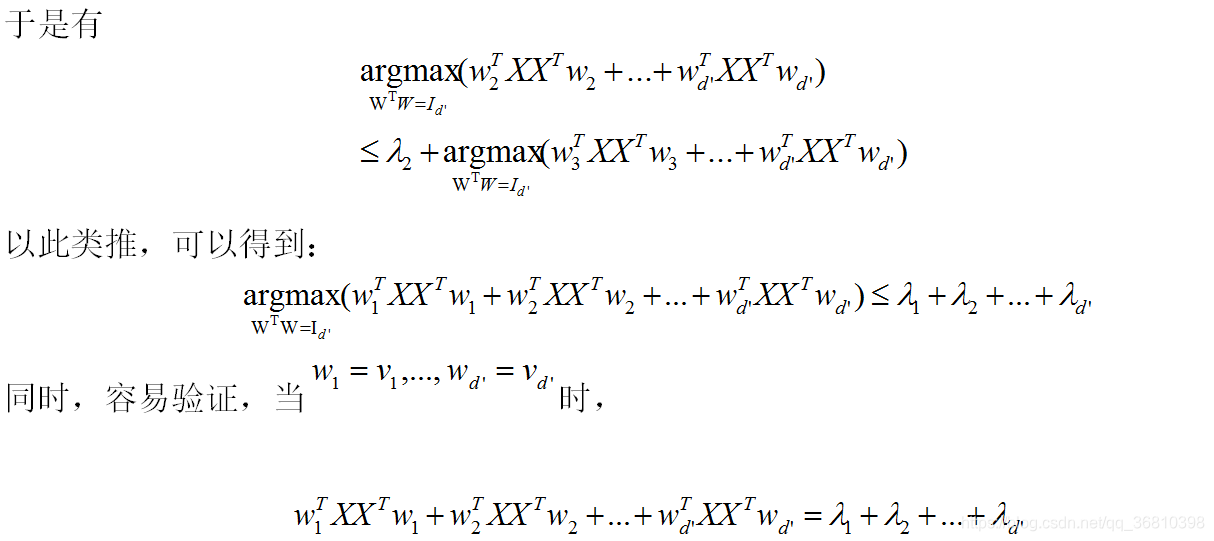

不过西瓜书里没有详细推导(我查了好几本书,包括DeepLearning和Hands On ML,都没有写详细推导,DeepLearning是作为一个练习让读者自己做)——为什么选取最大的d’个特征值所对应的特征向量就可以组成投影矩阵?结合DeepLearning里的部分过程,我补全了一个类似的证明。不排除有不对的地方,供有需要的朋友参考。

(a)PCA的目标

d维空间的向量x映射到d’维空间中y,PCA是用线性映射,假设有

y=transpose(W)*x,

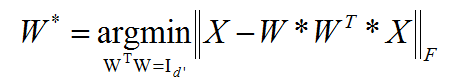

对于整个特征表Y=transpose(W)*X,得到 X=W*Y,PCA希望得到一个W,降维之后再还原回来,越接近原始数据越好,亦即希望X和W*transpose(W)*X越接近越好。用矩阵范数来衡量二者的接近程度,如用Frobenies范数来表示(矩阵每个元素的平方和再开方,不同的范数是等价的,用其他矩阵范数不影响结果)。

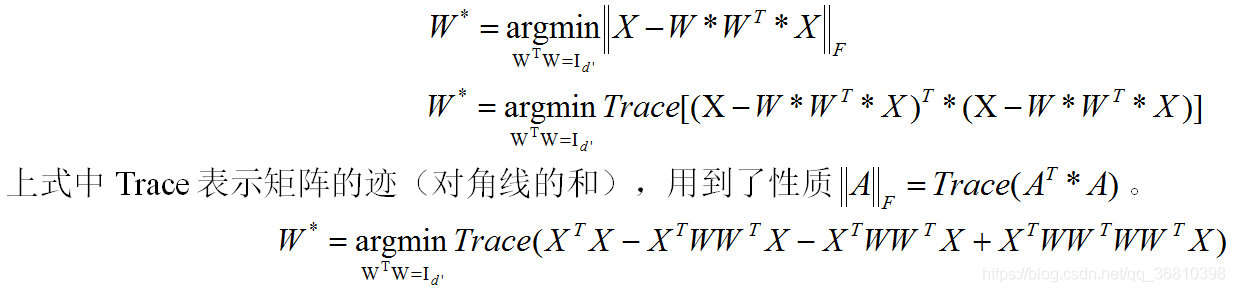

因此PCA的目标是求解W(其实是d’维空间中的一组基,不妨设其为标准正交基),使得:

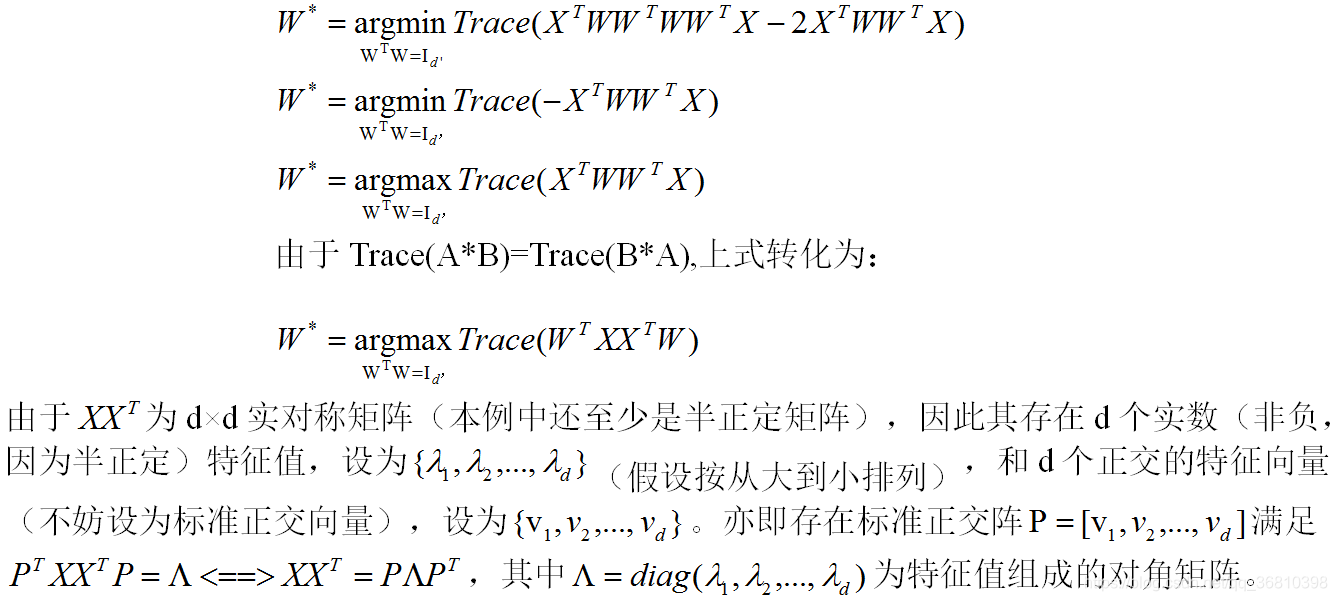

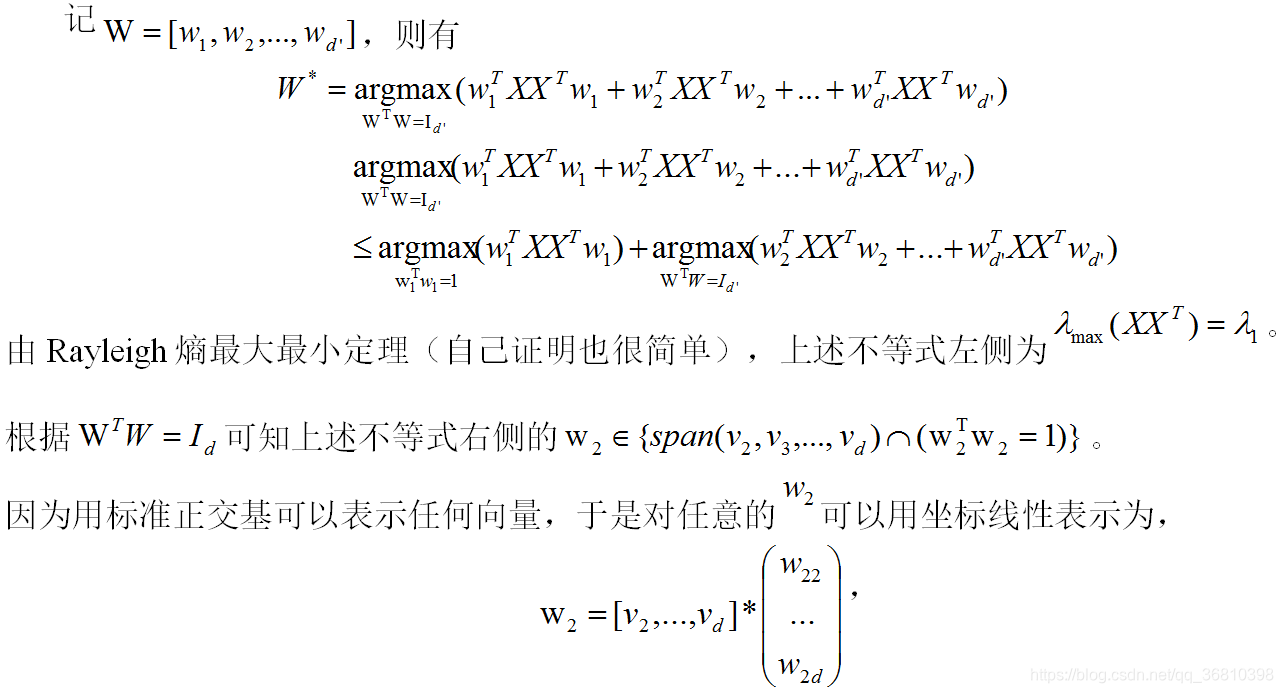

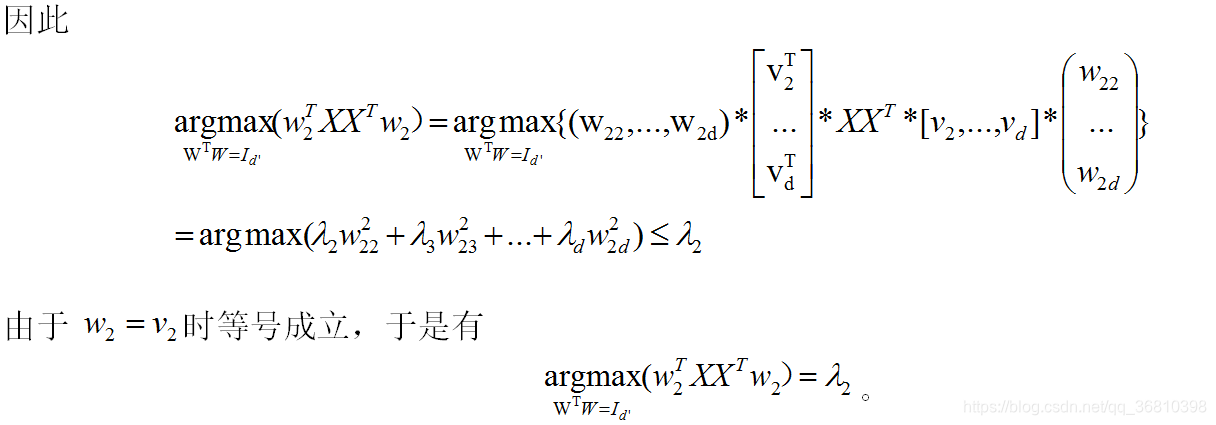

(b)求解