定义:逻辑回归假设数据服从伯努利分布,通过极大化似然函数的方法,运用梯度下降来求解参数,来达到将数据二分类的目的。

输入:逻辑回归的输入是一个线性组合,与线性回归一样,但是输出变成了概率。通过伯努利(类似抛硬币的概率分布)的概率公式我们可以得到sigmoid函数。

逻辑回归的最终形式:

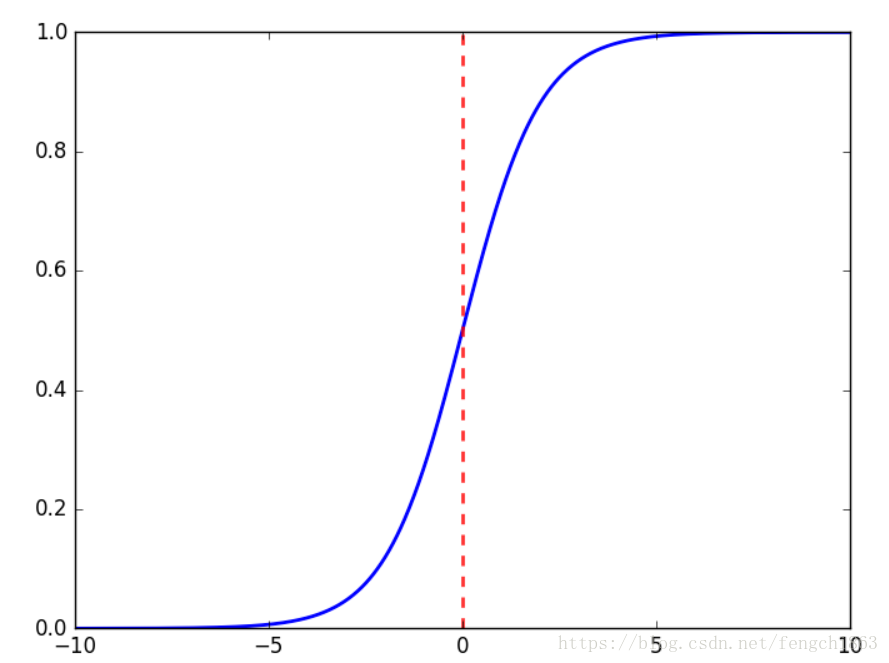

函数图像如下图,一般按0.5分类。

逻辑回归的损失函数是它的极大似然函数:

这个极大似然函数无法直接求解,所以通过对它梯度下降来不断逼近最优解。

处理过拟合:取L1或L2正则化,通过对权重增加惩罚来防止过拟合。一般使用L2正则化,L1正则化是截断效应,L2正则化是缩放效应。

优点:

1)形式简单,可解释性好,可以从权重的大小看到不同的特征对最后结果的影响,从而可以筛选出前k个影响最大的特征;

2)模型效果不错,可以作为baseline,如果特征工程做得好,效果就不会太差;

3)训练速度快,计算量只和特征的数据相关,资源占用小,尤其是内存,因为只需要存储各个维度的特征值;

4)方便输出结果调整,对最后输出的概率分数进行阈值划分,样本结果大于某个阈值的是一类,小于某个阈值的是一类;

缺点:

1)准确率不是很高,因为形式非常的简单;

2)很难处理数据不平衡的情况(此处可以说一下有哪些方法处理不平衡);

3)处理非线性数据比较麻烦;