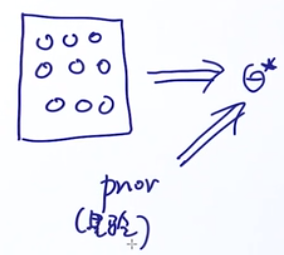

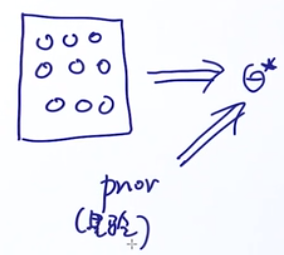

Intuition Behind

MLE:最大似然估计Maximum likelihood estimation

MAP:最大后验估计Maximum a posterion estimation

记录这个主要原因是之前看李航老师的《统计方法学》的时候,这里没搞懂,现在做个记录,网上其实有很多文章,但是没有讲出来这两个东西实际上有什么关系。

之前说了,我们搞机器学习就是要找到一个模型,然后解出这个模型的参数,这两个方法都是用来构建目标函数求解参数的。

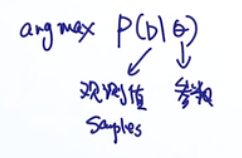

MLE

在估计参数的过程中,仅仅靠观测到的数据来进行估计最好的那个参数。

如果丢一个不均匀的硬币:正正正反反正

那么从结果可以推算参数:

θ=2/3

MAP

如果丢一个不均匀的硬币:正正正反反正,然后我们从小道消息知道这个硬币的先验概率是80%

那么从结果可以推算参数:

67%<θ<80%

但是如果我丢的次数足够多,例如一万次后,从结果统计到参数应该是70%,那么这个时候的先验信息其实不重要了(随着样本量的增加,先验越来越不重要)。

Mathematical Formulation

MLE

公式:

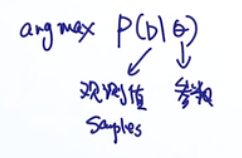

MAP

公式:

分母那里由于是常数,求最大值的时候可以忽略。

可以看到MAP比MLE多的就是先验概率这一项,那我们如果使用不同的先验概率,会有什么不一样?

下面来看看

先验与正则

以逻辑回归为例,先看MLE:

argθmaxp(D∣θ)=argw,bmaxp(y∣x,w)=argw,bmaxi=1∏np(yi∣xi,w,b)=argw,bmaxi=1∑nlogp(yi∣xi,w,b)

不看偏置:

argwmaxi=1∑nlogp(yi∣xi,w)

再看MAP:

argθmaxp(θ∣D)=argθmaxp(D∣θ)⋅p(θ)=argθmaxlogp(D∣θ)+logp(θ)=argw,bmaxi=1∑nlogp(yi∣xi,w,b)+logp(w,b)

不看偏置,

θ=w

argwmaxi=1∑nlogp(yi∣xi,w)+logp(w)(1)

From Gaussian Prior to L2 Regularization

我们先定义一个服从正态搞屎分布的

p(θ)=p(w)∼N(0,σ2),这里的高斯分布的

μ取0是可以的,因为分布总是可以通过平移使得

μ=0

根据搞屎分布的pdf(概率密度函数):

.

p(w)=2π

σ1exp(−2σ2w2)(2)

然后,把公式(2)带入(1)的后面那项:

logp(w)=log(2π

σ1exp(−2σ2w2))=−log(2π

σ)−2σ2w2

再带回(1):

argwmaxi=1∑nlogp(yi∣xi,w)−log(2π

σ)−2σ2w2

由于

σ是已知的,所以

−log(2π

σ)属于常数项,求极值可以忽略,整个目标函数变成:

argwmaxi=1∑nlogp(yi∣xi,w)−2σ21w2

换成求最小值问题,加负号:

−argwmini=1∑nlogp(yi∣xi,w)+2σ21∣∣w∣∣2

那么,我们可以把

2σ21看做

λ

From Laplace Prior to L1 Regularization

这次我们定义一个拉普拉屎分布:

p(θ)=p(w)∼Laplace(μ,b),这里的拉普拉屎分布的

μ取0是可以的,因为分布总是可以通过平移使得

μ=0:

p(θ)=p(w)∼Laplace(0,b)

根据拉普拉屎分布的pdf(概率密度函数):

p(w)=2b1exp(−b∣w∣)(3)

然后,把公式(3)带入(1)的后面那项:

logp(w)=log[2b1exp(−b∣w∣)]=log(2b1)−b∣w∣

再带回(1):

.

argwmaxi=1∑nlogp(yi∣xi,w)+log(2b1)−b∣w∣

由于

b是已知的,所以

log(2b1)属于常数项,求极值可以忽略,整个目标函数变成:

argwmaxi=1∑nlogp(yi∣xi,w)−b∣w∣

换成求最小值问题,加负号:

−argwmini=1∑nlogp(yi∣xi,w)+b1∣w∣

那么,我们可以把

b1看做

λ

小结

Adding Prior is Equivalent to Regularization

这个不但适用于逻辑回归,而且适用于其他模型,而且我们通过上面的推导知道:

加高斯分布的先验就相当于加L2正则项;

加拉普拉斯分布的先验就相当于加L1正则项。

MAP approaches to MLE solution

之前说了:随着样本量的增加,先验越来越不重要,没有先验MAP就变成了MLE

来看看这个怎么来理解:

MAP公式:

argθmaxlogp(D∣θ)+logp(θ)=argwmaxi=1∑nlogp(yi∣xi,w)+logp(θ)

可以看到,前面一项

∑i=1nlogp(yi∣xi,w)随着n趋向无穷大,是越来越大的,因为这个是累加的关系,所以后面那项

logp(θ)就变得不重要了。

前面一项就是MLE,后面那项就是先验概率。