1. 概述

考虑到在自动驾驶汽车中的应用,作者将去雾与目标检测结合,建立了一个端到端的网络。

雾图的生成通常是基于大气散射模型:

其中

表示雾图,

表示真实图片,

和

是两个关键的参数,分别表示大气光和透射图,

,

为大气散射系数,

为物体到相机的距离。因此,真实图片又可以表示为

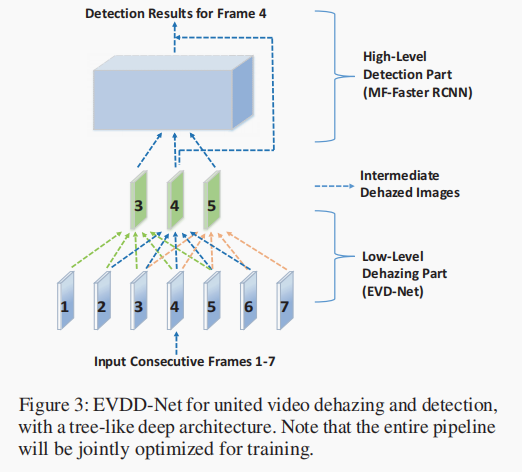

作者借鉴了AOD网络将其应用到视频去雾,再结合Faster-RCNN将其应用到视频目标检测,搭成最终模型如下图所示。

2. AOD

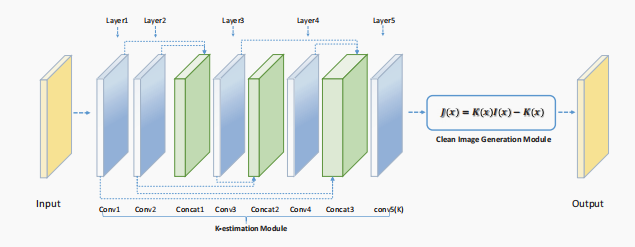

AOD网络结构如下图所示:

AOD将式(1)重写: 其中 将 和 合并到新变量 中。

2.1 Pipline

- 对输入 提取特征输出 ,

- 应用公式(3)输出清晰图像。

3 AOD应用到视频去雾

由于AOD是用于单张图像去雾,因此作者将其进行了改进以处理视频去雾问题,其主要问题在于连续帧的混合(temporal fusion)。由于连续帧具有内在的联系,因此利用多帧相干性进行视频去雾有巨大前景。

3.1 混合连续帧的三种策略

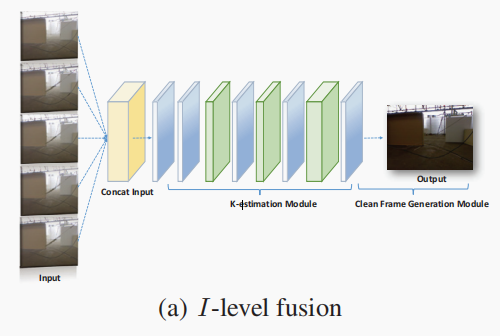

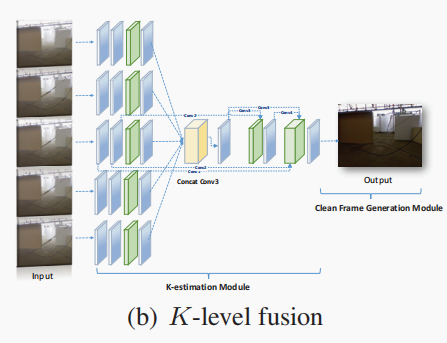

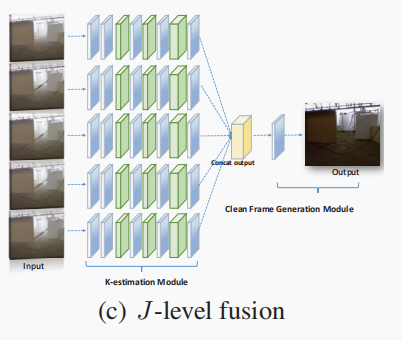

作者同时将5(后面解释为什么是5)张图片输入给网络,在三个不同的阶段将其进行融合,分析比较他们的结果

- I-Level Fusion: 在输入阶段将五个分支进行cancatenate。

- K-Level Fusion: 在K估计阶段将五个分支图片的特征图进行concatenate。

- J-Level Fusion: 在输出阶段将五个分支进行特征融合。

作者将AOD的参数作为初始化值,方便了模型的训练。

3.2 超参数的选择

通过最后的对比试验,作者在3,5,7中选择5作为输入连续帧的数量(3太少,7张连续帧内在联系没有那么大造成反噬);选择K-Level Fusion 作为特征融合策略。

4 损失函数

作者选择MSE作为损失函数

5 目标检测

略