摘要:

为了了解什么使对比预测任务能够学习有用的表示,我们系统地研究了框架的主要组成部分。

(1) 数据增强的组合在定义有效的预测任务方面起着关键作用;

(2) 在表示和对比损失之间引入一个可学习的非线性变换,大大提高了学习表示的质量。

(3) 与有监督学习相比,对比学习可以从更大的批量和更多的训练步骤中获益。

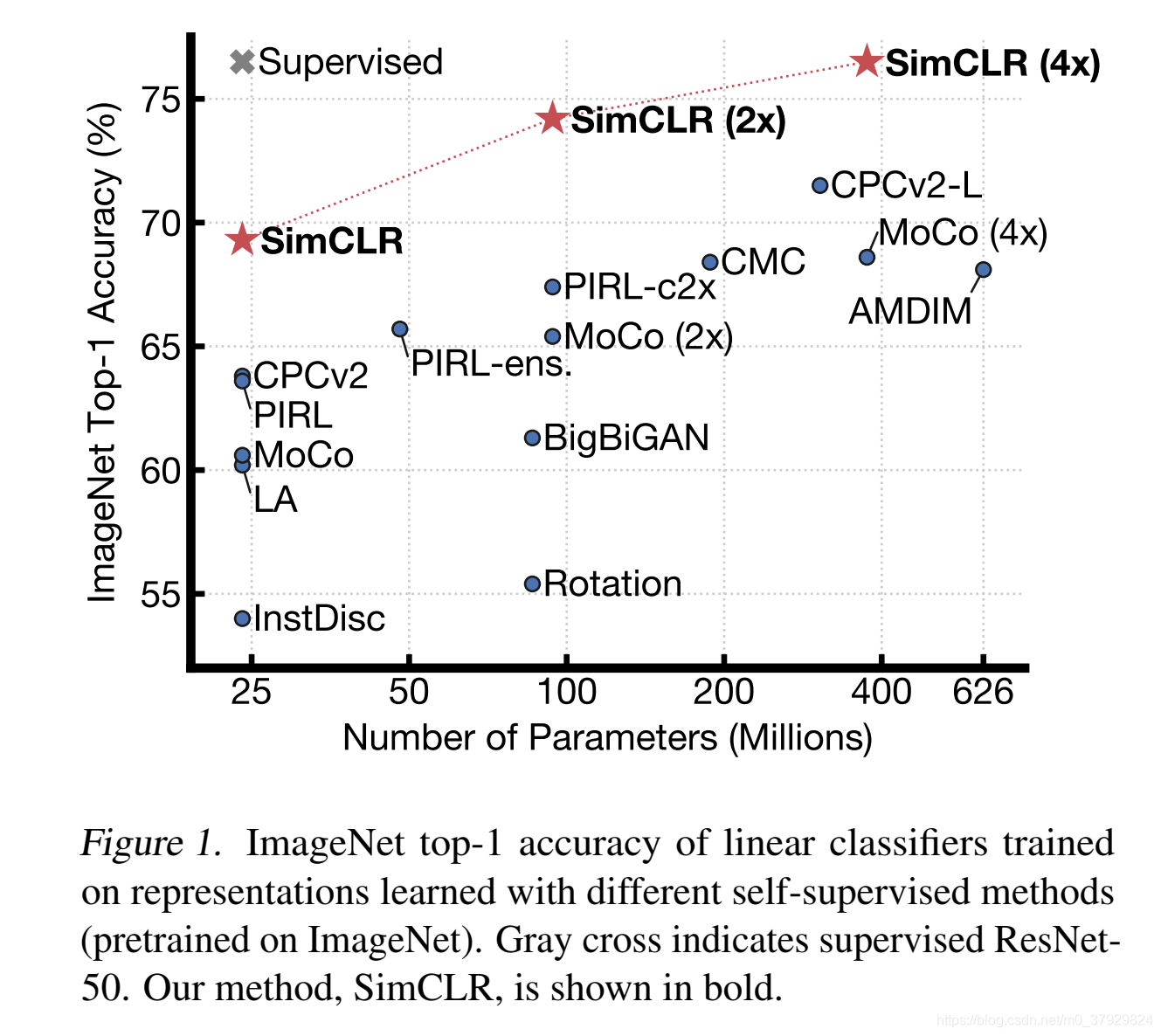

通过结合这些发现,我们能够在ImageNet上大大优于以前的自监督和半监督学习方法。由SimCLR学习的基于自监督表示的线性分类器达到了76.5%的top-1精度,比现有技术提高了7%,与监督ResNet-50的性能相当。当只对1%的标签进行微调时,我们达到85.8%的前5位精度,比AlexNet的标签少100倍。

Introduction

在这篇文章中,作者提出了一种精简的框架,名字为SimCLR,并不完全是因为它性能优异,并且还因为它不需要某种额外特殊的架构和额外的内存。Contrastive Learning

为了理解是什么使我们能够进行良好的对比表征学习,我们系统地研究了框架的主要组成部分,并表明:

1、在定义产生有效表示的对比预测任务时,多个数据增强操作的组合至关重要。此外,与监督学习相比,无监督对比学习从更强的数据增强中获益。

2、在表征和对比损失之间引入可学习的非线性转换,总体上提高了学习表征的质量。

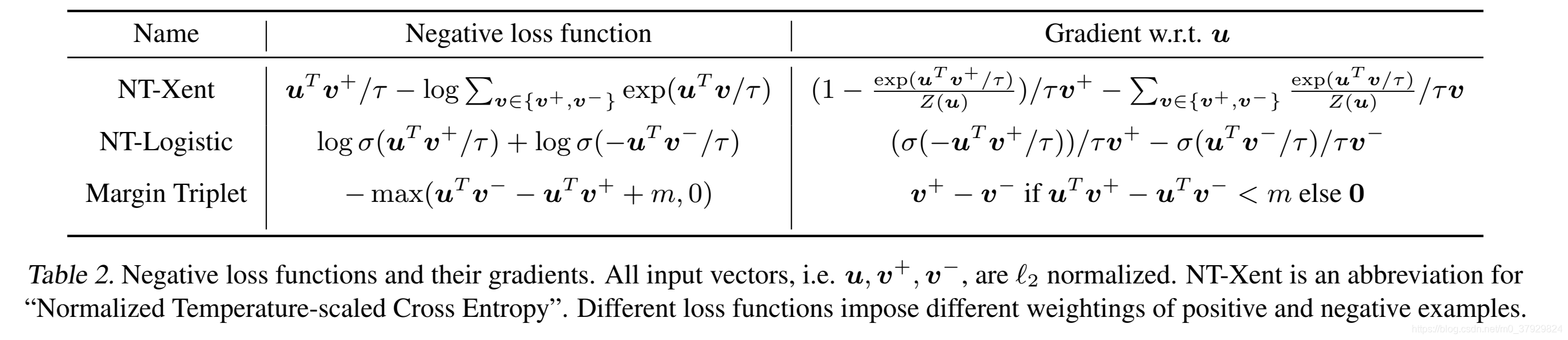

3、具有对比交叉熵损失的表征学习受益于规范化嵌入和适当调整的数。

4、与有监督的对照组相比,对比学习受益于较大的批量和较长的训练。与监督学习一样,对比学习也得益于更深更广的网络。

Method

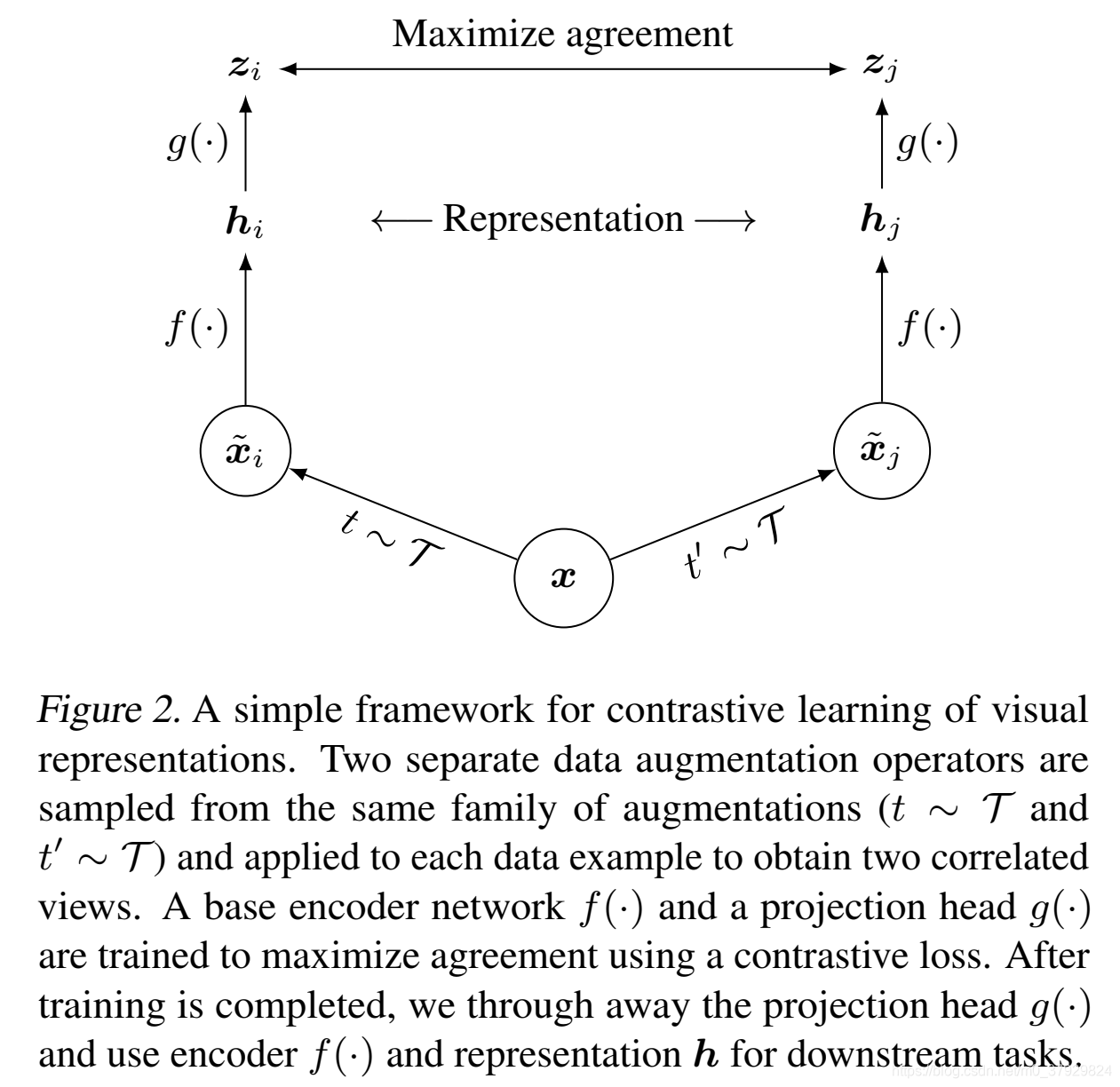

SimCLR通过最大化一致性学习表示

通过潜在空间中的对比损失,在同一数据示例的不同增强视图之间。

1、一种随机数据扩充模块,它将任意给定的数据实例随机地变换成同一实例的两个相关视图,我们将其视为一对正视图。在这项工作中,我们依次应用三种简单的增强:随机裁剪,然后将大小调整回原始大小,随机颜色失真和随机高斯模糊。如第3节所示,随机裁剪和颜色失真的结合是获得良好性能的关键。

2、一种神经网络基编码器f(·),从扩充的数据实例中提取表示向量。我们的框架允许在不受任何限制的情况下选择各种网络架构。我们选择简单,采用常用的ResNet

这篇文章的Batchsize很大,选用的是批次大小为8192。当某一批次大小为8192时,经过扩充,它的批量大小为8192时,从两个扩充视图中,每对正对给出16382个负示例。

为了稳定训练,对所有批量使用LARS优化器(You等人,2017)。我们使用云TPU训练我们的模型,根据批量大小使用32到128个核心。

在具有数据并行性的分布式训练中,BN均值和方差通常在每个设备上进行局部聚合。在我们的对比学习中,由于正对是在同一个设备中计算的,该模型可以利用局部信息泄漏来提高预测精度,而不需要改进表示。我们通过在训练期间对所有设备的BN均值和方差进行汇总来解决这个问题。其他方法包括洗牌数据示例(He et al.,2019a),或用层规范替换BN

Data Augmentation for Contrastive Representation Learning

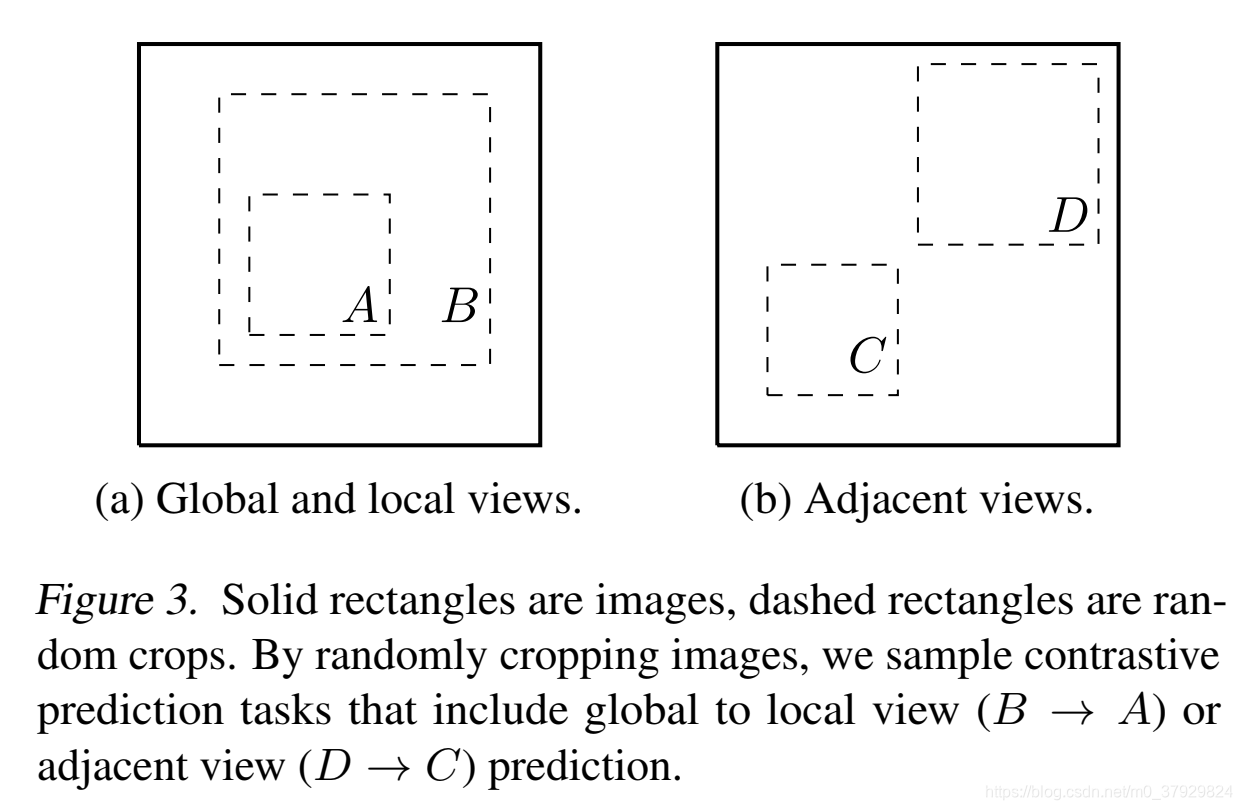

数据扩充已经广泛的应用于监督学习和无监督学习中,它并没有被认为是一种系统地定义对比预测任务的方法。通过约束网络体系结构中的接收场来实现全局到局部的视图预测,而Oord等人则是通过约束网络体系结构中的接收场来实现全局到局部的视图预测。(2018年);Hénaff等人。(2019)通过固定图像分割过程和上下文聚合网络实现邻域视图预测。

本文表明,通过对目标图像执行简单的随机裁剪(调整大小)可以避免这种复杂性,这将创建一个包含上述两个任务的预测任务系列,如图3所示。这种简单的设计选择可以方便地将预测任务与其他组件(如神经网络体系结构)分离。通过扩展增广项族并随机组合它们,可以定义更广泛的对比预测任务。

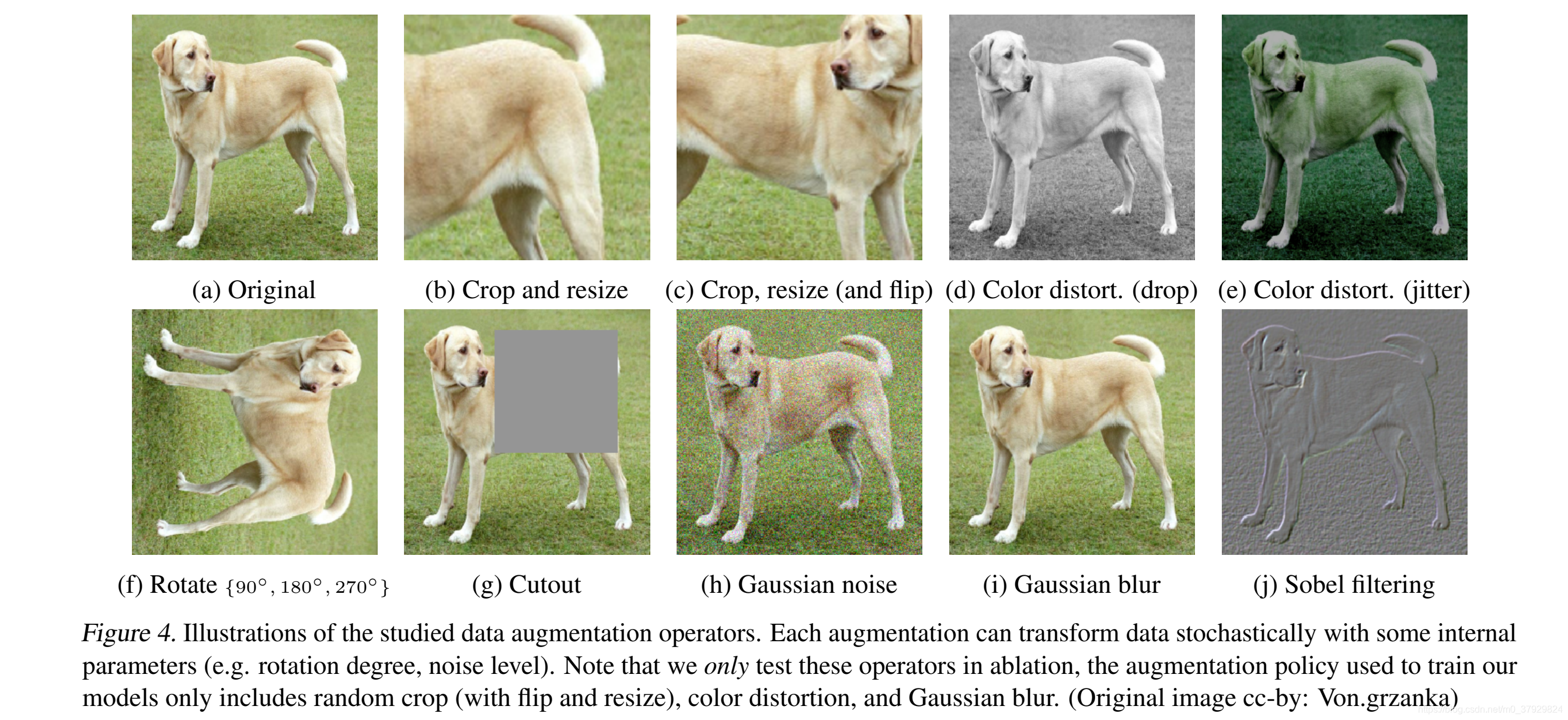

为了系统地研究数据增强的影响,我们在这里考虑了几种常见的增强。一种类型的增强涉及数据的空间/几何变换,例如裁剪和调整大小(带水平翻转)、旋转(Gidaris等人,2018)和剪切(DeVries&Taylor,2017)。另一种类型的增强涉及外观变换,例如颜色失真(包括颜色下降、亮度、对比度、饱和度、色调)(Howard,2013;Szegedy等人,2015)、高斯模糊和Sobel滤波。图4显示了我们在这项工作中研究的增强。

因为目前基于ImageNet都需要进行裁剪和Resize策略,为了消除这种混淆,我们考虑了一个非对称的数据转换设置。

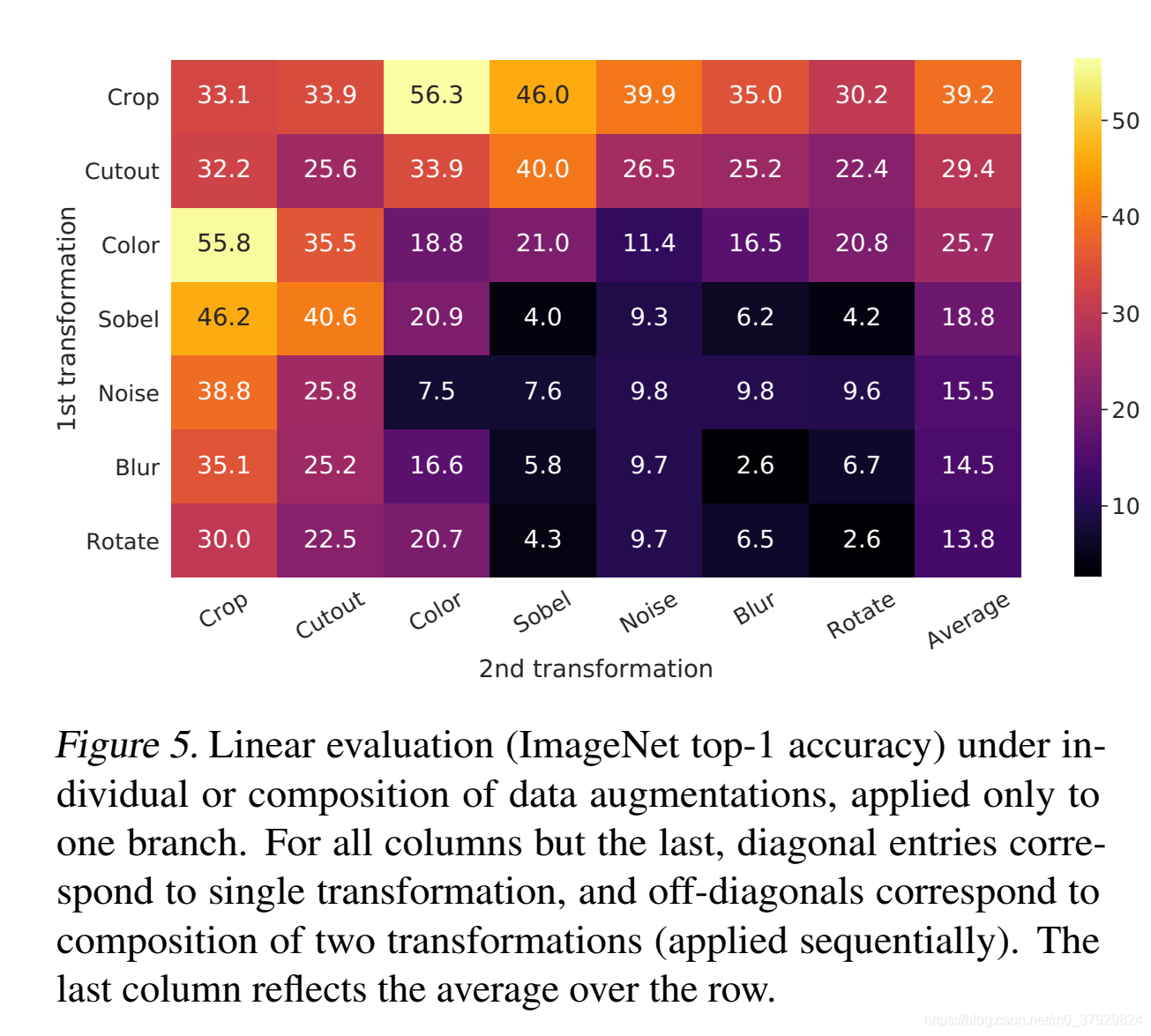

图5显示了单个和组合转换下的线性评估结果。我们观察到,没有一个单一的转换足以学习良好的表征,即使该模型几乎可以完美地识别对比任务中的正对。在构成增广词时,对比预测任务变得更加困难,但表示质量却显著提高。

我们观察到,没有一个单一的转换足以学习良好的表征,即使该模型几乎可以完美地识别对比任务中的正对。在构成增广词时,对比预测任务变得更加困难,但表示质量却显著提高。

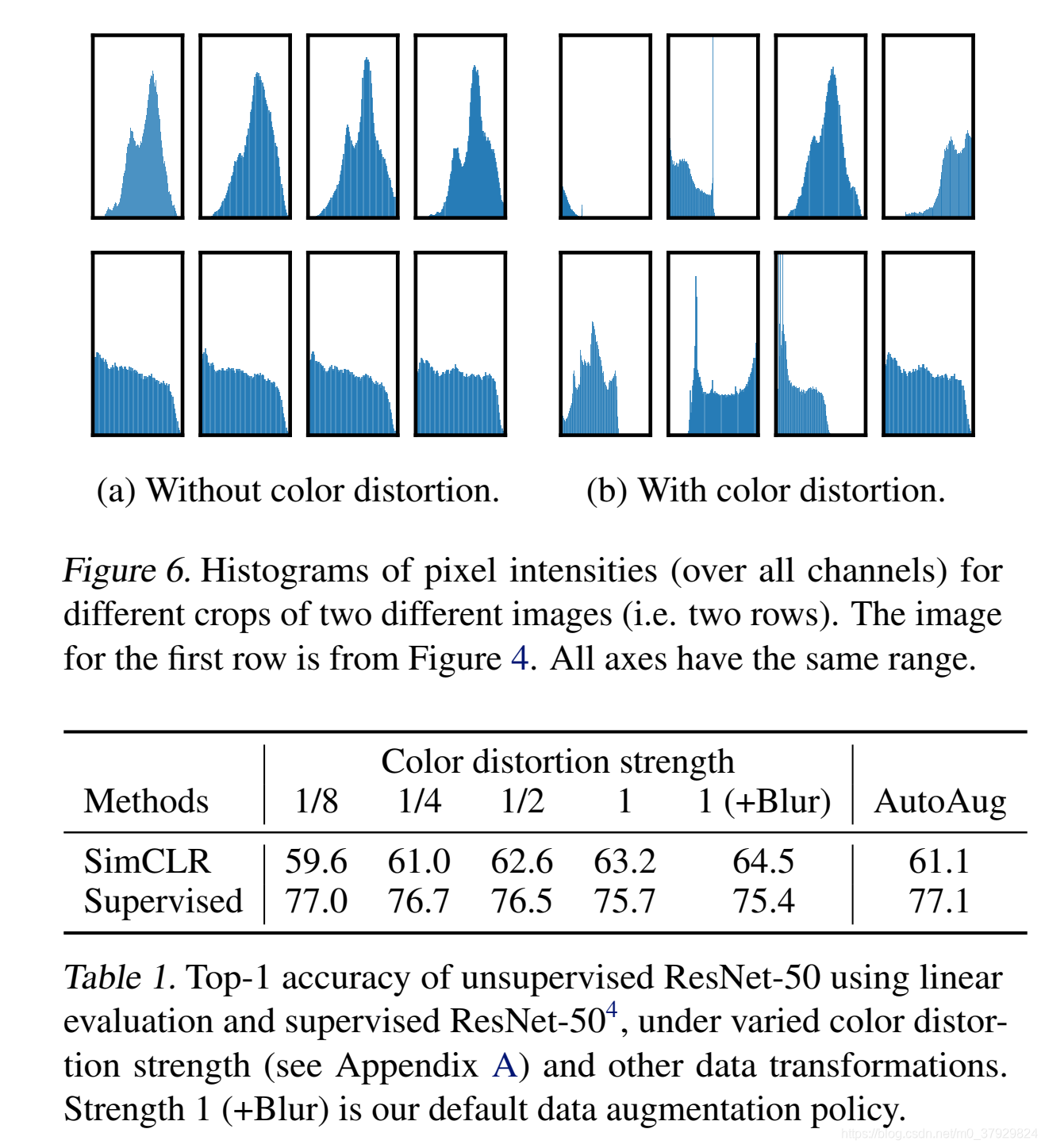

我们推测,当仅使用随机裁剪作为数据增强时,一个严重的问题是,图像中的大多数面片具有相似的颜色分布。图6显示,仅颜色直方图就足以区分图像。神经网络可以利用这一捷径来解决预测任务。因此,为了学习可概括的特征,在裁剪中加入颜色失真是非常重要的。

更强的颜色增强显著改善了学习的无监督模型的线性评估.

Architectures for Encoder and Head

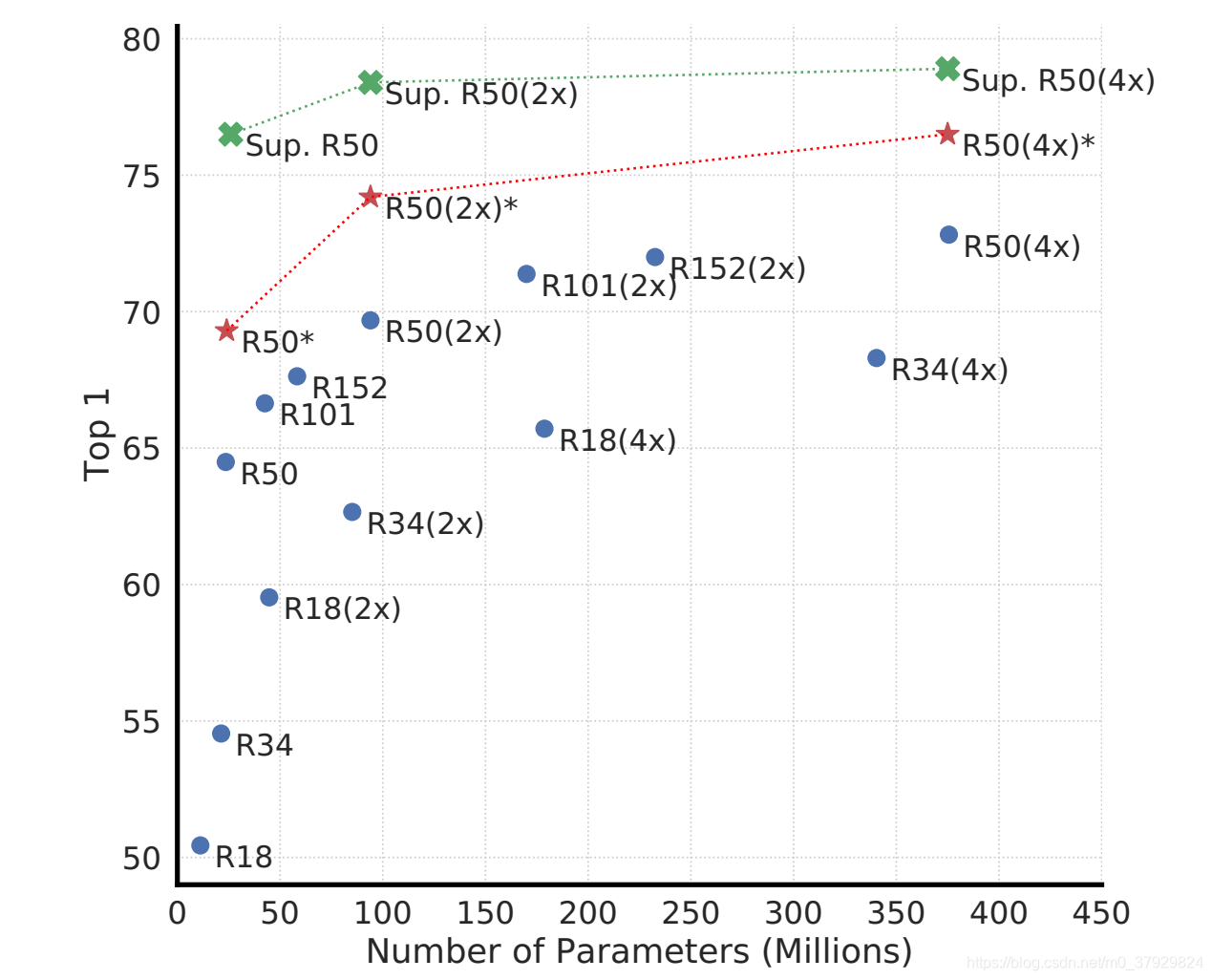

我们发现,在无监督模型上训练的有监督模型和线性分类器之间的差距随着模型大小的增加而缩小,这表明无监督学习比有监督学习从更大的模型中获益更多。

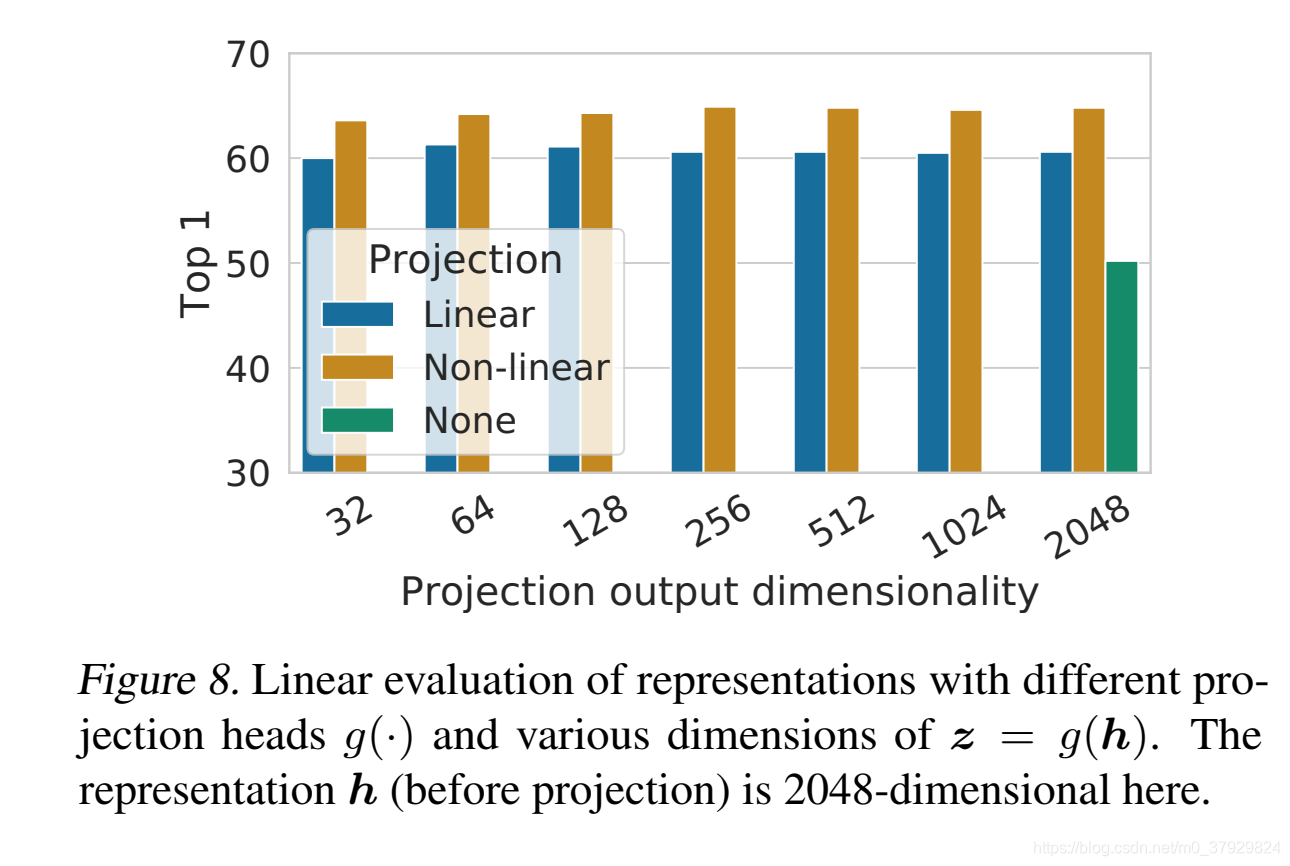

这说明投影头前的隐藏层比投影头后的隐藏层具有更好的表现力。

Conclusion

结果表明,以前的一些自监督学习方法的复杂性并不是获得良好性能的必要条件。本文的方法不同于在ImageNet上的标准有监督学习,只是在数据增强的选择、网络末端非线性头的使用以及损失函数方面。这个简单框架的优势表明,尽管最近兴趣激增,但自我监督学习仍然被低估。

补充:

对比方法(Contrastive methods)通过正面和负面的例子来学习表征。尽管不是全新的思路,对比方法通过无监督的对比预训练(Unsupervised contrastive pre-training)在计算机视觉任务中取得了巨大的成功。

比较知名的方法有:

在未标记的ImageNet数据上训练并使用线性分类器的无监督对比方法已经超过了监督的AlexNet(2019年Henaff提出的CPC方法)。

ImageNet上的对比式预训练成功地转移到了其它任务,并且胜过了监督的预训练任务(2019年何恺明提出的MoCo方法)。

和传统的 Generative model 不同,传统方法专注于像素空间的特征,会存在如下不足:

使用像素级loss可能导致此类方法过于关注基于像素的细节,而不是抽象的语义信息。

在于像素分析的方法难以有效的建立空间关联及对象的复杂结构。