【论文阅读—推荐系统】LIGHTGCL: SIMPLE YET EFFECTIVE GRAPH CONTRASTIVE LEARNING FOR RECOMMENDATION

文章目录

1. 来源

- 2023-ICLR

- code:https://github.com/HKUDS/LightGCL

- 论文地址:https://arxiv.org/abs/2302.08191

2. 介绍

图神经网络(GNN)是一种功能强大的基于图的推荐系统的学习方法。

- 近年来,集成了对比学习的 GNN 在推荐系统中的数据增强方案中表现出了优越的性能,旨在处理高度稀疏的数据。

尽管大多数现有的图对比学习方法都很成功,但它们要么对用户-项目交互图执行随机增强(例如,节点/边缘扰动),要么依赖于基于启发式的增强技术(例如,用户聚类)来生成对比视图。

作者认为这些方法不能很好地保留内在的语义结构,而且很容易受到噪声扰动的影响。在本文中,作者提出了一个简单而有效的图对比学习范式LightGCL,以缓解这些损害基于CL的推荐者的通用性和鲁棒性的问题。

- 模型专门利用奇异值分解进行对比增强,使全局协同关系建模实现无约束结构细化。

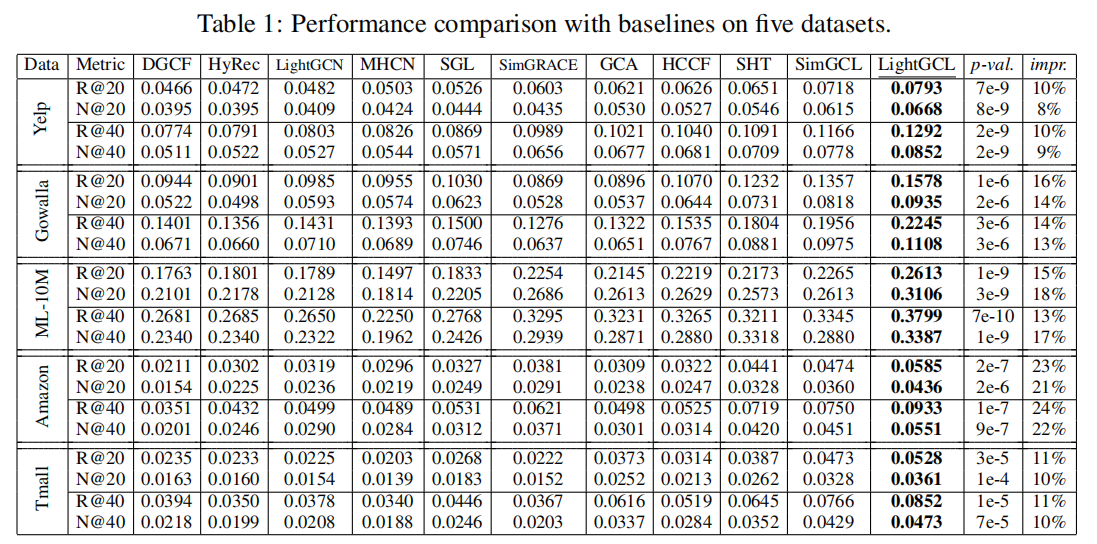

- 在几个基准数据集上进行的实验表明,模型在性能方面有了显著的改进。进一步的分析证明了LightGCL对数据稀疏性和流行偏差的鲁棒性。

3. 模型

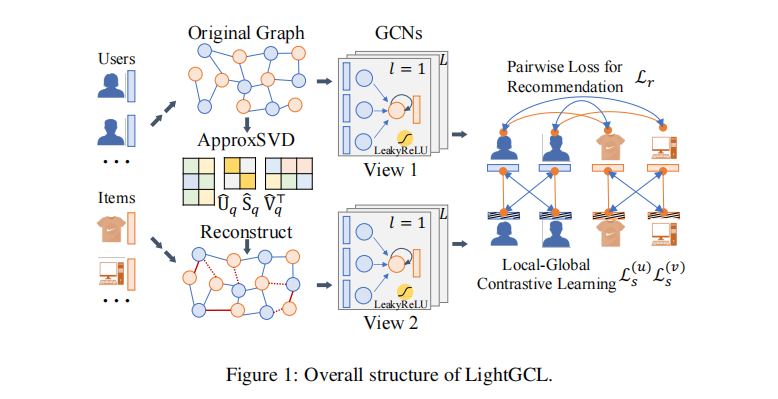

LightGCL是一个轻量级的图对比学习范式,如图1所示。

- 与提取局部图依赖关系的GCN主干(图的上半部分)互补,SVD 引导的增强(图的下半部分)使图与全局协作关系分析进行对比学习,以学习有效的用户和项目表示。

3.1 局部图依赖关系建模

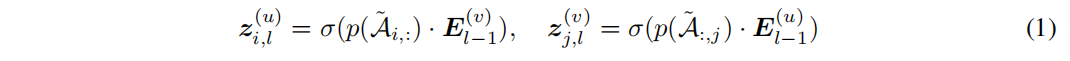

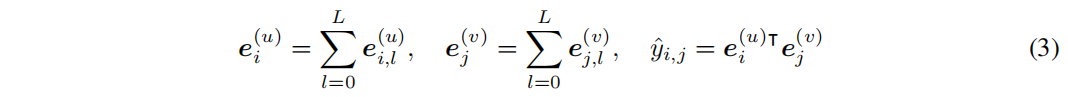

作为协同过滤的一种常见做法,为每个用户的 u i u_i ui 和项目 v j v_j vj 分配一个嵌入向量 e i ( u ) e^{(u)}_i ei(u), e j ( v ) e^{(v)}_j ej(v) ∈ R d R^d Rd,其中 d 是嵌入大小。所有用户和项目嵌入的集合被定义为 E ( u ) ∈ R I × d E ^{(u)} ∈R^{I×d} E(u)∈RI×d 和 E ( v ) ∈ R J × d E^{(v)}∈R ^{J×d} E(v)∈RJ×d,其中 I 和 J 分别为用户和项目的数量。继Xia等人(2022b)之后,作者采用了一个两层的GCN来聚合每个节点的相邻信息。在第 l l l 层中,聚合过程表示如下:

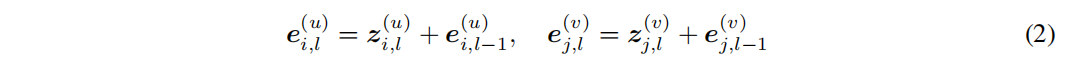

其中, z i , l ( u ) z^{(u)}_{i,l} zi,l(u) 和 z j , l ( v ) z^{(v)}_{j,l} zj,l(v) 表示用户 ui 和项目 vj 的第 l l l 层聚合嵌入。σ(·)表示负斜率的LeakyReLU,值为0.5。˜A是归一化邻接矩阵,作者在其上执行边删除,表示为p(·),以缓解过拟合问题。作者在每一层中实现残差连接,以保留节点的原始信息如下:

最后,节点的最终嵌入是其在所有层上的嵌入的总和,而用户 ui 和项目 vj 之间的内积预测了 ui 对 vj 的偏好:

3.2 高效的全局协作关系学习

为了使图对比学习与全局结构学习一起进行推荐,作者为LightGCL配备了SVD方案(Rajwade等人,2012;兰加拉扬,2001),以便从全局的角度有效地提取重要的协作信号。具体来说,

- 首先对邻接矩阵 A 进行 SVD,得到 A = USV T ^T T。

- 这里,U / V是一个I×I / J×J 标准正交矩阵,列是 A 的行-行 / 列-列相关矩阵的特征向量。S是一个存储 a 的奇异值的I×J对角矩阵,最大的奇异值通常是与矩阵的主成分相关的。

- 因此,作者截断奇异值列表以保持最大的q值,并用截断矩阵重建邻接矩阵为

其中Uq ∈ R I × q ^{I×q} I×q 和 Vq∈R J × q ^{J×q} J×q 分别包含 U 和 V 的前q列。Sq∈R q × q ^{q×q} q×q 是 q 最大奇异值的对角矩阵。

重构矩阵 A ^ \hat{A} A^ 是邻接矩阵 A A A 的一个低秩近似,因为它保持 rank( A ^ \hat{A} A^)=q。基于svd的图结构学习的优点是两方面的。

- 首先,它通过识别对用户偏好表示很重要和可靠的用户-项目交互来强调图的主成分。

- 其次,生成的新图结构通过考虑每个用户-项目对来保持全局协作信号。

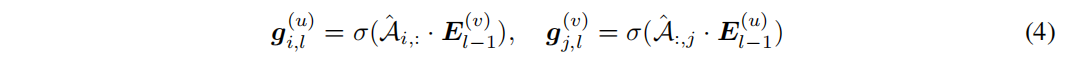

给定 A ^ \hat{A} A^ ,在每一层上对重构的用户-项目关系图进行消息传播:

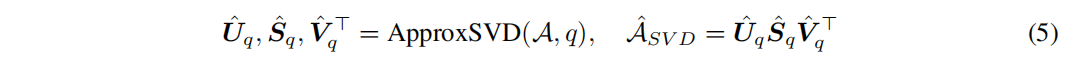

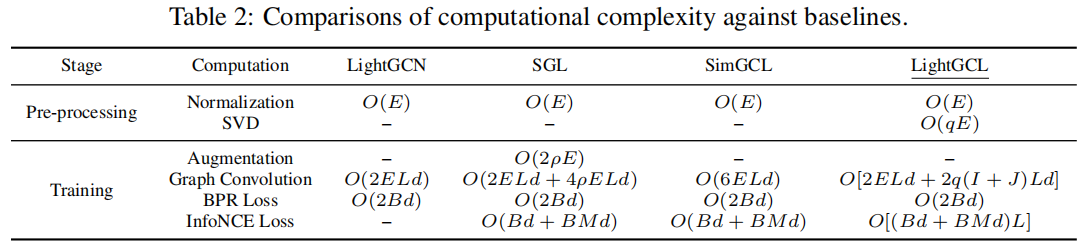

然而,在大型矩阵上执行精确的SVD是非常昂贵的,这使得处理大规模用户项矩阵不现实。因此,作者采用Halko et al.(2011)提出的随机SVD算法,其关键思想是首先用低秩标准正交矩阵近似输入矩阵的范围,然后对这个较小的矩阵进行SVD。

![]() 是 Uq,Sq,Vq的近似版本

是 Uq,Sq,Vq的近似版本

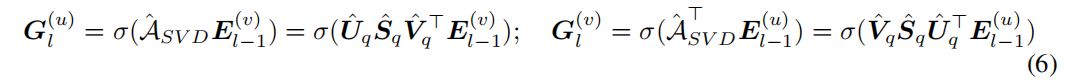

其中 q 是分解矩阵所需的秩。因此,作者重写了等式中的消息传播规则(4)与近似矩阵和嵌入的集体表示如下:

其中, G l ( u ) G_{l}^{(u)} Gl(u) 和 G l ( v ) G_{l}^{(v)} Gl(v) 是从新生成的图结构视图中编码的用户和项目嵌入的集合。

- 注意,实际上不需要计算和存储大的密集矩阵 ˆASVD。相反,我们可以存储低维的 U ^ q \hat{U}_q U^q, S ^ q \hat{S}_q S^q 和 V ^ q \hat{V}_q V^q。

然后通过在SVD预处理阶段进行预计算( U ^ q S ^ q \hat{U}_q\hat{S}_q U^qS^q)和( V ^ q S ^ q \hat{V}_q\hat{S}_q V^qS^q),提高了模型的效率。

3.3 简化的局部-全局对比学习

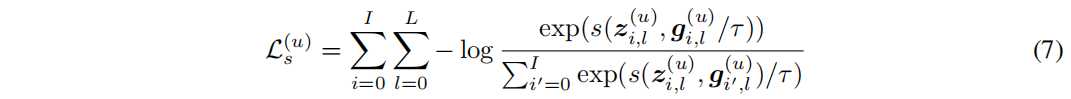

传统的GCL方法如 SGL 和 SimGCL 通过构建两个额外的视图来对比节点嵌入,而从原始图(主视图)生成的嵌入并不直接参与InfoNCE损失。采用这种繁琐的三视图范式的原因可能是,用于增强图的随机扰动可能会为主视图嵌入提供误导性的信号。然而,在作者提出的方法中,增强图视图是通过全局协作关系创建的,这可以增强主视图的表示。因此,作者通过直接对比SVD增强的视图嵌入 g i , l ( u ) g^{(u)}_{i,l} gi,l(u) 与InfoNCE损失中的主视图嵌入 z i , l ( u ) z^{(u)}_{i,l} zi,l(u) 来简化CL框架(Oord et al.,2018):

其中,s(·)和 τ 分别表示余弦相似度和温度。对于项目v的InfoNCE损失 L s ( v ) L^{(v)}_s Ls(v) 也以相同的方式定义。

- 为了防止过拟合,作者还在每批处理中实现了一个随机节点去除,以排除一些节点参与对比学习。

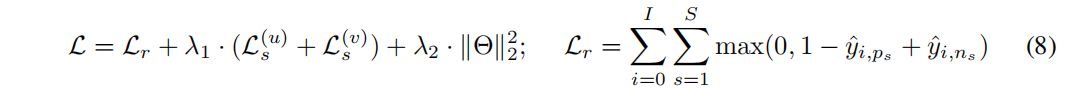

如等式(8)中所示,对比损失与我们的推荐任务的主要目标函数共同优化(其中 y ^ i , p s \hat{y}_{i,p_s} y^i,ps 和 y ^ i , n s \hat{y}_{i,n_s} y^i,ns 表示用户 i 的一对正负项的预测得分):

4. 实验

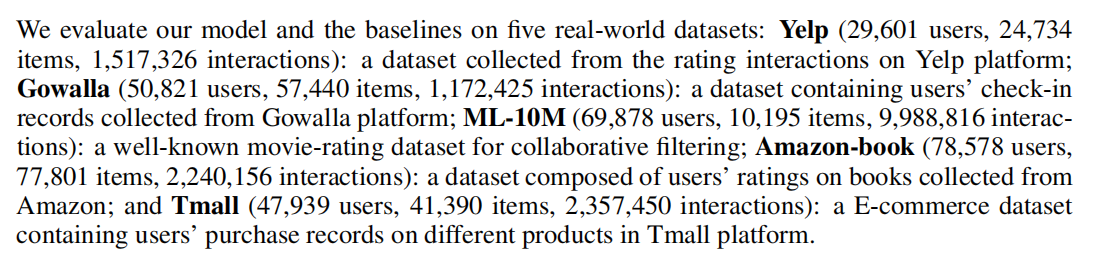

4.1 数据集

4.2 实验结果

4.3 效率对比

5. 总结

作者提出了一种简单有效的图对比学习框架推荐增强方法。具体地说,

- 论文呢探讨了使奇异值分解足够强大以增强用户-项交互图结构的关键思想。

- 主要发现表明,图增强方案显示出很强的抵抗数据稀疏性和流行偏差的能力。

- 大量的实验表明,模型在几个公共评估数据集上取得了最新的结果。