版权声明:本文为博主原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。

Hadoop HA 集群搭建

文章目录

集群规划:

| HDFS | YARN | zk | |

|---|---|---|---|

| hadoop01 | namenode+zkfc+journalnode+datanode | nodemanager+resourcemanager | QuorumPeerMain |

| hadoop02 | namenode+zkfc+journalnode+datanode | nodemanager | QuorumPeerMain |

| hadoop03 | journalnode+datanode | nodemanager+resourcemanager | QuorumPeerMain |

1.hadoop基础集群环境准备(1-10步)

2.ZooKeeper集群搭建(1-7步)

3.hadoop分布式集群安装(1-3步)

4.修改hadoop配置文件

进入到hadoop配置文件目录

cd /home/hadoop/apps/hadoop-2.7.6/etc/hadoop

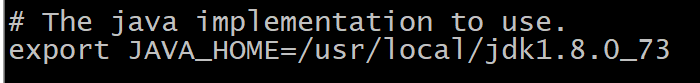

4.1修改hadoop-env.sh

改一下JAVA_HOME

export JAVA_HOME=/home/hadoop/apps/jdk1.8.0_73

- 后面的文件都是将所有内容复制到configuration标签中

4.2修改core-site.xml

<!-- 指定 hdfs 的 访问入口 namenode访问入口 完全分布式 hdfs://hadoop01:9000 高可用中两个namenode 这里配置的是两个namenode nameservice 组名 bd1906 hdfs://bd1906 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://bd1906/</value>

</property>

<!-- 指定 hadoop 数据存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop/data/hadoopdata/</value>

</property>

<!-- 指定 zookeeper 集群访问地址 -->

<property>

<name>ha.zookeeper.quorum</name>

<value>hadoop01:2181,hadoop02:2181,hadoop03:2181</value>

</property>

4.3修改hdfs-site.xml

- data的存储位置可以根据实际情况来修改一下

<!-- 指定副本数 -->

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

<!--指定 hdfs 的 nameservice 为 bd1906,需要和 core-site.xml 中保持一致-->

<property>

<name>dfs.nameservices</name>

<value>bd1906</value>

</property>

<!-- bd1906 下面有两个 NameNode,分别是 nn1,nn2 -->

<property>

<name>dfs.ha.namenodes.bd1906</name>

<value>nn1,nn2</value>

</property>

<!-- nn1 的 RPC 通信地址 -->

<property>

<name>dfs.namenode.rpc-address.bd1906.nn1</name>

<value>hadoop01:8020</value>

</property>

<!-- nn1 的 http 通信地址 -->

<property>

<name>dfs.namenode.http-address.bd1906.nn1</name>

<value>hadoop01:50070</value>

</property>

<!-- nn2 的 RPC 通信地址 -->

<property>

<name>dfs.namenode.rpc-address.bd1906.nn2</name>

<value>hadoop02:8020</value>

</property>

<!-- nn2 的 http 通信地址 -->

<property>

<name>dfs.namenode.http-address.bd1906.nn2</name>

<value>hadoop02:50070</value>

</property>

<!-- 指定 NameNode 的 edits 元数据在 JournalNode 上的存放位置 QJM -->

<property>

<name>dfs.namenode.shared.edits.dir</name>

<value>qjournal://hadoop01:8485;hadoop02:8485;hadoop03:8485/bd1906</value>

</property>

<!-- 指定 JournalNode 在本地磁盘存放数据的位置 -->

<property>

<name>dfs.journalnode.edits.dir</name>

<value>/home/hadoop/data/hadoopdata/journaldata</value>

</property>

<!-- 开启 NameNode 失败自动切换 -->

<property>

<name>dfs.ha.automatic-failover.enabled</name>

<value>true</value>

</property>

<!-- 配置失败自动切换实现方式 -->

<!-- 此处配置在安装的时候切记检查不要换行-->

<property>

<name>dfs.client.failover.proxy.provider.bd1906</name>

<value>org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider</value>

</property>

<!-- 配置隔离机制方法,多个机制用换行分割,即每个机制暂用一行-->

<property>

<name>dfs.ha.fencing.methods</name>

<value>

sshfence

shell(/bin/true)

</value>

</property>

<!-- 使用 sshfence 隔离机制时需要 ssh 免登陆 -->

<property>

<name>dfs.ha.fencing.ssh.private-key-files</name>

<value>/home/hadoop/.ssh/id_rsa</value>

</property>

<!-- 配置 sshfence 隔离机制超时时间 -->

<property>

<name>dfs.ha.fencing.ssh.connect-timeout</name>

<value>30000</value>

</property>

4.4修改mapred-site.xml

<!-- 指定 mr 框架为 yarn 方式 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<!-- 设置 mapreduce 的历史服务器地址和端口号 -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>hadoop02:10020</value>

</property>

<!-- mapreduce 历史服务器的 web 访问地址 -->

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>hadoop02:19888</value>

</property>

4.5修改yarn-site.xml

<!-- 开启 RM 高可用 -->

<property>

<name>yarn.resourcemanager.ha.enabled</name>

<value>true</value>

</property>

<!-- 指定 RM 的 cluster id -->

<property>

<name>yarn.resourcemanager.cluster-id</name>

<value>yarn_bd1906</value>

</property>

<!-- 指定 RM 的名字 -->

<property>

<name>yarn.resourcemanager.ha.rm-ids</name>

<value>rm1,rm2</value>

</property>

<!-- 分别指定 RM 的地址 -->

<property>

<name>yarn.resourcemanager.hostname.rm1</name>

<value>hadoop01</value>

</property>

<property>

<name>yarn.resourcemanager.hostname.rm2</name>

<value>hadoop03</value>

</property>

<!-- 指定 zk 集群地址 -->

<property>

<name>yarn.resourcemanager.zk-address</name>

<value>hadoop01:2181,hadoop02:2181,hadoop03:2181</value>

</property>

<!-- 要运行 MapReduce 程序必须配置的附属服务 -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!-- 开启 YARN 集群的日志聚合功能 -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!-- YARN 集群的聚合日志最长保留时长 -->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>86400</value>

</property>

<!-- 启用自动恢复 -->

<property>

<name>yarn.resourcemanager.recovery.enabled</name>

<value>true</value>

</property>

<!-- 制定 resourcemanager 的状态信息存储在 zookeeper 集群上-->

<property>

<name>yarn.resourcemanager.store.class</name>

<value>org.apache.hadoop.yarn.server.resourcemanager.recovery.ZKRMStateStore</value>

</property>

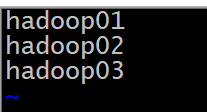

4.6增加slaves

vi slaves

加入

hadoop01

hadoop02

hadoop03

5.远程发送安装包

- 先切换到有hadoop-2.7.6文件夹的目录

cd /home/hadoop/apps

发送

scp -r hadoop-2.7.6 hadoop02:/home/hadoop/apps/

scp -r hadoop-2.7.6 hadoop03:/home/hadoop/apps/

6.远程发送配置文件

sudo scp /etc/profile hadoop02:/etc/

sudo scp /etc/profile hadoop03:/etc/

三台机器同时执行

source /etc/profile

hadoop version

7.集群初始化操作

- 必须按照步骤一步一步的来

- 每一步都要成功

7.1启动zookeeper服务

三台机器都要启动

zkServer.sh start

7.2启动journalnode

三台机器都要启动

hadoop-daemon.sh start journalnode

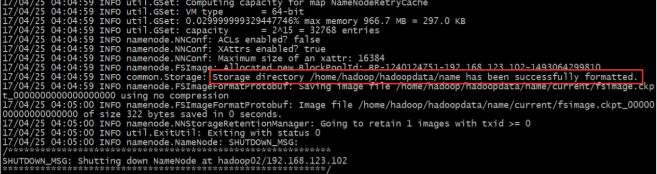

7.3格式化namenode

在hadoop01(任意一个namenode节点)中,看到如图所示的successfully再继续往下

hadoop namenode -format

7.4发送元数据

将hadoop1的元数据发送到hadoop02中

scp -r /home/hadoop/data/hadoopdata/dfs hadoop02:/home/hadoop/data/hadoopdata

7.5格式化zkfc

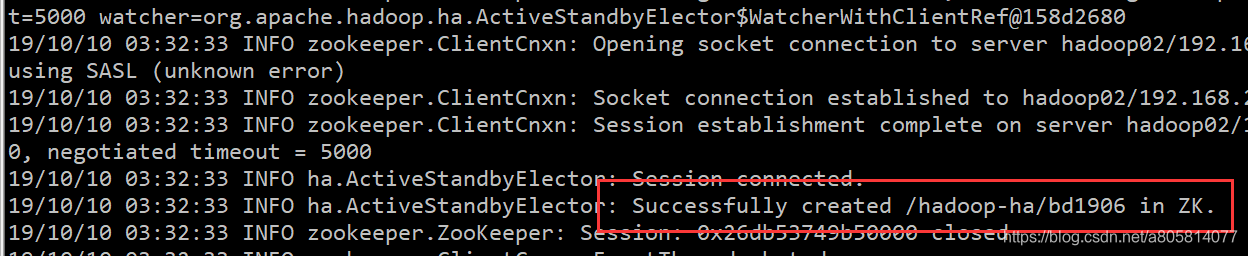

在hadoop01(任意一个namenode节点)中,看到如图所示的successfully再继续往下

hdfs zkfc -formatZK

7.6启动

启动hdfs(任意节点)

start-dfs.sh

启动yarn(在hadoop01)

start-yarn.sh

在另一个节点启动resourcemanager(hadoop03)

yarn-daemon.sh start resourcemanager

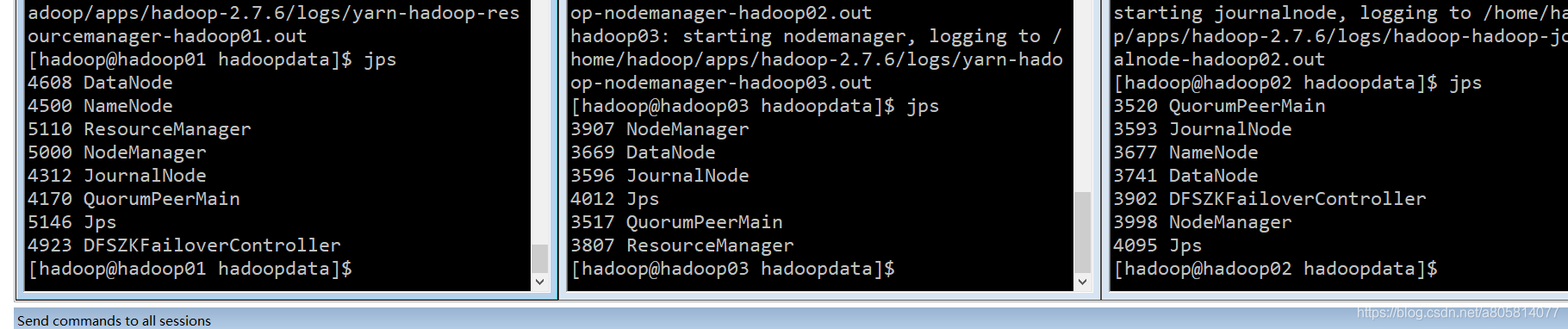

最后查看一下进程

jps