论文地址 :Deformable Convolutional Networks

工程地址:github 链接

0. 摘要

卷积神经网络对位置变化的建模存在天然缺陷,这是由于网络固定的位置结构。该论文提出两个新的模块来增强CNNs的这种建模能力,称为deformable convolution and deformable RoI pooling,两个模块的基本思想采样时增加额外的参数offets并学习这种偏移,新模块可以直接替换现有CNNs中的对应方法并且可以通过后向传播算法端到端训练,由此产生deformable convolutional networks。实验表明这两个模块对于目标检测任务和语义分割任务的精度都有一定的提升。

1. 介绍

视觉任务的一大挑战在于如何在变形物体上有效泛化或者说在物体层面对各种变形进行建模,一般有两种方法,一是建立包含各种变形的数据集,而是使用具有平移不变性的特征和算法。然而这两种方法存在两个问题:

- 变形有固定的方向而且可知

- 手工设计的具有不变性的特征和算法对于具有复杂变形的物体,可能无法描述或这描述过于困难。

尽管CNNs在各种计算机视觉任务上都取得了非常好的效果但是也无法完全解决上述两个问题,各种方法对物体变形的建模能力无非来自数据增广,大模型和简单设计的模块{比如最大池化在轻微的变形上的效果}

简而言之,由于内部模块的结构,CNNs对大的未知的变换的建模能力天然不足:卷积单元对输入的特征图在固定的位置进行采样;池化层不断减小着特征图的尺寸;RoI池化层产生空间位置受限的RoI。网络内部缺乏能够解决这个问题的模块,这会产生显著的问题,例如,同一CNN层的激活单元的感受也尺寸都相同,这对于编码位置信息的浅层神经网络并不可取,因为不同的位置可能对应有不同尺度或者不同形变的物体,这些层需要能够自动调整尺度或者感受也的方法。再比如,目标检测虽然效果很好但是都依赖于基于特征提取的边界框,这并不是最优的方法,尤其是对于非网格状的物体而言。

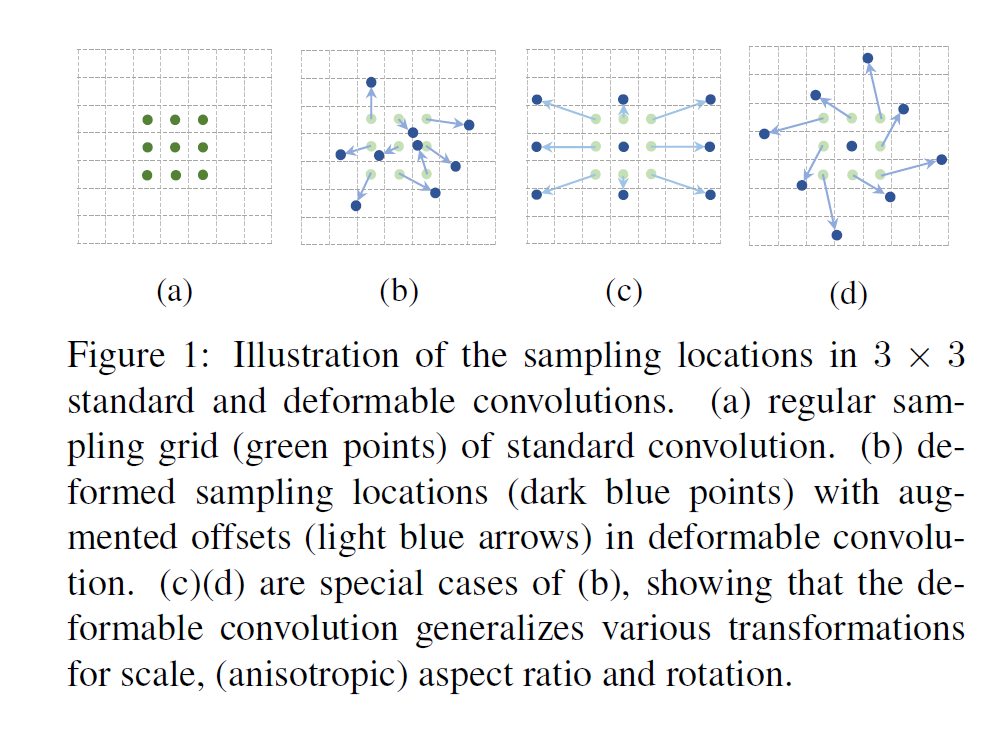

该论文介绍了两个新型的模块极大地增强了CNNs对于变形目标的建模能力,1) Deformable convolution: 在常规的网格状空间采样中加入2D偏移如下图所示; 2) Deformable RoI pooling: 在常规RoI池化的bin位置加入偏移。

两个模块都是轻量的,通过增加较少的参数和计算用于offsets的学习,替换标准CNNs中对应的方法简单快捷形成的网络称为:Deformable ConvNets。

论文中提出的方法与空间变换网络和可变形模型共享浅层特征,二者都有变换相关的参数并且从数据中学习,不同在于论文提出的方法能够以较为简单有效的方式处理较为复杂的变形。

2. Deformable Convolutional Networks

需要注意的是为了更好的形式化,下面的可变形卷积和RoI池化都不是在特征图的3D维度进行说明的,而是2D。

2.1 Deformable Convolution

2D卷积包含两个步骤:1)使用常规的grid

在输入特征图x上进行采样;2)将这些采样结果以一个权重w进行归并。grid

定义了感受也尺寸和空洞,比如说

就定义了一个空洞率为1的

的核。

对于输出特征图

中的每一个位置

,有:

其中

是

中位置的枚举。

在可变形卷积中常规网格

是经过偏移{

},其中

,公式1就变为下面的形式:

这样一来,采样就在不规则且有偏移的位置

上进行,因为偏差

比较所以通过双线性差值实现:

其中p表示任意的位置(公式2中

),q从特征图x的所有位置中选择,

是双线性插值的核函数,是二维的所以可以分成两个以为的核:

其中

。公式3的计算是非常快的因为

除了少数的qs其他位置都是0。

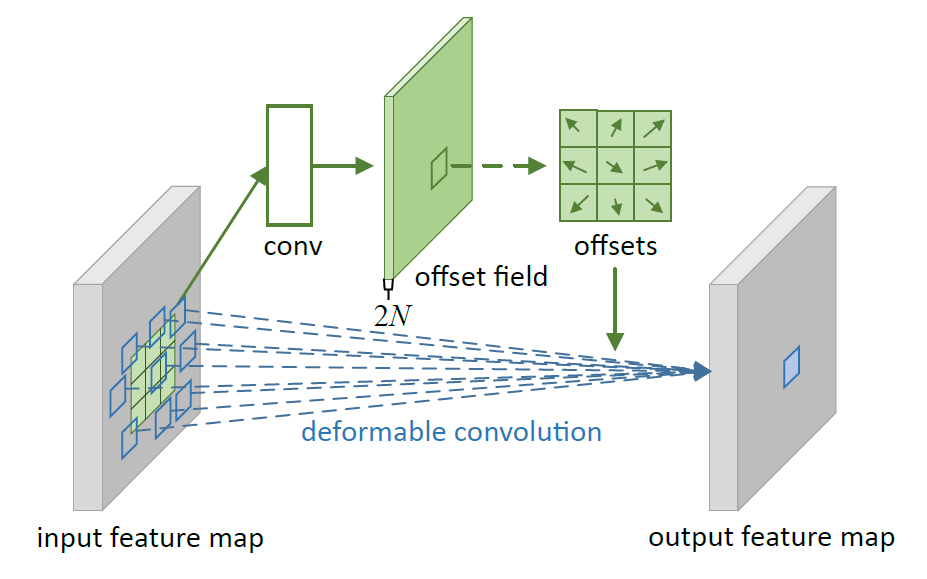

如上图所示,偏差是通过一个卷几层来获得的,其卷积核与普通的卷积层无异。输出的偏差域和输入特征图的尺寸相同,通道维度的2N对应N 二维偏移。生成偏移和输出特征的卷积核同时训练,为了学习偏移,梯度通过双线性操作后向传播。

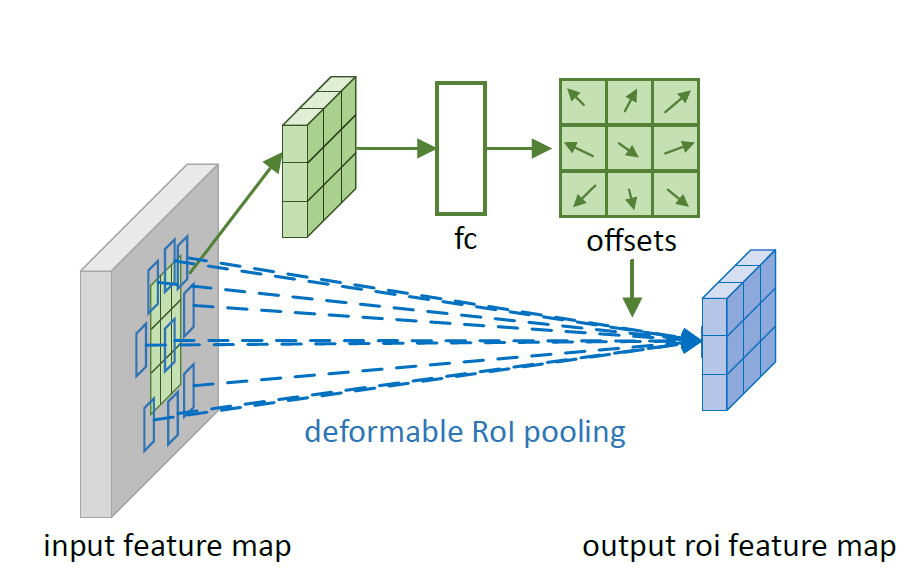

2.2 Deformable RoI Pooling

普通的RoI将输入的任意尺寸的矩形区域转化为固定大小的特征,给定输入特征图x,和一个尺寸为

的RoI和左上角坐标点

,RoI池化层将RoI分为

个容器并且输出一个

的特征图y,对于第(i,j)个容器的(

),有:

其中

是容器中像素点的数量,且对于第(i,j)个容器有:

。

与公式2相同,在可变形RoI池化中,偏移{

}加到容器中,公式5变为:

如下图所示,首先RoI池化层(公式5)生成池化特征图,之后应用一个全连接层生成正则化的偏移

,然后通过逐元素的乘法

转化为偏移

,其中

是预先设定好的缩放因子用于调整偏移的量级,取经验值0.1。

之后就是实验和与当时SOTA方法的结合以及相关工作部分{第一次见到这个部分放在后面~孤陋寡闻了}

欢迎扫描二维码关注微信公众号 深度学习与数学 [每天获取免费的大数据、AI等相关的学习资源、经典和最新的深度学习相关的论文研读,算法和其他互联网技能的学习,概率论、线性代数等高等数学知识的回顾]