- 深度学习是使用深层架构的机器学习方法

- 神经元也叫感知器

- 神经网络:按一定规则连接起来的神经元

按层布局

同层间无连接

第N-1层的输出是第N层的输入

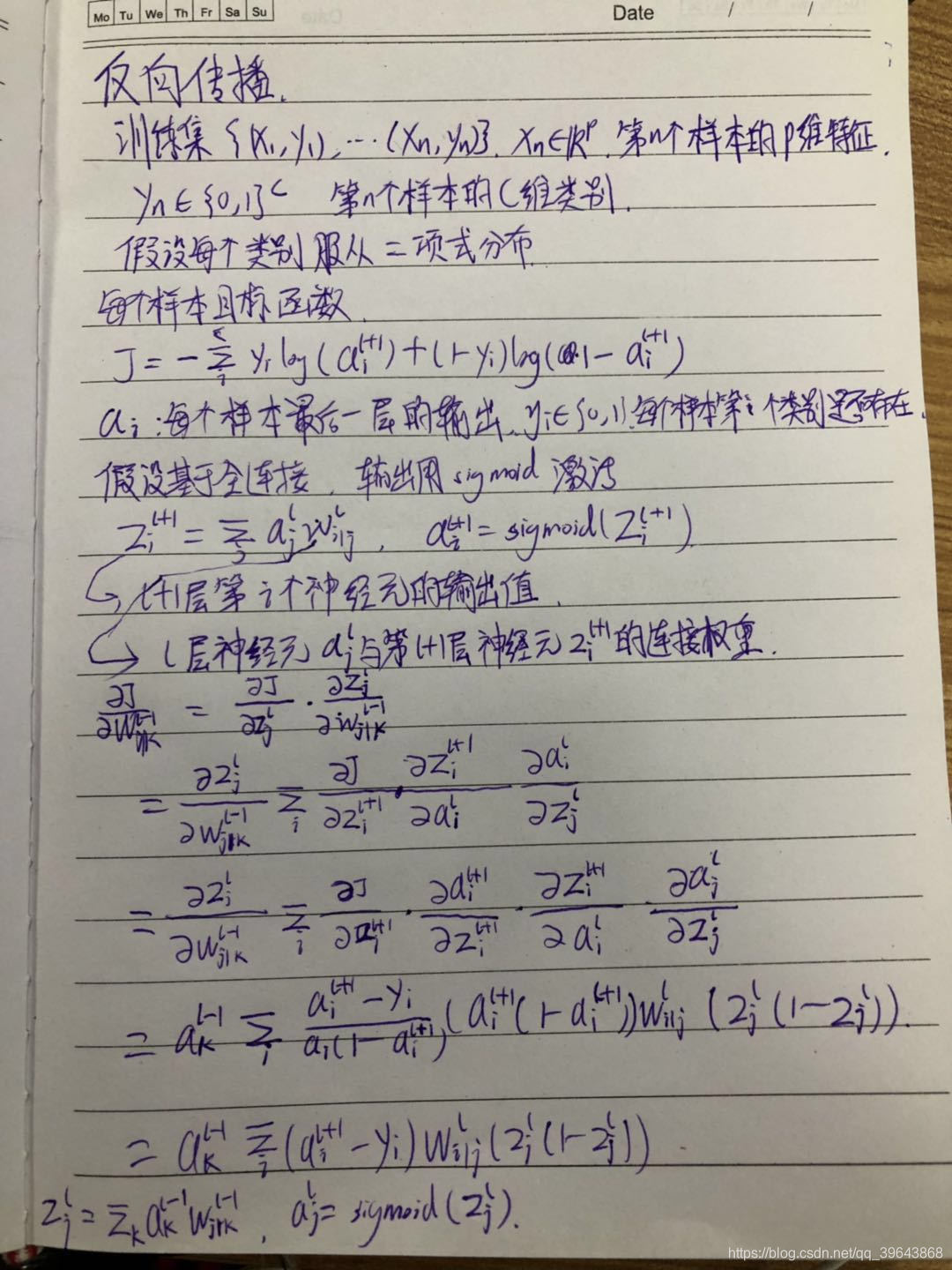

每个连接都有权值 - 反向传播

神经网络中,样本输入/权重参数通过前向传播得到输出值

一般与预测值差异很大,由于权重是随机初始化的

为校正网络权重,引入反向传播算法,修正权重参数,使输出值逼近目标值

最小化损失函数值

基于微积分链式求导的递归算法

- 网络参数初始化

深度网络模型都是采用梯度下降法更新的,本质是一种迭代算法,迭代前需要初始化

若初始化太小,前馈/反馈信号可能丢失

太大可导致梯度爆炸,影响模型收敛

常用的有:

高斯分布初始化(固定均值/方差)

考虑输入/输出神经元数量

均匀分布初始化

Xavier初始化

- 学习率选择

太小收敛缓慢

太大阻碍收敛,导致收敛函数在在最小值附近波动或者发散 - 模拟退火算法动态调整学习率

衰减系数t迭代次数

1反向衰减学习率

2.指数衰减学习率

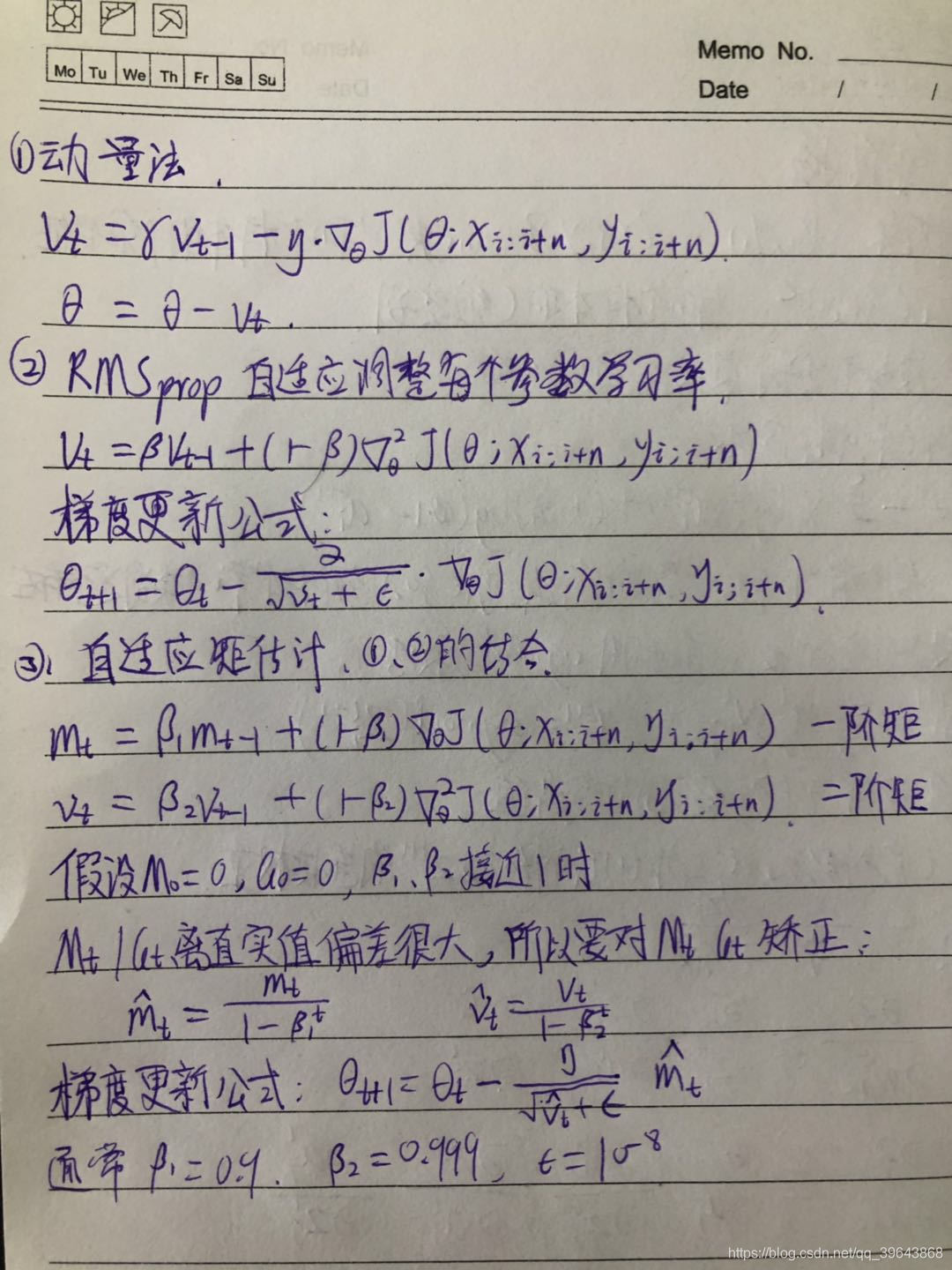

固定衰减模拟退火不能直接泛化到多个数据集 - 动量方法

累计梯度替代当前时刻梯度

类似球下山,下坡时累累积动力,速度越来越快

若某些参数在连续时间内梯度方向不同,动量变小

若连续时间内方向一致,动量增大

动量法可更快速的收俩,并减少目标函数的震荡 - RMSprop

自适应调整每个参数的学习率

克服学习率衰减等问题 - 自适应据估计

自适应调整每个参数的学习率

可看成是RMSprop和动量法的结合

笔记1-神经网络基础

猜你喜欢

转载自blog.csdn.net/qq_39643868/article/details/89548634

今日推荐

周排行