梯度下降法(Gradient Descent):

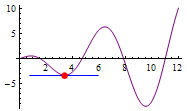

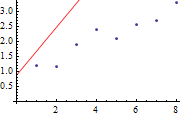

1.假设有一堆按一定规律分布的样本点,用直线拟合,

2.先随意画一条直线,分别计算每个样本点和直线上对应点的距离(误差),求出所有点的误差之和,然后不断旋转和平移,直到误差最小时为止

3.在旋转平移过程中,当误差越来越小时,旋转或移动的量也跟着逐渐变小,当误差小于某个很小的数,就可以收敛了。

4.直线的公式是y=kx+b,k可以控制直线的旋转角度,b可以控制直线的移动,梯度下降法的实质是不断的修改k、b这两个参数值,使最终的误差达到最小。

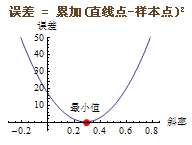

5.最小二乘法:求误差时使用 累加(直线点-样本点)^2,比直接求差距 累加(直线点-样本点) 的效果要好。

6. 根据旋转角度(斜率)和误差画一条函数曲线

从图中可以看出,误差的函数曲线是个二次曲线,凸函数,误差的最小值位于直线的最低端。即曲线上点的切线斜率等于0的坐标值。

这个坐标值就是我们要求的误差最小值和最终的拟合直线的最终斜率。

梯度下降的问题集中到了切线的旋转上。切线旋转至水平时,切线斜率=0,误差降至最小值。

学习率(Learning Rate): 切线每次旋转的幅度,学习率越大,拟合速度越快,但过大,会导致无法拟合。

7. 对于凹凸不平的误差函数曲线,梯度下降时有可能陷入局部最优解。