从例子开始:预测住房价格。

它被称为监督学习是因为对于每个数据来说,我们都给出了正确的答案,告诉我们,房子实际价格是多少。而且,更具体来说,这是一个回归问题,回归一词指的是,我们根据之前的数据预测出一个准确的输出值,对于这个例子就是价格,同时,还有另一种最常见的监督学习,叫做分类问题,当我们想要预测离散的输出值,例如,我们正想要寻找癌症肿瘤,并想要确定肿瘤是良性的还是恶性的,这就是0/1离散输出的问题。

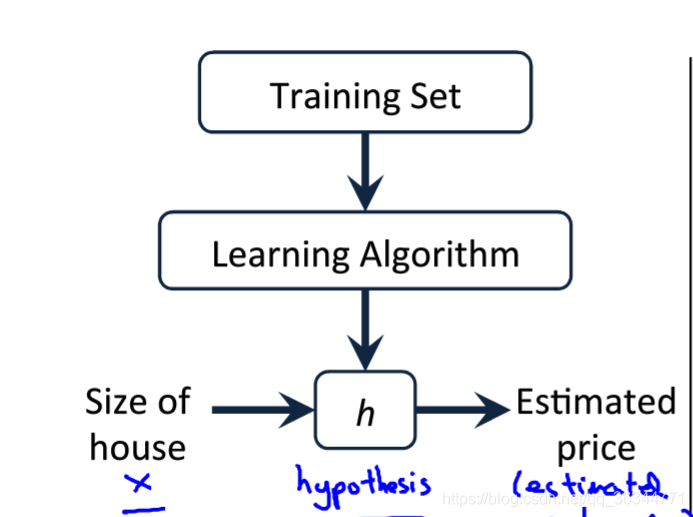

更进一步来说,在监督徐诶中我们有一个数据集,这个数据集被称为训练集。

在整个实验中用小写的m来表示训练样本的数目。

m代表训练集中实例的数量

x代表特征/输入变量

y代表目标变量/输出变量

(x,y)代表训练集中的实例

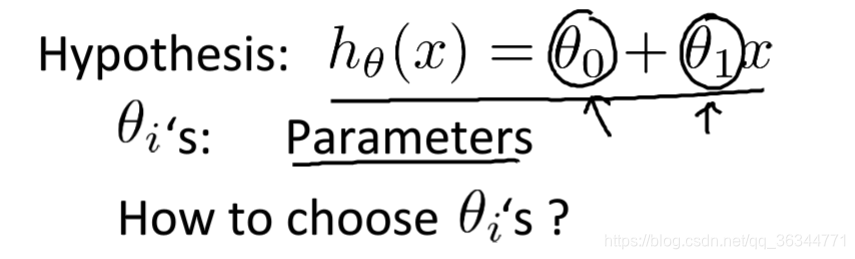

这是监督学习算法的工作方式,我们可以看到这里有我们的训练集里房屋加个,我们把它喂给我们的学习算法。然后输出一个函数,通常表示为小写h,表示,h代表假设hypothesis,h表示一个函数,输出是房屋尺寸大小,就像你朋友想出售的房屋,因此h根据输入的x值和y值,y值对应房子的价格。因此h是一个从x到y的函数映射。

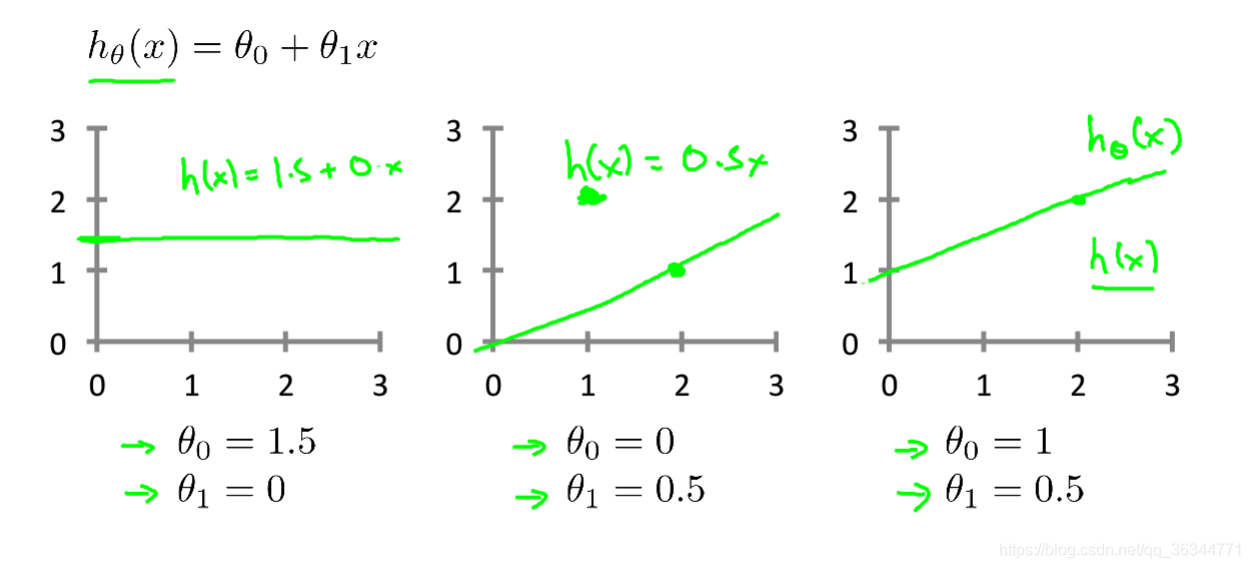

对于我们的放假预测为,我们该如何表达h?

推理的依据是,因为只含有一个特征/输入变量,因此这样的问题叫做单变量线性回归问题。

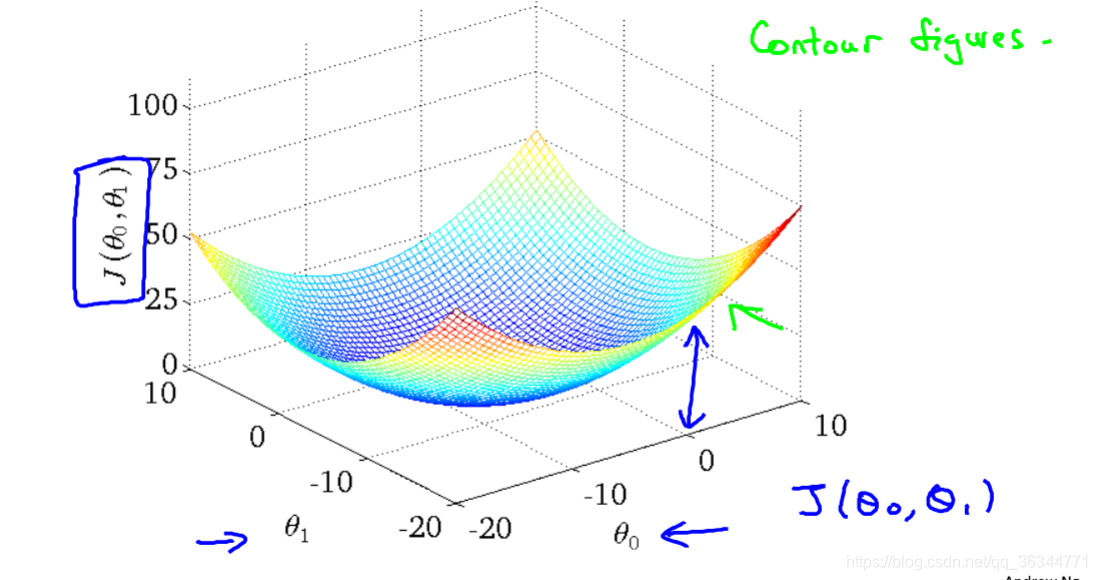

代价函数

我们选择的参数决定了我们得到的直线相对于我们的训练集的准确程度,模型所预测值与训练集中的实际之间的差距就是建模误差。

代价函数Cost Function :公式如上图所示。

其实就是求这个代价函数的最小值,这样估计的最精确,在确定了房屋面积之后,更能确定价格。

这是当其中参数项不等于0的时候的三维图

梯度下降

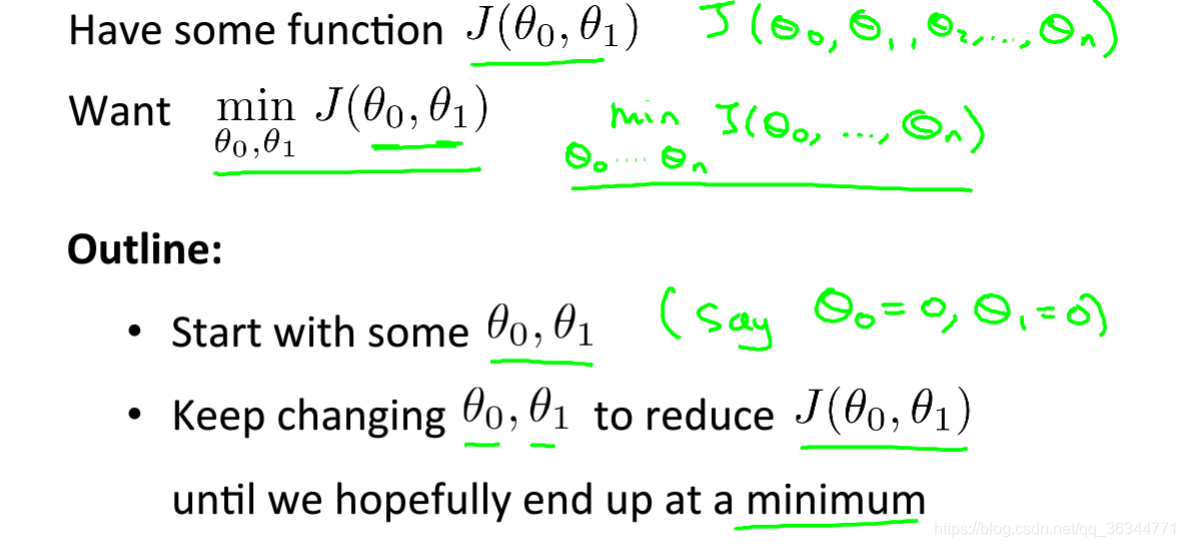

梯度下降是一个用来求函数最小值的算法,我们将使用梯度下降算法来求出代价函数的最小值

梯度下降的思想:开始时我们随机选择一个参数的组合,计算代价函数,然后我们寻找下一个能让代价函数值下降最多的参数组合,我们持续这么做直到到一个局部最小值,因为我们并没有完全尝试所有的参数组合,所以不能确定我们得到的局部最小值是否是全局最小值,选择不同的初始参数组合,可能会找到不同的局部最小值。

想象以下正站立在山的这一点上,站立在你想象的公园这座红色山上,在梯度下降算法中,我们要做的就是旋转360度,看看我们的作为,并问自己要在某个方向上,用小碎步尽快下山,这些小碎步需要朝什么方向?如果我们站在山坡上的这一点,你看一下周围,你会发现最佳的下山方向,你再看看周围,然后再一次想一想,我应该从什么方向迈着小碎步下山?然后你按照自己的判断又迈出了一步,重复上面的步骤,从这个新的点,你环顾四周,并决定从什么方向将会最快下山,然后又迈进了一小步,并以此类推,直到你接近局部最低点的位置。

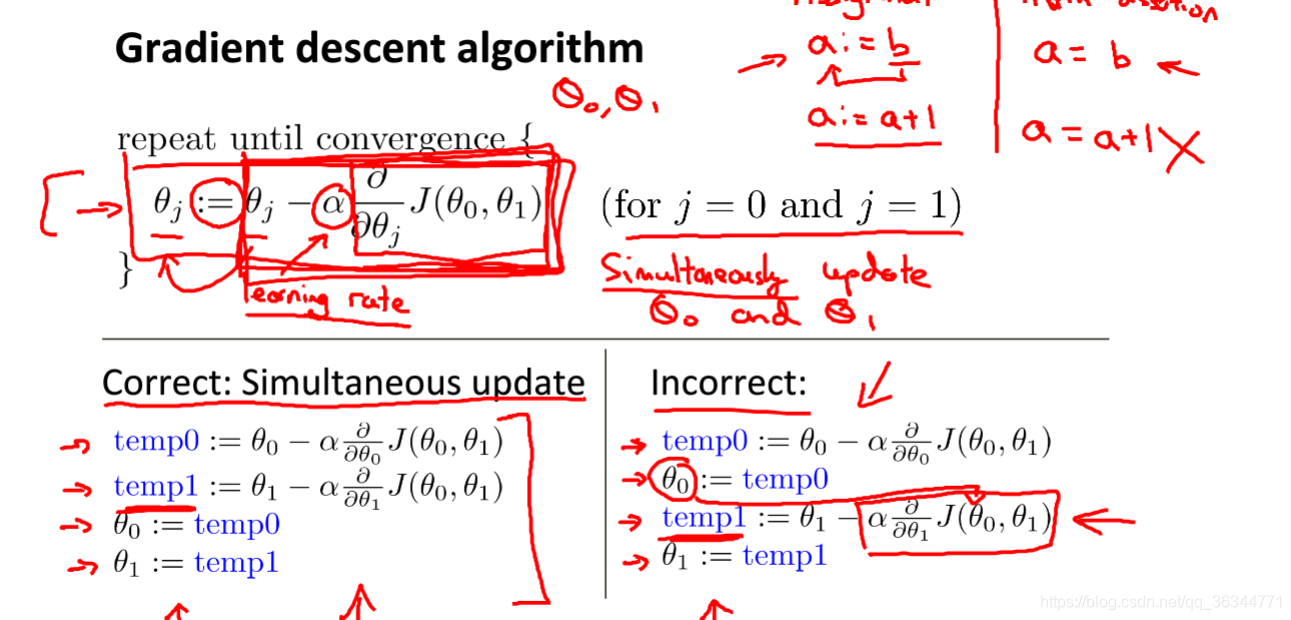

这是批量梯度下降的算法公式。

其中a是学习率,它决定了我们沿着能让代价函数下降程度最大的方向,向下迈出的步子有多大,在批量梯度下降中,我们每一次都同时让所有的参数减去学习速率乘以代价函数的导数。

这个算法需要同时更新两个参数,不能有先后顺序更新。