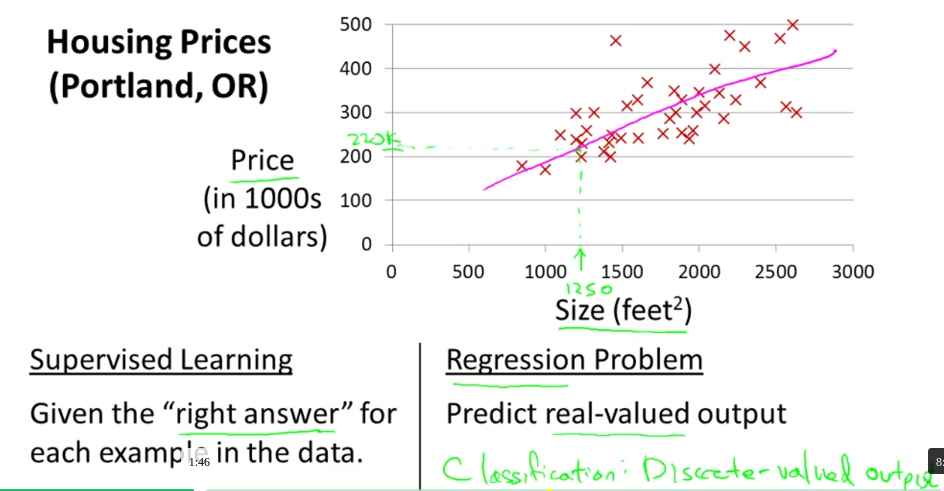

摘要: 给出一个房价预测的例子,x轴是房子的大小,y轴是房子的价格,图中标注了一些房子作为数据集,而这些点被称为标注数据(labeled data),利用这样的数据来预测的方法称为:监督学习。监督学习分为两类:分类与回归,此时,作为预测房价的这个例子是监督学习中的回归例子。

Linear Regression with one Variable(单变量线性回归)

Model and Cost Function(模型和损失函数)

给出一个房价预测的例子,x轴是房子的大小,y轴是房子的价格,图中标注了一些房子作为数据集,而这些点被称为标注数据(labeled data),利用这样的数据来预测的方法称为:监督学习。监督学习分为两类:分类与回归,此时,作为预测房价的这个例子是监督学习中的回归例子。

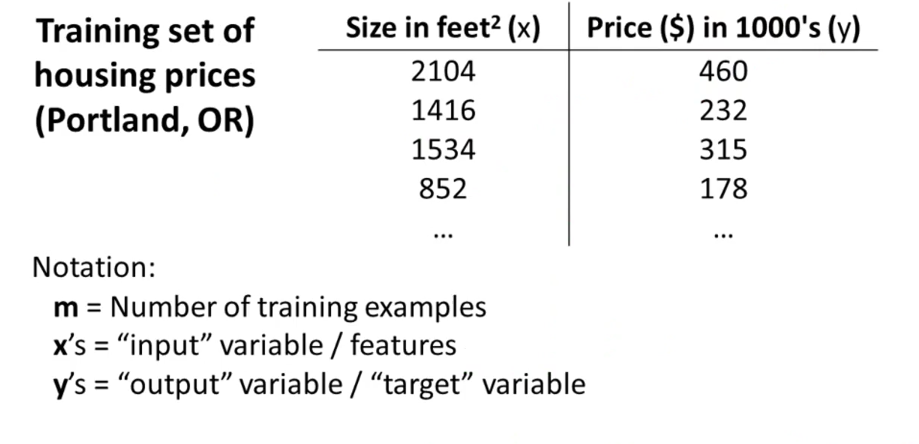

$m$代表是数据集的个数,$x's$是输入变量或者特征,$y's$是输出变量或者目标变量。

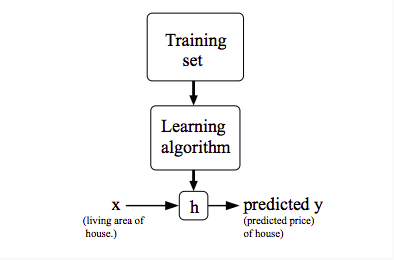

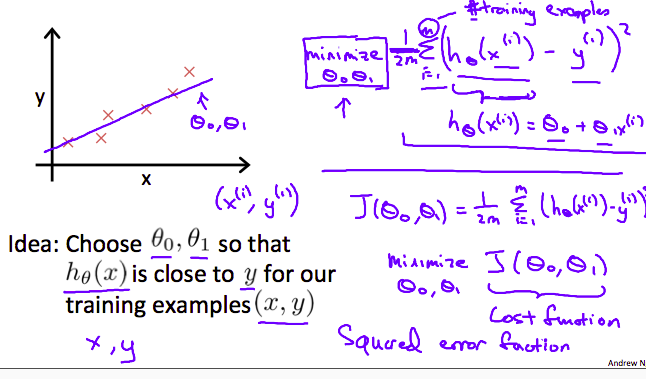

整个预测的过程可以归结为如下图:

通过训练数据,将数据输入到算法里面,我们能得到一个关于这个模型的一个假设$h$,然后利用这个假设$h$我们将其他输入变量输入到该假设中就会得到我们想要的预测结果$y$。那么对于单变量的线性回归我们用如下公式来表示:

线性模型其意思是模型是呈现线性变化的,为什么对于该房价的例子我们要采用单变量的,其原因是该模型的未知参数仅有一个$x$来决定。

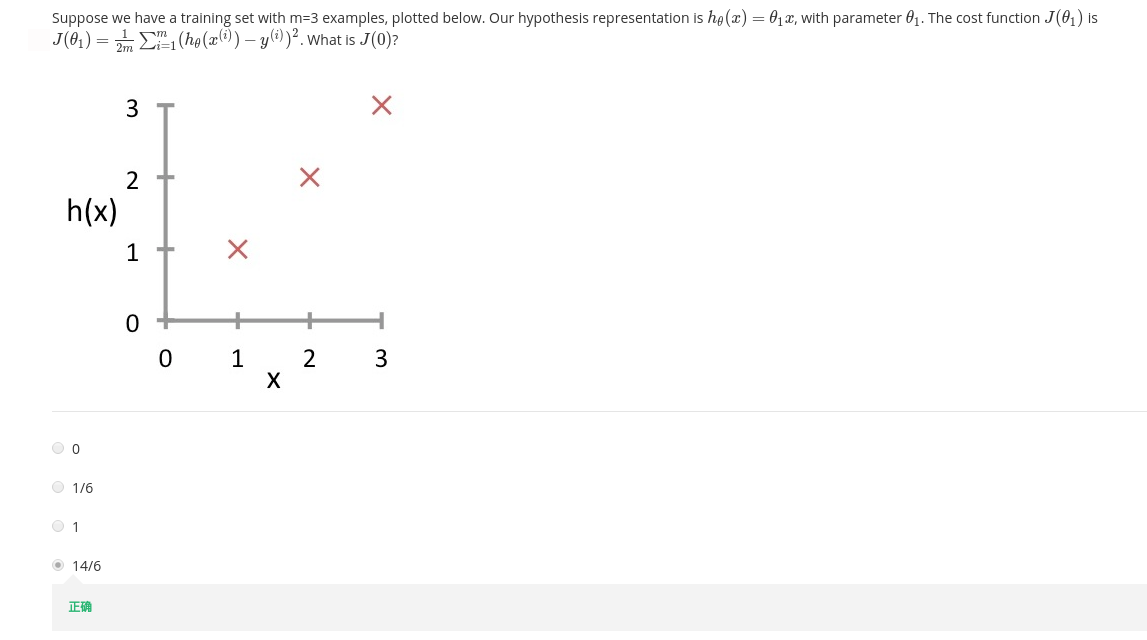

对于假设函数其包含两个参数,$θ_0$和$θ_1$,那么如何来确定这两个参数来使得得出的假设函数直线更好的拟合数据集或者换句话说如何才能判断假设函数所产生的误差最小?

所以,给出如下定义:

第一个公式是最小化预测值与真实值差的平方的值,也叫作均方误差值,是衡量误差的一种方式。第二个公式是我们的假设函数。有时我们更喜欢写成如下形式:

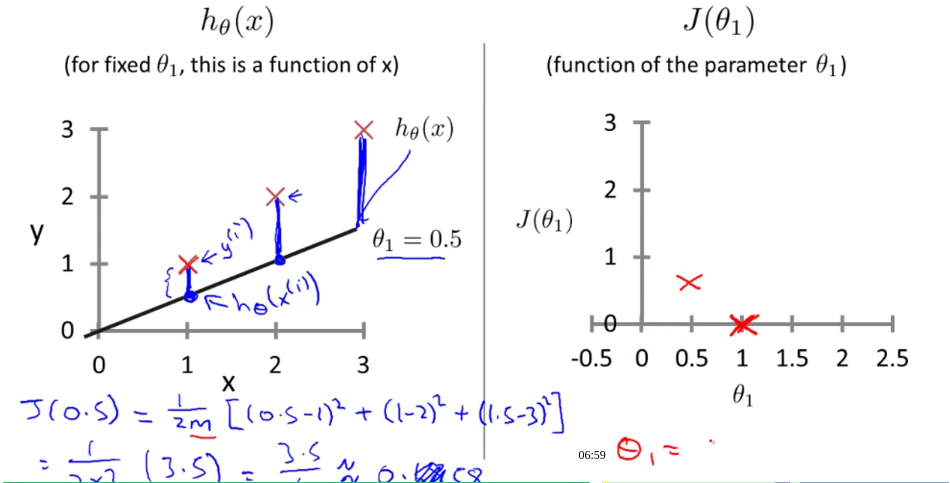

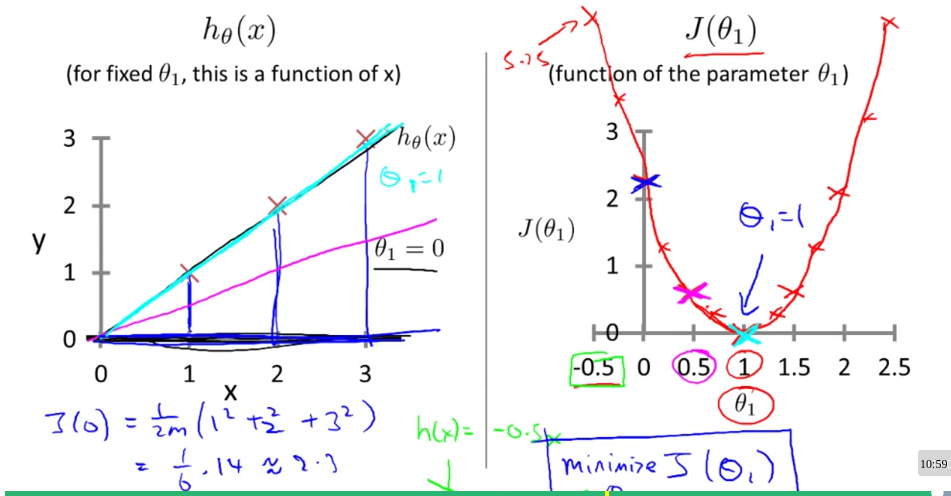

其中的$J(\theta_0,\theta_1)$叫做代价函数(cost function),我们的目的就是最小化代价函数,使得假设函数更加接近真实数据集。为了能更好的解释代价函数我们举个例子并画出能说明其含义的图来:

左边的图在坐标系中分别画了三个的点$(1,1)$,$(2,2)$,$(3,3)$,假设这就是我们的数据集,那么现在我们就要对这个数据集进行假设函数的猜测,当然,学过数学的人一眼就能看出在$\theta_0=0$,$\theta_1=1$时,也就是假设函数$h_\theta(x) = x$时是最吻合数据集的,但是假如该数据集不会这样简单,不能一眼看出它的拟合线来该怎么办呢?注意到,当假设函数越能拟合数据集时,它的代价函数就越接近$0$,所以这就是采用代价函数来选择参数$\theta_0$,$\theta_1$从而产生出更好的假设函数来拟合数据集的原因。

刚刚上面的例子图片采用的二维的图像,因为图片中只包含了两个参数,$\theta_1$和$J(\theta_1)$,如果是三个参数的图片则会映射到三维的图像上面上: