【机器学习】贝叶斯线性回归(最大后验估计+高斯先验) - qq_32742009的博客 - CSDN博客

https://blog.csdn.net/qq_32742009/article/details/81485887

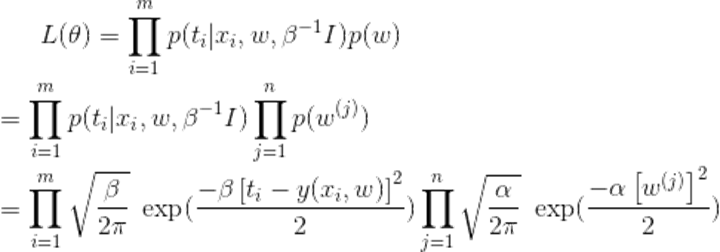

贝叶斯优化(BO)的迭代公式:

- 极大似然函数(后验概率最大化):

- 对数似然:

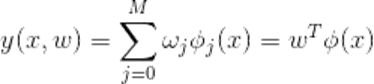

- 最后化简:(这里表明每计算一次w是O(D^3)的复杂度,其中计算y(xi,w)为D2(w乘以f(xi)为D,生成f(xi)为D),求L2范数为D,计算y(xi,w)求和为N,计算w2为D2,总复杂度为max(NDD2,D2)=N*D3)

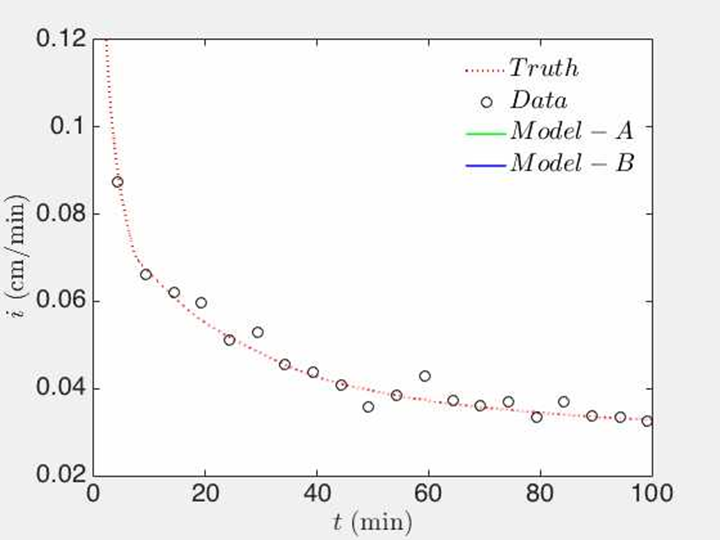

- 由于要迭代N步,每步处理一个DD矩阵(D为特征维数),因此算法复杂度为O(N D^3);且注意,当N逐渐增大的时候,BO算法无限趋近LM算法,但BO算法的开销更大,因此BO不适用于大量样本点的情形,收敛性待证

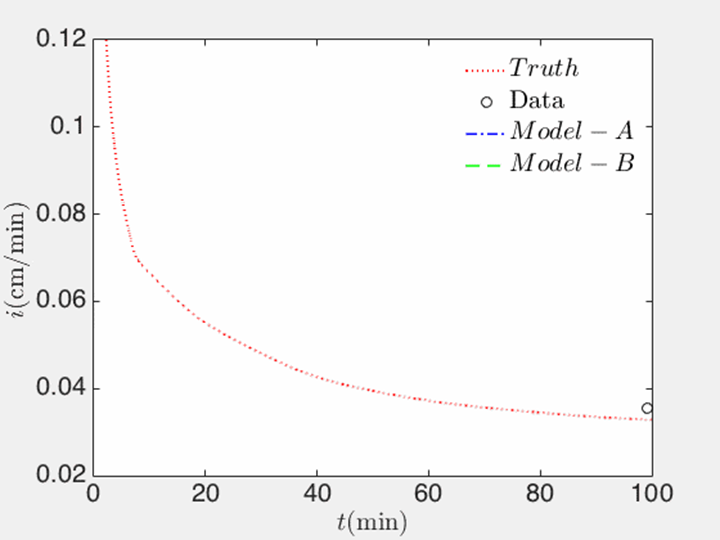

- 但BO算法在样本点过少的情形下,面临着拟合函数参数波动过大的情况(过于依赖前面的样本点)

边缘概率:Marginal likelihood

贝叶斯优化(Bayesian Optimization)深入理解 - marsggbo - 博客园 https://www.cnblogs.com/marsggbo/p/9866764.html

https://app.sigopt.com/static/pdf/SigOpt_Bayesian_Optimization_Primer.pdf

扩展阅读:

http://papers.nips.cc/paper/7917-scalable-hyperparameter-transfer-learning.pdf

https://arxiv.org/pdf/1802.02219.pdf

类似方法:数据同化【在复杂系统中根据更新数据动态地更新模型】

https://earth.esa.int/documents/973910/979015/oneill1-2.pdf

教程:

http://cerea.enpc.fr/HomePages/bocquet/teaching/assim-mb-en.pdf

贝叶斯与数据同化:

https://pdfs.semanticscholar.org/cdb2/10822ceb3cccb6388ad14b2642380e6f36a5.pdf

https://assimilation.kaust.edu.sa/Media%20%20Image%20Gallery/Papers/final_mwr2012_new.pdf