学习朴素贝叶斯分类器时,接触到贝叶斯估计,查阅了很多资料,发现对贝叶斯估计这一名词的具体解释不一,故做如下梳理。

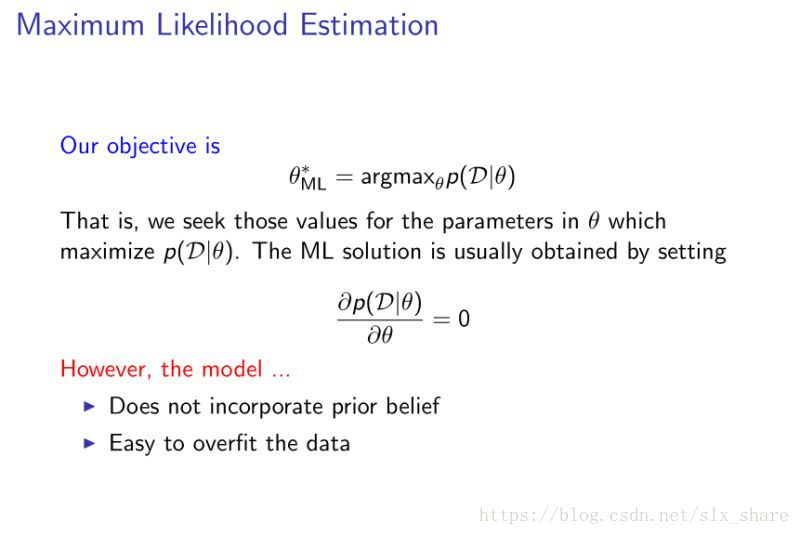

极大似然估计

极大似然估计是频率派提出的参数的点估计方法。

基于参数theta是固定的这一条件, 即使得当前数据集D出现概率最大的参数就是实际参数。

具体求解方法就是对似然函数求导。

贝叶斯估计

贝叶斯估计是贝叶斯派提出的参数估计方法。可分为贝叶斯点估计,贝叶斯区间估计,本文暂不涉及区间估计。

基于参数theta是服从一定先验分布的随机变量这一条件。那么在数据集D出现后,有了新的信息,我们可以依此更新参数theta的分布,这个更新后的分布就是后验概率分布。

贝叶斯点估计方法

既然更新后的参数仍然是服从一定概率分布的随机变量,那么如果我们只要一个参数向量,该如何挑选呢?这就涉及到三类挑选方法:

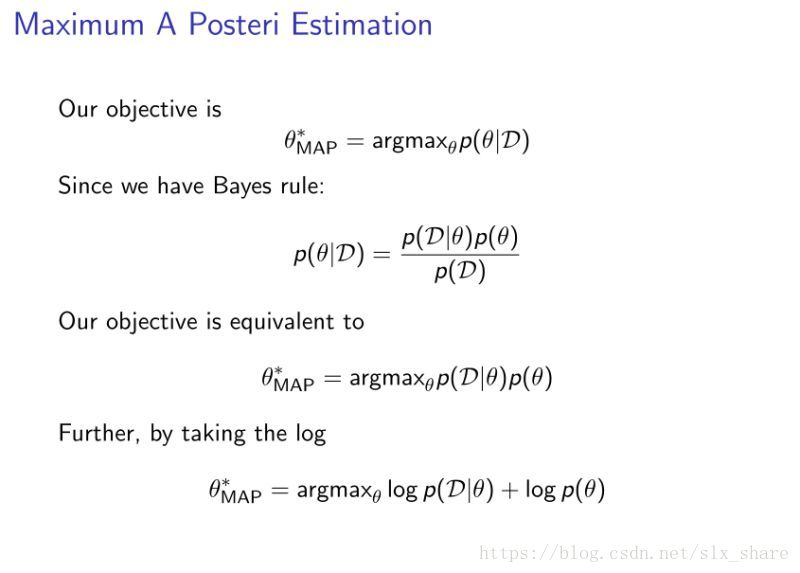

1. 后验众数估计。顾名思义,挑选出现最频繁的参数。也就是说,后验概率分布出现概率最大的theta。故对后验概率分布函数求导即可。这个做法类似于极大似然估计,数学表达式等同于似然函数乘以先验分布(当先验分布为均匀分布,即无信息先验分布时,表达式相同),因此被称为是正则化的极大似然估计,又称为最大后验概率估计(MAP),但切记背后的思想截然不同。

2. 后验中位数估计。挑选参数的中位数,似乎用得少。

3. 后验期望估计。就是选取所有参数的均值,即

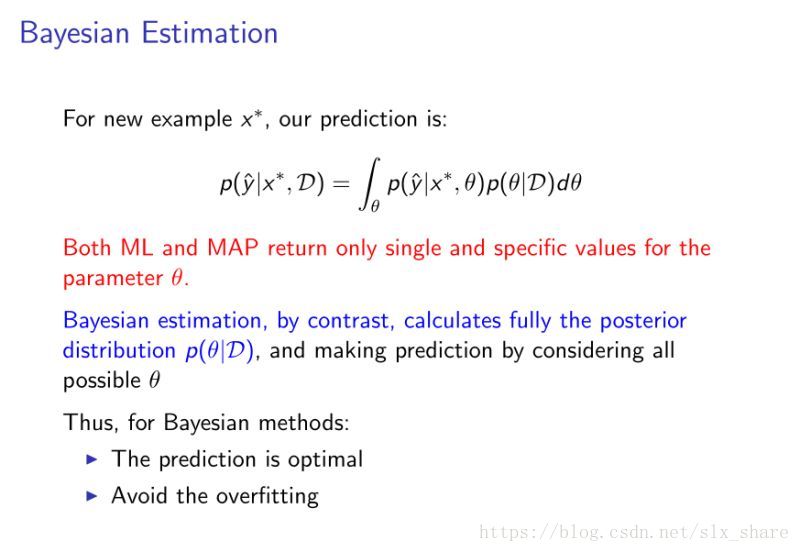

贝叶斯估计

上文中,最大贝叶斯点估计从某种意义上讲,都是选取一个随机变量theta的统计值(众数、中位数和均值)来替代分布,这样做的目的无非就是可以减少计算量。但真正意义上的贝叶斯估计方法应该是使用参数空间中所有的参数,分别建立模型(获取模型的ensemble),然后运用所有的模型进行估计,取所有估计值的期望为最终估计值,权值根据参数的概率分布计算。这样做可以有效避免过拟合,但计算量是十分巨大的。具体降低计算量的方法,后续再讲。

注:本文图片来源, 参考博客