机器学习所针对的问题有两种:一种是回归,一种是分类。回归是解决连续数据的预测问题,而分类是解决离散数据的预测问题。在线性回归中,最小二乘法实质上就是找到一条直线,使所有样本数据到该直线的欧式距离之和最小,即误差最小。

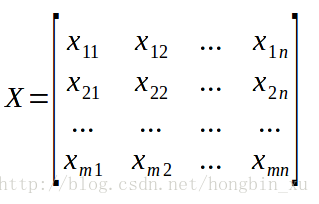

我们假设数据集中共有m个样本,每个样本有n个特征,用X矩阵表示样本和特征,是一个m×n的矩阵。

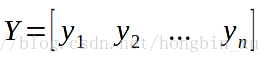

用Y矩阵表示标签,是一个m×1的矩阵:

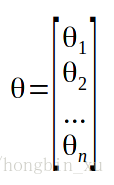

为了构建线性模型,我们还需要假设一些参数:

(有时还要加一个偏差(bias)也就是

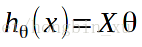

好了,我们可以表示出线性模型了:

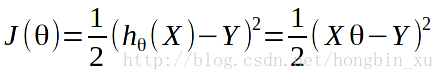

损失函数:

这里的1/2并无太大意义,只是为了求导时能将参数正好消掉而加上。

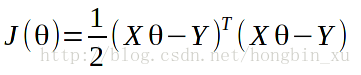

代价函数代表了误差,我们希望它尽可能地小,所以要对它求偏导并令偏导数为0,求解方程。

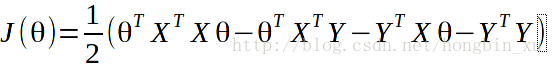

在求偏导之前先展开一下:

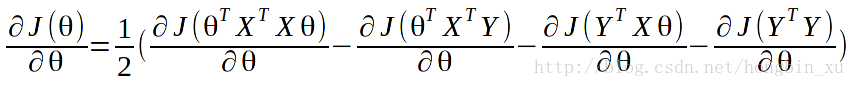

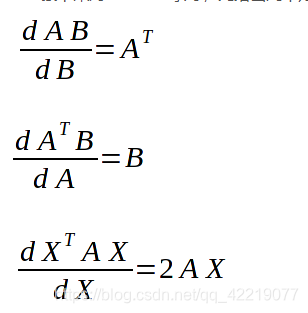

注意几个矩阵求导公式:

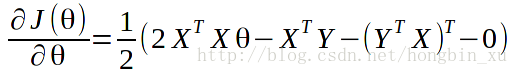

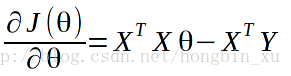

求偏导:

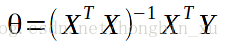

令偏导等于0,得到:

注意:这是在可逆的前提下得到的,事实上存在不可逆的情况。

所以,我们可以根据公式直接求得的值,但是当X维度很高时矩阵求逆计算量非常大,所以我们在实际应用中往往采用梯度下降的算法更新,方法如下: