问题:简述一下线性回归?

1、什么是线性回归

对于给定的数据集,试图学习一个线性模型(y=wx+b),以尽可能准确的预测实值标记。

2、线性模型的假设

很多模型都对数据进行了假设(KNN没有),线性模型的假设有:

样本点的取值是没有测量误差的;

线性,自变量x与因变量y之间是线性关系;

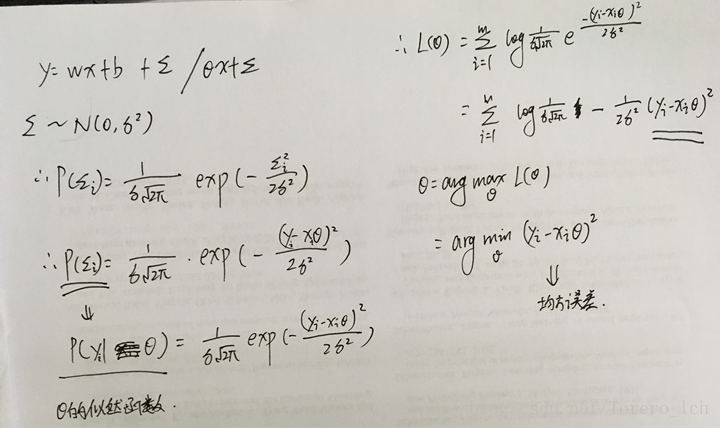

随机干扰项/残差服从零均值,同方差的正态分布,即

为什么会有第三条假设, 在实际应用场景中,很难甚至不可能把导致y结果的所有变量(特征)都找到,放到回归模型里面。我们只存放那些认为比较重要的特征。根据中心极限定理,那些对结果影响比较小的(假设独立分布)之和是趋于正太分布的。

3、线性回归的模型函数、目标函数和求解

线性回归的模型是y=wx+b,怎么样确定模型参数呢,选取什么目标函数/损失函数呢?线性回归一般会使用均方误差来作为误差函数,而基于均方误差最小化来进行模型求解的方法称为最小二乘法。

选择最小二乘法的原因是残差(理论上的误差?)服从均值为0的正态分布,由面下公式可以推导出模型参数θ的似然函数,然后当然是用极大似然估计来估计参数了,落实到实际求解中,就是要最小化图中的那一项,即最小化均方误差。

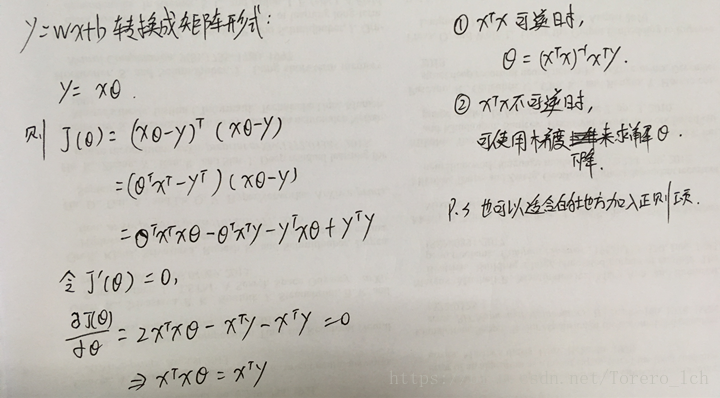

最后一步就是求解参数了,