多元线性方程原理及推导

概念

1.在统计学中,线性回归方程是利用最小二乘函数对一个或多个自变量之间关系进行建模的一种回归分析。这种函数是一个或多个称为回归系数的模型参数的线性组合。只有一个自变量的情况称为简单回归,大于一个自变量的情况叫多元回归。

2.在线性回归中,数据使用线性预测函数来建模,并且未知的函数模型参数也是通过数据来估计。这种模型被叫做线性模型。最常用的线性回归建模是给定的X的条件下y的条件分布的分位数作为X的线性函数表示。像所有形式的回归分析一样,线性回归也是把焦点放在给定X的值的y的条件概率分布,而不是X和y的联合概率分布(多元分析领域)。

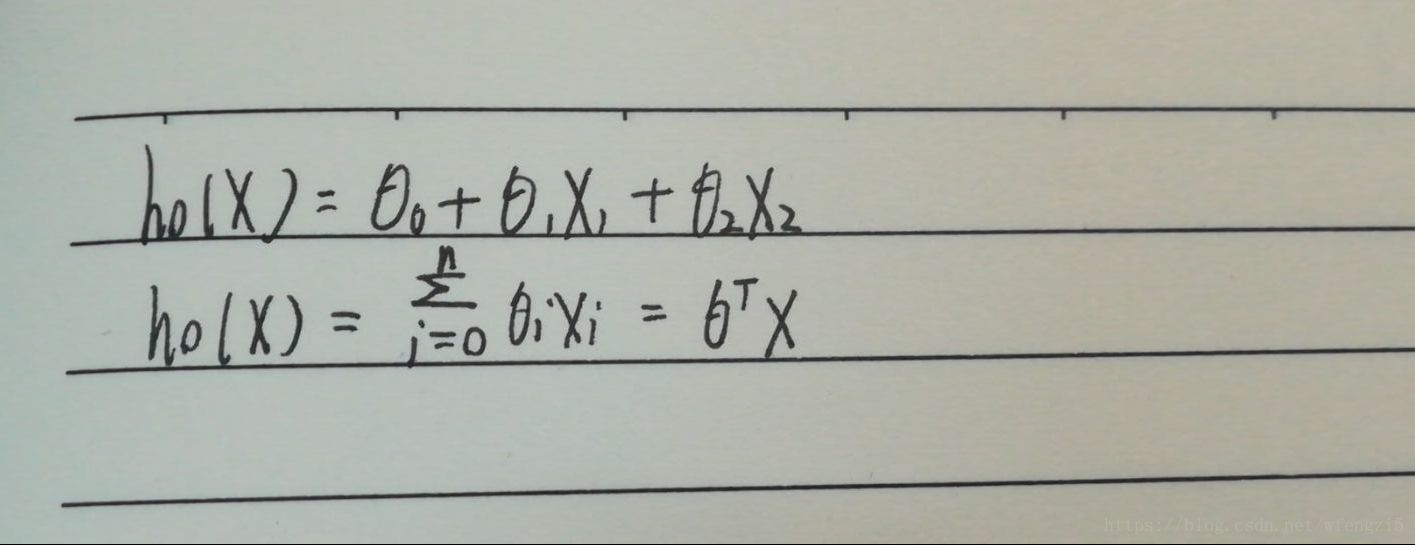

公式

一元线性回归方程:y=a+bx

a称为截距

b为回归直线的斜率

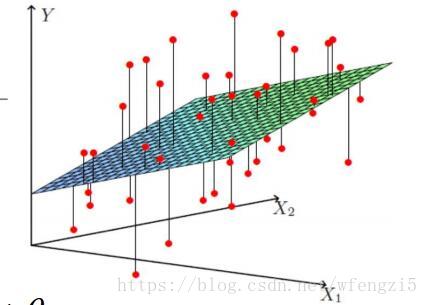

多元线性回归方程:y=b0+b1X1+b2X2+…+bnXn

b0为常数项

b1,b2,b3,…bn称为y对应于x1,x2,x3,…xn的偏回归系数

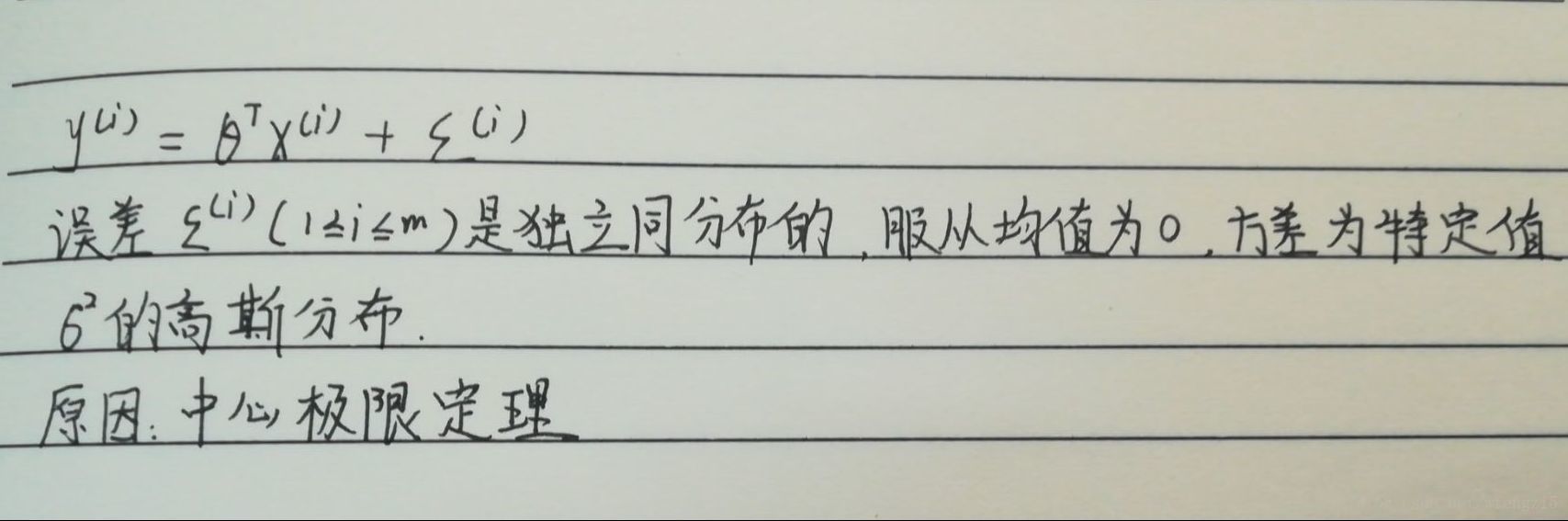

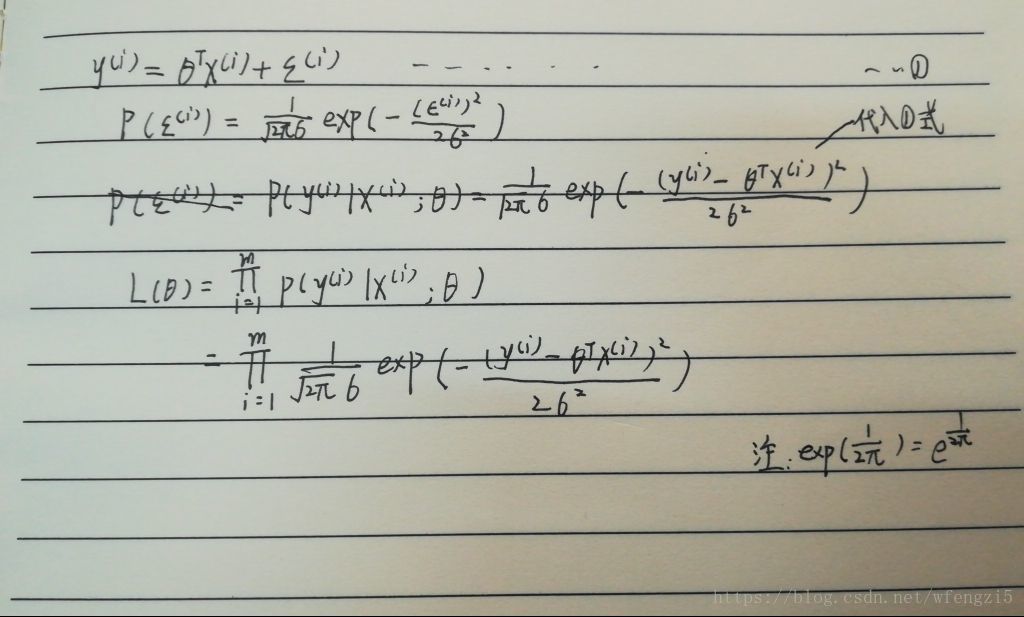

推导

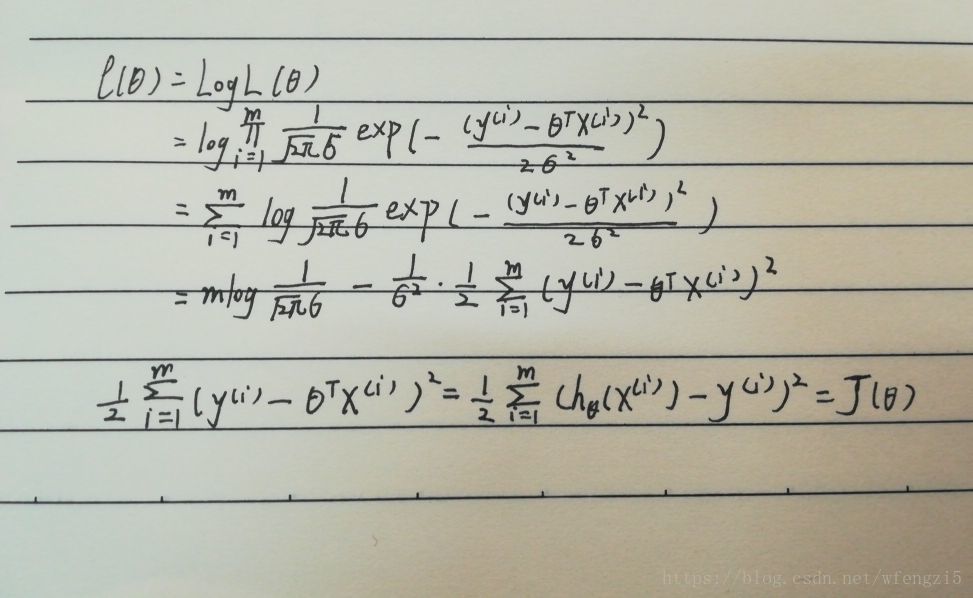

使用极大函数解释最小二乘

似然函数

高斯的对数似然与最小二乘

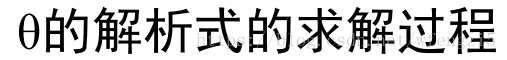

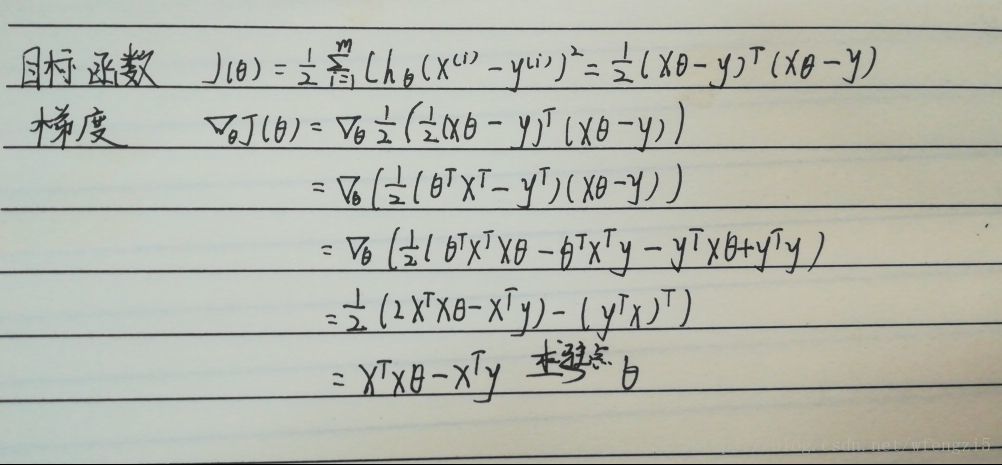

参数的解析式

总结

自我认为多元线性方程的推导过程还是挺麻烦的,需要多看几遍。学习推导的过程中,我们要认识一些数学符号,一些方法,比如最小二乘,极大似然,梯度等等。

事实上,一种现象常常是与多个因素相联系的(比如:房子总价与房子面积,房间数,地段这些因素相关),由多个自变量的最优组合共同来预测或估计因变量,比只用一个自变量进行预测或估计更有效,更符合实际。因此多元线性回归比一元线性回归的实用意义更大。