Introduction

问题:大多数基于CNN的深度神经网络模型并没有充分利用原始低分辨率(LR)图像的分层特征,因此性能相对较低。

本文: 提出了一种新的残差密集网络(RDN)来解决SR中的这个问题。

残差密集网络优点:

(1)充分的利用了所有卷积层的层次信息,通过密集连接卷积层提取丰富的卷积特征。

(2)允许从前一个RDB的状态直接连接到当前RDB的所有层,从而形成连续的内存(CM)机制。

(3)可以更有效地从先前和当前局部特征中学习更有效的特征,并稳定更广泛的网络的训练。

contribution:

(1) 提出了一个统一的网络框架—RDN 用于高质量的图像恢复。网络充分利用了原始低质图像(LQ)的层次特征。

(2)提出残差密集块(RDB),它不仅可以通过连续记忆(CM)机制从前一个 RDB 读取状态,还可以通过局部密集连接充分利用其中的所有层。然后通过局部特征融合(LFF)自适应地保留累积的特征。

(3)我们提出了全局特征融合以自适应地融合 LR 空间中所有 RDB 的分层特征。利用全局残差学习,我们将浅层特征和深层特征结合在一起,从原始 LR 图像中得到全局密集特征。

问题:什么是全局特征融合,什么是局部特特征融合

Residual Dense Network for IR

在图2中我们展示了我们所提出的RDN用于图像恢复,包括图像超分辨、去噪和压缩去伪影。

3.1 Network Structure

我们主要将图像超分辨为例并且对于去噪和压缩去伪影的情况给予明确的论证。

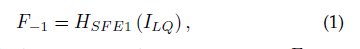

如图2(a)所示,我们的RDN主要由四部分组成:浅层特征提取网络(SFENet)、残差密集块(RDBs)、密集特征融合(DFF)以及上采样网络(UPNet)。在这里我们将ILQ和IHQ作为RDN的输入和输出图像。具体来说,我们使用两层卷积层来提取浅的映射层。第一个卷积层从LQ输入中提取映射F-1:

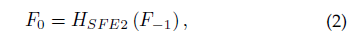

在这里HSFE1(.)代表了卷积操作,F-1用于更进一步的浅层特征提取和全局残差映射。所以我们更进一步的有:

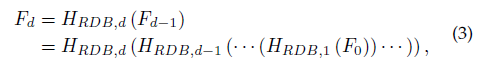

在这里HSFE2(.)代表了第二个浅层特征提取的卷积操作并且作为密集残差网络的输入。假设我们有D个密集残差网络,那么第d个RDB的输出Fd 可以由如下公式获得:

HRDB.d表示第d个RDB(残差密集网络)。HRDB.d可以是一个复合函数的操作,例如卷积和RELU。因为Fd是由利用d个RDB网络块的每一个层生成的,我们可以将Fd看作局部特征。

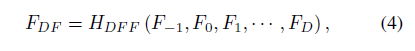

我们提取了一系列的RDBs等级特征之后,进一步将他们进行密集特征融合(DFF),它包括全局特征融合(GFF)和全局残差学习。DFF充分利用了先前的层可以表示为

提取了低质空间的局部特征和全局特征之后,我们进行上采样生成高质量图片。我们在这里利用上采样网络中的ESPCN[42]之后再加一个卷积层。输出的RDB即:

RDN for DN and CAR

如上图(b)所示,我们去除上采样结构,通过残差学习获得高质量图像

3.2 Network Structure

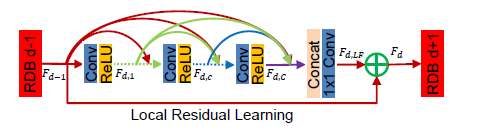

如下图所示,文章提出的RDB包括密集连接层、局部特征融合(LFF)、和局部残差学习,生成一个连续的存储机制(CM)。

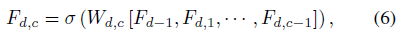

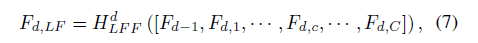

连续存储机制(CM): 如上面所讲述的RDB模块一样,使Fd-1和Fd作为第d个RDB模块的输入和输出,并且都有Go个特征层。第d个RDB模块的第c个卷积层的输出可以表示为:

σ表示ReLU激活函数。Wd,c是第c个卷积层的权重,偏置在这里被简化省略了。我们假设Fdc有G个映射层,[Fd-1, Fd,1, …,Fd,c-1] 表示联合映射层,一共有(c - 1) x G + Go 个映射层。这种结构不尽保留了先前的特征还保存了局部密集特征。

局部特征融合(LFF): 我们应用LFF去自适应融合先前的RDB块和当前RDB的卷积层。如上面介绍的那样,第d-1个RDB块的map特征直接以连接的方式加到第d个RDB块上。减少特征的数量是很有必要的。另一方面,我们使用一个卷积层控制输出的信息。我们将这种操作叫做局部特征融合(LFF):

在这里HdLFF在第d个RDB模块的1x1卷积函数。 我们还发现了G的增长速率很大,不带LFF的的深度密集网络很难训练。然而,高的增长速率也带来好的性能。

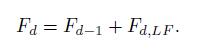

局部残差学习(LRL): 因为在一个RDB块中有很多个卷积层,我们在RDB块中使用LRL来增加信息的流动和加大增长速率。第d个RDB的输出可以由下式获得

我们可以看到LRL也可以进一步的提高网络的表示能力。

3.3 密集特征融合(DFF)

和上面的局部特征融合相类似,DFF由全局特征融合和全局残差学习所组成。

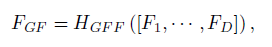

Global feature Fusion(GFF): 我们所提出的GFF是融合所有的RDB块的特征去提取全局特征FGF

HGFF是一个1x1 和 3x3 卷积的符合函数。1x1卷积层用来融合不同的层次特征,3x3卷积对残差学习进一步提取特征。

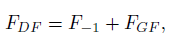

Global residual learning(GRL): 然后我们在上采样之前使用GRL去获得特征映射

在这里F-1代表浅层特征映射。在我们所提到的RDB结构中,在全局特征融合之前,所有的其他层都被充分的利用到。

值的注意的是在Tai等[18]的paper里利用了长的密集网络恢复了更多的高频信息。然而,在记忆存储模块,先前的层没有直接连接到所有的子序列层。局部特征信息没有充分运用。另外,MemNet在高质空间提取特征会增加计算的复杂度。,因此我们提取局部的和全局特征在LQ space。