Concatenated Attention Neural Network for Image Restoration

摘要:在本文中,我们提出了用于低级视觉任务的通用框架,包括图像压缩伪像减少和图像去噪。 在此框架下,专门设计了一种新颖的级联注意神经网络(CANet)用于图像恢复。 本文的主要贡献如下:首先,通过应用简洁但有效的级联和特征选择机制,我们建立了一种新颖的连接机制,将模块堆叠网络中的不同模块连接起来。 其次,在每个模块卷积层中都使用了像素级和通道级注意力机制,这促进了图像中更多基本信息的进一步提取。 最后,我们通过充分的压缩伪影去除和图像降噪实验,证明了CANet比以前的最新技术具有更好的效果。

一、介绍

图像恢复(IR)旨在从相应的损坏的低质量(LQ)图像中恢复高质量(HQ)图像。 这是一个不适定的逆过程,一直是一个挑战,但在计算机视觉领域是受欢迎的研究领域。 在大量的应用场景中,IR可以为用户带来良好的视觉体验并协助高级视觉应用。 图1显示了减少图像压缩伪影的视觉示例。

随着深度学习的普及,IR也迎来了春天。 2016年,Dong等人首先提出了一种基于深度卷积网络的压缩伪像减少方法,并在当时很容易获得最佳性能[5]。 后来,Zhang等人充分利用了像素和离散余弦变换(DCT)域的优势,并采用了多尺度卷积神经网络来去除JPEG压缩伪像[25]。 文献[30]提出了一种新颖的隐式双域卷积网络,用于鲁棒的彩色图像压缩伪像减少。 张等人提出了一种新的DnCNN方法[22],通过引入残差学习和批处理归一化来解决这个问题。 [20]设计了一个称为MemNet的新存储网络用于图像恢复。 在[7]中,设计了一种新的噪声估计子网,以进一步提高图像去噪模型的效率。 文献[1]提出了信道注意去除噪声的高效率。 另外,Zhang等人引入了一个非本地关注的非常深的网络,并且在图像去噪和压缩伪像减少任务中均取得了可喜的成果[27]。

但是,前面说明的方法中仍然存在一些问题。首先,许多算法使用大量复杂的块来构成它们的网络,而用于连接块的单元素操作导致提取信息的效率低下。 其次,大多数算法没有探索执行任务的注意力机制[19],或者只有少数算法仅在特定模块下使用它。 因此,在红外先验研究中,注意力机制尚未得到充分利用。 另一方面,为了最小化噪声和损坏的信息的不良影响,IR是典型的任务,需要谨慎使用图像信息。 如果仅将注意力网络添加到本地部分,则未过滤的噪声将干扰后续过程中特征图的最终结果。 总之,需要开发一个更好的注意力网络来解决极度损坏的图像。

为了解决上述问题,本文提出了许多低级视觉任务的通用框架。 在此框架下,块之间的级联和注意机制在图像恢复中被采用,这加快了级联注意神经网络(CANet)的形成。在CANet中,每个块(称为关注块(A块))由基于像素注意和通道注意机制的剩余模块组成。请注意,在一个要素图中,其某些像素和通道可能包含比其他像素更多的噪声信息。 A块可以减少这些信息在像素和通道方面带来的不良影响。 同时,在由多层组成的每个关注块(A-block)中,放弃了将每个块的输出直接传递到后续块的方式。 引入了一种新的功能重用机制。 它可以将电流输出与从前一个块提取的特征融合到下一个块,并以本地和全局方式进行特征选择操作。 这样,最终功能可以在本地和全局混合。 接下来,特征重用操作监督特征信息的输出。 最后,代替ResNet [8]逐元素操作,采用级联操作以避免有效信息的丢失。 实验表明,在压缩伪影去除和图像去噪任务方面,CANet比以前的最新方法获得更好的结果。

这项工作的主要贡献包括三个方面:

1)提出了一种新的图像复原通用框架,该框架使用模块堆叠方法来实现特征重用和特征选择。 串联和特征选择操作用于在本地和全局重用特征。 不同模块中特征融合的过程可以使网络以进化的方式恢复图像质量。

2)我们提出了一个相当轻量级的注意力残差模块,该模块由像素级注意力和通道级注意力组成。 逐个像素注意用于过滤像素空间信息,而逐个通道模块用于收集逐个通道的整体信息,然后执行信道注意机制。 所有这些使从分层功能中获取有效信息成为可能。

3)我们证明,在各种图像恢复任务(如图像去噪,压缩伪像减少)中,CANet的性能优于某些最新技术

二、相关工作

2.1 图像修复神经网络

鉴于一些成功的深度学习方法,包括用于超分辨率任务的SRCNN [6]和用于图像压缩伪影减少的四层CNN [5],在低级视觉任务中,如何获得高性能的网络体系结构一直都是 一直是热门话题。 例如,张等人提出了一个深层网络。基于残差学习和批量归一化[11]的DnCNN [22]用于图像去噪,此后,残差学习的引入在图像去噪方面取得了很大的进展。 Lim等人[14]通过删除批处理归一化层来设计EDSR,并在当时达到了新的最新性能。 Huang等[10]利用卷积成分之间的密集连接提出了DenseNet。 他们没有盲目地追求更深,更广泛的神经网络,而是探索了更有效地重用特征的措施。 Qiu等[18]提出了一种用于单图像超分辨率的递归网络EBRN,使浅层和深层分别恢复图像的低频信息和高频信息。

2.2 注意力机制

最近,已经出现了几种与注意力机制有关的创新方法。 Hu等[9]提出了一种基于通道注意机制的挤压与激励(SE)块图像分类方法。 他们创造性地使用全局池来收集全局信息,然后使用两个卷积层来计算频道关注权重。 此外,Zhang等[26]通过引入信道注意来设计RCAN,以解决超分辨率问题。 RIDNet [1]结合了扩展卷积和通道注意来进行图像降噪,并获得了出色的性能。此外,Zhang等[27]提出了一种用于图像恢复任务的深度残差非局部网络(RNAN)。 RNAN显示非本地注意力提高了网络的表示能力,秦等人[17]在此基础上提出了FFANet,它通过结合像素级和通道级注意力机制对单幅图像进行去雾处理,从而大大提高了网络的性能。

三、级联注意力网络

3.1 级联框架

在本节中,我们将说明所提议的级联注意网络(CANet)模型的详细信息。 该架构如图2所示,主要由N个关注块(A块)和跳过连接组成。

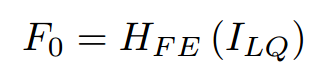

如图2所示,CANet使用A块逐步重构高质量图像。 A块由几个A层组成,每个A层由像素级和通道级注意力层组成。 两个块之间的要素传输是通过局部和全局跳过连接完成的。 在这里,我们为低质量图像设置![]() ,为高质量图像设置

,为高质量图像设置![]() 。

。

第一层提取特征![]() :

:

其中![]() 是将图像从像素空间转换为特征空间的卷积层。

是将图像从像素空间转换为特征空间的卷积层。 ![]() 通过远程跳过连接用于全局残差学习。 然后,我们还有:

通过远程跳过连接用于全局残差学习。 然后,我们还有:

其中![]() 表示第一个A块。

表示第一个A块。 ![]() 还传递给全局残差学习。 因此,我们有:

还传递给全局残差学习。 因此,我们有: ;

;

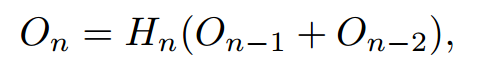

其中![]() 是第n个A块的输出(F0除外)。 块的每个输出都传递到注意力层,并且与下一个块的输出具有本地跳过连接。

是第n个A块的输出(F0除外)。 块的每个输出都传递到注意力层,并且与下一个块的输出具有本地跳过连接。 ![]() 表示注意力层,将在后续章节中详细介绍。

表示注意力层,将在后续章节中详细介绍。 ![]() 联结为本地跳过连接。 最后,我们有

联结为本地跳过连接。 最后,我们有![]() ;

;

和![]()

此处,![]() 全部串联起来以进行全局跳过连接。

全部串联起来以进行全局跳过连接。 ![]() 是一个复合函数,

是一个复合函数,![]() 是网络的最终输出图像。 通过使用全局残差学习(GRL),网络实际上可以学习HQ图像和LQ图像之间的残差。

是网络的最终输出图像。 通过使用全局残差学习(GRL),网络实际上可以学习HQ图像和LQ图像之间的残差。

3.2 注意力残差块

在本节中,我们将介绍有关注意残差块(A块)的详细信息。在许多计算机视觉任务中,大量实验表明注意力机制表现出卓越的性能。 但是,大多数为减少压缩伪影和图像去噪而设计的网络都在像素方向和通道方向上均等对待,这可能会限制网络的表示能力。 为了改善这一点,CANet采用了特殊注意残差块,该残差块由按像素和按通道的注意层(A层)构成。 如图2所示。 Ablock由N个A层组成:

其中![]() 是第n个A层的输出,而

是第n个A层的输出,而![]() 是第n个A层的函数。A块是递归计算单元。 A块的最终输出为

是第n个A层的函数。A块是递归计算单元。 A块的最终输出为![]() 。

。

在图3中,基于先前的残差网络研究,通过在通道注意层之前引入逐像素注意层,开发了局部残差机制进行深度训练,然后使用多个A层形成一个A块 在CANet中。

3.3 逐像素注意力机制

像素注意(PA)层如图4所示。 CANet将特征从先前的卷积层馈送到PA层,PA层由三个1×1卷积层,两个PRelu和一个S型激活函数组成。 该机制可以显示为

其中Conv1,Conv2和Conv3都是1×1卷积,它们逐渐将特征图通道的尺寸从H×W×C减小到H×W×1。δ1和δ2是PRelu激活函数,而α是sigmoid。sigmoid的输出![]() 是特征的权重。 在这里,我们重新调整

是特征的权重。 在这里,我们重新调整![]() ,以将元素按要素相乘为

,以将元素按要素相乘为

通过A层的结构(参见图3),其他有价值的图像像素通过增加高质量的权重而降低低质量的像素而受到更多关注。 结果,这种结构可以帮助CANet从低质量的图像重建损坏的信息。

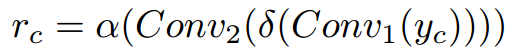

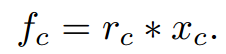

3.4 通道注意力

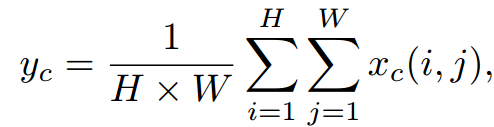

通道注意包括几个步骤(参见图4)。 首先,将特征图馈入通道方式的全局平均池层:

其中![]() 是特征图X的第c个通道在位置

是特征图X的第c个通道在位置![]() 处的特征值。全局平均池化运算符收集通道全局信息并将特征图从

处的特征值。全局平均池化运算符收集通道全局信息并将特征图从![]() 。 然后将

。 然后将![]() 传递到两个卷积层中,一个是PRelu和S形激活运算符,它获得了通道注意的权重。 此外,我们有

传递到两个卷积层中,一个是PRelu和S形激活运算符,它获得了通道注意的权重。 此外,我们有

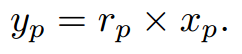

其中Conv1减小yc的通道,而Conv2对该通道进行上采样。 δ和α是PRelu和S形运算符。 最后,将输入xc和rc与逐元素相乘,我们得到

整个过程如图3所示。 通过在像素注意之后添加通道注意层,而不是仅关注像素权重,A层可以平衡不同通道中有用和损坏的信息的问题。

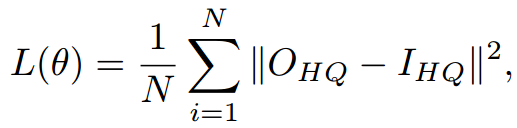

3.5 损失函数

对于低级视觉任务,已经使用了几种不同的损失函数,例如L2损失[16],L1损失[28],知觉损失和对抗损失[13]。 为了与其他方法公平地比较,特别是RNAN [27]和IDCN [31],选择了L2损失函数:

其中θ是CANet的参数。 ![]() 代表网络的输出,其中

代表网络的输出,其中![]() 是地面真相,而

是地面真相,而![]() 表示l2范数。

表示l2范数。

3.6 应用细节

在本文中,超参数设置如下。 CANet包含5个A块,每个块由6个A层组成。 卷积层的内核大小通常为3×3。对于像素级和通道级注意,采用1×1卷积。 A层输出的通道数固定为64。

4 实验

4.1 细节和指标

我们进行的实验着重于图像降噪和JPEG压缩伪像减少的任务。 DIV2K [21]用于训练我们的模型。 为了保持与原始工作的一致性[27] [31],为了减少压缩伪像,所有900个DIV2K图像(包括800个DIV2K训练数据和100个DIV2K验证数据)都用于训练,而BSDS500的100个验证图像均用于训练。 用于验证。 对于图像去噪,我们选择800个DIV2K数据进行训练,并选择Kodak24数据集进行验证,然后从每个输入中提取16个大小为48×48的色块。 Adam [12]被用作优化器。 学习速率设置为10−4,并且所有型号都使用1080Ti GPU和RTX2080Ti进行训练。 此外,在每个任务中均使用通用数据集进行测试,并将峰值信噪比(PSNR)和结构相似性指数(SSIM)作为评估指标。

4.3 图像去噪

在图像去噪任务中,保留了一些与zhang等[27]一致的结果,并将Kodak24用于验证数据集并在Urban100和CBSD68中进行测试。 对于每个数据集,我们都需要测试不同的AWGN噪声级别(例如10、30、50)。 比较方法包括:ARCNN [5],CBM3D [4],TNRD [3],RED [16],DnCNN [22],MemNet [20],IRCNN [23],FFDNet [24],RIDNet [1]和 RNAN [27]。

所有结果示于表2。 毫不奇怪,在不同噪声水平下,CANet在所有数据集上均具有最佳结果。 RNAN也具有优越的性能,但CANet的参数不到RNAN的一半(见表3)。 CANet为326万,远远少于750万RNAN。 对于图像去噪任务,在去除噪声的同时重建高频信息非常重要且困难。 视觉结果也在图6和图7中给出。 以CBSD68中的“ 241048”为例,我们给出了河流AWGN噪声(σ= 50)和视觉比较。 尽管大多数方法在去噪方面具有明显的效果,但它们几乎遭受严重的细节损失(河流中的波纹)的困扰。

但是CANet可以保留比其他方法更详细的内容。 从CBSD68看到“ 145086”。 虽然目标是消除噪音并保持草的质地,但该图显示RNAN几乎会丢失所有的纹理信息,而CANet可以更好地保留草的质地。

5 总结

在本文中,我们提出了用于低级视觉任务的通用框架,包括图像压缩伪像的减少和图像降噪。 在此框架下,CANet内置了几个用于图像恢复的剩余注意力块,具有强大的图像提取功能。 接下来,我们使用特征选择和级联操作来连接块,其结果还可以用作低级视觉任务的通用手段,例如图像压缩伪像去除,图像去噪。 实验表明,我们的方法优于基准数据集上的几种最新方法。 但是,实际上,在低级视觉任务下,视觉细节和纹理信息的恢复仍然很困难。 现有的方法都无法完美解决此问题。 在未来的工作中,我们计划恢复更多的细节和纹理信息以进行图像还原,并将我们的框架扩展到其他任务,例如超分辨率,图像去雾,图像去模糊。