线性回归是机器学习中最基本的一个算法,但是那些所谓的效果很好的算法也无非是从这些基础算法慢慢演变而来。我面试很多的互联网公司都十分重视基础。一些简单的东西学好了,很多复杂的东西以前看不懂的东西就会迎刃而解的。机器算法的每个细节都不要去忽略,不然会让你错失很多机会。

非常感谢 的课程对我学机器学习有很大的帮助。

话不多说,接下来是干货。

预备知识:极大似然估计

机器学习中,我们现在来简单的思考一下机器学习的本质问题。片面来说,机器学习的过程就是从样本空间寻找拟合函数的过程。这里所谓的拟合函数多种多样,当一个拟合函数的基本模型定下后,就需要通过样本空间的大量样本来调整拟合函数模型的一些参数定形(这里主要讲的是参数学习算法),使之能够进行更加准确的拟合。由此可见极大似然估计在机器学习中是有举足轻重的地位。

https://blog.csdn.net/zengxiantao1994/article/details/72787849大家可以去这篇博客看极大似然估计的内容。我觉得写得很好。

线性回归:

一个小李子

预测一个人去银行可以贷款多少钱?

数据:工资和年龄(2个特征)

思考:工资和年龄都会影响银行贷款的结果,那么他们各自有多大的影响呢?

通俗理解:我们设X1,X2分别为年龄和工资特征,h(x)是银行最终会借给我们多少钱。我们需要一个面去最好的拟合我们的数据点。

假设

扩展到多维并整合:

真实值与预测值之间肯定会有误差(我们用

对于每个样本:

其中:误差

由于误差服从高斯分布则:

由此可以推出:

得到似然函数:

要算其极大值,所以要算其导数。这种似然函数求偏导是很难的。因此要将它转换为对数似然函数。

对数似然函数:

展开化简:

获得目标函数也称(代价函数,Cost Function):

有了目标函数,我们的目的就是找到一组参数theta使得代价最小,稍有常识的人就能知道,这个函数肯定是有最小值的。

要求目标函数最小值,先求目标函数的偏导:

偏导等于0:

当然很显然的是,如果矩阵不可逆就不能用这个方案了。

出现这个情况的原因可能是:

1.各个特征不独立、有关联,比如出现了重量和质量两个特征(至少在同一个地方两者完全成比 例)

2.特征数量大于所给训练集样本个数。

梯度下降:

损失函数:

拿出两个维度去画图

为了寻找山谷的最低点,也就是我们的目标函数终点。先随机给定给个

(1):找到当前最合适的方向(梯度方向)

(2):走那么一小步,走快了该” 跌倒 ” 了

(3):按照方向与步伐去更新我们的参数

梯度下降方法有3种: 损失函数

批量梯度下降(GD): 慢 容易得到最优解,但是由于每次考虑所有样本,速度很慢

随机梯度下降(SGD):特别快 每次找到一个样本,迭代速度快,但不一定每次都朝着收敛方向

小批量梯度下降:实用 每次更新选择一小部分数据来算(一般是32,64,128)

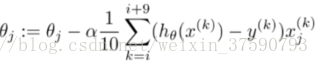

每次向下滑要慢慢滑,就是要个步长,我们定义为α(学习率)往往很小的一个值(从小开始,不行再小)。向下滑动的次数,就是迭代的次数,我定义为num_iter,相对α往往很大。定义好这两个,我们就可以一边求梯度,一边向下滑了。也就是去更新

评估方法:

对于一个线性回归算法好不好,不能从我们眼睛看到的效果去评估,我们应该选择一个方法去定量的评估一个回归算法拟合的好不好。

最常用的评估项R2:

R2的取值越接近于1我们认为模型拟合得越好。