二分类

众所周知,二分类问题的损失函数为:

其中y代表标签值(0,1);h(θ,x)代表通过假设假设函数(sigmoid 函数)计算出的函数值(概率),sigmoid 函数的取值区间为(0,1)

当标签值为1时,h(θ,x)的值为预测y为1的概率,这个值越靠近0,logh(θ,x)的值就会越大,从而对loss值的惩罚也就越大;反之当标签值为0时,1-h(θ,x)的值为预测y为0的概率,这个值越靠近0,log(1-h(θ,x))的值就会越大。

二分类问题的决策函数为:

![]()

多分类(softmax)

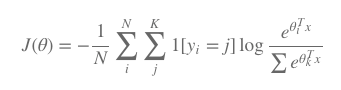

二分类问题也可以看做是多分类问题的特例,由此,K分类问题的loss函数表达式也可以延伸为:

多分类问题(softmax)的决策函数为:

![]()

(与二分类函数的决策函数比较,二分类函数的决策函数依然可以视为K分类问题的特例)

总结

由此不难看出,在keras里面activation选择sigmoid的时候,与之对应的loss为binary_crossentropy;同理,activation选择softmax的时候,与之对应的loss为categorical_crossentropy