版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/sinat_36811967/article/details/84378246

逻辑回归主要用来解决二分类问题,但是在工作学习中,我们肯定会碰到多分类的问题,下面就简单介绍下用逻辑回归解决多分类问题的方法。

one-VS-rest

从上面的名字就可以看出来,这个做法是通过对一个n分类问题训练n个分类器,其中每个分类器是区分某一个类别和剩下所有类别的(1,0)。预测的时候,根据每个分类器预测为某一类(1)的概率,最大值即为预测结果。

优点:普适性较广,效率相对较好,多少个类别训练多少个分类器即可。

缺点:如果种类较多,各个分类器数据不平衡的现象就会非常明显。

one-VS-one

顾名思义,就是对所有类别每两个训练一个分类器,那么要训练的分类器就有n*(n-1)/2 个,预测的时候就是投票法,每个分类器预测得到某个类别,看哪个类别最终得票最多就是结果。

这样做的优点就是可以规避上一种方法训练数据不平衡的问题,性能相对稳定;还有就是训练模型虽然多,但是相对简单,训练效率会有提升。

缺点就是要训练的分类器太多了,随着分类的增多,要训练的分类器个数呈平方级别的增长。

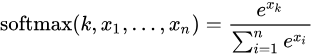

Softmax

softmax在数学定义上就是对LR二分类在多分类情况下的拓展。

在处理一些样本可能丛属多个类别的分类问题是,使用前两种方法有可能达到更好的效果。

Softmax 回归适合处理一个样本尽可能属于一种类别的多分类问题。