版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/sinat_36811967/article/details/84777467

softmax多分类的假设函数为:

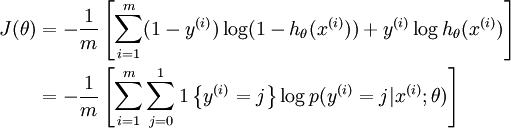

在下面的公式中,1{}是示性函数,其取值规则为:1{取值为真的表达式}=1,1{取值为假的表达式}=0。举例来说,表达式 1{2+2=4}的值为1 ,1{5+2=4}的值为 0。softmax代价函数为:

由此可推出逻辑回归二分类代价函数为:

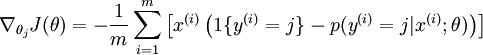

经过求导,梯度公式如下:

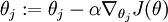

所以参数更新:

Reference:

http://deeplearning.stanford.edu/wiki/index.php/Softmax回归