马尔科夫决策过程

Makov的定义

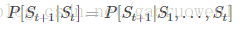

下一个状态的产生只和当前的状态有关,即:

本来直观上讲,下一个状态的产生跟所有历史状态是有关的,也就是等式右边所示。但是Markov的定义则是忽略掉历史信息,只保留当前状态的信息来预测下一个状态,这就叫Markov。

状态转移概率

对于一个具体的状态s和它的下一个状态s’ ,它们的状态转移概率(就是从s转移到s’的概率)定义为:

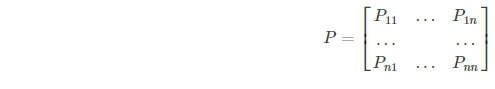

假如总共有n种状态可以选择。那么状态转移矩阵P定义为:

矩阵中第 i 行表示:当前状态为

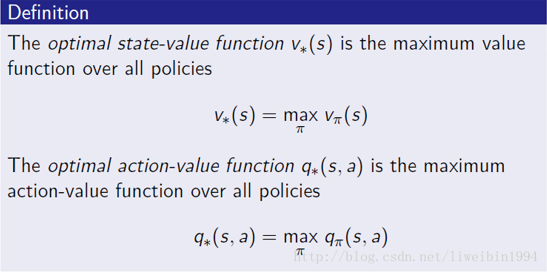

q∗(s,a):在所有的策略中产生的状态动作价值函数中最大的那个函数。

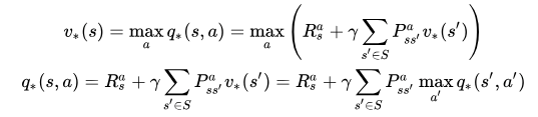

贝尔曼最优方程

v 描述了处于一个状态的长期最优化价值,即在这个状态下考虑到所有可能发生的后续动作,并且都挑选最优的动作来执行的情况下,这个状态的价值

q 描述了处于一个状态并执行某个动作后所带来的长期最优价值,即在这个状态下执行某一特定动作后,考虑再之后所有可能处于的状态并且在这些状态下总是选取最优动作来执行所带来的长期价值。

由上面的公式可以,要求最优值需要一步步迭代计算,是一个递归过程。具体在代码中怎么计算,就要使用到价值迭代、策略迭代、Q-learning、Sarsa等。

附:参考马尔科夫决策过程

</div>