原文地址:

https://www.cnblogs.com/pinard/p/9426283.html

---------------------------------------------------------------------------------------

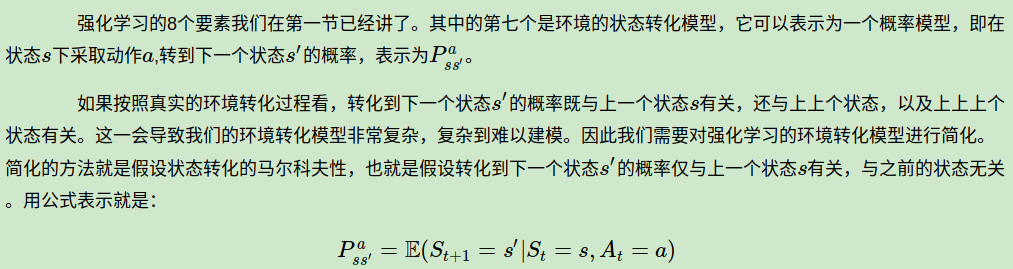

在强化学习(一)模型基础中,我们讲到了强化学习模型的8个基本要素。但是仅凭这些要素还是无法使用强化学习来帮助我们解决问题的, 在讲到模型训练前,模型的简化也很重要,这一篇主要就是讲如何利用马尔科夫决策过程(Markov Decision Process,以下简称MDP)来简化强化学习的建模。

MDP这一篇对应Sutton书的第三章和UCL强化学习课程的第二讲。

1. 强化学习引入MDP的原因

对于马尔科夫性本身,我之前讲过的隐马尔科夫模型HMM(一)HMM模型,条件随机场CRF(一)从随机场到线性链条件随机场以及MCMC(二)马尔科夫链都有讲到。它本身是一个比较简单的假设,因此这里就不专门对“马尔可夫性”做专门的讲述了。

2. MDP的价值函数与贝尔曼方程