6-1 Kernel Ridge Regression

前面几篇:

机器学习技法笔记1:线性SVM

机器学习技法笔记2: SVM的对偶形式

机器学习技法笔记3: Kernel SVM

机器学习技法笔记4: Soft Margin SVM

机器学习技法笔记5: kernel逻辑回归

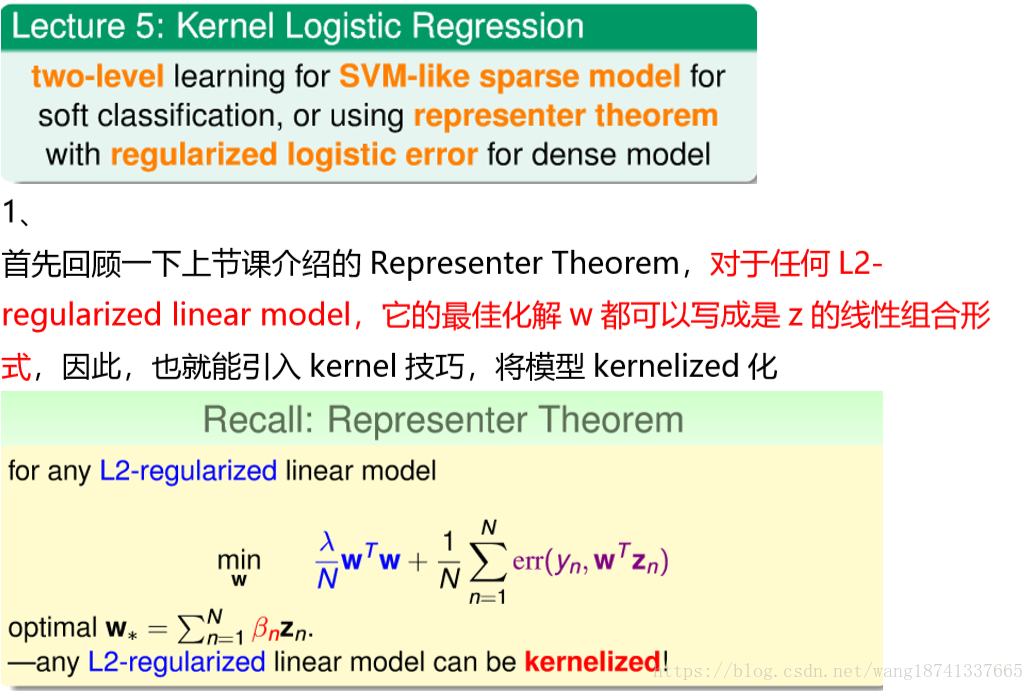

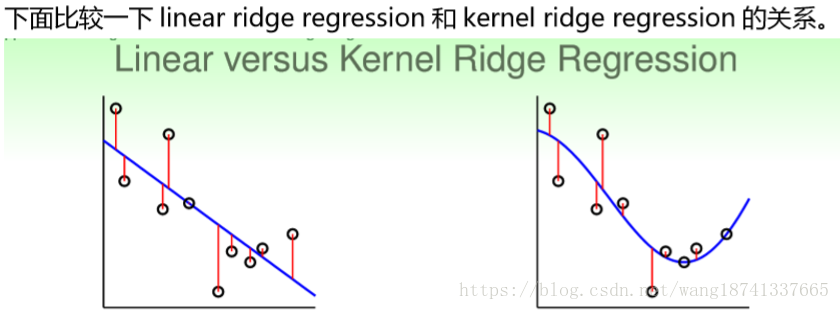

上节课我们主要介绍了Kernel Logistic Regression,讨论如何把SVM的技巧 应用在soft-binary classification上。方法是使用2-level learning,先利用 SVM得到参数b和w,然后再用通用的logistic regression优化算法,通过 迭代优化,对参数b和w进行微调,得到最佳解。然后,也介绍了可以通过 Representetive Theorem,在z空间中,引入SVM的kernel技巧,直接对 logistic regression进行求解。本节课将延伸上节课的内容,讨论如何将SVM 的kernel技巧应用到ridge regression问题上。

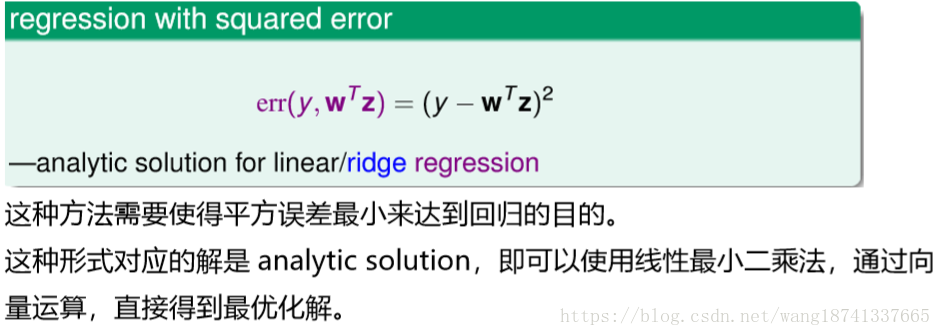

若上面式子中的错误函数为平方误差,就可以得到岭回归(也就是带正则项的线性回归)的形式

在机器学习基石课程中给出过岭回归的解析解如下,这里不详细描述:

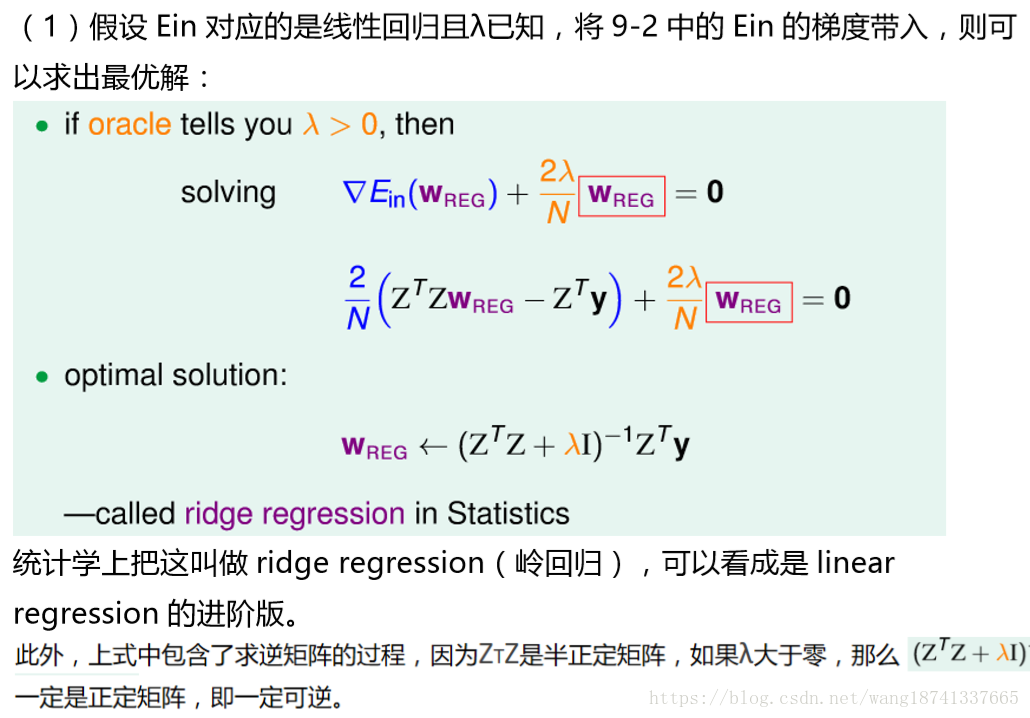

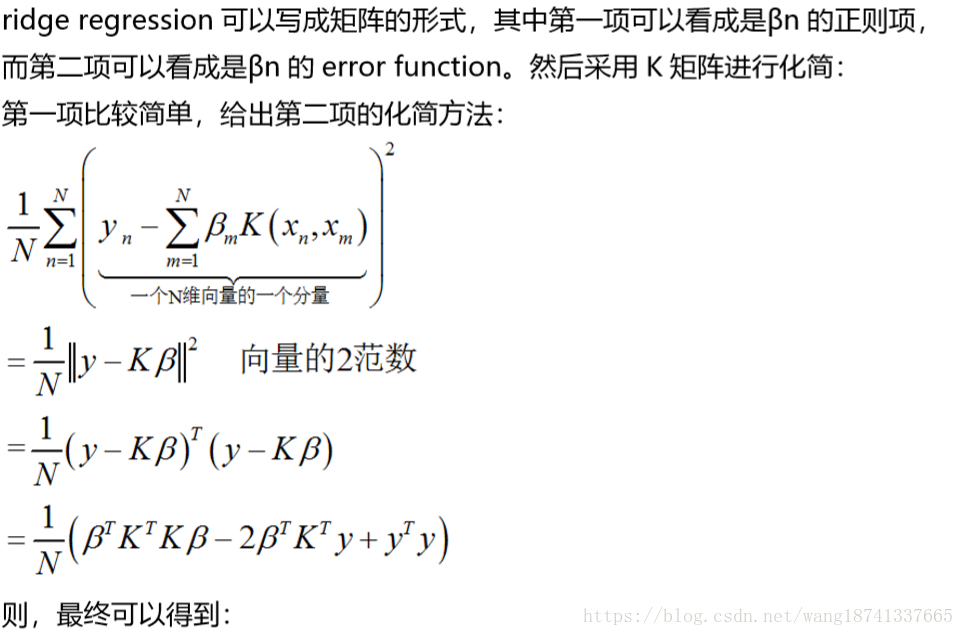

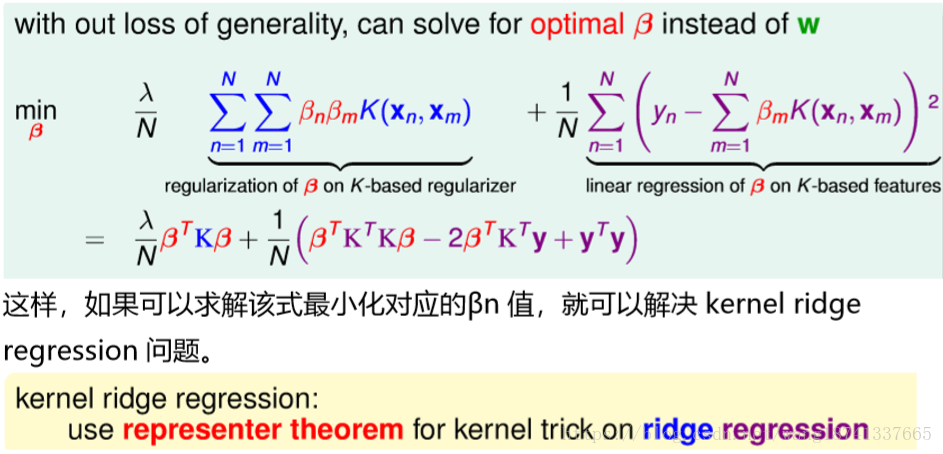

接下来我们尝试使用kernel技巧来解决岭回归问题

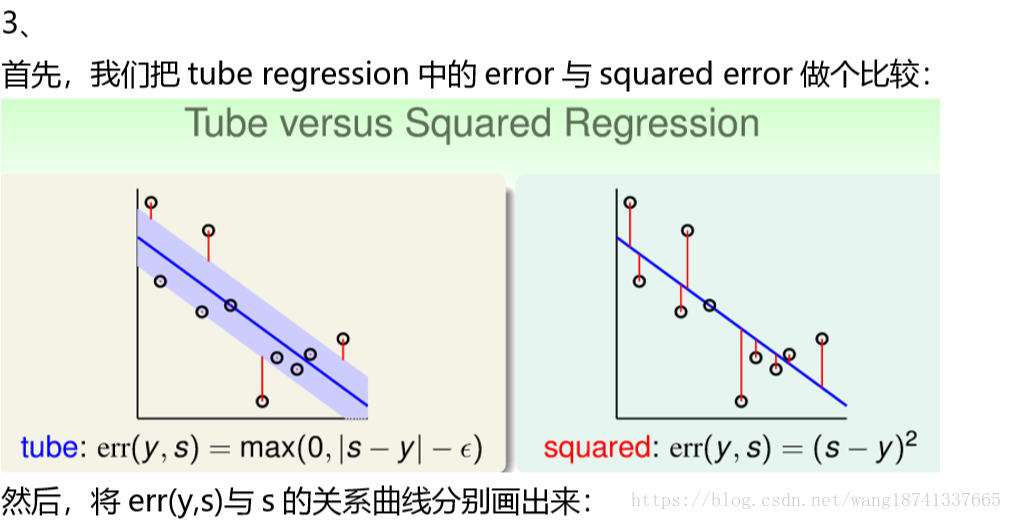

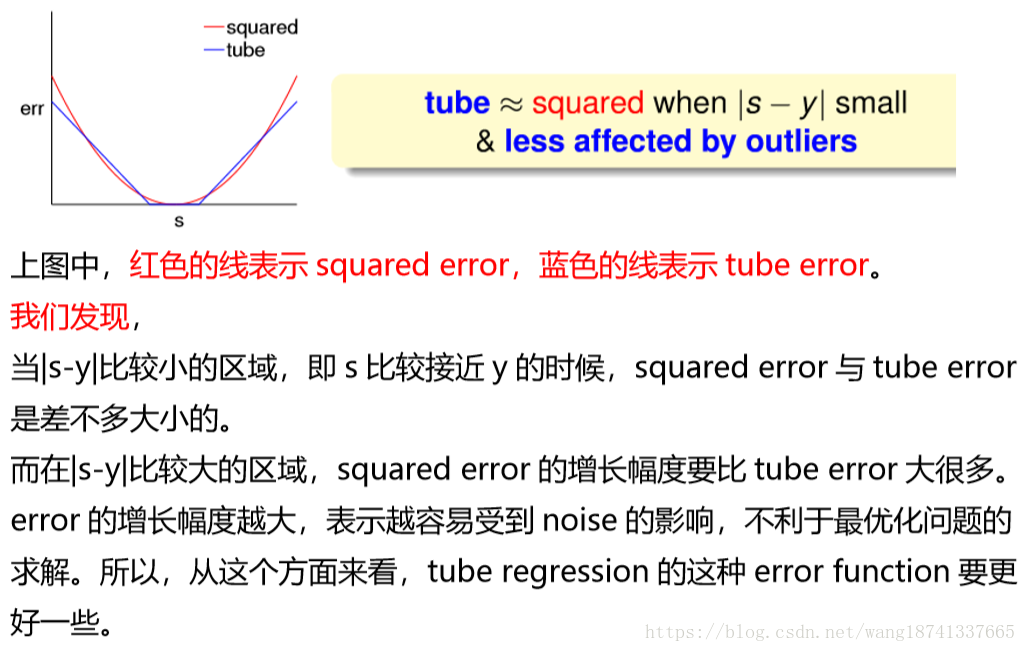

3、

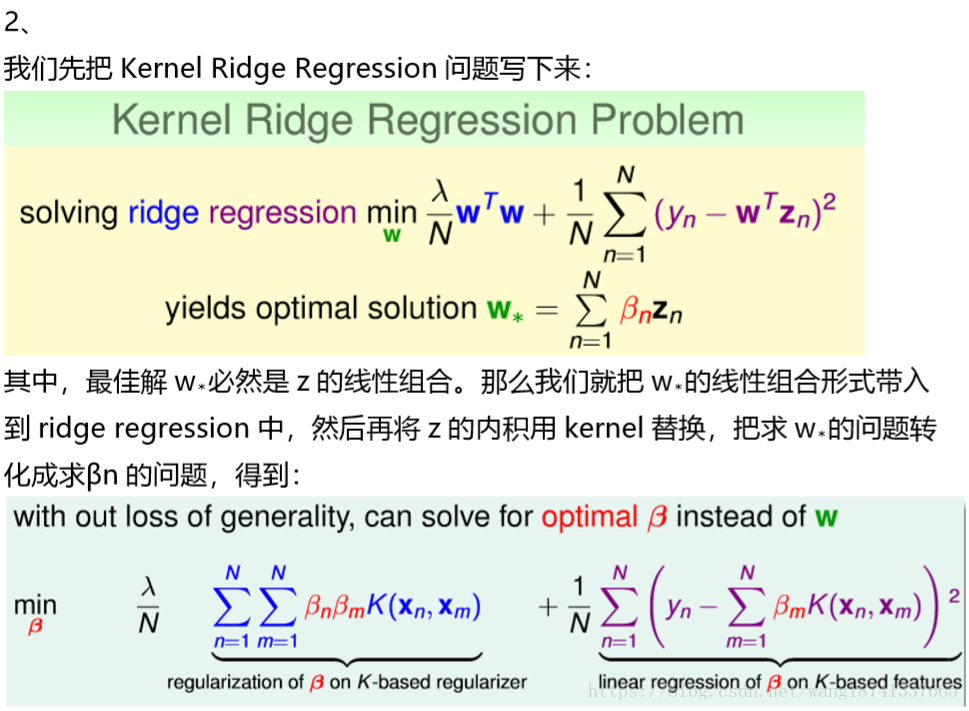

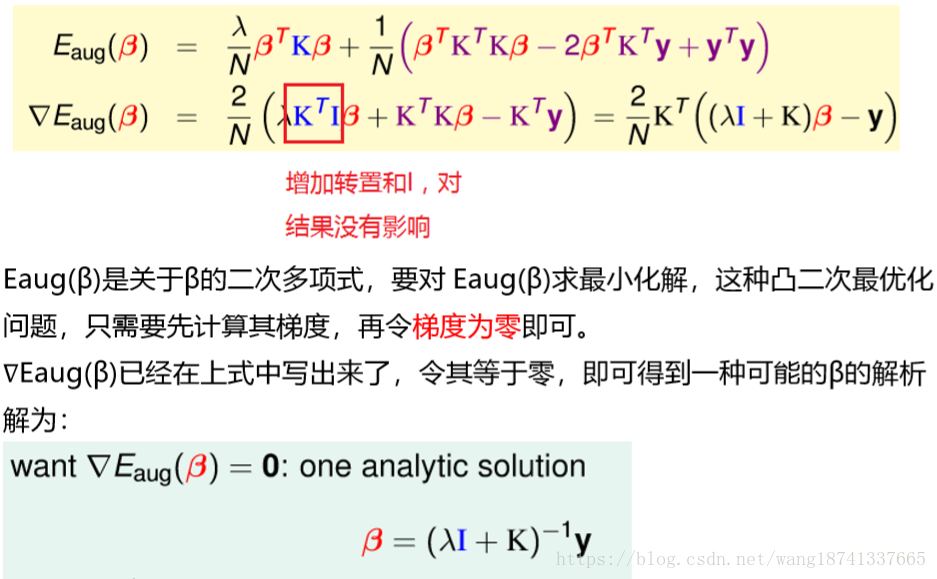

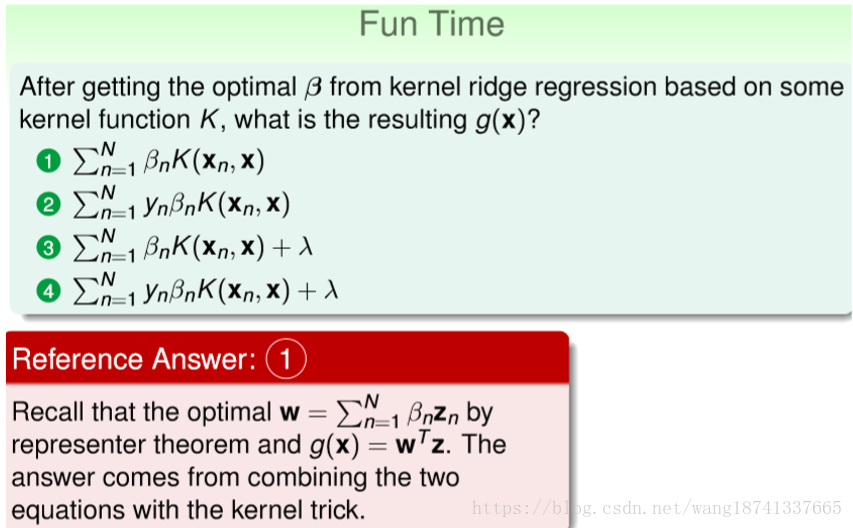

求解βn的问题可以写成如下形式(通过使得梯度等于零来实现):

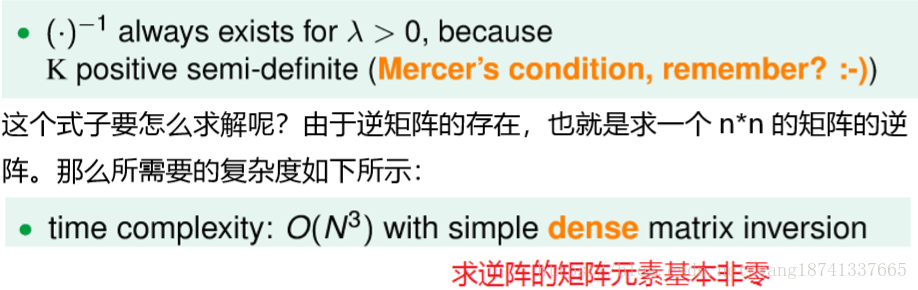

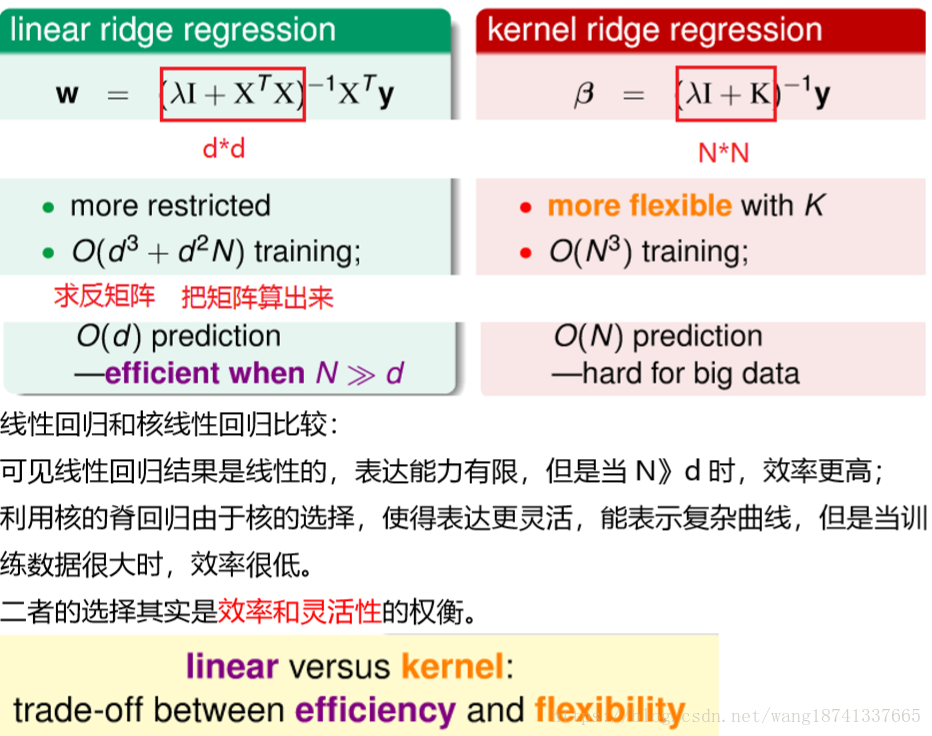

这里需要关心的问题是(λI+K)的逆矩阵是否存在? 答案是肯定的。因为我们之前介绍过,核函数K满足Mercer’s condition, 它是半正定的,因此在λ>0的时候,所以(λI+K)一定是可逆的。

4、

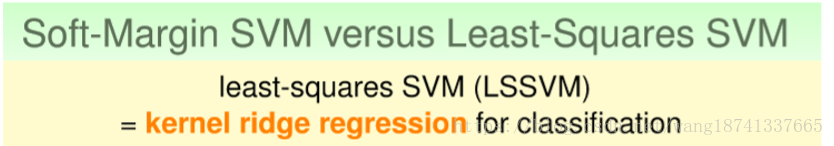

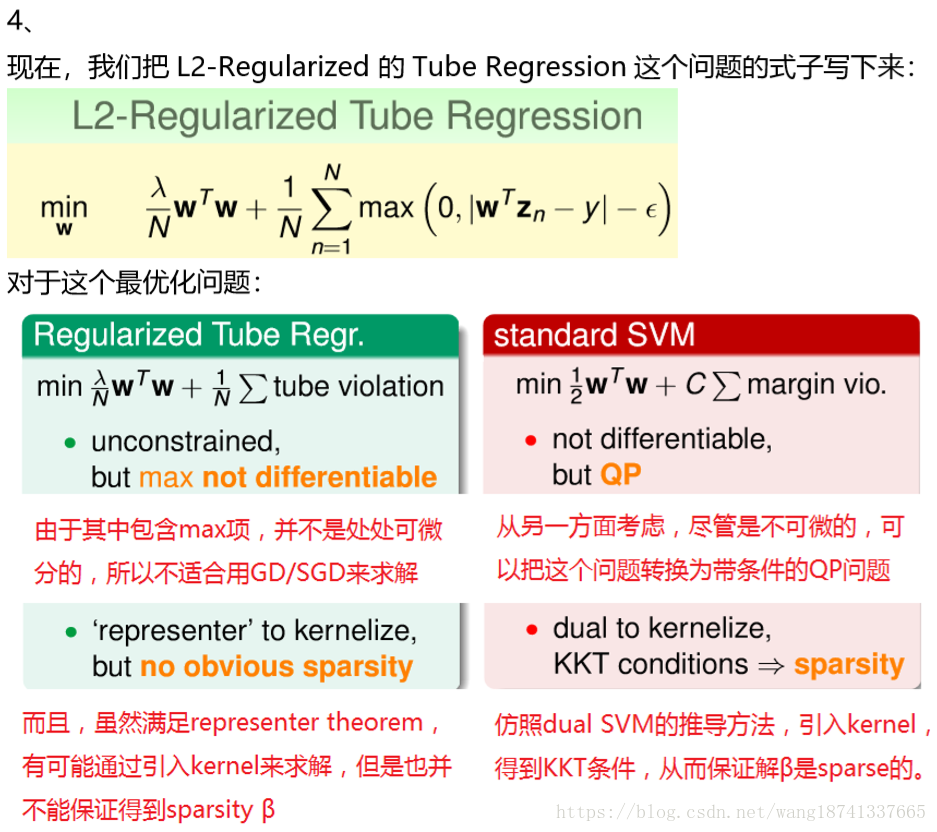

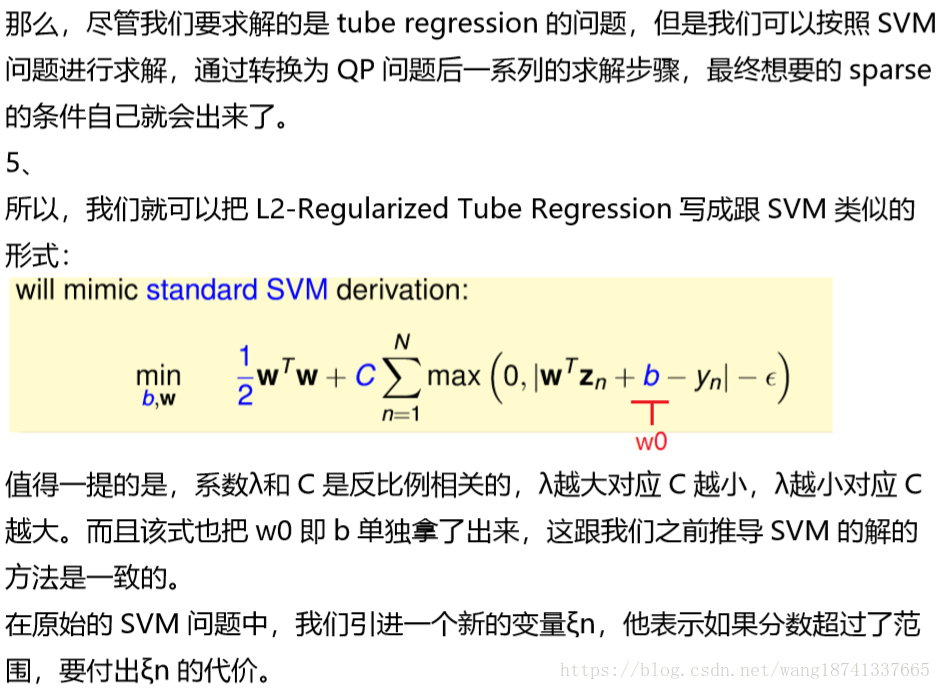

6-2 Support Vector Regression Primal

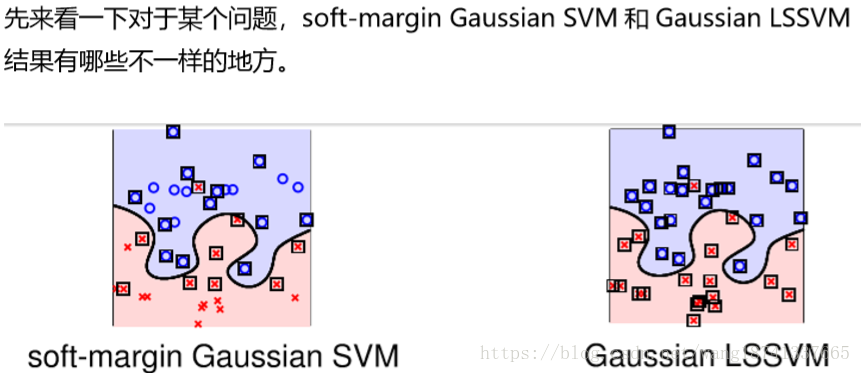

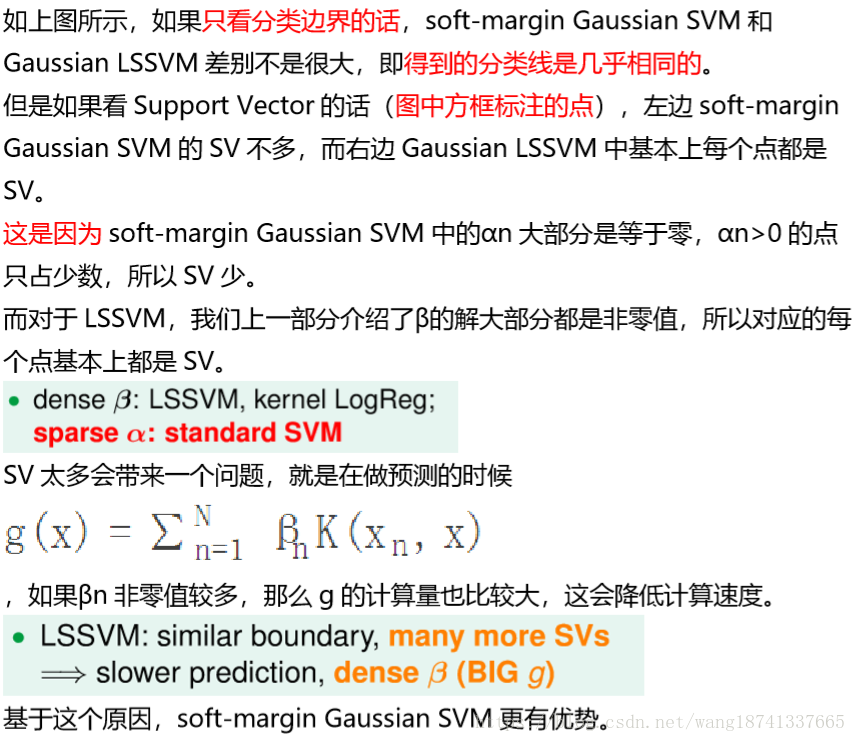

1、 我们在机器学习基石课程中介绍过linear regression可以用来做 classification,那么上一部分介绍的kernel ridge regression同样可以来做 classification。我们把kernel ridge regression应用在classification上取个 新的名字,叫做least-squares SVM(LSSVM)。

6-3 Support Vector Regression Dual

现在我们已经得到了SVR的primal形式,接下来将推导SVR的Dual形式。

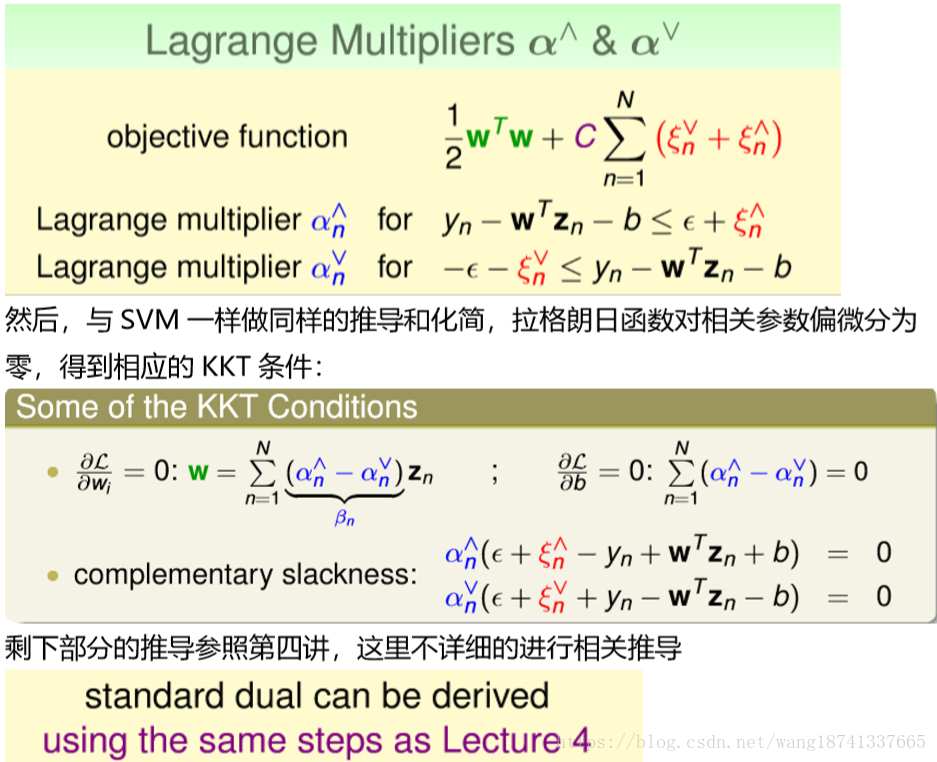

1、 二次规划的对偶问题首先是引入一个拉格朗日乘子,将约束问题转换为无约束 问题。对于该模型的约束条件可以分成两部分,所以对于每个样本点引入两个 因子。 令拉格朗日因子α⋁和α⋀,分别是与ξ⋁n和ξ⋀n不等式相对应。 这里忽略了与ξ⋁n≥0和ξ⋀n≥0对应的拉格朗日因子。

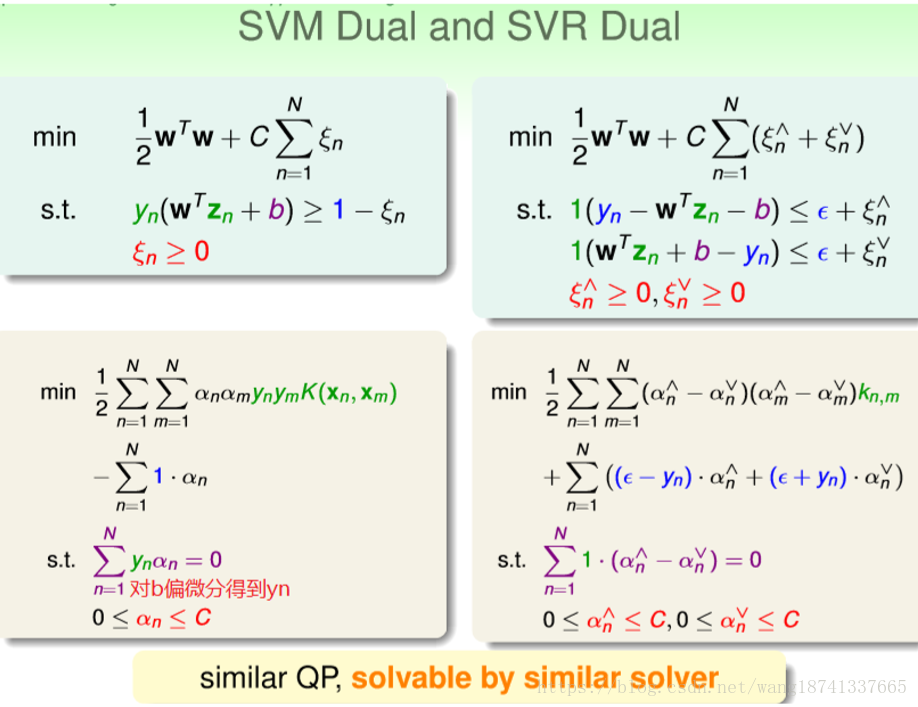

2、 实际上,我们可以通过观察SVM primal与SVM dual的参数对应关系,直接 从SVR primal推导出SVR dual的形式。(而不是进行具体数学推导)

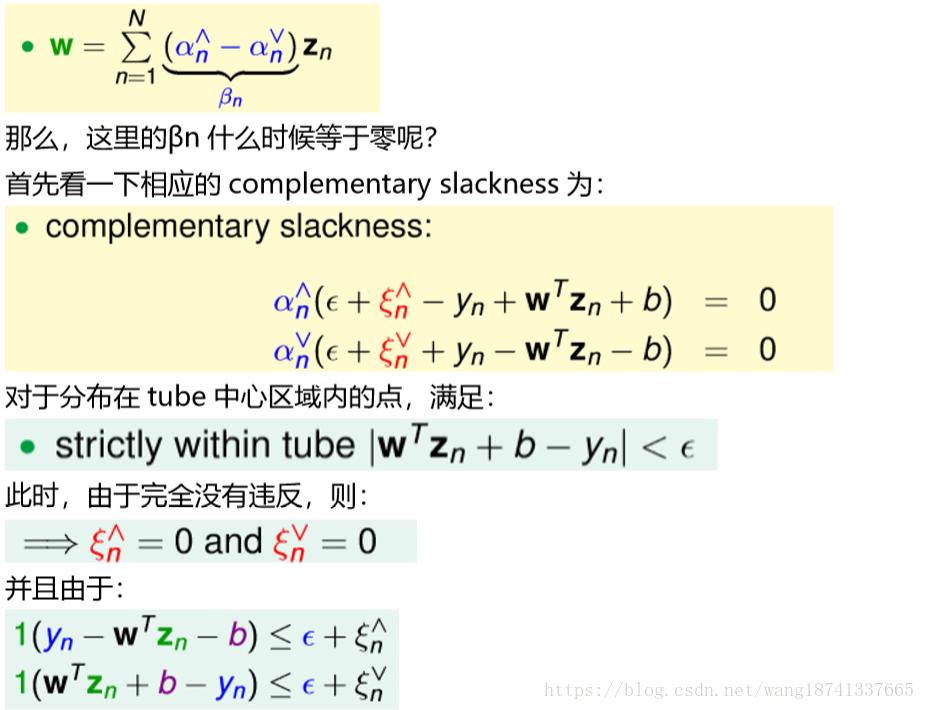

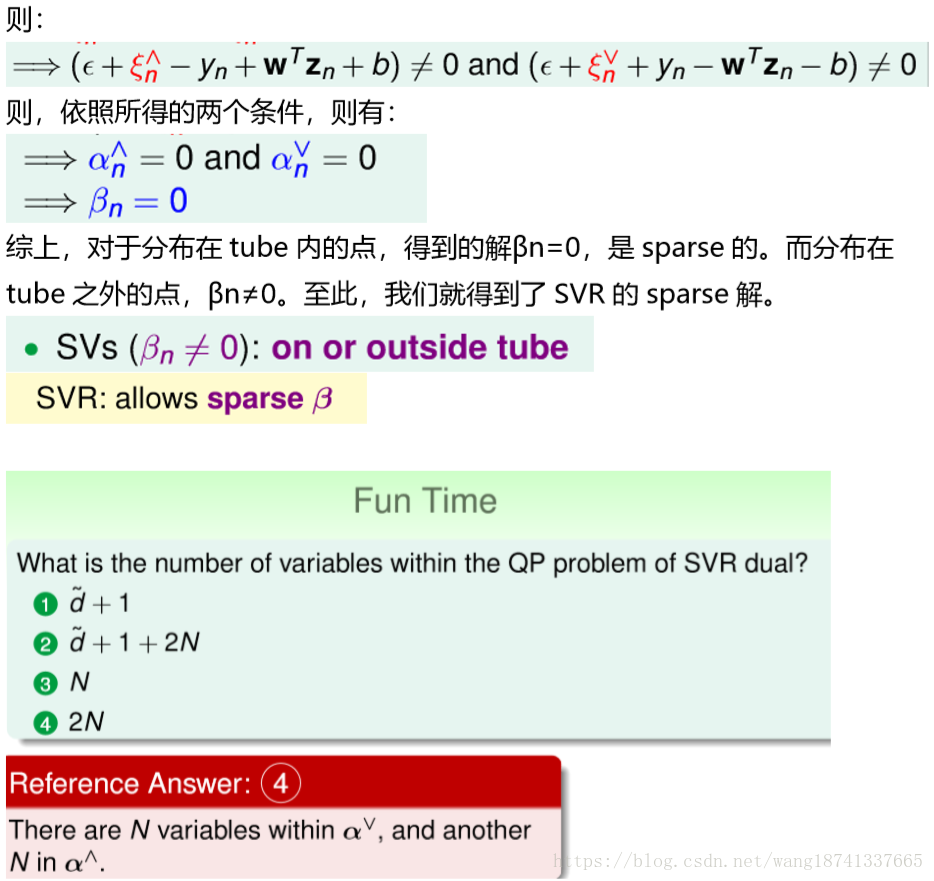

3、 最后,我们就要来讨论一下SVR的解是否真的是sparse的。前面已经推导了 SVR dual形式下推导的解w为:

6-4 Kernel模型的总结

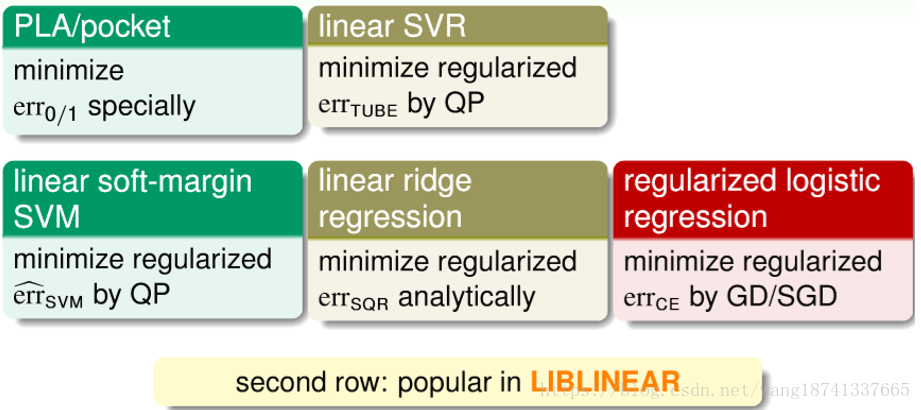

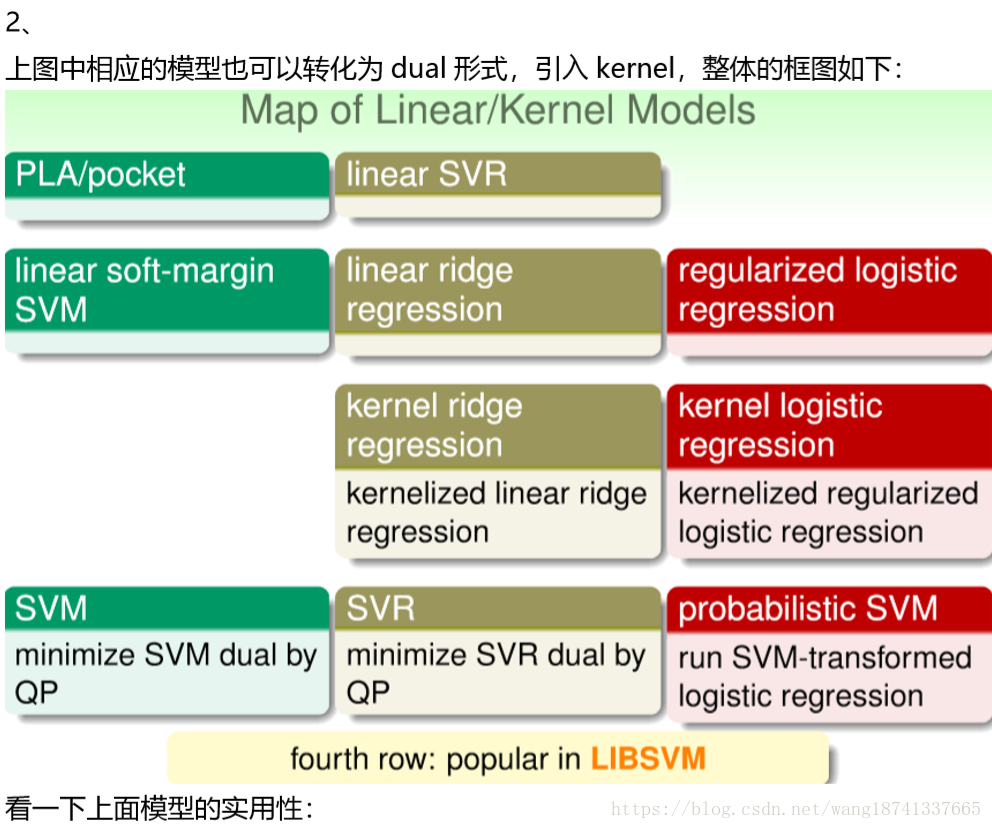

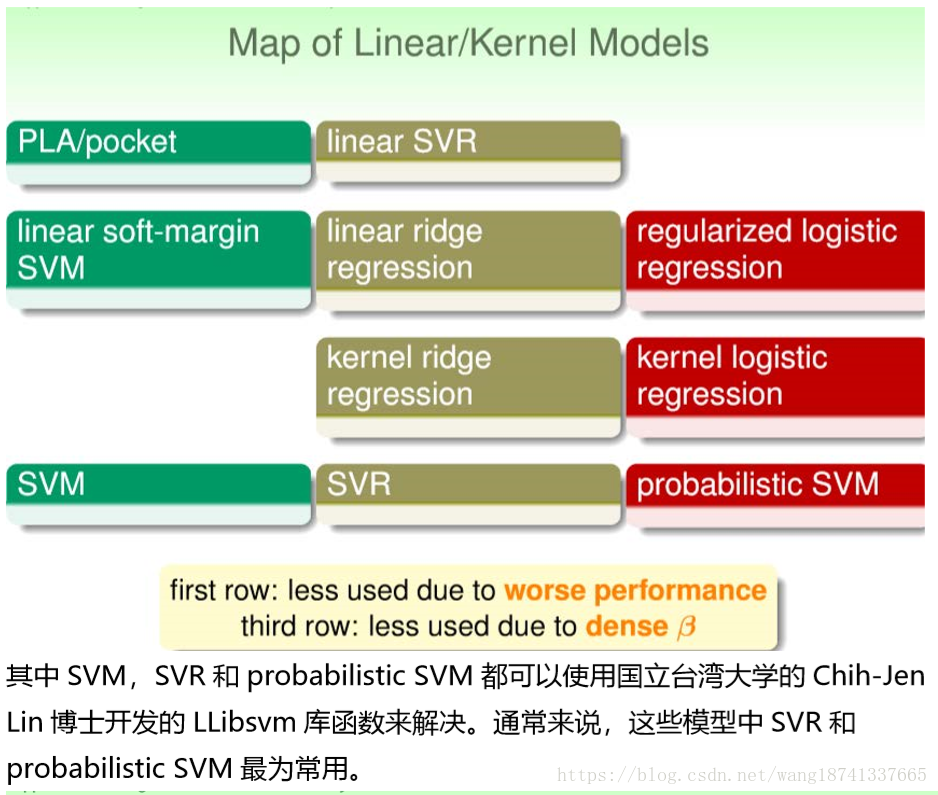

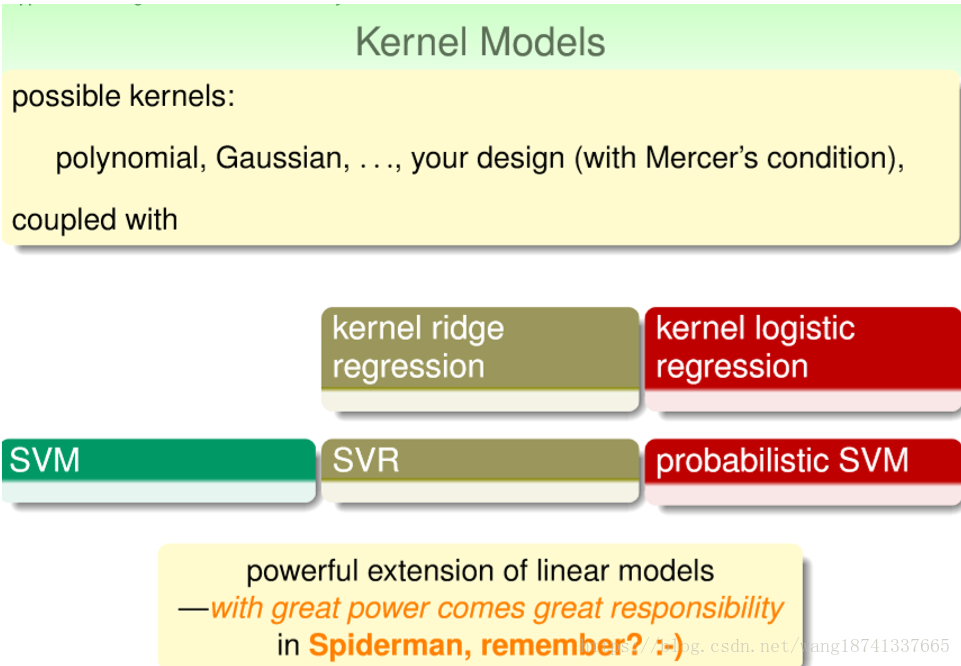

1、 在前面,我们介绍过三种线性模型,分别是PLA/pocket,regularized logistic regression和linear ridge regression。这三种模型都可以使用国立 台湾大学的Chih-Jen Lin博士开发的Liblinear库函数来解决。

另外,我们介绍了linear soft-margin SVM,其中的error function是 err^svm,可以通过标准的QP问题来求解。 linear soft-margin SVM和PLA/pocket一样都是解决同样的问题。

然后,还介绍了linear SVR问题,它与linear ridge regression一样都是解决 同样的问题,从SVM的角度,使用errtube,转换为QP问题进行求解,这也 是我们本节课的主要内容。

总结

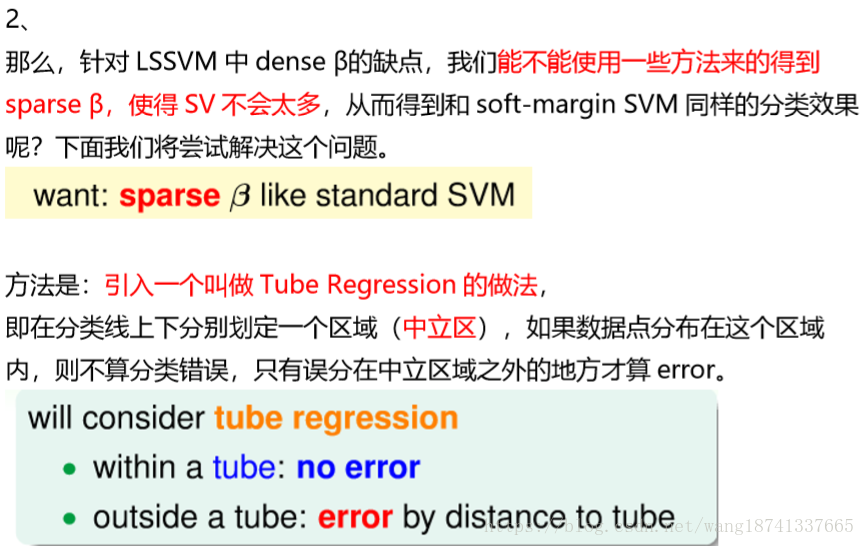

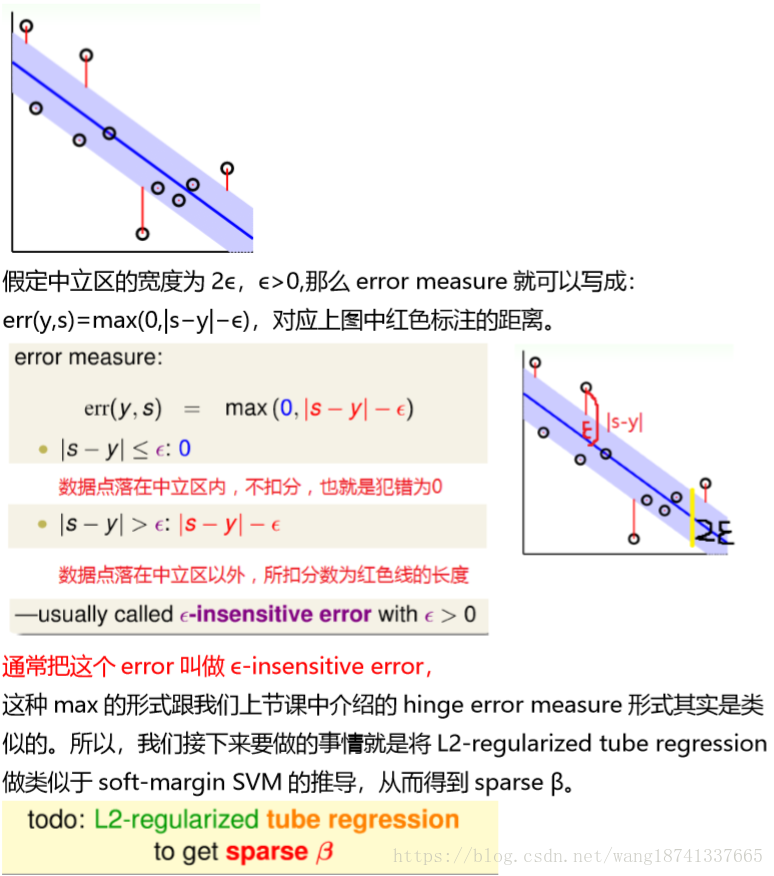

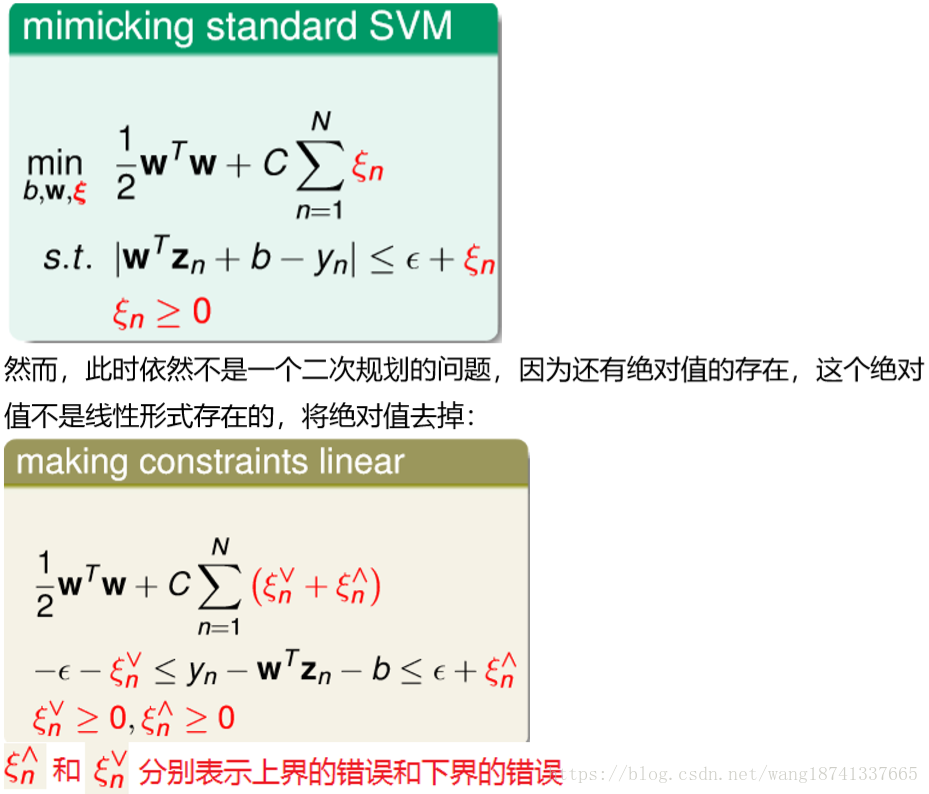

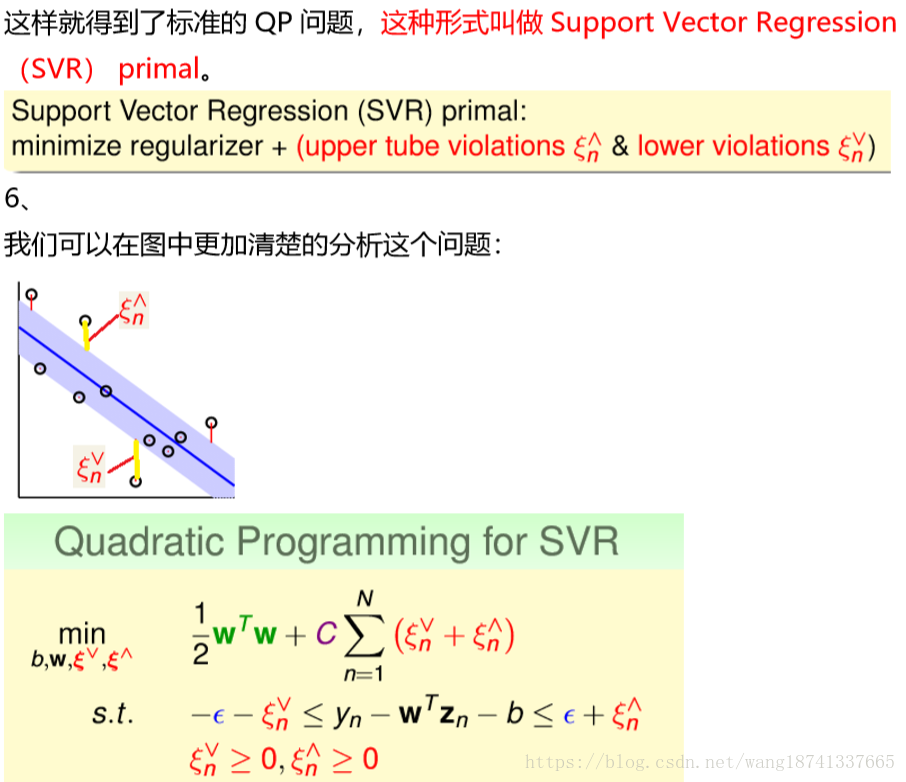

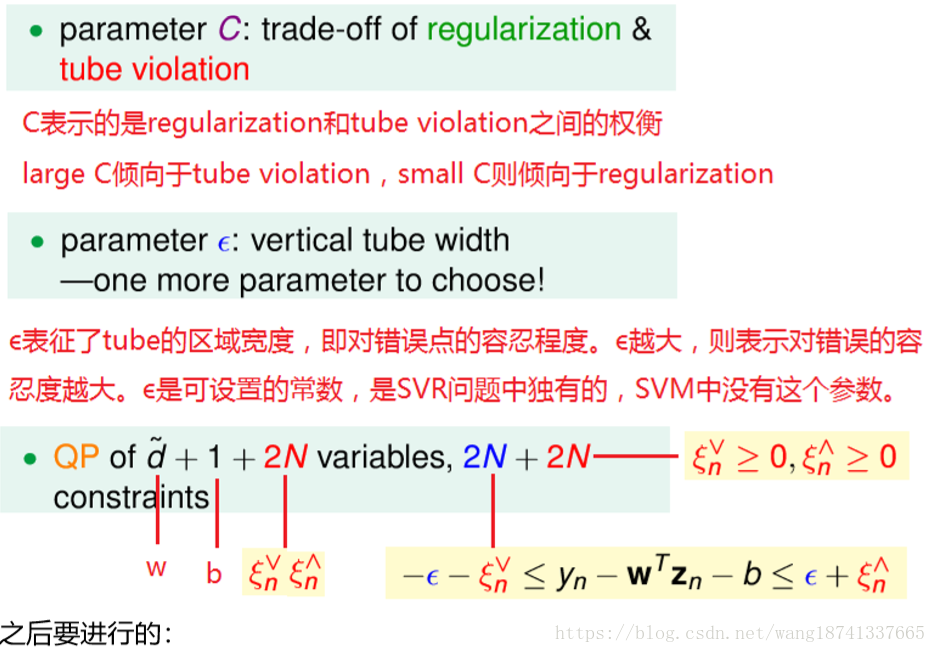

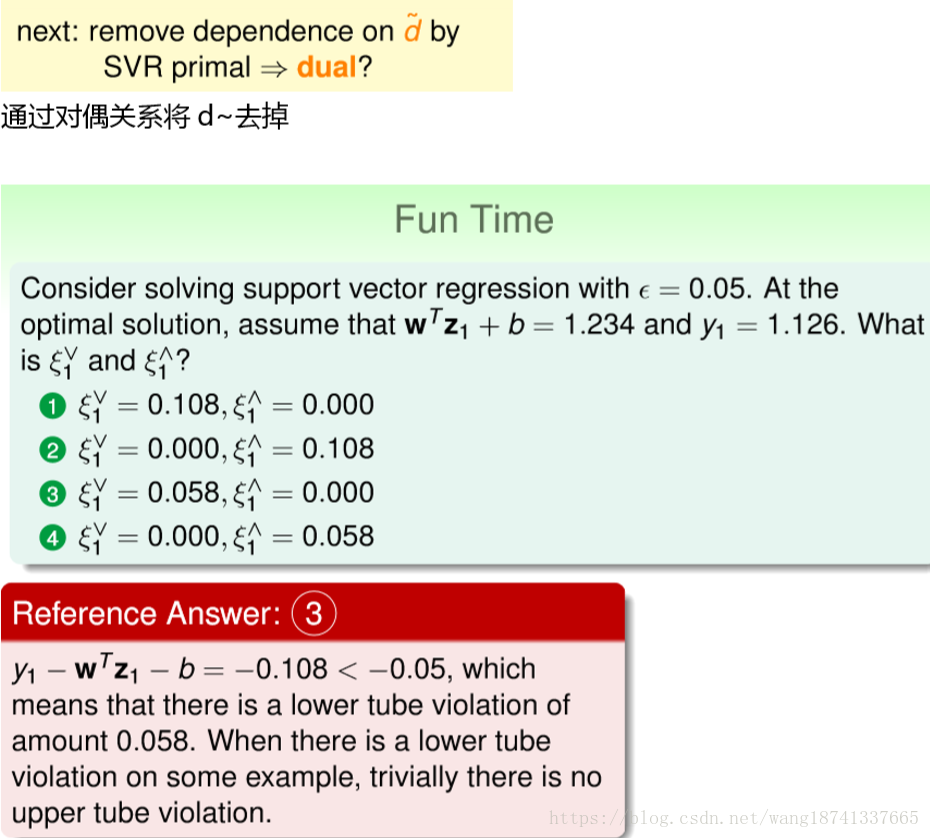

6-1将kernel技巧应用到ridge regression问题上,使得ridge regression的形式更加灵活,6-2将6-1中的ridge regression用于分类,发现其支持向量过多的特点,从而修改其错误函数,引入中立区,最终得到了SVR的原始形式,6-3基于此推导出了SVR的对偶形式