什么是Apache Storm

Apache Storm是一个分布式实时大数据处理系统。Storm设计用于在容错和水平可扩展方法中处理大量数据。它是一个流数据框架,具有最高的摄取率。虽然Storm是无状态的,它通过Apache ZooKeeper管理分布式环境和集群状态。它很简单,您可以并行地对实时数据执行各种操作。

Apache Storm继续成为实时数据分析的领导者。Storm易于设置和操作,并且它保证每个消息将通过拓扑至少处理一次。

storm优点

- 编程简单:开发人员只需要关注应用逻辑,而且跟Hadoop类似,Storm提供的编程原语也很简单

- 高性能,低延迟:可以应用于广告搜索引擎这种要求对广告主的操作进行实时响应的场景。

- 分布式:可以轻松应对数据量大,单机搞不定的场景

- 可扩展: 随着业务发展,数据量和计算量越来越大,系统可水平扩展

- 容错:单个节点挂了不影响应用

- 消息不丢失:保证消息处理

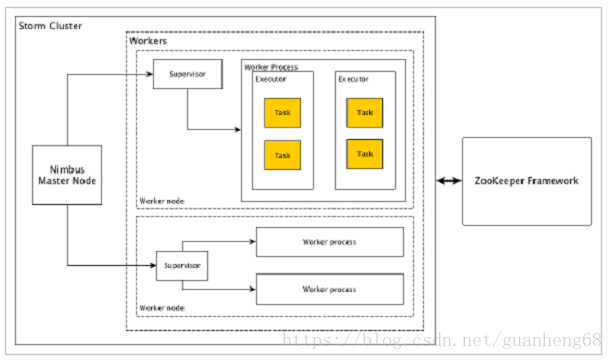

storm集群架构

Nimbus(主节点): Nimbus是Storm集群的主节点。集群中的所有其他节点称为工作节点。主节点负责在所有工作节点之间分发数据,向工作节点分配任务和监视故障。

Supervisor(工作节点): 遵循指令的节点被称为Supervisors。Supervisor有多个工作进程,它管理工作进程以完成由nimbus分配的任务。

Worker process(工作进程): 工作进程将执行与特定拓扑相关的任务。工作进程不会自己运行任务,而是创建执行器并要求他们执行特定的任务。工作进程将有多个执行器。

Executor(执行者): 执行器只是工作进程产生的单个线程。执行器运行一个或多个任务,但仅用于特定的spout或bolt。

Task(任务): 任务执行实际的数据处理。所以,它是一个spout或bolt。

ZooKeeper framework(ZooKeeper框架): Apache的ZooKeeper的是使用群集(节点组)自己和维护具有强大的同步技术共享数据之间进行协调的服务。Nimbus是无状态的,所以它依赖于ZooKeeper来监视工作节点的状态。

ZooKeeper的帮助supervisor与nimbus交互。它负责维持nimbus,supervisor的状态。

Storm虽然不是完全无状态的。它将其状态存储在Apache ZooKeeper中。由于状态在Apache ZooKeeper中可用,故障的网络可以重新启动,并从它离开的地方工作。通常,像monit这样的服务监视工具将监视Nimbus,并在出现任何故障时重新启动它。

storm基础说明

可以简单的理解为storm是把一个任务(Topology)分成多个小单元处理,每个小单元(bolts)可以设置一个或多个线程.

TopologyBuilder: 创建拓扑(打包实时处理逻辑)

- setSpout(String id, IRichSpout spout, Number parallelism_hint)

https://tieba.baidu.com/p/5820023394

- setBolt(String id, IRichBolt bolt, Number parallelism_hint).shuffleGrouping()

- createTopology()

https://tieba.baidu.com/p/5820022187

parallelism_hint: 线程个数

shuffleGrouping: 随机分组(分组模式)

Spout: 实现一个IRichSpout接口

- open() 初始化你的数据源.

- nextTuple() 通过收集器发出生成的数据。

- close() spout关闭

- declareOutputFields() 声明元组输出模式.(即输出数据类型)

- ack() 确认处理

- fail() 不处理或不重新处理

Bolt: 实现IRichBolt接口

- prepare() 执行器将运行此方法来初始化spout。

- execute() 处理单个元组(数据)

- cleanup() spout关闭时使用

- declareOutputFields() 声明元组输出模式.(即输出数据类型)

storm简单代码

Sport:

public class FakeCallLogReaderSpout implements IRichSpout {

//Create instance for SpoutOutputCollector which passes tuples to bolt.

private SpoutOutputCollector collector;

private boolean completed = false;

//Create instance for TopologyContext which contains topology data.

private TopologyContext context;

//Create instance for Random class.

private Random randomGenerator = new Random();

private Integer idx = 0;

@Override

public void open(Map conf, TopologyContext context, SpoutOutputCollector collector) {

this.context = context;

this.collector = collector;

}

@Override

public void nextTuple() {

if(this.idx <= 1000) {

List<String> mobileNumbers = new ArrayList<String>();

mobileNumbers.add("1234123401");

mobileNumbers.add("1234123402");

mobileNumbers.add("1234123403");

mobileNumbers.add("1234123404");

Integer localIdx = 0;

while(localIdx++ < 100 && this.idx++ < 1000) {

String fromMobileNumber = mobileNumbers.get(randomGenerator.nextInt(4));

String toMobileNumber = mobileNumbers.get(randomGenerator.nextInt(4));

while(fromMobileNumber == toMobileNumber) {

toMobileNumber = mobileNumbers.get(randomGenerator.nextInt(4));

}

Integer duration = randomGenerator.nextInt(60);

this.collector.emit(new Values(fromMobileNumber, toMobileNumber, duration));

}

}

}

@Override

public void declareOutputFields(OutputFieldsDeclarer declarer) {

declarer.declare(new Fields("from", "to", "duration"));

}

//Override all the interface methods

@Override

public void close() {}

public boolean isDistributed() {

return false;

}

@Override

public void activate() {}

@Override

public void deactivate() {}

@Override

public void ack(Object msgId) {}

@Override

public void fail(Object msgId) {}

@Override

public Map<String, Object> getComponentConfiguration() {

return null;

}

}- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

CallLogCreatorBolt

public class CallLogCreatorBolt implements IRichBolt {

//Create instance for OutputCollector which collects and emits tuples to produce output

private OutputCollector collector;

@Override

public void prepare(Map conf, TopologyContext context, OutputCollector collector) {

this.collector = collector;

}

@Override

public void execute(Tuple tuple) {

String from = tuple.getString(0);

String to = tuple.getString(1);

Integer duration = tuple.getInteger(2);

collector.emit(new Values(from + " - " + to, duration));

}

@Override

public void cleanup() {}

@Override

public void declareOutputFields(OutputFieldsDeclarer declarer) {

declarer.declare(new Fields("call", "duration"));

}

@Override

public Map<String, Object> getComponentConfiguration() {

return null;

}

}- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

TopologyBuilder

TopologyBuilder builder = new TopologyBuilder();

builder.setSpout("call-log-reader-spout", new FakeCallLogReaderSpout());

builder.setBolt("call-log-creator-bolt", new CallLogCreatorBolt(),1)

.shuffleGrouping("call-log-reader-spout");

builder.createTopology()