一、storm的基本原理:

1、离线计算是什么?

离线计算:批量获取数据、批量传输数据、周期性批量计算数据、数据展示

代表技术:Sqoop批量导入数据、HDFS批量存储数据、MapReduce批量计算数据、Hive批量计算数据、***任务调度

1,hivesql:工作中的重中之重;

2、调度平台

3、Hadoop集群运维

4、数据清洗(脚本语言)

5、元数据管理

6、数据稽查:看数据中有没有垃圾数据,对数据量比较;

7、数据仓库模型架构

2、流式计算是什么

流式计算:数据实时产生、数据实时传输、数据实时计算、实时展示;

代表技术:Flume实时获取数据、Kafka/metaq实时数据存储、Storm/JStorm实时数据计算、Redis实时结果缓存、持久化存储(mysql)。

一句话总结:将源源不断产生的数据实时收集并实时计算,尽可能快的得到计算结果;

3、离线计算与实时计算的区别

最大的区别:实时收集、实时计算、实时展示

4、Storm是什么?

Flume实时采集,低延迟

Kafka消息队列,低延迟

Storm实时计算,低延迟

Redis实时存储,低延迟

Storm用来实时处理数据,特点:低延迟、高可用、分布式、可扩展、数据不丢失。提供简单容易理解的接口,便于开发。

海量数据?数据类型很多,产生数据的终端很多,处理数据能力增强

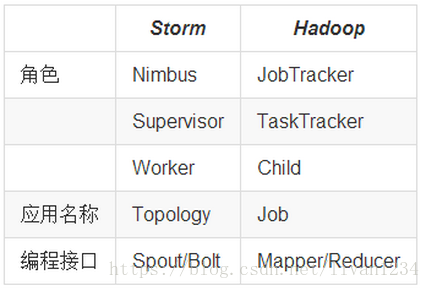

5、Storm与Hadoop的区别

- Storm用于实时计算,Hadoop用于离线计算。

- Storm处理的数据保存在内存中,源源不断;Hadoop处理的数据保存在文件系统中,一批一批。

- Storm的数据通过网络传输进来;Hadoop的数据保存在磁盘中。

- Storm与Hadoop的编程模型相似

Job:任务名称

JobTracker:项目经理

TaskTracker:开发组长、产品经理

Child:负责开发的人员

Mapper/Reduce:开发人员中的两种角色,一种是服务器开发、一种是客户端开发

Topology:任务名称

Nimbus:项目经理

Supervisor:开组长、产品经理

Worker:开人员

Spout/Bolt:开人员中的两种角色,一种是服务器开发、一种是客户端开发;

6、Storm应用场景及行业案例

Storm用来实时计算源源不断产生的数据,如同流水线生产。

6.1、运用场景

1)日志分析

从海量日志中分析出特定的数据,并将分析的结果存入外部存储器用来辅佐决策。

2)管道系统

将一个数据从一个系统传输到另外一个系统,比如将数据库同步到Hadoop

3)消息转化器

将接受到的消息按照某种格式进行转化,存储到另外一个系统如消息中间件

6.2、典型案列

1)一淘-实时分析系统:实时分析用户的属性,并反馈给搜索引擎

最初,用户属性分析是通过每天在云梯上定时运行的MR job来完成的。为了满足实时性的要求,希望能够实时分析用户的行为日志,将最新的用户属性反馈给搜索引擎,能够为用户展现最贴近其当前需求的结果。

2)携程-网站性能监控:实时分析系统监控携程网的网站性能

利用HTML5提供的performance标准获得可用的指标,并记录日志。Storm集群实时分析日志和入库。使用DRPC聚合成报表,通过历史数据对比等判断规则,触发预警事件。

3)阿里妈妈-用户画像:实时计算用户的兴趣数据

为了更加精准投放广告,阿里妈妈后台计算引擎需要维护每个用户的兴趣点(理想状态是,你对什么感兴趣,就向你投放哪类广告)。用户兴趣主要基于用户的历史行为、用户的实时查询、用户的实时点击、用户的地理信息而得,其中实时查询、实时点击等用户行为都是实时数据。考虑到系统的实时性,阿里妈妈使用Storm维护用户兴趣数据,并在此基础上进行受众定向的广告投放。

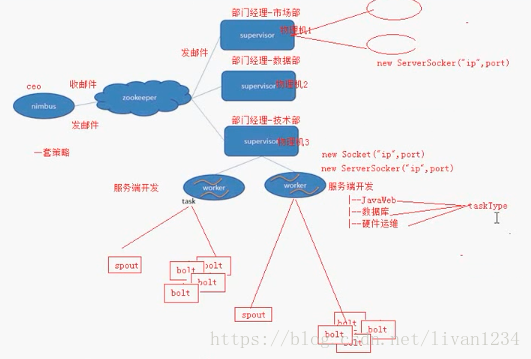

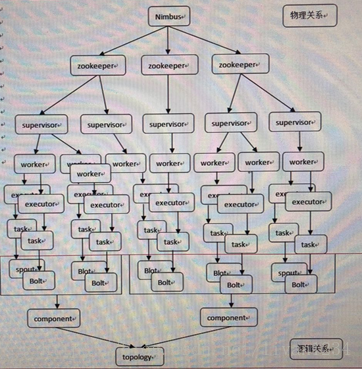

7、Storm核心组件(重要)

- Nimbus:负责资源分配和任务调度,分配完成后,将其通过zk分配给supervisor,zk记录分配的任务信息和心跳信息。

- Supervisor:负责接受nimbus分配的任务,启动和停止属于自己管理的worker进程,是当前物理机上的管理者,worker的数量是根据端口号来的。---通过配置文件设置当前supervisor上启动多少个worker。

- Worker:运行具体处理组件逻辑的进程。Worker运行的任务类型只有两种,一种是Spout任务,一种是Bolt任务,一个worker中有多个这种任务,。

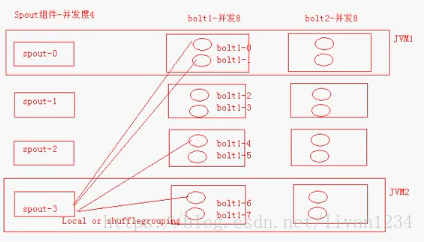

- Task:worker中每一个spout/bolt的线程称为一个task. 每个task属于某个组件并发度中的一个,在storm0.8之后,task不再与物理线程对应,不同spout/bolt的task可能会共享一个物理线程,该线程称为executor。

并发度:一种类型的任务,被几个线程同时执行,并发度的数量等于线程的数量一个任务的多个线程会被运行在多个worker上,有一种类似于平均算法的负载均衡策略,尽可能减少网络请求IO,与hadoop中的Map Reduce类似(尽可能运行在数据所在的物理节点上);

一个worker可以看作是一个JVM,如上图,一个jvm中可以执行五个task任务,即五个线程,每个jvm与外部通讯需要的是socket,联系其他的jvm。

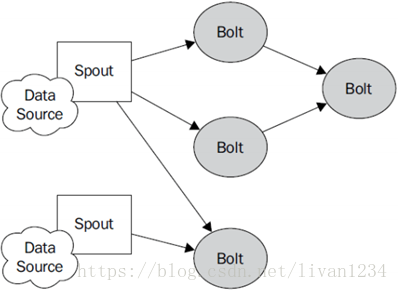

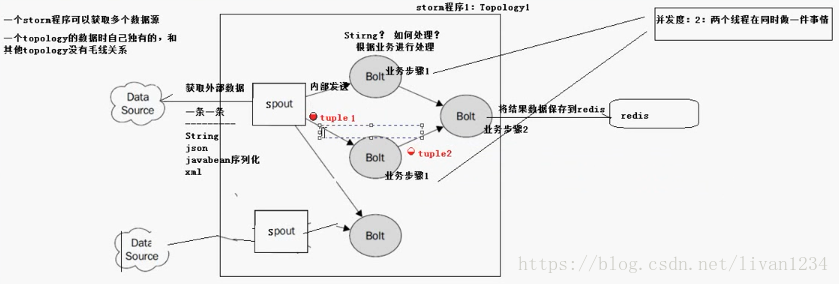

8、Storm编程模型(重要)

- Topology:Storm中运行的一个实时应用程序的名称。(拓扑)

- Spout:在一个topology中获取源数据流的组件。

通常情况下spout会从外部数据源中读取数据,然后转换为topology内部的源数据。

- Bolt:接受数据然后执行处理的组件,用户可以在其中执行自己想要的操作。

- Tuple:一次消息传递的基本单元,理解为一组消息就是一个Tuple。

- Stream:表示数据的流向。

一个worker只属于一个topology。

一个topology要求的worker数量如果不被满足,集群在任务分配时,根据现有的worker先运行topology,如果当前集中worker数量为0,那么最新提交的topology将只会被标识为active,但是不分配worker,不运行,只有当有了空闲资源,才会被运行。

以案例的形式描述:

冰山融化,形成小水滴,由spout进行收集,然后在Bolt中融入新的物质,最终形成需要的液体。

- 外部数据源data source中存在大量数据,由spout获取外部收据,这些数据(一条一条)可以是string,可以是json,也可以是javabean等格式;

- Spout会将收集的数据内部发送到blot中,在blot中根据业务逻辑处理相应的数据,多个blot可以是平行的(此即为并发度),也可以是串联的;

- 最后的blot会将数据传输给数据库redis。

上面的步骤为topology,即storm的一个单元;

一个topology的数据是独有的,与其他topology是没有关系的,但是多个topology可以同时使用一个数据源。

Spout传输的一个数据单元即为一个tuple,tuple是一个java对象,里面封装了一个list;

程序的流动方向是StreamGrouping,即数据流分区,类似于hadoop中的hash散列,分组方式有多种,比如:随机分组(shuffle Grouping,用的是随机函数)、按字段分组(Field Grouping,用的是hash散列)、不分组等七种方式,具体可见后面的stream Grouping详解:

对于blot的并发处理:

每个blot中的并发都对应一个线程:

比如:

1)blot1-0是一个线程

2)blot1-1是一个线程

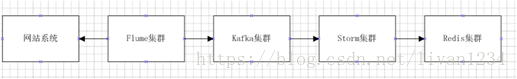

9、流式计算一般架构图(重要)

- 其中flume用来获取数据。

- Kafka用来临时保存数据。

- Strom用来计算数据。

- Redis是个内存数据库,用来保存数据。

二、集群部署的基本流程:

1、流程概述:

集群部署的流程:下载安装包、解压安装包、修改配置文件、分发安装包、启动集群。

2、Storm集群部署

2.1、下载安装包

也可以直接在官网上下载tar.gz的安装包,然后将其上传到对应的服务器上。

2.2、解压安装包

解压安装文件到制定的目录,并把storm加入到环境变量

sudo tar -zxvf apache-storm-0.9.6.tar.gz

sudo mv apache-storm-0.9.6 storm

sudo vi /etc/profile

Source /etc/profile

2.3、修改配置文件

vim /usr/apps/storm/storm/conf/storm.yaml

输入以下内容:

2.4、分发安装包

scp -pr storm root@hdp-node-2:/usr/apps/

scp -pr storm root@hdp-node-3:/usr/apps/

2.5、启动集群

Hdp-node-1节点启动nimbus和storm ui:

[root@ Hdp-node-1~]# nohup storm ui >/dev/null 2>&1 &

[root@ Hdp-node-1~]# nohup storm nimbus >/dev/null 2>&1 &

Hdp-node-2和Hdp-node-3主机启动Supervisor节点:

[root@ Hdp-node-2~]# nohup storm supervisor >/dev/null 2>&1 &

[root@ Hdp-node-3~]# nohup storm supervisor >/dev/null 2>&1 &

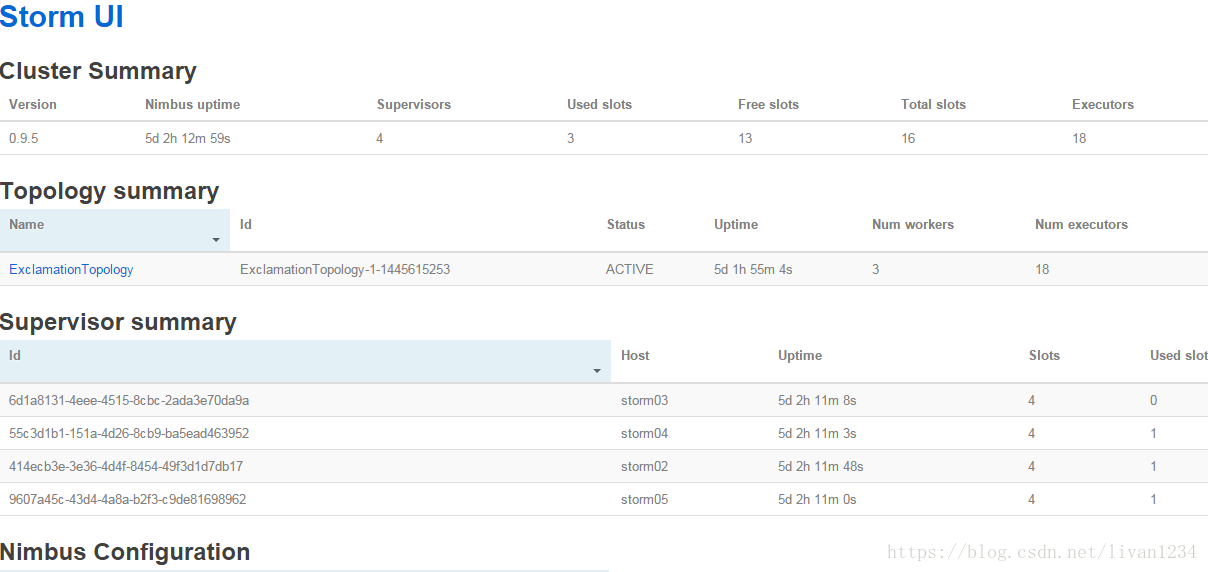

3、查看集群

访问nimbus.host:/8080,即可看到storm的ui界面。

4、Storm常用操作命令

有许多简单且有用的命令可以用来管理拓扑,它们可以提交、杀死、禁用、再平衡拓扑。

1)提交任务命令格式:storm jar 【jar路径】 【拓扑包名.拓扑类名】 【拓扑名称】

bin/storm jar examples/storm-starter/storm-starter-topologies-0.9.6.jar storm.starter.WordCountTopology(驱动类) wordcount

2)杀死任务命令格式:storm kill 【拓扑名称】 -w 10(执行kill命令时可以通过-w [等待秒数]指定拓扑停用以后的等待时间)

storm kill topology-name -w 10

3)停用任务命令格式:storm deactivte 【拓扑名称】

storm deactivte topology-name

我们能够挂起或停用运行中的拓扑。当停用拓扑时,所有已分发的元组都会得到处理,但是spouts的nextTuple方法不会被调用。销毁一个拓扑,可以使用kill命令。它会以一种安全的方式销毁一个拓扑,首先停用拓扑,在等待拓扑消息的时间段内允许拓扑完成当前的数据流。

1)启用任务命令格式:storm activate【拓扑名称】

storm activate topology-name

2)重新部署任务命令格式:storm rebalance 【拓扑名称】

storm rebalance topology-name

再平衡使你重分配集群任务。这是个很强大的命令。比如,你向一个运行中的集群增加了节点。再平衡命令将会停用拓扑,然后在相应超时时间之后重分配工人,并重启拓扑。

5、Storm集群的进程及日志熟悉

5.1、部署成功之后,启动storm集群。

依次启动集群的各种角色

5.2、查看nimbus的日志信息

在nimbus的服务器(hdp-node-1)上:

cd /usr/apps/storm/storm/logs

tail -100f /usr/apps/storm/storm/logs/nimbus.log

5.3、查看ui运行日志信息

在ui的服务器上,一般和nimbus一个服务器:

cd /usr/apps/storm/storm/logs

tail -100f /usr/apps/storm/storm/logs/ui.log

5.4、查看supervisor运行日志信息

在supervisor服务上

cd /usr/apps/storm/storm/logs

tail -100f /usr/apps/storm/storm/logs/supervisor.log

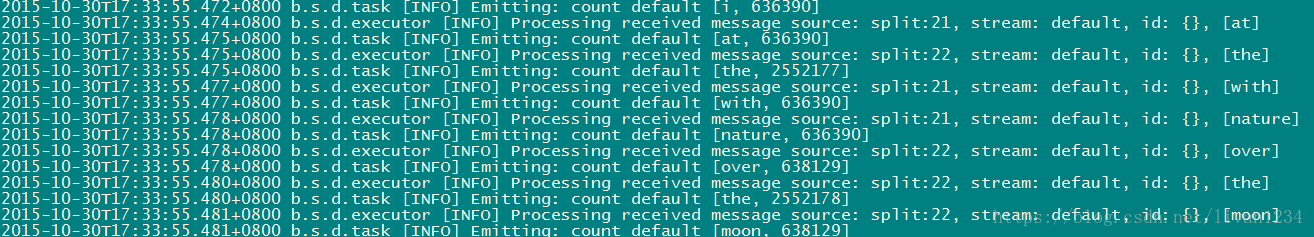

5.5、查看supervisor上worker运行日志信息

在supervisor服务上

cd /usr/apps/storm/storm/logs

tail -100f /usr/apps/storm/storm/logs/worker-6702.log

(该worker正在运行wordcount程序)