概述

这篇论文主要基于closed form matting和KNN matting两种方法,利用CNN,以两种方法输出和RGB图像一起作为神经网络的输入,从而达到融合局部和非局部方法。论文声称是第一次将深度学习用于自然图像抠图。

Motivation

论文的动机主要来源于local methods的closed form matting和unlocal methods的KNN matting。文中较大篇幅在分析两种方法,这里也借此机会学习一下有代表性的传统方法。

closed form matting

封闭式表面抠图假定局部颜色分布遵循color line model,其中局部窗口内的颜色可以表示为两种颜色的线性组合。基于这个假设,Levin导出了matting Laplacian,证明了前景的alpha matte可以在没有明确估计前景和背景颜色的情况下以封闭的形式求解。从那以后,matting Laplacian被广泛地用作正则化来增强估计的alpha matte和其他应用的平滑性。该方法的优点是参数少,多数图像满足color line model的假设;不足就是假设失效的情况也是比较多的。

KNN matting

KNN抠图属于非局部抠图,其目标是通过允许alpha值在非局部像素中传播来解决matting Laplacian的局限性。类似于closed form matting,非局部抠图也对采样的非局部像素进行了假设。它假定像素的alpha值可以通过具有相似外观的非局部像素的alpha值的加权和来描述。在非局部抠图中,相似的外观由颜色,距离和纹理相似性来定义。然而,由于非局部像素的比较,其计算非常高。KNN matting通过仅考虑高维特征空间中的前K个近邻而改善了非局部抠图。它通过仅考虑颜色和它们特征空间中的位置相似性来减少计算。优点也是参数少,易于调整;不足是定义一个通用的特征空间是困难的。

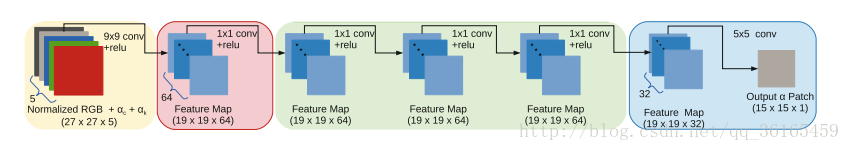

网络结构

网络的输入是归一化的RGB图像,以及由closed form matting得到的alpha matte和由KNN matting得到的alpha matte,做归一化的目的是为了减少输入信号的幅度变换,因为幅度变化在初始化的alpha值中能够更好地捕获。

根据卷积核的大小可以将网络结构分成三个阶段。

第一阶段输入是5通道,使用64个9*9的卷积核,得到64个响应图,作用是进行结构分析,得到的相应图包含了不同的局部图像结构;

第二阶段是4个1*1的卷积层,进行remapping,小的卷积核效果更好;

第三阶段使用5*5的卷积核进行重构。

损失函数是欧几里得损失函数。其实纵观整个CNN网络,还是比较小的网络。

论文最大的亮点是对比各种输入,发现使用RGB+closed form matting+KNN matting作为输入效果最好。既然是首度使用深度学习进行抠图,可以达到抛砖引玉的作用吧。

训练

训练的一些其他细节不再赘述,这里注意到其考虑到了数据平衡的问题,这也是ICCV 2017报告中谈到的问题,数据均衡能够防止过拟合。论文中根据具有非零alpha值以及非零alpha梯度的像素的数量来对训练patches进行聚类。如果一个patch有许多带有非零alpha值的像素,但是有几个像素具有非零的alpha梯度,该patch可以被认为是sharp boundary patch。反之,如果一个patch有一些非零alpha值的像素,但有许多非零alpha梯度的像素,该patch可以被认为是一个长头发的patch。根据这一分析,将训练patch分为20组。在准备训练数据时,为了避免过拟合,将每个组的样本数量做平均。

最后放张效果图吧