y = ax+b+ ε

y1 = ax+b

其中y为样本实际值,y1为预测值。

线性回归、岭回归(Ridge)与Lasso回归拟合出来为y=ax+b.

区别:损失函数:线性回归为误差平方和,岭回归为误差平方和加L2正则项(可以使得每个系数都相对更小从而减少过拟合),Lasso回归为误差平方和加L1正则项(可以通过使很多系数为0来减少生效的变量)。

损失函数最小化方法:梯度下降,最小二乘,牛顿法,拟牛顿法。

Lasso是部分可导,因此可以用坐标轴下降法(分别在每个坐标轴找方向迭代寻优,不需要像梯度下降一样求导)和最小角回归法(找到与y最接近的x1,顺着x1走直到残差在x1和x2角平分线即根据最相关自变量系数开始?)。

logistic回归损失函数为对数似然函数。

FM(Factorization Machine)算法:

在线性回归基础上引入交叉项,考虑特征之间的关系。复杂度为线性,可以在稀疏情况下合理地估计参数。

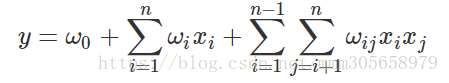

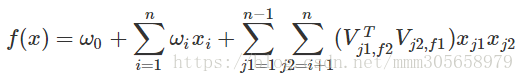

度为2的模型为

需要xi与xj都不为0才可以训练wij,在稀疏情况下很难满足这个条件。因此为每个特征引入个长度为k的辅助向量V,使得Vi乘以VjT等于Wij。也就是为每个特征对应一个隐变量。

FFM则为每个特征对应n个隐变量(由于经过了one hot编码,可以根据实际特征种类来设置n)。

迭代求参时可以设置自适应学习率(随着迭代次数增加减少学习率)。