目录

一、正则项与岭回归、Lasso的关系

(2)正则项在机器学习中普遍存在,在做模型时,往往需要加上正则项。

(3)我们希望θ越小越好(最好等于0,L0正则),如果θ很大,就容易造成模型震荡,结果会不稳定。

(4)所谓的不稳定,就是数据进行很小的变换,模型都会有很大的转变。

加上正则项后,会使得模型曲线更加的平滑(起伏不是很大)。

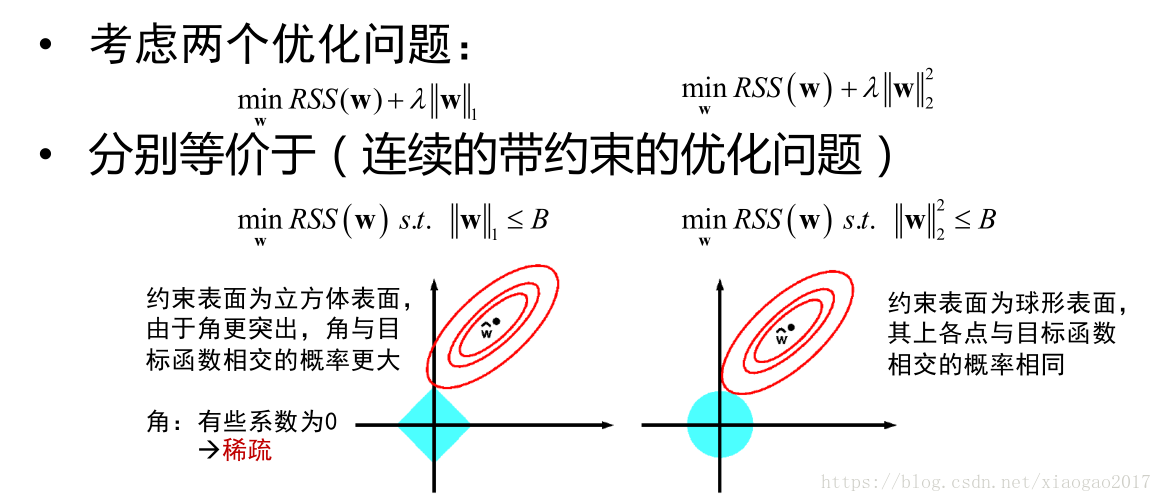

(5)L0正则不是很好的求解,于是用L1正则近似成L0正则(Lasso)。

(6)L1正则优点:可以舍弃一些特征。缺点:正由于可以舍弃一些特征,它的稳定性不如L2,即某个特征一会有,一会没有

(7)L1正则不太好求导,于是又考虑到了L2正则(岭回归)

优点:它的约束项是一个二次曲线,每一点都是连续的,优化更方便,支持他的求解算法更多。

二、怎么理解加上正则项,模型复杂度降低?

(1)正则化对模型参数添加先验(根据经验得到的结论),使得模型复杂度降低,对于噪声以及outliers的输入扰动相对较小。

我们知道,当样本数量很少时,容易造成过拟合。而加入了先验,先验知识可以防止过拟合。

举例:抛硬币,如果只抛5次,每次都是正面,可能会得出一个结论,正面朝上概率为1.这个就是过拟合。如果此时,经验告诉我们,向上的概率只有0.5,于是我们就不会下这么一个糟糕的结论。

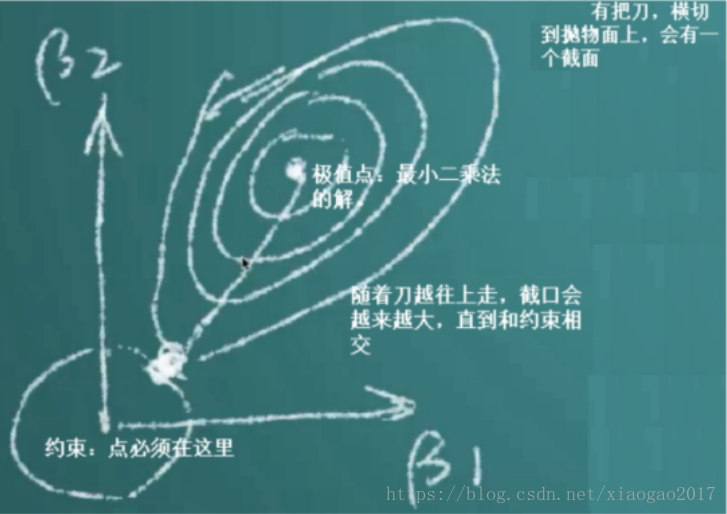

(2)损失函数不断的往外扩张(参数值不断增大),如果不加以限制的话,将会非常的庞大(极不稳定),而正则项,就是加以限制,套索,碰到这个套索就停止扩张。

(3)最小二乘法,加2范数正则 等价 加了高斯分布的先验。加1范数的正则 等价加拉普拉斯分布的先验。

三、岭回归

(1)L2损失+L2正则

(2)怎么求解?

类似OLS求解一样,可以考虑用SVD方式、梯度下降方式求解。

四、Lasso

(1)L2损失+L1正则

(2)怎么求解?

通常用LARS,做点变换,等价Lasso。

有时候也用坐标轴下降法,它的下降速度比较快。在sklearn中用的就是坐标轴下降法。