上一节内容总结了线性回归方法,并在求θ用到了梯度下降方法。这一节将利用梯度下降方法,讨论局部加权线性回归(Locally weighted linear regression)

前提知识补充:

非参数算法:虽然样本容量不断扩充,拟合曲线也会改变。

参数算法:由常数θ决定,不随样本容量不断扩充而改变。例如线性回归过程。

似然函数定义:总的来说步骤就是令误差服从高斯分布后,取对数的结果。具体步骤如下

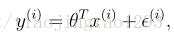

1.假设输出y与输入x存在以下关系

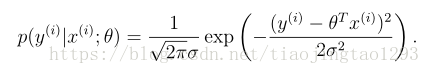

2.规定误差服从高斯分布

3.令L(θ) == p(y|X;θ),似然函数ℓ(θ)就是对p(θ)取对数的结果。(看起来感觉L(θ) == p( y|X;θ)这一步有点多余)

局部加权线性回归

局部加权线性回归是一种参数算法,与线性回归的定义不同,它多了一个加权值。

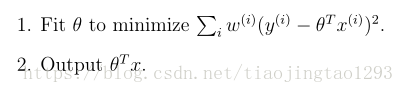

局部加权线性回归定义:

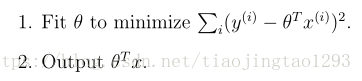

对比线性回归:

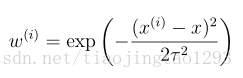

w(i)服从

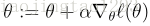

如何求出θ是的拟合最合适呢?

这要应用线性回归当中的梯度下降法。说白了就是求出似然函数之后对θ求导,不断用

看似复杂冗长的算法定义其实不难理解,你get到了吗?