版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/qq_16949707/article/details/53493037

1 线性回归的使用

1 解决的问题:

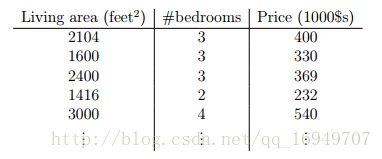

依照一些房子的面积Living area和卧室的个数bedrooms,以及价格price的数据,构建模型来预测给定面积和卧室个数的房间的价格price。

2 构建线性模型

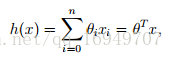

hθ(x) = θ0 + θ1x1 + θ2x2

也可以写作:

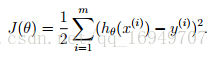

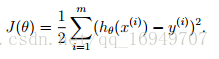

3 构建损失函数

即为预测值和真实值的差别,平方和1/2都是为了方便求导。

4 LMS算法

一 批量梯度下降算法

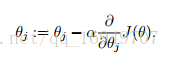

1 用损失函数的梯度乘以a(尺度因子)去更新模型参数θj。

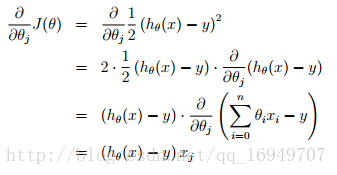

2 而损失函数对θj求导为:

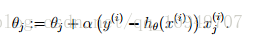

3 所以θj依靠已有数据训练可以表示为:

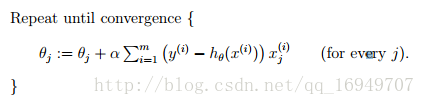

4 一直更新,直到收敛

因为每次更新都用到了整个训练数集,所以称作batch gradient descent批量梯度下降算法。

二 随机梯度下降算法来更新模型参数θj

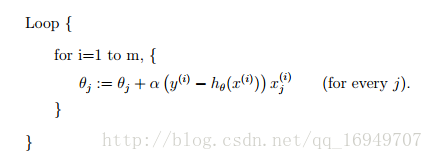

只针对单个训练例子来更新模型参数,叫做stochastic gradient descent随机梯度下降算法。

2 三个疑惑

一 为什么只是线性模型?

刚开始为了简单

二 损失函数为什么定义为如下情况:

1 推导:

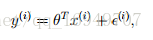

假设存在误差的模型可以表示为:

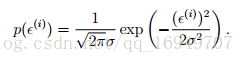

2 而误差服从高斯分布(一般情况)

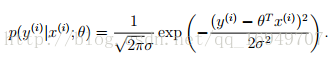

3 那么就代表模型参数为θ时,输入为x(i),输出为y(i)的概率为:

(误差越小,概率越大,而误差服从高斯分布)

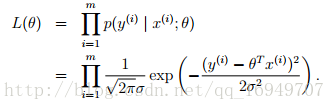

4 那么参数为θ的似然函数可以记为:

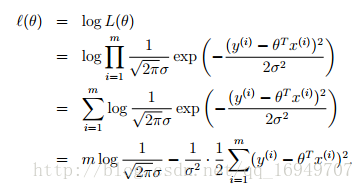

5 最大化log(参数θ的似然函数)

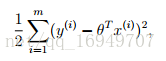

要使这个函数最大,那么就要使这个函数的后半部分最小,即:

跟之前定义的损失函数一致

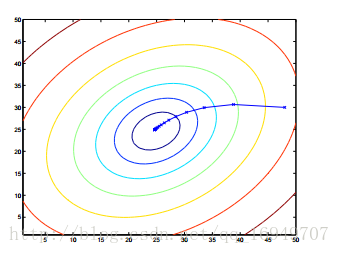

三 梯度下降算法为什么能得到最优解?

每次依照模型θ的函数,在梯度方向逐步更新θ,直到收敛,即误差很小为止。