论文地址:Identity Mappings in Deep Residual Networks

在上一篇文章中,对MSRA何凯明团队的ResNet进行了介绍(地址),那篇文章中提到了,1202层的ResNet出现了过拟合的问题,有待进一步改进。第二年,何的团队就发表了“Identity Mappings in Deep Residual Networks”这篇文章,分析了ResNet成功的关键因素——residual block背后的算法,并对residual block以及after-addition activation进行改进,通过一系列的ablation experiments验证了,在residual block和after-addition activation上都使用identity mapping(恒等映射)时,能对模型训练产生很好的效果,通过这项改进,也成功的训练出了具有很好效果的ResNet-1001。

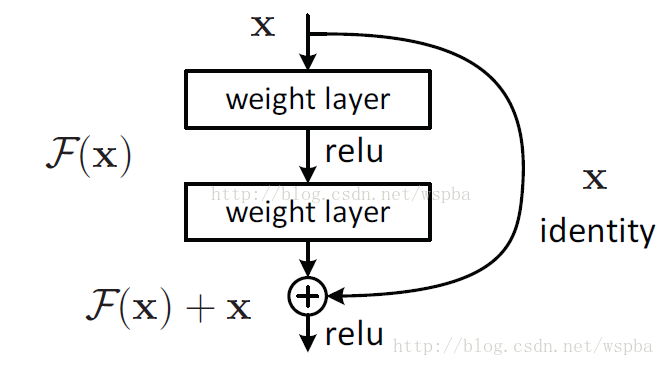

在原始的ResNet中,对于每一个residual building block:

可以表现为以下形式:

其中

而本文提出了,如果h(x)和f(y)都是恒等映射,即

即上面的公式可以表达为:

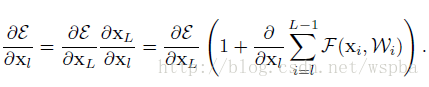

那么通过递归,可以得到任意深层单元L特征的表达:

文章分析了这个表达的优良特性:

(1)对于任意深的单元

(2)对于任意深的单元

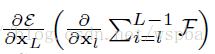

而对于反向传播,假设损失函数为

将梯度分成了两个部分:不通过权重层的传递

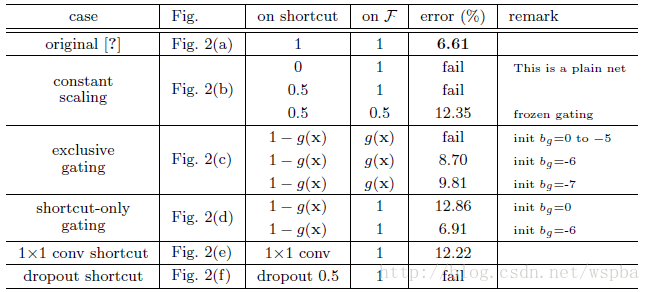

通过了以上分析,作者设计实验来进行验证。

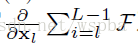

首先,对于恒等跳跃连接

作者认为,捷径连接中的操作 (缩放、门控、1

而且虽然1

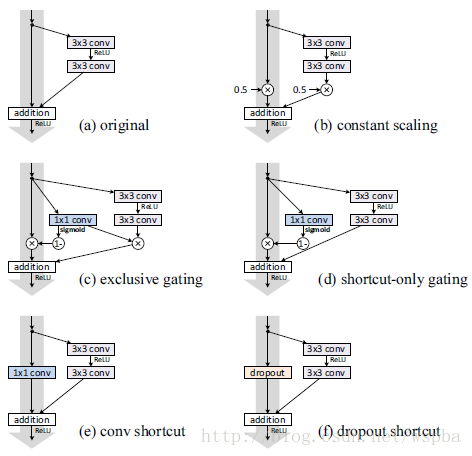

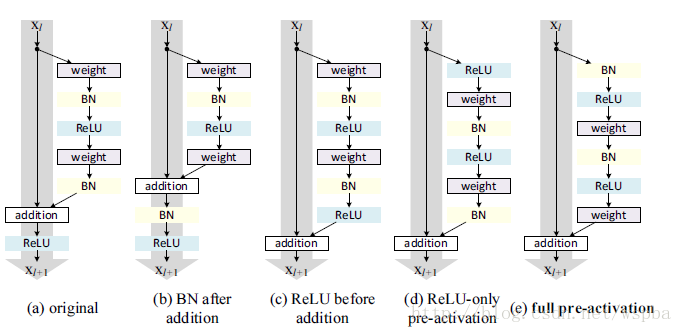

接下来,对于激活函数,作者设计了以下几种形式:

实际上只是激活函数(ReLU/BN)的位置有所不同,由于作者希望构建一个恒等的

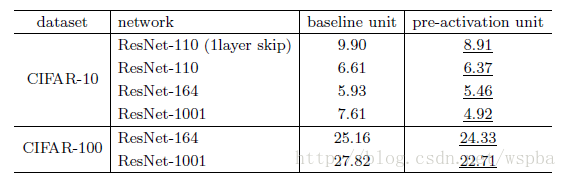

甚至在1001层的ResNet上也克服了过拟合的问题:

作者认为这是由两方面引起的:第一,由于

这篇文章为深层模型的训练提供了很好的方式和思路,也促进了深层模型的进一步发展,接下来我将会把这篇文章的译文提供给大家,也欢迎大家的批评指正。