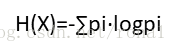

信息熵:

变量X有多种取值x1,x2,x3...xi...xn,

现有一样本,用各种取值的频率近似作为概率用,求得:

p1,p2,p3...pi...pn

熵

这里的log可以以2,10,e为底,反正后面要用的是熵的差值或比值。

信息增益:

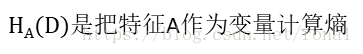

g(D,A)=样本原本熵H(D)-用A特征分类后的熵H(D|A)

H(D|A)算法:假设D被A分为多组,D1,D2...Di...,每组的样本数量n1,n2...ni...

H(D|A)=∑(ni/n)·H(Di)

信息增益缺点:会偏向取值多的特征

信息增益率:

实质是g(D,A)乘以一个惩罚系数

A取值越多,这个惩罚系数越小,

缺点:偏向取值少的特征。

gini不纯度:只能处理二分类特征,

对于多分类特征,用one-against-rest,先找到一个gini最小的分点,变为二分类。

预剪枝:树生成过程中,对每个结点判断是否应该作为叶结点。

后剪枝:完整树生成后,从叶到根逐个非叶结点判断是否应该作为叶结点。

连续值处理:离散化

方法:值排序,相邻两两相加,得到的点作为候选划分点,找到一个信息增益最高的点作为划分点。

缺失值处理:每次计算只在本特征非缺失样本中进行。