本论文介绍了FLAN(Fine-tuned LAnguage Net,微调语言网络),一种指导微调方法,并展示了其应用结果。该研究证明,通过在1836个任务上微调540B PaLM模型,同时整合Chain-of-Thought Reasoning(思维链推理)数据,FLAN在泛化、人类可用性和零射推理方面相对于基础模型取得了改进。论文还详细介绍了如何评估这些方面。

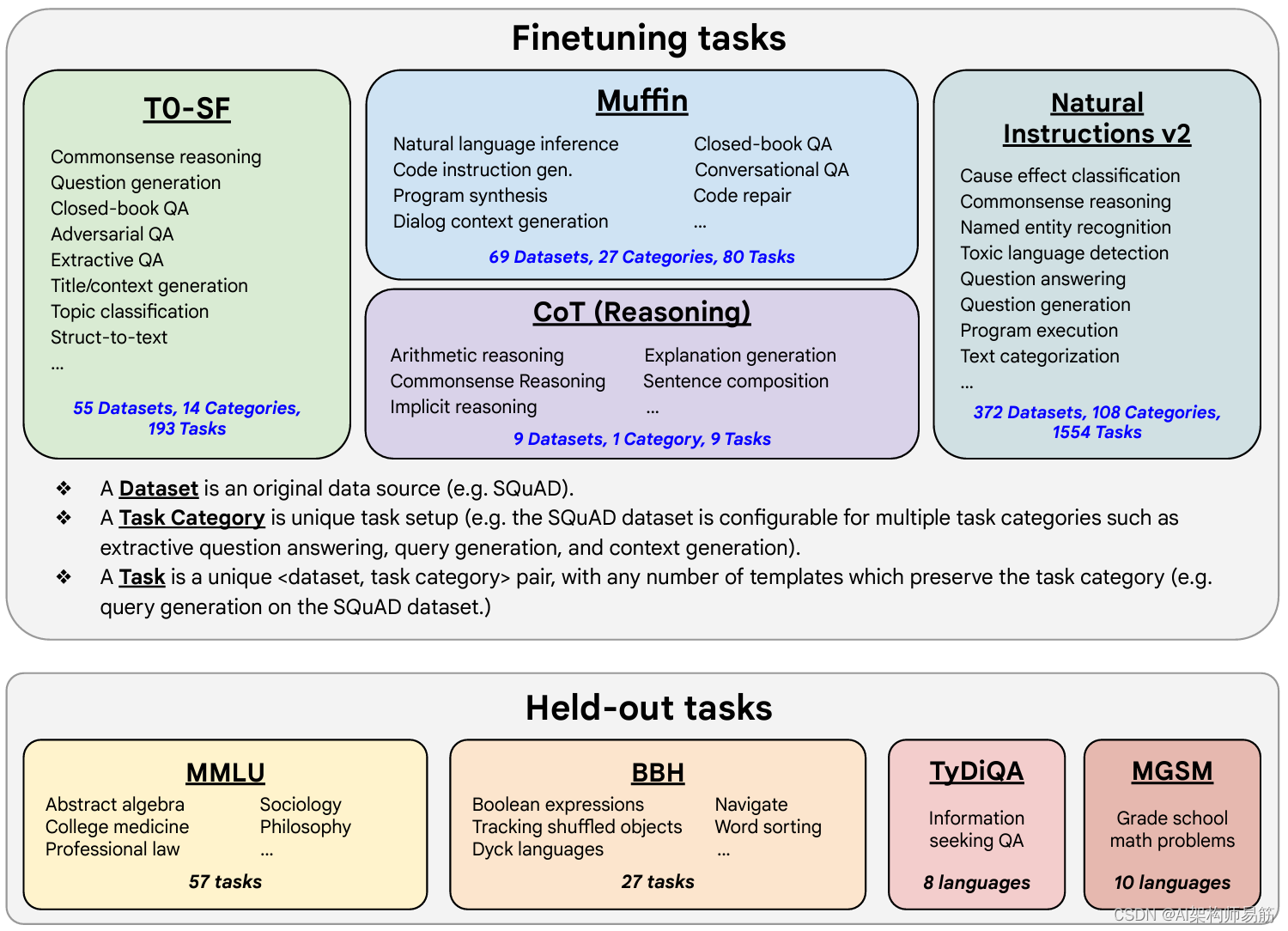

这里是来自讲座幻灯片的图片,说明了在训练FLAN时使用的微调任务和数据集。任务选择在以前的工作基础上进行了扩展,通过整合来自Muffin的对话和程序合成任务,并将它们与新的Chain of Thought Reasoning任务集成。它还包括其他任务集合的子集,如T0和Natural Instructions v2。一些任务在训练期间被保留,后来用于评估模型在未见任务上的性能。

参考

https://www.coursera.org/learn/generative-ai-with-llms/supplement/aDQwy/scaling-instruct-models