Principal Component Analysis 主成分分析笔记

文章目录

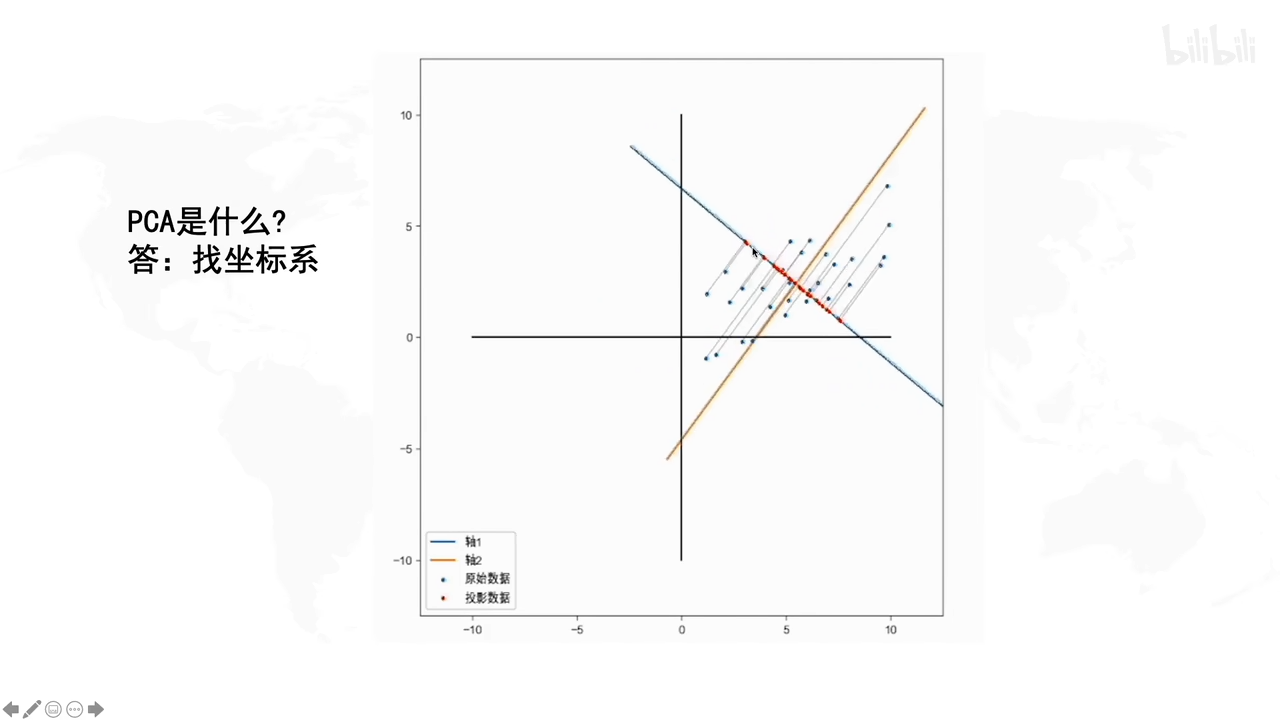

PCA是什么?

假设要保存二维的信息,由于降维考虑,期望只存储一个维度的信息(为了减少存储的信息量)

PCA是找到一个新的坐标系去存储一维信息。这个坐标系的原点落在数据的中心,坐标系的方向是往数据分布的方向走,这样子就降维了。

原始数据分布在新坐标系X轴上,Y轴为0

蓝色的点是原始的数据 ,红色的点是蓝色的点投影到轴上的。这样通过某一些角度,只保留一维信息就能存储二维的信息量了(存在信息损失,但此时目的是为了降维信息的情况下令信息损失度最小)

PCA的目的:找一个坐标系,使得数据在保留一个维度的情况下,信息损失最小

在上图就是很好的显示了,因为坐标点投影得比较分散,易于显示。

若发现投影后数据集中在一个点红色的斑点的话,说明没有保存多少信息,因为信息重合混淆了,数据不能很好地在新坐标系下区分开。

那怎么样才算好的坐标系呢?

具体步骤:

若没有去中心化直接找坐标系,不利于发现一个方向,去拟合这些数据。

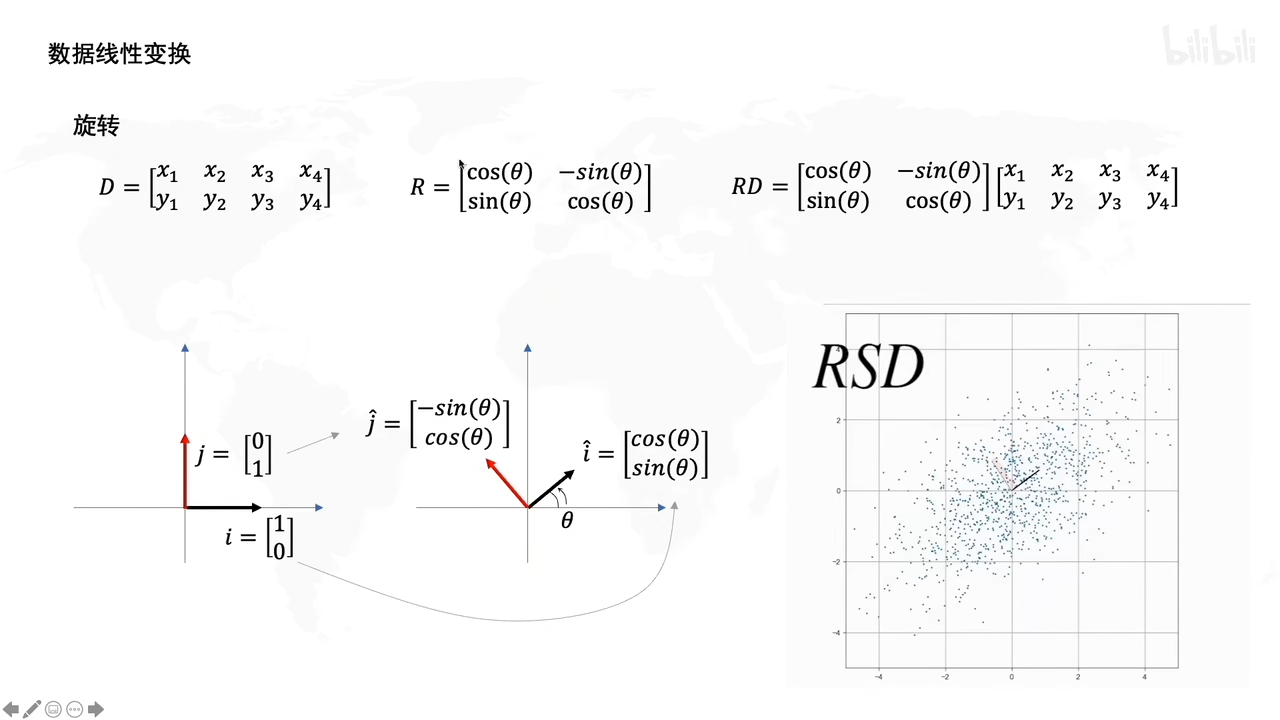

数据的线性变换

拉伸操作:

比如这里,D是一个数据集,S表示拉伸的矩阵(为了实现数据拉伸的)。

S左乘D之后,D上的每一个数据点都被拉伸。

旋转操作:

R就是个旋转矩阵,R左乘D后,让D旋转了某个角度。

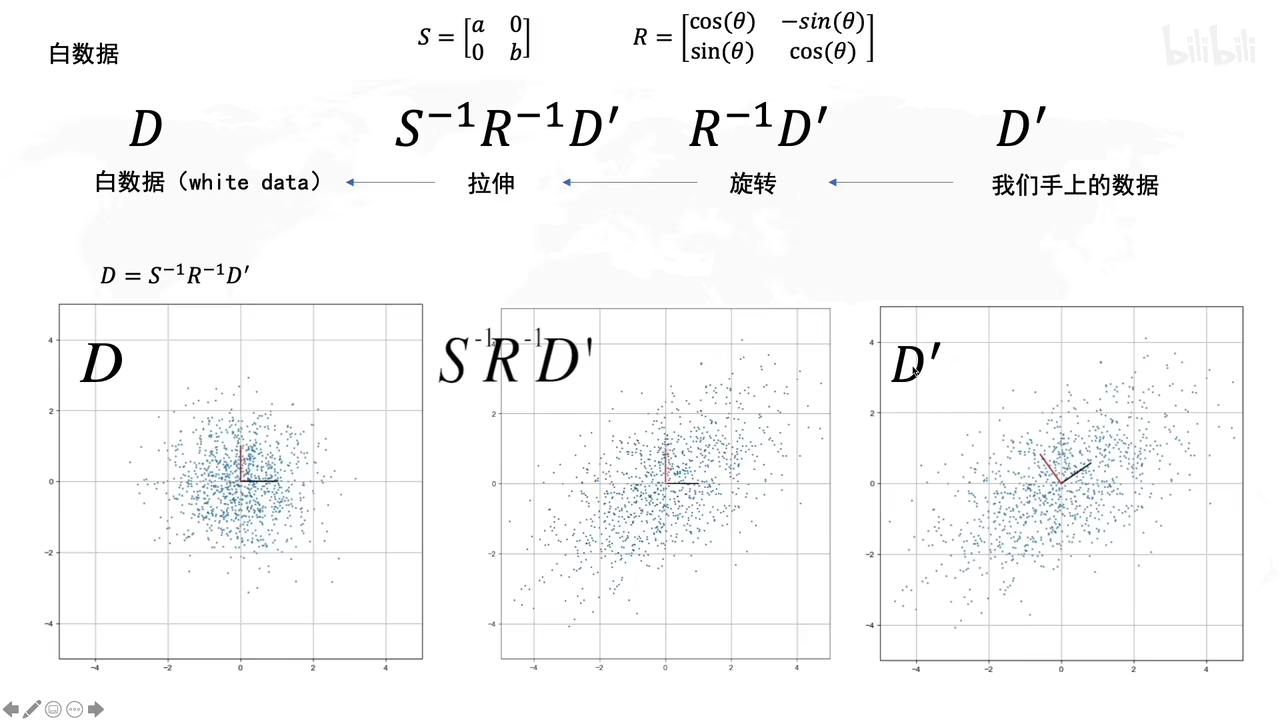

白数据的处理:

白数据:x,y都是服从标准正态分布(均值为0,方差为1),而且x,y不相关。

拉伸,旋转有什么作用呢?

拉伸:是方差最大的方向

旋转:决定了方差最大的方向的角度是多大

旋转找角度,拉伸找最大

D’乘逆矩阵,转化成原来的矩阵D

如何求R?

协方差的特征向量就是R

X,Y并非相互独立,存在一定的正相关关系,引入协方差

什么是协方差?

X增大,Y也增大,数据分布如下图所示。协方差大于0

(自己和自己的协方差就是方差)

协方差矩阵是什么?

协方差矩阵:对角线上是各个轴自己的方差

若x,y是不相关的话,那么cov(x,y)就是0

下图,

左图就是x,y不相关

中图就是x,y正相关(协方差 > 0)

右图就是x,y负相关(协方差 < 0)

为什么是n-1?(因为保证统计量的无偏性,保守估计比真实值偏大)

用白数据加上拉伸和旋转后,就得到D’

开始公示推导:(D’符合一般正态分布,可以标准化后与D一样的特性)

特征向量求解

λ :特征值

v :特征向量

特征值1和特征值2 组成 L矩阵

特征向量1 和特征向量2 组成R矩阵

协方差的特征值:

总结:

PCA怎么求解:

三维降到二维:三维转二维就是找个二维平面然后投影(让数据间方差最大的)

三维转二维就是找个二维平面然后投影,(让数据间方差最大的)

PCA和置信椭圆有什么关系?

置信椭圆:置信椭圆基本上是对置信区域的描述方式,其长轴和短轴分别为置信区域的参数,置信椭圆的长短半轴,分别表示二维位置坐标分量的标准差(如经度的σλ和纬度的σφ)。

从白数据里面画了一个圆,(刚好有0.95的数据在圆内)拉伸旋转后成了一个圆,有0.95的数据点在椭圆里,就是95%置信椭圆

查表得到s = 4.605 ->90%置信椭圆

PCA缺点:

离群点对PCA的结果造成影响较大

课程链接

【用最直观的方式告诉你:什么是主成分分析PCA】 https://www.bilibili.com/video/BV1E5411E71z?share_source=copy_web&vd_source=e6d8f0881a34c7aaf5e3fa344cc9a51a

老师讲的嘎嘎好,通俗易懂,爱了!记得给三连。