【轻量型卷积网络】MobileNet系列:MobileNet V2网络解析

文章目录

1. 介绍

论文地址:论文链接

1.1 V1存在的问题

MobileNet-v1的主要思想就是深度可分离卷积,可以参考MobileNet V1网络解析。

- 结构问题:MobileNet-v1的结构非常简单,类似于VGGNet,是一个非常复古的直筒结构。

- 这种结构的性价比其实不高,后续一系列的ResNet、DenseNet等结构已经证明通过复用图像特征,使用Concat/Elwise+等操作进行融合,能极大提升网络的性价比。

- Depthwise convolution存在的问题:Depthwise convolution确实是大大降低了计算量,Depthwise+Pointwise的结构在性能上也能接近普通卷积。

- 但是在实际应用时我们发现Depthwsie部分的kernel比较容易训废掉,训练完之后发现Depthwise训出来的kernel有不少是空的。因为depthwise每个kernel_dim相对于普通卷积要小得多,过小的kernel_dim加上ReLU的激活影响下,使得输出神经元很容易变为0,所以就学废了。ReLU对于0的输出梯度为0,所以一旦陷入0输出,就没法恢复了。

1.2 解决方法

MobileNet v2网络是由google团队在2018年提出的,相比MobileNet V1网络,准确率更高,模型更小。

网络中的亮点 :

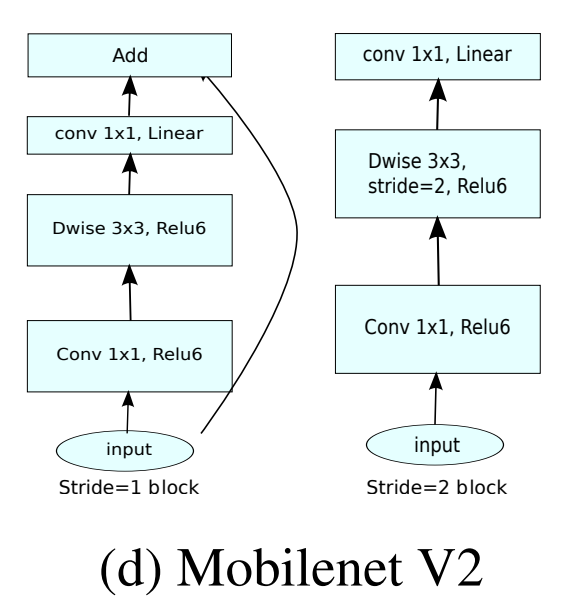

- Inverted Residuals (倒残差结构 ):去掉了小维度输出层后面的非线性激活层,目的是为了保证模型的表达能力。 好处:通过去掉Eltwise+ 的特征去掉ReLU, 减少ReLU对特征的破坏;

- Linear Bottlenecks(结构的最后一层采用线性层):和residual block中维度先缩减再扩增正好相反,因此shotcut也就变成了连接的是维度缩减后的feature map。

- 好处1: 复用特征。

- 好处2: 旁支block内先通过1x1升维, 再接depthwise conv以及ReLU, 通过增加ReLU的InputDim, 来缓解特征的退化情况。

MobileNet-v2的主要思想就是在v1的基础上引入了线性瓶颈 (Linear Bottleneck)和逆残差 (Inverted Residual)来提高网络的表征能力,同样也是一种轻量级的卷积神经网络。

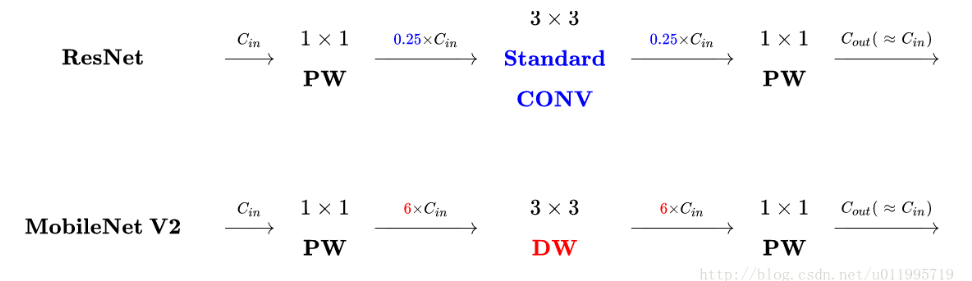

- ResNet是:压缩”→“卷积提特征”→“扩张”,

- MobileNetV2则是Inverted residuals,即:“扩张”→“卷积提特征”→ “压缩”。

2. 模型

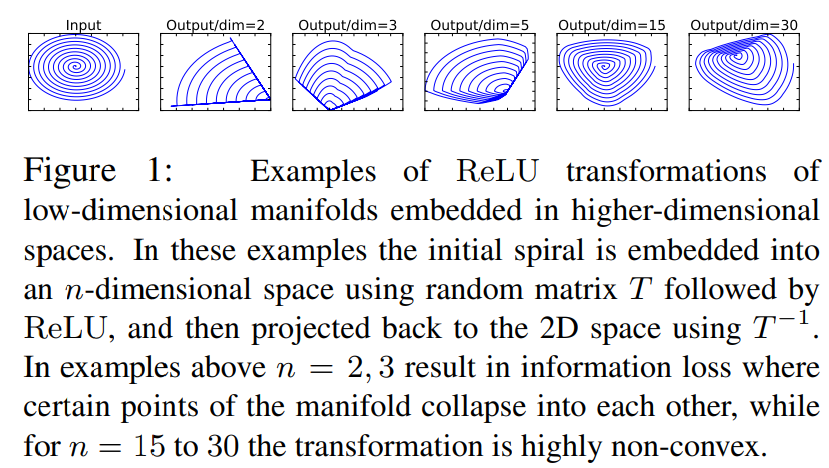

2.1 Linear Bottlenecks

v1中使用width multiplier参数来做模型通道的缩减,使特征信息集中在缩减后的通道中,其后使用非线性激活ReLU,会产生较大的信息丢失。为了减少信息损失,v2使用linear bottleneck,在bottleneck的输出后接线性激活。

2.2 Inverted residuals

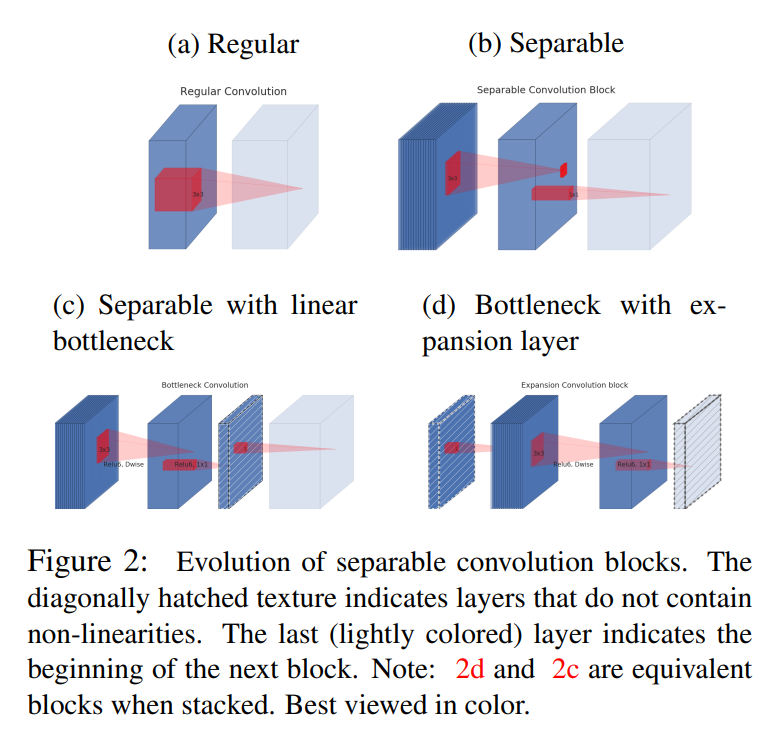

上图展示了从standard convolution到depthwise separable convolution再到本文中的inverted residual block的差异。

- 标准33卷积操作,若输入channel数量为n,则卷积核的维度为33n(图中红色立方体),将channel和spatial的信息同时进行映射,参数量较大

- v1中采用的depthwise separable convolution,可分离卷积,解耦了channel和spatial,化乘法为加法

- 在(b)的基础上增加了一个类似bottleneck的操作

- v2 inverted residual block结构,和ResNet中residual block对维度的操作相反。

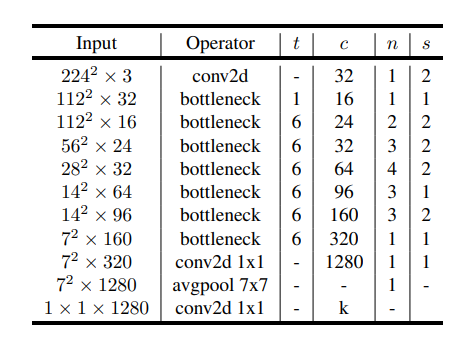

2.3 网络结构

MobieNet V2网络结构细节如下: