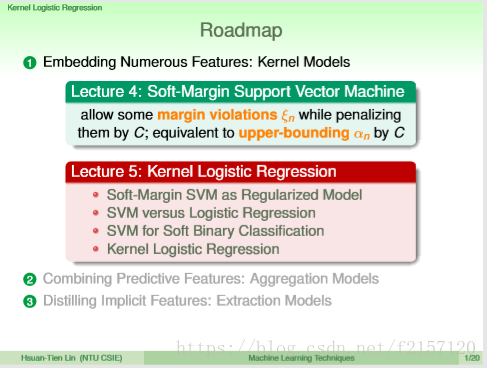

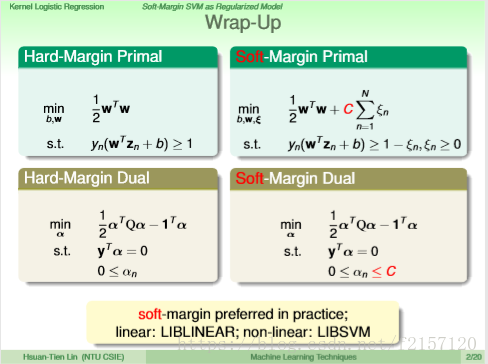

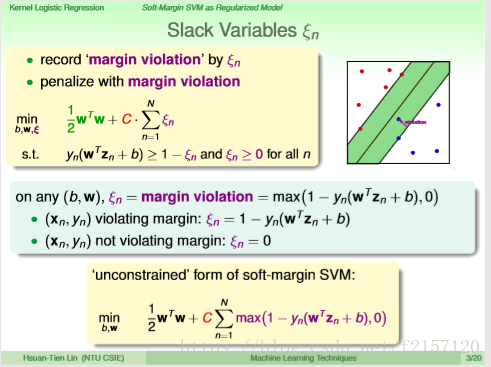

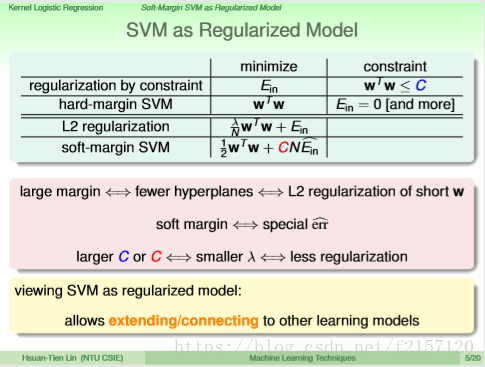

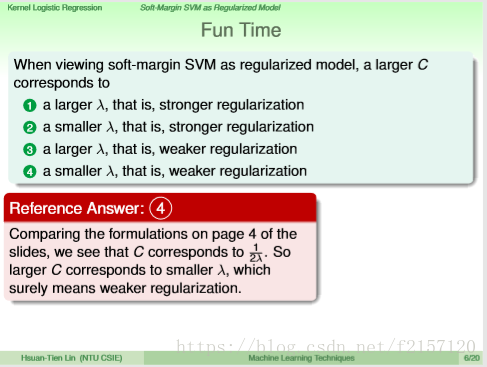

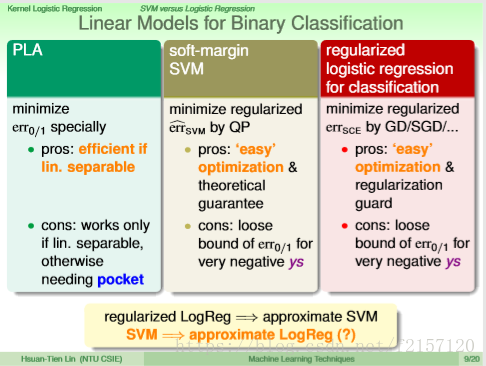

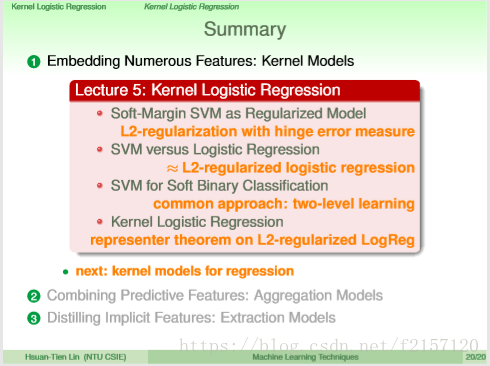

上节2-4中有讲,如果SVM中允许犯一点点错误,把原来很严格的hard-margin改成soft-margin,允许违反一些些边界,用C代表惩罚,与原来形式类似,唯一的差别,就是alpha n的上界为C。

LIBLINEAR,LIMSVM(专门求解dual SVM)由台大林志远老师实验室开发

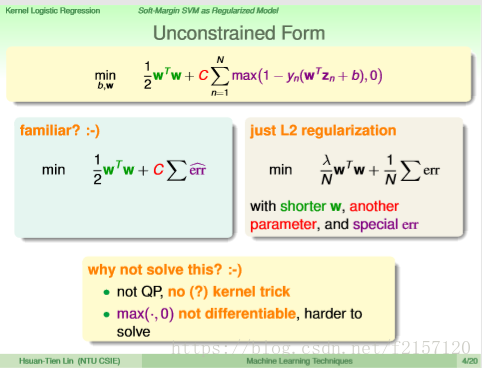

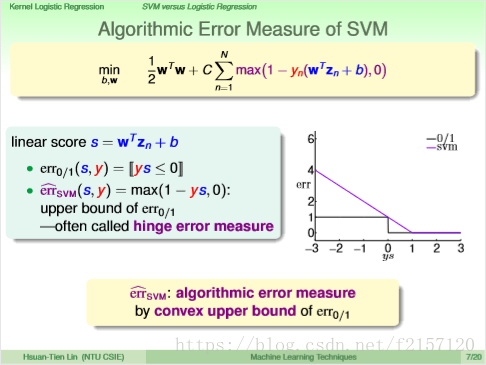

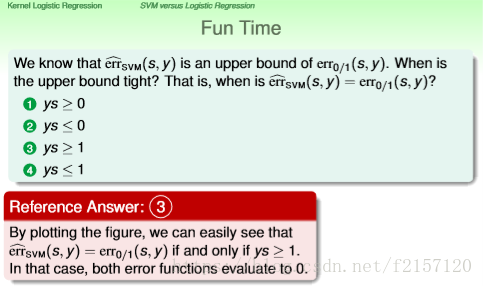

SVM error measure, usually called hinge error measure.

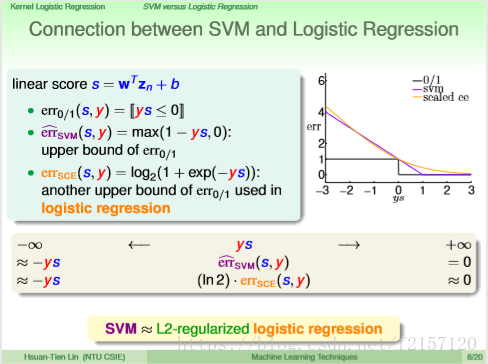

errSCE: scalled error.

Soft margin SVM 的解可以作为logistics Regression的某个解。

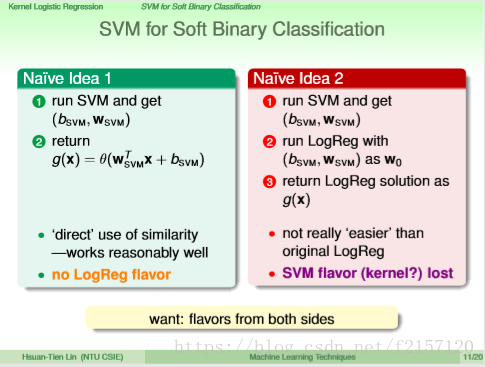

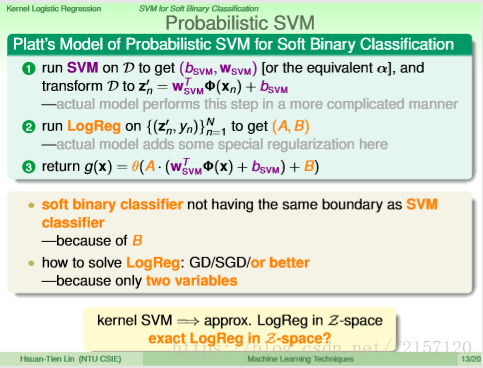

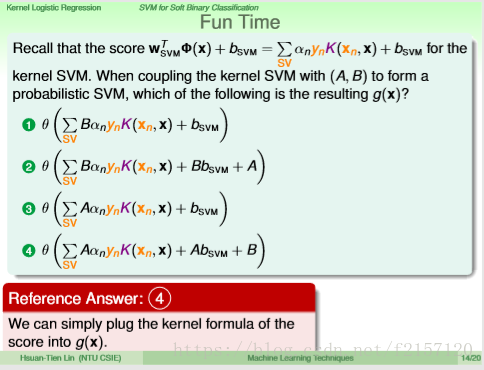

SVM只是分开ooxx,但不具有概率的特性。Logistics Regression则具有该特性。 SVM的解作为Logistics Regression的起始点,快速求解。

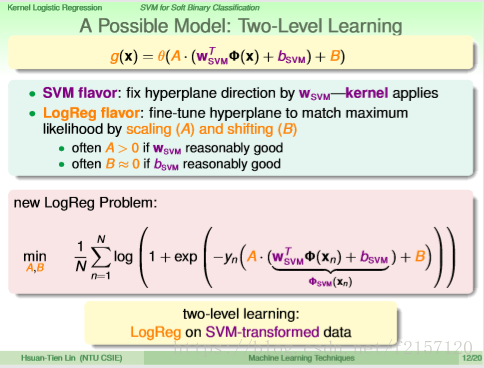

融合SVM与Logistics Regression,

B可以平移SVM的边界

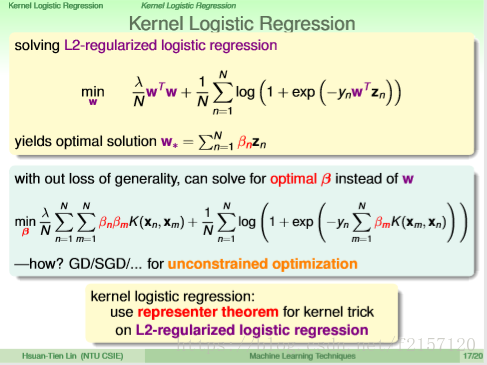

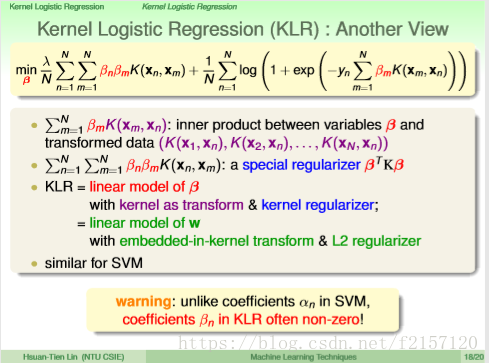

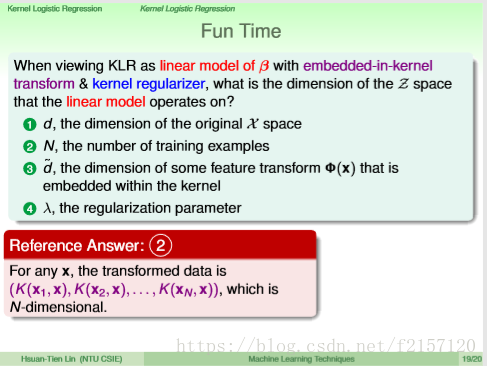

在Z空间里面真正的做Logistics Regression, 而不是刚才的近似解。 Logistics Regression根本不是一个QP问题(二次优化)

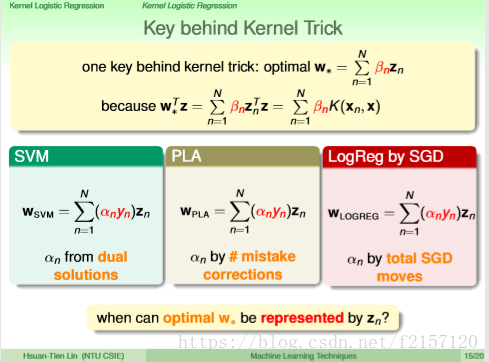

最佳的w是一堆z的线性组合。 SVM的组合系数来自于对偶问题的解,PLA组合系数来此于训练过程中z参与了多少次错误矫正,LogReg的组合系数来自于GD/SGD过程中告诉我们到底该按照多大的步数走。

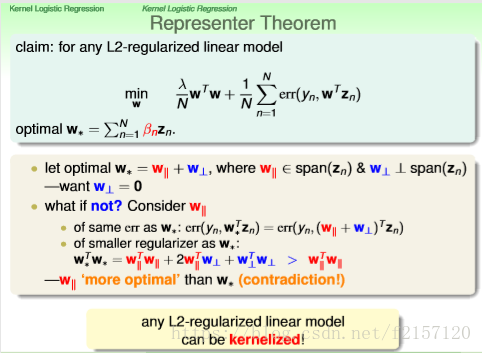

解的是L2-regularzied linear model时,最后结果w就可以表示为z的线性组合。