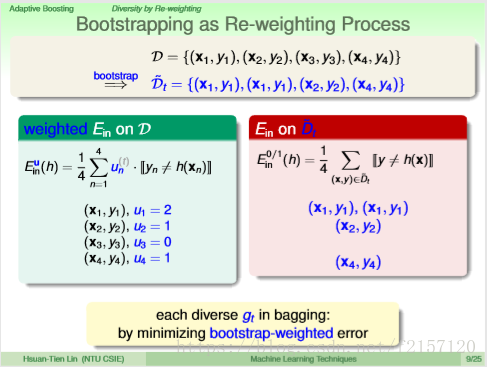

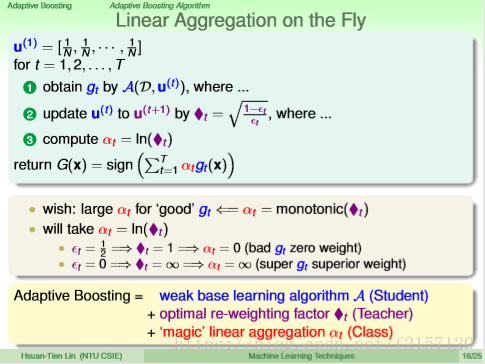

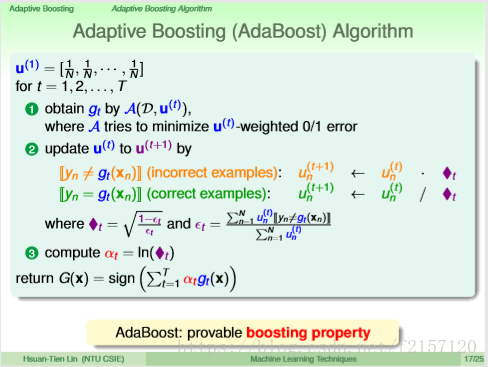

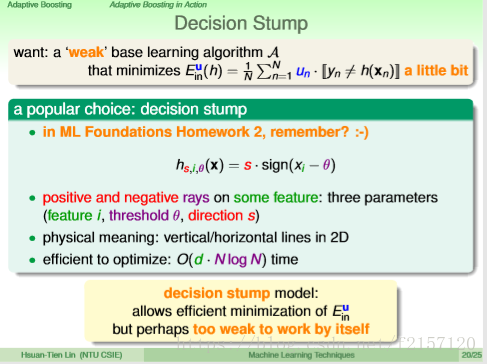

先算出错误率Epselo t,把犯错误的点做(1-Et)的放缩,正确的点做Et比例的放缩=》正确的乘以♦t,错误的除以♦t

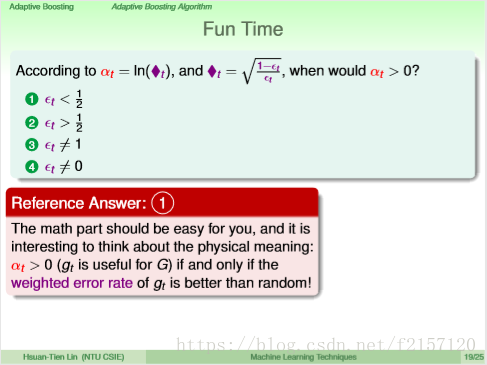

通常,♦t≥1,因为1/2是丢铜板乱猜的概率。只要base algroithm比乱猜好,♦t大于等于1,使得正确的得以缩小,错误的得以放大,更加专注在犯错误的点上面,来得到不一样的hypothesis。有点类似于PLA,有错即改

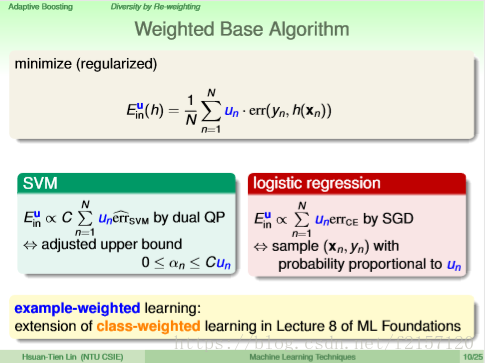

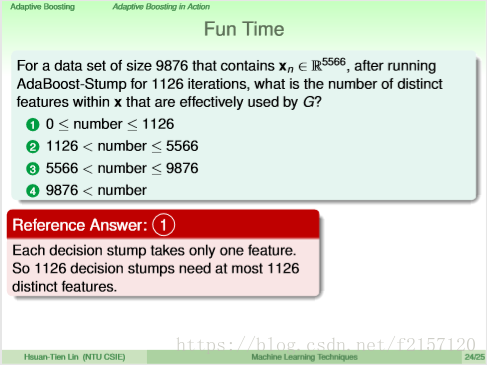

只要比乱猜效果好,最终Ein总可收敛

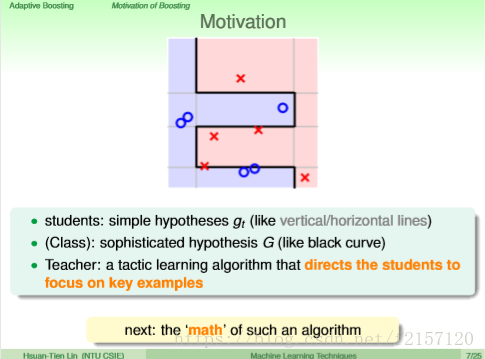

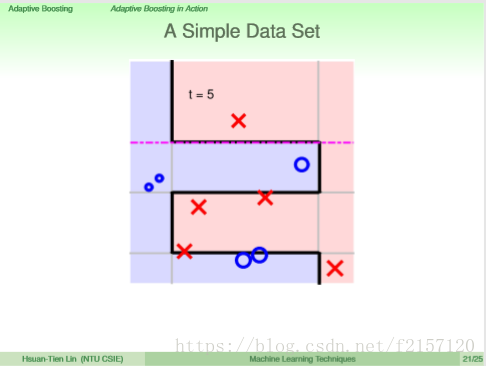

t=1,放大error

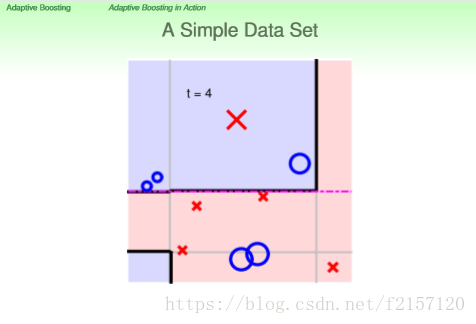

t=2,进一步切割,放大中间的error

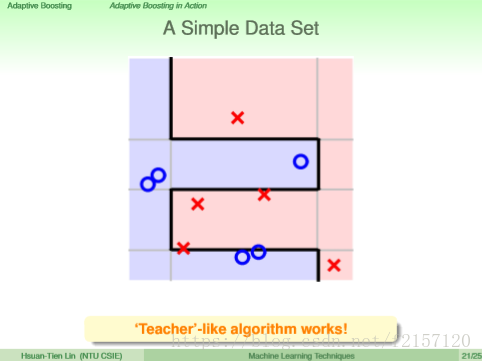

t=3

经过足够的迭代,可以得出一条完美的分界线