概述

-

学习地址:

https://tianchi.aliyun.com/specials/promotion/aicampml?invite_channel=3&accounttraceid=baca918333cb45008b70655b544a5aeadgkm -

学习内容:机器学习算法(三): KNN(k-nearest neighbors)

-

问题:多种监督学习的算法如何选择的问题还没有认真研究。

-

总结:KNN的数据填充为我处理经济数据提供了新的思路,但对面板数据缺失值处理上,KNN算法逻辑不能满足;当加入时间和城市维度,分类就无意义;KNN缺失值补充还是针对分类问题的数据进行补充,不能推广到各个类型的数据填充。

逻辑回归算法

一、KNN的介绍和应用

(一)KNN的介绍

-

KNN(k-nearest neighbors),中文翻译K近邻。我们常常听到一个故事:如果要了解一个人的经济水平,只需要知道他最好的5个朋友的经济能力, 对他的这五个人的经济水平求平均就是这个人的经济水平。这句话里面就包含着KNN的算法思想。

-

KNN是一种memory-based learning,也叫instance-based learning,属于lazy learning。即它没有明显的前期训练过程,而是程序开始运行时,把数据集加载到内存后,不需要进行训练,就可以开始分类了。

(二)算法思路与实现

1. 算法思路

- 算法思想:如果一个样本在特征空间中的k个最相似(即特征空间中最邻近)的样本中的大多数属于某一个类别,则该样本也属于这个类别。该方法在定类决策上只依据最邻近的一个或者几个样本的类别来决定待分样本所属的类别。

- KNN算法中我们最需要关注两个问题:k值的选择和距离的计算。 kNN中的k是一个超参数,需要我们进行指定,一般情况下这个k和数据有很大关系,都是交叉验证进行选择,但是建议使用交叉验证的时候,k∈[2,20],使用交叉验证得到一个很好的k值。

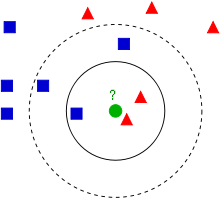

如下例:

如上图,绿色圆要被决定赋予哪个类,是红色三角形还是蓝色四方形?如果K=3,由于红色三角形所占比例为2/3,绿色圆将被赋予红色三角形那个类,如果K=5,由于蓝色四方形比例为3/5,因此绿色圆被赋予蓝色四方形类。

2. KNN建立与类别判定

- 1)KNN建立过程

- 给定测试样本,计算它与训练集中的每一个样本的距离。

- 找出距离近期的K个训练样本。作为测试样本的近邻。

- 依据这K个近邻归属的类别来确定样本的类别。

- 2)类别的判定

-

投票决定,少数服从多数。取类别最多的为测试样本类别。

-

加权投票法,依据计算得出距离的远近,对近邻的投票进行加权,距离越近则权重越大,设定权重为距离平方的倒数。

扫描二维码关注公众号,回复: 12345391 查看本文章

(三)KNN的应用

- 主要应用场景:分类、回归、缺失值填充

-

KNN虽然很简单,但是人们常说"大道至简",一句"物以类聚,人以群分"就能揭开其面纱,看似简单的KNN即能做分类又能做回归, 还能用来做数据预处理的缺失值填充。由于KNN模型具有很好的解释性,一般情况下对于简单的机器学习问题,我们可以使用KNN作为 Baseline,对于每一个预测结果,我们可以很好的进行解释。推荐系统的中,也有着KNN的影子。例如文章推荐系统中, 对于一个用户A,我们可以把和A最相近的k个用户,浏览过的文章推送给A。

-

机器学习领域中,数据往往很重要,有句话叫做:“数据决定任务的上限, 模型的目标是无限接近这个上限”。 可以看到好的数据非常重要,但是由于各种原因,我们得到的数据是有缺失的,如果我们能够很好的填充这些缺失值, 就能够得到更好的数据,以至于训练出来更鲁棒的模型。接下来我们就来看看KNN如果做分类,怎么做回归以及怎么填充空值。

二、算法不足

- 算法复杂程度高,如果已经10000个样本,有1000个样本需要估计,则需基于这10000个样本计算1000次(当数据集不是特别大的时候,计算机还是可以处理的)。

- 当其中样本分布不平衡的时候,比如其中一类样本过大(实例数量过多)占主导地位,新的未知实例容易被归类到这个主导样本,因为这类样本实例的数量过大,但这个新的未知实例实际并没有接近目标样本。某一类别样本密度大,就可能出现误判。

三、算法实践

(一)Demo数据集–kNN分类

# Step1: 库函数导入

import numpy as np

import matplotlib.pyplot as plt

from matplotlib.colors import ListedColormap

from sklearn.neighbors import KNeighborsClassifier

from sklearn import datasets

# Step2: 数据导入

# 使用莺尾花数据集的前两维数据,便于数据可视化

iris = datasets.load_iris()

X = iris.data[:, :2]

y = iris.target

# Step3: 模型训练&可视化

k_list = [1, 3, 5, 8, 10, 15]

h = .02

# 创建不同颜色的画布

cmap_light = ListedColormap(['orange', 'cyan', 'cornflowerblue'])

cmap_bold = ListedColormap(['darkorange', 'c', 'darkblue'])

plt.figure(figsize=(15,14))

# 根据不同的k值进行可视化

for ind,k in enumerate(k_list):

# enumerate(sequence, [start=0]),同时列出数据和数据下标,一般用在 for 循环当中

clf = KNeighborsClassifier(k)

clf.fit(X, y)

# 画出决策边界

x_min, x_max = X[:, 0].min() - 1, X[:, 0].max() + 1

y_min, y_max = X[:, 1].min() - 1, X[:, 1].max() + 1

# 规定coordinates中X,Y的最小与最大值

xx, yy = np.meshgrid(np.arange(x_min, x_max, h),

np.arange(y_min, y_max, h)) # 步长为h

Z = clf.predict(np.c_[xx.ravel(), yy.ravel()])

# 根据边界填充颜色

Z = Z.reshape(xx.shape)

plt.subplot(321+ind)

'''

plt.subplot(221)

# equivalent but more general

ax1=plt.subplot(2, 2, 1)

'''

plt.pcolormesh(xx, yy, Z, cmap=cmap_light)

# 数据点可视化到画布

plt.scatter(X[:, 0], X[:, 1], c=y, cmap=cmap_bold,

edgecolor='k', s=20)

# The edge color of the marker. Possible values

plt.xlim(xx.min(), xx.max())

plt.ylim(yy.min(), yy.max())

# plt.xlim() 显示的是x轴的作图范围,同时plt.ylim() 显示的是y轴的作图范围,而 plt.xticks() 表达的是x轴的刻度内容的范围

plt.title("3-Class classification (k = %i)"% k)

plt.show()

- Step4: 原理解析

如果选择较小的K值,就相当于用较小的领域中的训练实例进行预测,例如当k=1的时候,在分界点位置的数据很容易受到局部的影响,图中蓝色的部分中还有部分绿色块,主要是数据太局部敏感。当k=15的时候,不同的数据基本根据颜色分开,当时进行预测的时候,会直接落到对应的区域,模型相对更加鲁棒。

(二)莺尾花数据集–kNN分类

# Step1: 库函数导入

import numpy as np

from sklearn import datasets # 加载莺尾花数据集

from sklearn.neighbors import KNeighborsClassifier # 导入KNN分类器

from sklearn.model_selection import train_test_split

# Step2: 数据导入&分析

iris = datasets.load_iris() # 导入莺尾花数据集

X = iris.data

y = iris.target

# 得到训练集合和验证集合, 8: 2

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)

# Step3: 模型训练

# 这里我们设置参数k(n_neighbors)=5, 使用欧式距离(metric=minkowski & p=2)

# 训练模型

clf = KNeighborsClassifier(n_neighbors=5, p=2, metric="minkowski")

# Power parameter for the Minkowski metric. When p = 1, this is equivalent to using manhattan_distance (l1), and euclidean_distance (l2) for p = 2. For arbitrary p, minkowski_distance (l_p) is used.

clf.fit(X_train, y_train)

# Step4:模型预测&可视化

# 预测

X_pred = clf.predict(X_test)

acc = sum(X_pred == y_test) / X_pred.shape[0]

print("预测的准确率ACC: %.3f" % acc)

(三)模拟数据集–kNN回归

- KNN回归的算法核心是: 是取 k 个离 x1 最近的样本坐标,然后对他们的 y1 值求平均。

# Step1: 库函数导入

#Demo来自sklearn官网

import numpy as np

import matplotlib.pyplot as plt

from sklearn.neighbors import KNeighborsRegressor

# Step2: 数据导入&分析

np.random.seed(0)

# 随机生成40个(0, 1)之前的数,乘以5,再进行升序

X = np.sort(5 * np.random.rand(40, 1), axis=0)

# Create an array of the given shape and populate it with random samples

# from a uniform distribution over [0, 1).

# 创建[0, 5]之间的500个数的等差数列, 作为测试数据

T = np.linspace(0, 5, 500)[:, np.newaxis] # np.newaxis的作用是增加一个维度。

# 使用sin函数得到y值,并拉伸到一维

y = np.sin(X).ravel()

# Add noise to targets[y值增加噪声]

y[::5] += 1 * (0.5 - np.random.rand(8))

# list[start:end:step]

# #############################################################################

# Step3: 模型训练&预测可视化

# Fit regression model

# 设置多个k近邻进行比较

n_neighbors = [1, 3, 5, 8, 10, 40]

# 设置图片大小

plt.figure(figsize=(10,20))

for i, k in enumerate(n_neighbors):

# 默认使用加权平均进行计算predictor

clf = KNeighborsRegressor(n_neighbors=k, p=2, metric="minkowski")

# 训练

clf.fit(X, y)

# 预测

y_ = clf.predict(T)

plt.subplot(6, 1, i + 1)

plt.scatter(X, y, color='red', label='data')

plt.plot(T, y_, color='navy', label='prediction')

plt.axis('tight')

plt.legend()

plt.title("KNeighborsRegressor (k = %i)" % (k))

plt.tight_layout()

plt.show()

- Step4:模型分析

当k=1时,预测的结果只和最近的一个训练样本相关,从预测曲线中可以看出当k很小时候很容易发生过拟合。

当k=40时,预测的结果和最近的40个样本相关,因为我们只有40个样本,此时是所有样本的平均值,此时所有预测值都是均值,很容易发生欠拟合。

一般情况下,使用knn的时候,根据数据规模我们会从[3, 20]之间进行尝试,选择最好的k,例如上图中的[3, 10]相对1和40都是还不错的选择。

(四)马绞痛数据–kNN数据预处理+kNN分类pipeline

# 下载需要用到的数据集

!wget https://tianchi-media.oss-cn-beijing.aliyuncs.com/DSW/3K/horse-colic.csv

# 下载数据集介绍

!wget https://tianchi-media.oss-cn-beijing.aliyuncs.com/DSW/3K/horse-colic.names

# Step1: 库函数导入

import numpy as np

import pandas as pd

# kNN分类器

from sklearn.neighbors import KNeighborsClassifier

# kNN数据空值填充

from sklearn.impute import KNNImputer

# 计算带有空值的欧式距离

from sklearn.metrics.pairwise import nan_euclidean_distances

# 交叉验证

from sklearn.model_selection import cross_val_score

# KFlod的函数

from sklearn.model_selection import RepeatedStratifiedKFold

from sklearn.pipeline import Pipeline

import matplotlib.pyplot as plt

from sklearn.model_selection import train_test_split

- Step2: 数据导入&分析

1数据集介绍:horse-colic.names

数据中的’?‘表示空值,如果我们使用KNN分类器,’?'不能数值,不能进行计算,因此我们需要进行数据预处理对空值进行填充。

这里我们使用KNNImputer进行空值填充,KNNImputer填充的原来很简单,计算每个样本最近的k个样本,进行空值填充。

# Step3: KNNImputer空值填充--使用和原理介绍

X = [[1, 2, np.nan], [3, 4, 3], [np.nan, 6, 5], [8, 8, 7]]

imputer = KNNImputer(n_neighbors=2, metric='nan_euclidean')

imputer.fit_transform(X)

# 带有空值的欧式距离计算公式

nan_euclidean_distances([[np.nan, 6, 5], [3, 4, 3]], [[3, 4, 3], [1, 2, np.nan], [8, 8, 7]])

Step4: KNNImputer空值填充–欧式距离的计算

样本[1, 2, np.nan] 最近的2个样本是: [3, 4, 3] [np.nan, 6, 5], 计算距离的时候使用欧式距离,只关注非空样本。

[1, 2, np.nan] 填充之后得到 [1, 2, (3 + 5) / 2] = [1, 2, 4]

正常的欧式距离

x = [ 3 , 4 , 3 ] , y = [ 8 , 8 , 7 ] ( 3 − 8 ) 2 + ( 4 − 8 ) 2 + ( 3 − 7 ) 2 = 33 = 7.55 x = [3, 4, 3], y = [8, 8, 7] \\ \sqrt{(3-8)^2 + (4-8)^2 + (3-7)^2} = \sqrt{33} = 7.55 x=[3,4,3],y=[8,8,7](3−8)2+(4−8)2+(3−7)2=33=7.55

带有空值的欧式聚类

x = [ 1 , 2 , n p . n a n ] , y = [ n p . n a n , 6 , 5 ] 3 1 ( 2 − 6 ) 2 = 48 = 6.928 x = [1, 2, np.nan], y = [np.nan, 6, 5] \\ \sqrt{\frac{3}{1}(2-6)^2} = \sqrt{48} = 6.928 x=[1,2,np.nan],y=[np.nan,6,5]13(2−6)2=48=6.928

只计算所有非空的值,对所有空加权到非空值的计算上,上例中,我们看到一个有3维,只有第二维全部非空,

将第一维和第三维的计算加到第二维上,所有需要乘以3。

表格中距离度量使用的是带有空值欧式距离计算相似度,使用简单的加权平均进行填充。

| 带有空值的样本 | 最相近的样本1 | 最相近的样本2 | 填充之后的值 |

|---|---|---|---|

| [1, 2, np.nan] | [3, 4, 3]; 3.46 | [np.nan, 6, 5]; 6.93 | [1, 2, 4] |

| [np.nan, 6, 5] | [3, 4, 3]; 3.46 | [8, 8, 7]; 3.46 | [5.5, 6, 5] |

# load dataset, 将?变成空值

input_file = './horse-colic.csv'

df_data = pd.read_csv(input_file, header=None, na_values='?')

# 得到训练数据和label, 第23列表示是否发生病变, 1: 表示Yes; 2: 表示No.

data = df_data.values

ix = [i for i in range(data.shape[1]) if i != 23]

X, y = data[:, ix], data[:, 23]

# 查看所有特征的缺失值个数和缺失率

for i in range(df_data.shape[1]):

n_miss = df_data[[i]].isnull().sum()

perc = n_miss / df_data.shape[0] * 100

if n_miss.values[0] > 0:

print('>Feat: %d, Missing: %d, Missing ratio: (%.2f%%)' % (i, n_miss, perc))

# 查看总的空值个数

print('KNNImputer before Missing: %d' % sum(np.isnan(X).flatten()))

# 定义 knnimputer

imputer = KNNImputer()

# 填充数据集中的空值

imputer.fit(X)

# 转换数据集

Xtrans = imputer.transform(X)

# 打印转化后的数据集的空值

print('KNNImputer after Missing: %d' % sum(np.isnan(Xtrans).flatten()))

Step5: 基于pipeline模型训练&可视化

什么是Pipeline, 我这里直接翻译成数据管道。任何有序的操作有可以看做pipeline,例如工厂流水线,对于机器学习模型来说,这就是数据流水线。

是指数据通过管道中的每一个节点,结果除了之后,继续流向下游。对于我们这个例子,数据是有空值,我们会有一个KNNImputer节点用来填充空值,

之后继续流向下一个kNN分类节点,最后输出模型。

results = list()

strategies = [str(i) for i in [1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 15, 16, 18, 20, 21]]

for s in strategies:

# create the modeling pipeline

pipe = Pipeline(steps=[('imputer', KNNImputer(n_neighbors=int(s))), ('model', KNeighborsClassifier())])

# 数据多次随机划分取平均得分

scores = []

for k in range(20):

# 得到训练集合和验证集合, 8: 2

X_train, X_test, y_train, y_test = train_test_split(Xtrans, y, test_size=0.2)

pipe.fit(X_train, y_train)

# 验证model

score = pipe.score(X_test, y_test)

scores.append(score)

# 保存results

results.append(np.array(scores))

print('>k: %s, Acc Mean: %.3f, Std: %.3f' % (s, np.mean(scores), np.std(scores)))

# print(results)

# plot model performance for comparison

plt.boxplot(results, labels=strategies, showmeans=True)

plt.show()

Step 6: 结果分析

我们的实验是每个k值下,随机切分20次数据, 从上述的图片中, 根据k值的增加,我们的测试准确率会有先上升再下降再上升的过程。 [3, 5]之间是一个很好的取值,上文我们提到,k很小的时候会发生过拟合,k很大时候会发生欠拟合,当遇到第一下降节点,此时我们可以 简单认为不在发生过拟合,取当前的k值即可。