1.逻辑回归用于解决分类问题

简单举例 : 判定邮件是否为垃圾邮件;肿瘤是良性的还是恶性的.

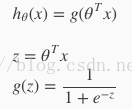

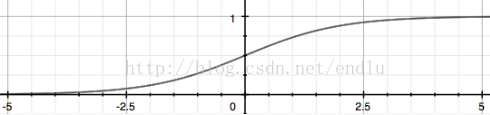

2.假设函数:

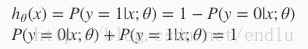

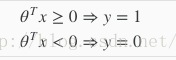

3.预测结果h(x)值的含义为 : x的分类结果属于'1'的概率, 概率表示:

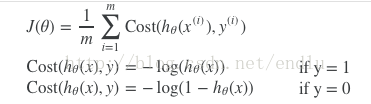

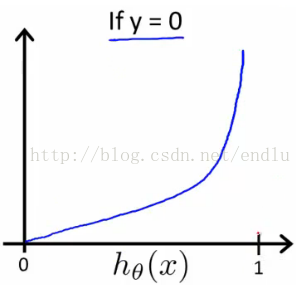

4.代价函数:

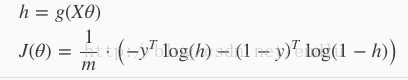

简化形式:

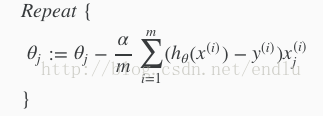

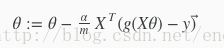

5. 梯度下降法:

6. 向量化:

7. 多元分类问题:1对多法:

上面讨论的都是y只有0 1两种结果的情况,当y取值为更多元时,一个解法如下:

假设y取值为1 2 ... k, 将训练集中y=i 与 y != i (i = 1 2 ... k),分为两种分类,运用上面方法得到k个假设函数h。每个函数的值表示属于分类i的概率。

预测时,分别得到k个结果,取最大值的分类。

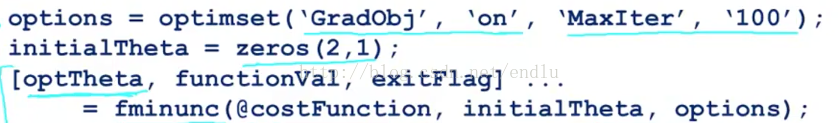

8. 优化算法:

- 共轭梯度法

- BFGS

- L-BFGS

Octive中,最优函数fminunc(), 使用方法:

optimeset构建偏好设置。第一个参数,打开自定义损失函数。第二个参数,设定最大迭代次数。

fminunc,第一个参数是自定义的损失函数,第二个是初始theta向量,第三个是options。

返回值第一个theta,第二个是损失函数的结果,第三个是是否已收敛。

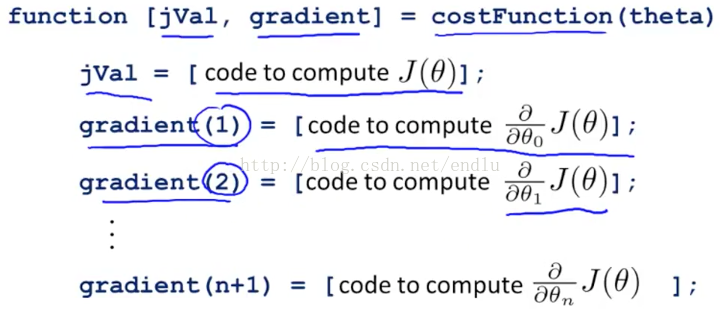

其中,自定义的损失函数如下:

返回值:第一个,损失函数结果。第二个,每一步的梯度值向量。(损失函数对每个theta的偏导)