经典深度学习模型

神经网络有时可以与乐高积木进行比较,在那里你可以构建几乎任何简单到复杂的结构,你的想象力可以帮助你构建。经典深度学习模型 大概有这些:

https://blog.csdn.net/jackkang01/article/details/81064114

LeNet网络

经典的LeNet诞生于1998年

参数详解:

1、INPUT层

首先是数据输入层,输入图像的尺寸统一归一化为32*32。

注意:本层不算LeNet-5的网络结构,传统上,不将输入层视为网络层次结构之一。

2、C1层-卷积层

卷积核:6个,大小:5*5

神经元数量:28x28x6

输入图片尺寸:32x32x1(MNIST数据集是2828,对齐进行边缘0填充扩展为3232);输出featuremap尺寸:28x28x6;(32-5+1=28,filter=5*5, strides(步幅)=1, padding(填充方式选择“不填充”)=‘VALID’)

卷积层参数:(5x5+1)x6=156个参数,其中6个为偏置参数;

卷积层连接:(5x5+1)x28x28x6=122304个连接。有122304个连接,但是我们只需要学习156个参数,主要是通过权值共享实现的。

3、S2层-池化层(下采样层)

输入图片尺寸:28x28x6;

输出图片尺寸:14x14x6;(filter=2*2, strides=2, padding=‘SAME’)

池化层参数:2x6=12个参数;S2这个pooling层是对C1中的2*2区域内的像素求和乘以一个权值系数再加上一个偏置

池化层连接:(4+1)x14x14x6=5880个连接。

采样方式:4个输入相加,乘以一个可训练参数,再加上一个可训练偏置。结果通过sigmoid

采样种类:6

神经元数量:14x14x6

4、C3层-卷积层

输入图片尺寸:14x14x6;

输出图片尺寸:10x10x16;(14-5+1=10,filter=5*5, strides=1, padding=‘VALID’)

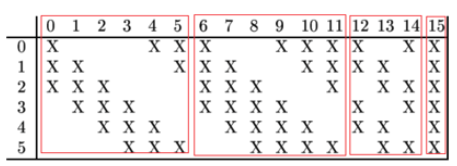

卷积层参数:(5x5x3+1)x6 + (5x5x4 + 1) x 3 + (5x5x4 +1)x6 + (5x5x6+1)x1 = 1516个参数;(这里的卷积核不再是二维平面卷积核,而是3维卷积核,分别对应3层,4层,4层,6层)

卷积层连接:1516x10x10=151600个连接。

5、S4层-池化层(下采样层)

输入图片尺寸:10x10x16;

输出featureMap尺寸:5x5x16;(filter=2*2, strides=2, padding=‘SAME’)

池化层参数:2x16=32个参数;

池化层连接:(4+1)x5x5x16=2000个连接。

6、C5层-卷积层

输入图片尺寸:5x5x16;

输出图片尺寸:1x1x120;(filter=55, strides=1,5-5+1)

这里表示有120个1x1的卷积核

卷积层参数:(5x5x16+1)x120=48120个参数;(120个三维卷积核,卷积核维度是55*16,即一个卷积核有16层,每层参数相同)

卷积层连接:(5x5x16+1)x120=48120个连接,与参数大小一致(相当于全连接)。

7、F6层-全连接层

输入图片尺寸:1x1x120;(C5 层的120维向量)

输出图片尺寸:1x1x84;

全连接层参数:(120+1)x84=10164个参数;

全连接层连接:(120+1)x84=10164个连接,与参数大小一致。(84个神经元,与120维向量全连接)

8、Output层-全连接层

输入图片尺寸:1x1x84;

输出图片尺寸:1x1x10;

全连接层参数:(84+1)x10=850个参数;

全连接层连接:(84+1)x10=850个连接,与参数大小一致

https://blog.csdn.net/qq_30815237/article/details/88988265

AlexNet网络

AlexNet 可以说是具有历史意义的一个网络结构,可以说在AlexNet之前,深度学习已经沉寂了很久。历史的转折在2012年到来,AlexNet 在当年的ImageNet图像分类竞赛中,top-5错误率比上一年的冠军下降了十个百分点,而且远远超过当年的第二名。

AlexNet的创新有如下几个方面:

1、Data augmentation数据增强

https://www.cnblogs.com/wangguchangqing/p/10333370.html#autoid-1-4-0

当训练数据有限的时候,可以通过一些变换来从已有的训练数据集中生成一些新的数据,来扩大训练数据的size。

随机crop。训练时候,对于256*256的图片进行随机crop到224*224,然后允许水平翻转,那么相当与将样本倍增到((256-224)^2)*2=2048。

测试时候,对左上、右上、左下、右下、中间做了5次crop,然后翻转,共10个crop,之后对结果求平均。作者说,不做随机crop,大网络基本都过拟合(under substantial overfitting)。

对RGB空间做PCA,然后对主成分做一个(0, 0.1)的高斯扰动。结果让错误率又下降了1%。

2、ReLU 激活函数

Sigmoid激活函数可以将输出压缩到0,1之间,缺点是:

1、当输入非常大或者非常小的时候,会有饱和现象,这些神经元的梯度是接近于0的。如果你的初始值很大的话,梯度在反向传播的时候因为需要乘上一个sigmoid 的导数,所以会使得梯度越来越小,这会导致网络变的很难学习。

2、Sigmoid 的 output 不是0均值. 这是不可取的,因为这会导致后一层的神经元将得到上一层输出的非0均值的信号作为输入。 产生的一个结果就是:如果数据进入神经元的时候是正的(e.g. x>0 elementwise in f=wTx+b),那么 w计算出的梯度也会始终都是正的。 当然了,如果你是按batch去训练,那么那个batch可能得到不同的信号,所以这个问题还是可以缓解一下的。因此,非0均值这个问题虽然会产生一些不好的影响,不过跟上面提到的 kill gradients 问题相比还是要好很多的。

主要是因为它是linear,而且 non-saturating(因为ReLU的导数始终是1),相比于 sigmoid/tanh,ReLU 只需要一个阈值就可以得到激活值,而不用去算一大堆复杂的运算。

3、Dropout

AlexNet 提出了一个非常有效的模型组合版本,它在训练中只需要花费两倍于单模型的时间。这种技术叫做Dropout,它做的就是以0.5的概率,将每个隐层神经元的输出设置为零。

引入Dropout主要是为了防止过拟合。在神经网络中Dropout通过修改神经网络本身结构来实现,对于某一层的神经元,通过定义的概率将神经元置为0,这个神经元就不参与前向和后向传播,就如同在网络中被删除了一样,同时保持输入层与输出层神经元的个数不变,然后按照神经网络的学习方法进行参数更新。在下一次迭代中,又重新随机删除一些神经元(置为0),直至训练结束。

Dropout应该算是AlexNet中一个很大的创新,现在神经网络中的必备结构之一。Dropout也可以看成是一种模型组合,每次生成的网络结构都不一样,通过组合多个模型的方式能够有效地减少过拟合,Dropout只需要两倍的训练时间即可实现模型组合(类似取平均)的效果,非常高效。

如下图:

4、Local Responce Normalization

LRN是一种提高深度学习准确度的技术方法。LRN一般是在激活、池化函数后的一种方法。 在ALexNet中,提出了LRN层,对局部神经元的活动创建竞争机制,使其中响应比较大对值变得相对更大,并抑制其他反馈较小的神经元,增强了模型的泛化能力。LRN的详细介绍如下: (链接地址:tensorflow下的局部响应归一化函数tf.nn.lrn)

5、层叠池化

在LeNet中池化是不重叠的,即池化的窗口的大小和步长是相等的,在AlexNet中使用的池化(Pooling)却是可重叠的,也就是说,在池化的时候,每次移动的步长小于池化的窗口长度。AlexNet池化的大小为3×3的正方形,每次池化移动步长为2,这样就会出现重叠。重叠池化可以避免过拟合,这个策略贡献了0.3%的Top-5错误率。与非重叠方案s=2,z=2相比,输出的维度是相等的,并且能在一定程度上抑制过拟合。

6、Alex网络结构

上图中的输入是224×224,不过经过计算(224−11)/4=54.75并不是论文中的55×55,而使用227×227作为输入,则(227−11)/4=55

网络包含8个带权重的层;前5层是卷积层,剩下的3层是全连接层。最后一层全连接层的输出是1000维softmax的输入,softmax会产生1000类标签的分布网络包含8个带权重的层;前5层是卷积层,剩下的3层是全连接层。最后一层全连接层的输出是1000维softmax的输入,softmax会产生1000类标签的分布。

卷积层C1

该层的处理流程是: 卷积–>ReLU–>池化–>归一化。

卷积,输入是227×227,使用96个11×11×3的卷积核,得到的FeatureMap为55×55×96。

ReLU,将卷积层输出的FeatureMap输入到ReLU函数中。

池化,使用3×3步长为2的池化单元(重叠池化,步长小于池化单元的宽度),输出为27×27×96((55−3)/2+1=27)

局部响应归一化,使用k=2,n=5,α=10−4,β=0.75进行局部归一化,输出的仍然为27×27×96,输出分为两组,每组的大小为27×27×48

卷积层C2

该层的处理流程是:卷积–>ReLU–>池化–>归一化

卷积,输入是2组27×27×48。使用2组,每组128个尺寸为5×5×48的卷积核,并作了边缘填充padding=2,卷积的步长为1. 则输出的FeatureMap为2组,每组的大小为27×27 times128. ((27+2∗2−5)/1+1=27)

ReLU,将卷积层输出的FeatureMap输入到ReLU函数中

池化运算的尺寸为3×3,步长为2,池化后图像的尺寸为(27−3)/2+1=13,输出为13×13×256

局部响应归一化,使用k=2,n=5,α=10−4,β=0.75进行局部归一化,输出的仍然为13×13×256,输出分为2组,每组的大小为13×13×128

卷积层C3

该层的处理流程是: 卷积–>ReLU

卷积,输入是13×13×256,使用2组共384尺寸为3×3×256的卷积核,做了边缘填充padding=1,卷积的步长为1.则输出的FeatureMap为13×13 times384

ReLU,将卷积层输出的FeatureMap输入到ReLU函数中

卷积层C4

该层的处理流程是: 卷积–>ReLU

该层和C3类似。

卷积,输入是13×13×384,分为两组,每组为13×13×192.使用2组,每组192个尺寸为3×3×192的卷积核,做了边缘填充padding=1,卷积的步长为1.则输出的FeatureMap为13×13 times384,分为两组,每组为13×13×192

ReLU,将卷积层输出的FeatureMap输入到ReLU函数中

卷积层C5

该层处理流程为:卷积–>ReLU–>池化

卷积,输入为13×13×384,分为两组,每组为13×13×192。使用2组,每组为128尺寸为3×3×192的卷积核,做了边缘填充padding=1,卷积的步长为1.则输出的FeatureMap为13×13×256

ReLU,将卷积层输出的FeatureMap输入到ReLU函数中

池化,池化运算的尺寸为3×3,步长为2,池化后图像的尺寸为 (13−3)/2+1=6,即池化后的输出为6×6×256

全连接层FC6

该层的流程为:(卷积)全连接 -->ReLU -->Dropout

卷积->全连接: 输入为6×6×256,该层有4096个卷积核,每个卷积核的大小为6×6×256。由于卷积核的尺寸刚好与待处理特征图(输入)的尺寸相同,即卷积核中的每个系数只与特征图(输入)尺寸的一个像素值相乘,一一对应,因此,该层被称为全连接层。由于卷积核与特征图的尺寸相同,卷积运算后只有一个值,因此,卷积后的像素层尺寸为4096×1×1,即有4096个神经元。

ReLU,这4096个运算结果通过ReLU激活函数生成4096个值

Dropout,抑制过拟合,随机的断开某些神经元的连接或者是不激活某些神经元

全连接层FC7

流程为:全连接–>ReLU–>Dropout

全连接,输入为4096的向量

ReLU,这4096个运算结果通过ReLU激活函数生成4096个值

Dropout,抑制过拟合,随机的断开某些神经元的连接或者是不激活某些神经元

输出层

第七层输出的4096个数据与第八层的1000个神经元进行全连接,经过训练后输出1000个float型的值,这就是预测结果。

AlexNet参数数量

卷积层的参数 = 卷积核的数量 * 卷积核 + 偏置

C1: 96个11×11×3的卷积核,96×11×11×3+96=34848

C2: 2组,每组128个5×5×48的卷积核,(128×5×5×48+128)×2=307456

C3: 384个3×3×256的卷积核,3×3×256×384+384=885120

C4: 2组,每组192个3×3×192的卷积核,(3×3×192×192+192)×2=663936

C5: 2组,每组128个3×3×192的卷积核,(3×3×192×128+128)×2=442624

FC6: 4096个6×6×256的卷积核,6×6×256×4096+4096=37752832

FC7: 4096∗4096+4096=16781312

output: 4096∗1000=4096000

卷积层 C2,C4,C5中的卷积核只和位于同一GPU的上一层的FeatureMap相连。从上面可以看出,参数大多数集中在全连接层,在卷积层由于权值共享,权值参数较少。