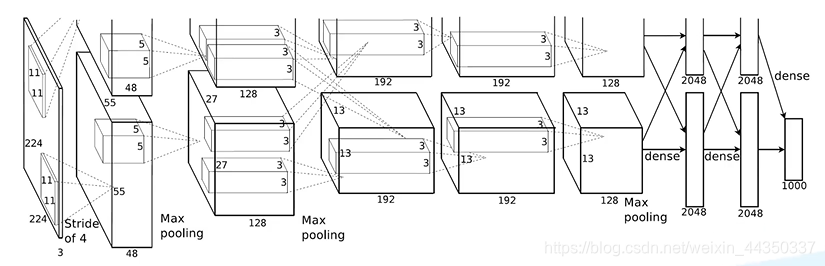

AlexNet:2012年ILSVRC比赛冠军,远超第二名的CNN,分类准确率由传统的70%+提升到80%+。比LeNet更深,用多层小卷积叠加来替换单个的大卷积。

该网络的亮点在于:

(1)首次利用GPU进行网络加速训练。

(2)使用了ReLU激活函数,而不是传统的sigmoid激活函数以及Tanh激活函数。

(3)使用了LRN局部响应归一化。

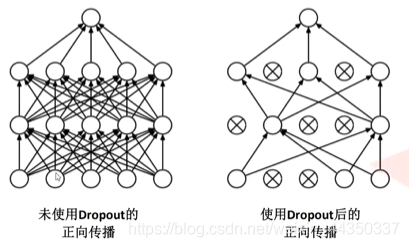

(4)在全连接层的前两层中使用了Dropout随机失活神经元操作,以减少过拟合。

使用Dropout的方式在网络正向传播过程中随机失活一部分神经元

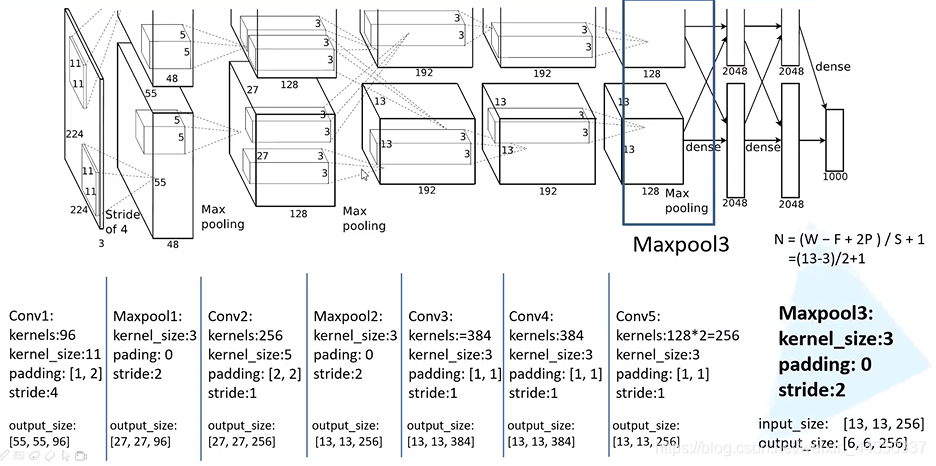

经卷积后的矩阵尺寸大小计算公式为:

N = (W-F+2P)/ S+1

- 输入图片大小为W*W

- Filter大小F*F

- 步长S

- padding的像素数为P

原始数据是2562563的图片

图像处理:数据增强,

随机剪切 256 * 256 * 3——> 224 * 224 * 3

224*224旋转 位置变换

224 * 224——> 227 * 227

实际输入AlexNet网络的是227 * 227 * 3,这样是为了方便计算,这样不需要后续padding

Conv1*:卷积

Kernels:卷积核个数 48*2=96

kernel_size:11

padding:【1,2】

stride:2

input_size:【55,55,96】

output_size:【27,27,96】