KNN算法(k-Nearest Neighbor Classification)---- k-近邻分类算法

• 一个样本在特征空间中,总会有k个最相似(即特征空间中最邻近)的样本。其中,大多数样本属于某一个类别,则该样本也属于这个类别。

• 是理论上比较成熟的方法,也是最简单的机器学习算法之一。

行业应用:

- 客户流失预测

- 欺诈侦测等(更适合于稀有事件的分类问题)

计算步骤:

- 算距离:给定测试对象,计算它与训练集中的每个对象的距离

- 找邻居:圈定距离最近的k个训练对象,作为测试对象的近邻

- 做分类:根据这k个近邻归属的主要类别,来对测试对象分类

是一种懒惰算法

• 平时不好好学习,考试(对测试样本分类)时才临阵磨枪(临时去找k个近邻)。

• 懒惰的后果:模型简单,计算开销大。

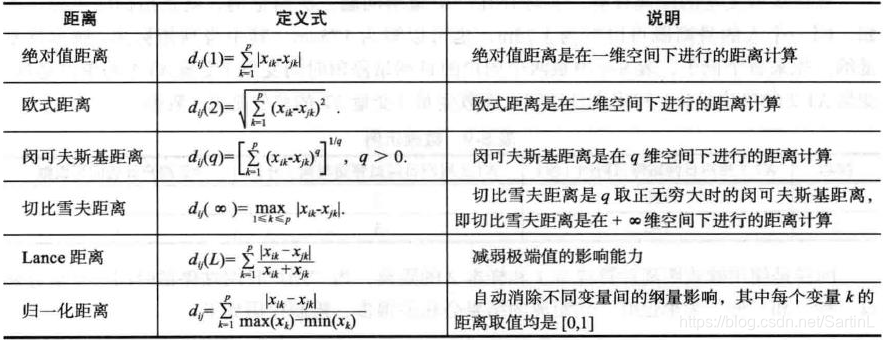

算距离

距离越近应该意味着这两个点属于一个分类的可能性越大。

• 计算的距离衡量包括欧式距离、夹角余弦等。

• 欧式距离:

典型的距离定义

找领居:由哪几个(K)已知样本决定测试样本类别

做分类

- 投票决定:少数服从多数;

- 加权投票法:根据距离的远近,距离越近则权重越大(权重为距离平方的倒数)。

算法流程

- 计算已知类别数据集中的点与当前点之间的距离;

- 按照距离递增次序排序;

- 选取与当前点距离最小的k个点;

- 确定前k个点所在类别对应的出现频率;

- 返回前k个点出现频率最高的类别作为当前点的预测分类。

优点

- 简单,易于理解,易于实现,无需估计参数,无需训练;

- 适合对稀有事件进行分类(例如当流失率很低时,比如低于0.5%,构造流失预测模型);

- 特别适合于多分类问题(multi-modal,对象具有多个类别标签),例如根据基因特征来判断其功能分类,kNN比SVM的表现要好。

缺点

- 对测试样本分类时的计算量大,内存开销大,评分慢;

- 可解释性较差,无法给出决策树那样的规则。

Python实现

sklearn库中提供KNeighborsClassifier实现KNN算法,此外,还提供RadiusNeighborsClassifier(非均匀采样时比较合适,以半径为选取方法)做最近邻分类

• sklearn.neighbors.KNeighborsClassifier(n_neighbors=5 #邻居数,默认为5

, weights=‘uniform’ #用于预测的权重方法

, algorithm=‘auto’ #用于计算最近邻的算法(ball_tree、kd_tree、brute、auto)

, leaf_size=30 #传递给BallTree 或KDTree 叶大小

, p=2 #

, metric=‘minkowski’ #用于树的度量距离

, metric_params=None #度量参数

, **kwargs)

导入库:from sklearn.neighbors import KNeighborsClassifier

利用KNN算法实现对鸢尾花分类模型的构建及分类性能的基本评估

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.neighbors import KNeighborsClassifier

iris = load_iris() #鸢尾花数据

#拆分专家样本集

data_tr, data_te, label_tr, label_te = train_test_split(iris.data, iris.target, test_size=0.2)

model = KNeighborsClassifier(n_neighbors=3) #构建模型

model.fit(data_tr, label_tr) #模型训练

pre = model.predict(data_te) #模型预测

print(pre)

acc = model.score(data_te, label_te) #模型在测试集上的精度

print(acc)