一、Logistic回归的认知与应用场景

Logistic回归为概率型非线性回归模型,是研究二分类观察结果与一些影响因素之间关系的

一种多变量分析方法。通常的问题是,研究某些因素条件下某个结果是否发生,比如医学中根据病人的一些症状

来判断它是否患有某种病。

二、LR分类器

LR分类器,即Logistic Regression Classifier。

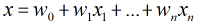

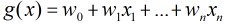

在分类情形下,经过学习后的LR分类器是一组权值,当测试样本的数据输入时,这组权值与测试数据按

照线性加和得到

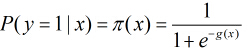

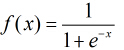

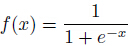

按照sigmoid函数的形式求出

所以Logistic回归最关键的问题就是研究如何求得

三、Logistic回归模型

考虑具有个独立变量的向量

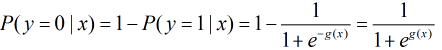

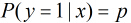

根据观测量相对于某事件发生的概率。那么Logistic回归模型可以表示为

这里

那么

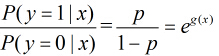

所以事件发生与不发生的概率之比为:

这个比值称为事件的发生比(the odds of experiencing an event),简记为odds。

————————————————

小结:

一般来说,回归不用在分类问题上,因为回归是连续型模型,而且受噪声影响比较大。

如果非要应用在分类问题上,可以使用logistic回归。

logistic回归本质上是线性回归,只是在特征到结果的映射中加入了一层函数映射,

即先把特征线性求和,然后使用函数g(z)将做为假设函数来预测。g(z)可以将连续值映射到0和1上。

————————————————

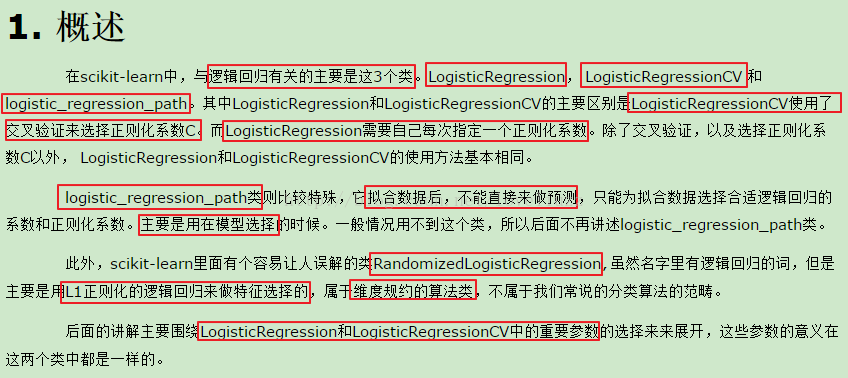

其主要参数

Cs : 浮点数列表或int,可选(默认值= 10)

Cs中的每个值描述正则化强度的倒数。如果Cs为int,则以1e-4和1e4之间的对数标度选择Cs值网格。与支持向量机一样,较小的值指定更强的正则化。

fit_intercept : bool,optional(默认= True)

指定是否应将常量(也称为偏差或截距)添加到决策函数中。

cv : int或交叉验证生成器,可选(默认=无)

使用的默认交叉验证生成器是分层K-Folds。如果提供了整数,则它是使用的折叠数。默认5倍

dual : bool,可选(默认= False)

双重或原始配方。使用liblinear解算器,双重公式仅实现l2惩罚。当n_samples> n_features时,首选dual = False。

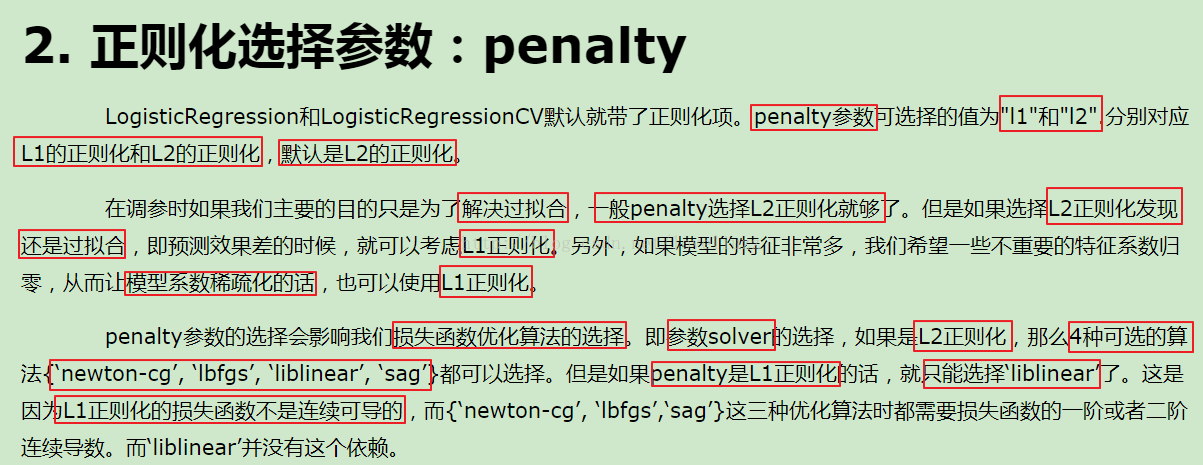

penaly :str,'l1','l2'或'elasticnet',可选(默认='l2')用于指定惩罚中使用的规范。'newton-cg','sag'和'lbfgs'解算器仅支持l2处罚。'elasticnet'仅由'saga'解算器支持。

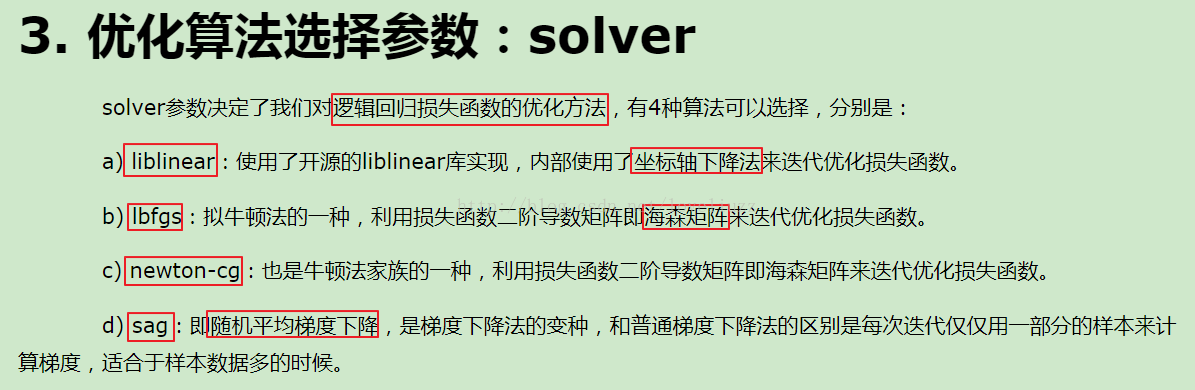

solver:逻辑回归损失函数的优化方法,有四种算法供选择

‘newton-cg’:坐标轴下降法来迭代优化损失函数 ‘lbfgs’:, ‘liblinear’:牛顿法变种 ‘sag’:随机梯度下降

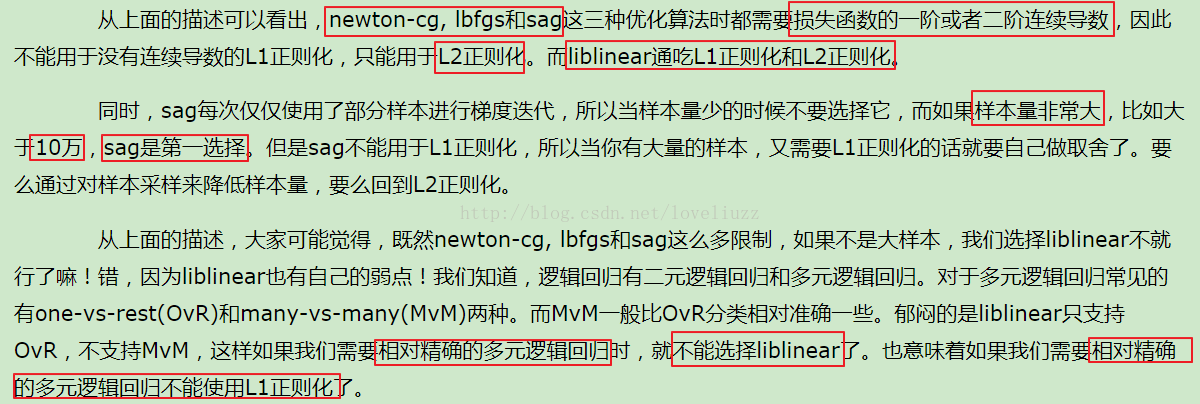

其中‘newton-cg’, ‘lbfgs’, ‘sag’只适用于L2惩罚项的优化,liblinear两种都适用。因为L1正则化的损失函数不是连续可导的,而{‘newton-cg’, ‘lbfgs’,‘sag’}这三种优化算法时都需要损失函数的一阶或者二阶连续导数。而‘liblinear’并没有这个依赖。

当样本数目比较大时,使用sag效果较好,因为它只使用一部分样本进行训练。

a) liblinear:使用了开源的liblinear库实现,内部使用了坐标轴下降法来迭代优化损失函数。

b) lbfgs:拟牛顿法的一种,利用损失函数二阶导数矩阵即海森矩阵来迭代优化损失函数。

c) newton-cg:也是牛顿法家族的一种,利用损失函数二阶导数矩阵即海森矩阵来迭代优化损失函数。

d) sag:即随机平均梯度下降,是梯度下降法的变种,和普通梯度下降法的区别是每次迭代仅仅用一部分的样本来计算梯度,适合于样本数据多的时候。

维度<10000时,lbfgs法比较好, 维度>10000时, cg法比较好,显卡计算的时候,lbfgs和cg都比seg快

tol : float,optional(默认值= 1e-4)容忍停止标准。

max_iter : int,optional(默认值= 100) 优化算法的最大迭代次数。

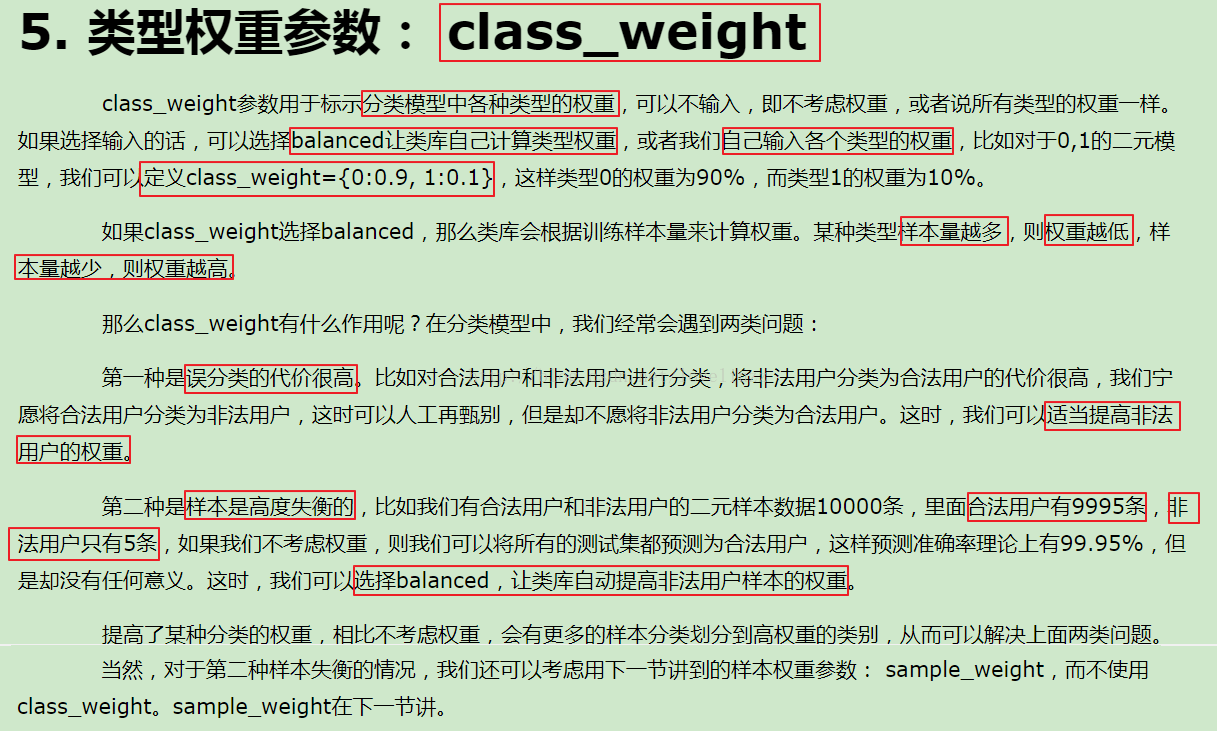

class_weight : dict或'balanced',可选(默认=无)与表单中的类相关联的权重。如果没有给出,所有课程都应该有一个重量。{class_label: weight}“平衡”模式使用y的值自动调整与输入数据中的类频率成反比的权重。n_samples / (n_classes * np.bincount(y))请注意,如果指定了sample_weight,这些权重将与sample_weight(通过fit方法传递)相乘。版本0.17中的新功能: class_weight =='balanced'

n_jobs : int或None,可选(默认=无)交叉验证循环期间使用的CPU核心数。 None除非在joblib.parallel_backend上下文中,否则表示1 。 -1表示使用所有处理器。有关 详细信息,请参阅词汇表。

verbose : int,optional(默认值= 0)对于'liblinear','sag'和'lbfgs'求解器将详细设置为任何正数以表示详细程度。

refit : bool,optional(默认= True)如果设置为True,则在所有折叠中对得分进行平均,并且获取对应于最佳得分的coefs和C,并且使用这些参数进行最终的改装。否则,对应于折叠的最佳分数的coefs,intercepts和C被平均。

intercept_scaling : float,optional(默认值= 1)仅在使用求解器“liblinear”且self.fit_intercept设置为True时有用。在这种情况下,x变为[x,self.intercept_scaling],即具有等于intercept_scaling的常数值的“合成”特征被附加到实例向量。截距变成了。intercept_scaling * synthetic_feature_weight注意!合成特征权重与所有其他特征一样经受l1 / l2正则化。为了减少正则化对合成特征权重(并因此对截距)的影响,必须增加intercept_scaling。

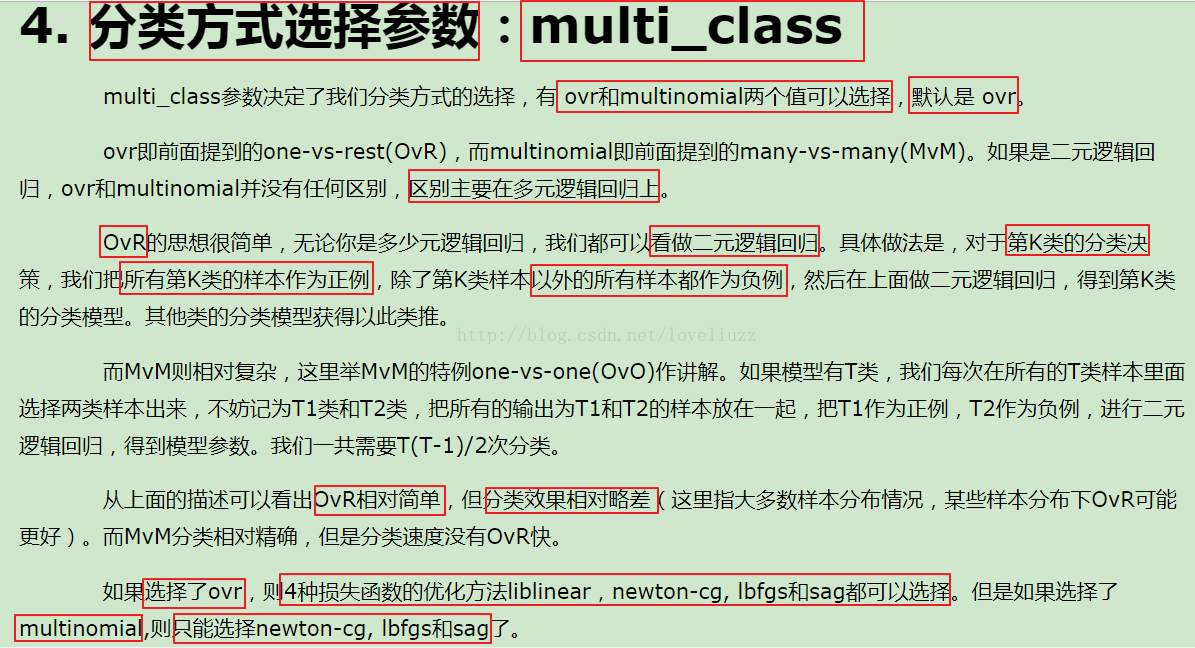

multi_class : str,{'ovr','multinomial','auto'},optional(default ='ovr'如果选择的选项是'ovr',那么二进制问题适合每个标签。对于“多项式”,最小化的损失是整个概率分布中的多项式损失拟合,即使数据是二进制的。当solver ='liblinear'时,'multinomial'不可用。如果数据是二进制的,或者如果solver ='liblinear','auto'选择'ovr',否则选择'multinomial'。版本0.18中的新功能:用于“多项式”情况的随机平均梯度下降求解器。版本0.20更改:默认值将在0.22中从“ovr”更改为“auto”。

random_state : int,RandomState实例或None,可选(默认=无)如果是int,则random_state是随机数生成器使用的种子; 如果是RandomState实例,则random_state是随机数生成器; 如果为None,则随机数生成器是由其使用的RandomState实例np.random。

l1_ratios : float或None列表,可选(默认=无)弹性网混合参数列表,带。仅用于。值0等于使用,而1等于使用 。因为,惩罚是L1和L2的组合。0 <= l1_ratio <= 1penalty='elasticnet'penalty='l2'penalty='l1'0 < l1_ratio <1

————————————————

版权声明:本文为CSDN博主「NongfuSpring-wu」的原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/weixin_41690708/article/details/95171333下面是一些重要参数:

除了上面的六个参数,还有一个参数,Cs,也就是正则化系数,相当于 LogisticRegression里的参数C。

通常使用np.logspace来生成几个正则化系数,供函数挨个尝试,选择一个最好的,这也就是交叉验证的过程。

然后参数cv控制几折交叉验证。

Cs=np.logspace(-2, 2, 20)

顺便说一下吧,如果是LogisticRegression

sklearn.linear_model.LogisticRegression

LogisticRegression(penalty=‘l2’, dual=False,

tol=0.0001, C=1.0, fit_intercept=True,

intercept_scaling=1, class_weight=None,

random_state=None, solver=‘warn’, max_iter=100,

multi_class=‘warn’, verbose=0,

warm_start=False, n_jobs=None)

penalty:惩罚项,可为’l1’ or ‘l2’。‘netton-cg’, ‘sag’, ‘lbfgs’只支持’l2’。

‘l1’正则化的损失函数不是连续可导的,而’netton-cg’, ‘sag’, 'lbfgs’这三种算法需要损失函数的一阶或二阶连续可导。

调参时如果主要是为了解决过拟合,选择’l2’正则化就够了。若选择’l2’正则化还是过拟合,可考虑’l1’正则化。

若模型特征非常多,希望一些不重要的特征系数归零,从而让模型系数化的话,可使用’l1’正则化。

dual:选择目标函数为原始形式还是对偶形式。

将原始函数等价转化为一个新函数,该新函数称为对偶函数。对偶函数比原始函数更易于优化。

tol:优化算法停止的条件。当迭代前后的函数差值小于等于tol时就停止。

C:正则化系数。其越小,正则化越强。

fit_intercept:选择逻辑回归模型中是否会有常数项b

intercept_scaling:

class_weight:用于标示分类模型中各种类型的权重,{class_label: weight} or ‘balanced’。

‘balanced’:类库根据训练样本量来计算权重。某种类型的样本量越多,则权重越低。

若误分类代价很高,比如对合法用户和非法用户进行分类,可适当提高非法用户的权重。

样本高度失衡的。如合法用户9995条,非法用户5条,可选择’balanced’,让类库自动提高非法用户样本的权重。

random_state:随机数种子。

solver:逻辑回归损失函数的优化方法。

‘liblinear’:使用坐标轴下降法来迭代优化损失函数。

‘lbfgs’:拟牛顿法的一种。利用损失函数二阶导数矩阵即海森矩阵来迭代优化损失函数。

‘newton-cg’:牛顿法的一种。同上。

‘sag’:随机平均梯度下降。每次迭代仅仅用一部分的样本来计算梯度,适合于样本数据多的时候。

多元逻辑回归有OvR(one-vs-rest)和MvM(many-vs-many)两种,而MvM一般比OvR分类相对准确一些。但是,'liblinear’只支持OvR。

max_iter:优化算法的迭代次数。

multi_class:‘ovr’ or ‘multinomial’。'multinomial’即为MvM。

若是二元逻辑回归,二者区别不大。

对于MvM,若模型有T类,每次在所有的T类样本里面选择两类样本出来,把所有输出为该两类的样本放在一起,进行二元回归,得到模型参数,一共需要T(T-1)/2次分类。

verbose:控制是否print训练过程。

warm_start:

n_jobs:用cpu的几个核来跑程序。

有了sklearn包之后,很多这种机器学习的算法的代码都比较简单了,下面是logisticsRegression的代码,LogisticsRegressionCV的代码同理可以写出来。

from sklearn import linear_model

logistic = linear_model.LogisticRegression()

#如果用正则化,可以添加参数penalty,可以是l1正则化(可以更有效的抵抗共线性),也可以是l2正则化,如果是类别不均衡的数据集,可以添加class_weight参数,这个可以自己设置,也可以让模型自己计算

logistic = linear_model.LogisticRegression( penalty='l1', class_weight='balanced')

logistic.fit(X_train,y_train)

y_pred = logistic.predict( X_test)

#如果只想预测概率大小,可以用下面这个函数

y_pred = logistic.predict_proba(X_test)