CCNet: Criss-Cross Attention for Semantic Segmentation

简述:

目前,语义分割的主流方法多为以FCN为基础的网络,它们天生局限于局部接受域和短期上下文信息。由于语境信息的不足,这些限制对基于模糊语言的方法产生了很大的负面影响。随后的带有金字塔池模块的PSPNet来捕获上下文信息同样没有达到预期的效果。本文提出CCNet,利用当前的两个交叉关注模块,实现领先性能的分段基准,包括Cityscapes, ADE20K和MSCOCO。

问题or相关工作:

CCNet有明显的两个优势:1是计算量小,仅(H+W-1)元素

2递归方式用CCNet,对一个像素捕捉到全局的contextual information

模型:

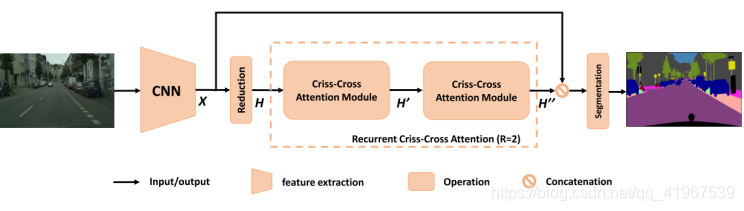

CCNet框架解读:照片输入进网络后,先选用ResNet-101作为backbone,backbone最后两个stage的stride改为1,同时用洞卷积扩大感受野,得到的特征图X是原图的1/8;随后经过1×1卷积降维,得到H;H经过一个criss-cross attention module得到H’,此时H’中的每个位置捕捉到和u在同一行或同一列的context information;H`经过一个相同结构,相同参数的CC module,得到H’’,在H’’中的每个位置,捕捉的是全局性的context information;最后将X与H’’级联,经过分割层得出结果。

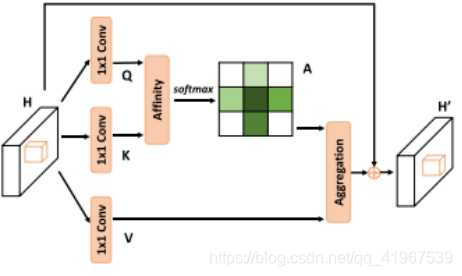

其中criss-cross module结构如下:

其中分为两个主要的部分,一个是Affinity,一个是Aggregation

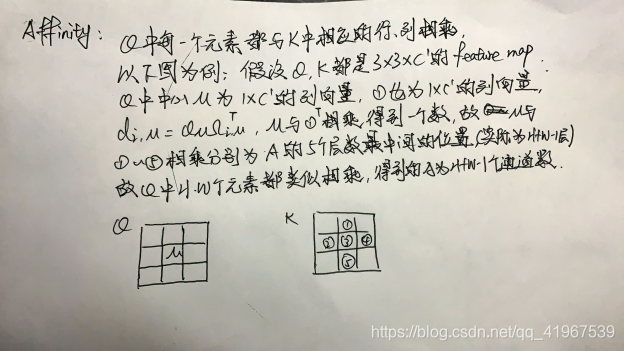

其中,Affinity的表达式及其具体具体操作如下:

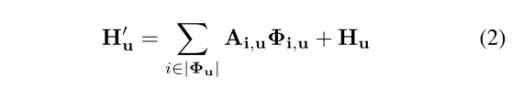

Aggregation的表达式及其具体具体操作如下:

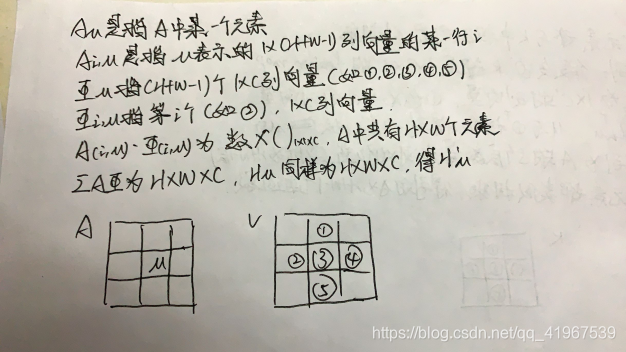

经过一个criss-cross module,结果sparse(稀疏)。但连续经过两个criss-cross module,结果dense,下图中由左上点到右下点需要两步,就解释了其原理。

实验:

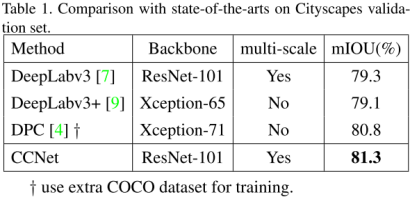

用不同的模型在COCO等数据集上进行测试,可以看出CCNet有明显的优势。

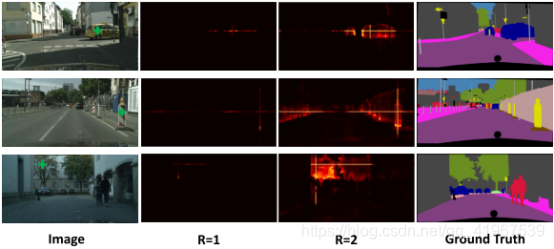

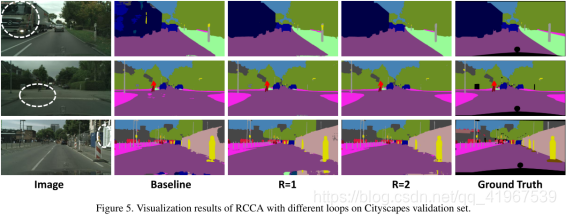

下图的实例分析中,白色圆圈来表示那些容易被错误分类的具有挑战性的区域。

下图中间两幅是RCCA中R = 1、R = 2时的像素级注意图(pixel-wise attention maps)