论文地址:https://arxiv.org/abs/1805.10180v1

摘要:本文利用全局上下文信息在语义分割中的影响提出了一个金字塔注意力网络(PAN)。

与现有的工作不同,我们结合注意机制和空间金字塔对像素级别的标签提取精确稠密特征,而不是复杂的空洞卷积(dilated convolution )和人工设计的解码器网络。具体地,我们引入了特征金字塔注意力模块,在高层特征图输出上执行空间金字塔注意力结构,并结合全局池来学习更好的特征表示。每个解码层使用全局注意力上采样模块,全局上下文信息作为低层特征来选择类别位置细节信息的一个引导。所提出的方法在PASCAL VOC 2012和City scapaces基准上达到了最新的性能,mIOU有了新的记录。在没有用COCO数据集训练的情况下PASCAL VOC 2012的准确度84%。

1.引言

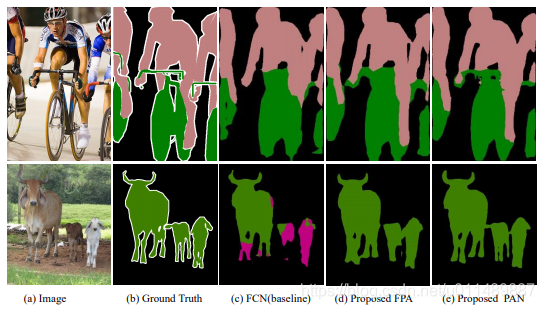

由于丰富的层级特征和端到端的可训练网络使得像素级别的语义分割任务取得了很大的进展。然而在编码高层次特征时,因多次池化空间分辨率变小,全局的信息受到很大损失。如图所示FCN缺乏对小物体进行预测的能力。

在本论文中我们考虑了两个主要的挑战。

第一个问题是,在多尺度的对象的存在导致分类的困难。为了解决这个问题,PSPNET〔33〕或DeDIPAB系统〔2〕执行空间金字塔池化在不同的网格尺度或扩张率(称为Atrous Spatial Pyramid Pooling,或ASPP)。在ASPP模块中,空洞卷积是一种稀疏计算。这可能导致网格伪像[28],PSPNet提出的金字塔池化模块可能会丢失像素级的定位信息。受SeNET〔8〕和Parsenet〔18〕的启发,我们尝试对从CNN得到的高层特征提取更加准确的像素级attention信息。

另一个问题是高层特征在分类方面是有优势的,但在进行二值预测重构原始图像分辨率时是具有短板的。一些U型网络执行复杂的解码器模块,使用低级别的信息来帮助高级特征恢复图像细节,然而它们是耗时的。为了解决这个问题我们提出了一种有效的解码模块—Global Attention Upsample(GAU),它可以提取高层次特征的全局上下文作为对低层特征信息的加权引导,而不会造成太多的计算负担。

综上所述,本文主要有三个贡献。首先,我们提出了一种FPA模块,在FCN中嵌入不同的尺度上下文特征。然后,我们开发了GAU,一个有效的语义分割解码器模块。最后,结合FPA模块和GAU。

2.相关工作

Encoder-decoder:大多数方法试图结合相邻阶段的特征以增强低级别的特征,没有考虑多元化表达与全局上下文信息。

Global Context Attention:受ParseNet(17)启发,global分支在方法〔33〕〔29〕中被采纳以利用全局场景上下文。global context容易扩大感受野和增强像素分类的一致性。DFN(29)将全局平均池化分支嵌入到顶部,将U形结构扩展到V形结构。EncNET[ 31 ]引入了具有SENET(8)类模块的编码层,以捕获编码的语义,并预测对这些编码语义有条件的缩放因子。所有这些结果都在不同的数据集上表现优异。在本文中,我们应用全局池操作作为附加模块添加到解码器分支来选择有判别力的多分辨率特征表示,被证明是有效的。

Spatial Pyramid:这种模型应用平行空间金字塔池化以利用多尺度上下文信息,空间金字塔池[7][30]被广泛应用,为整体场景的解释,特别是多尺度中变化差异大的物体提供了良好的表达。在此基础上,PSPNET[33]和DEEPLAB系列[3][2]扩展了全局池化to the Spatial Pyramid Pooling and Atrous Spatial Pyramid Pooling。这些模型显示了高质量的分割结果,然而通常需要大量的计算资源。

3.方法

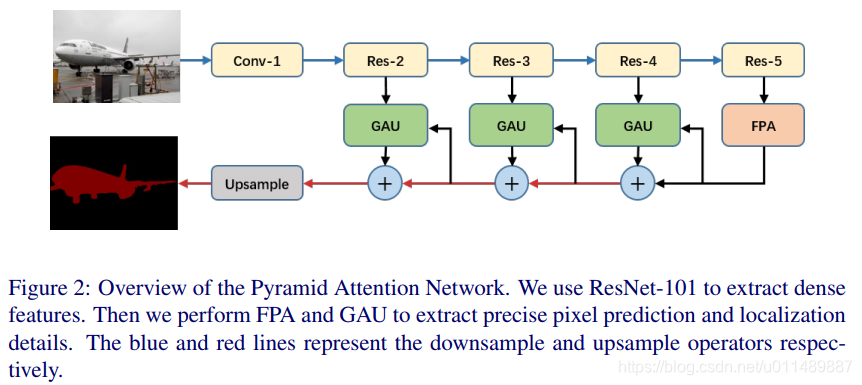

这部分我们介绍提出的Feature Pyramid Attention(FPA) 模块and Global Attention Upsample(GAU) 模块。整体网络架构如下:

3.1 Feature Pyramid Attention (FPA)

最近的一些模型,如PSPnet[33]或Deeplab[2]应用空间金字塔池化或Atrous Spatial Pyramid Pooling。空洞卷积可能导致局部信息丢失,这可能对特征图的局部一致性造成不利影响。PSPnet中提出的金字塔池化模块在不同尺度的池化操作中会丢失像素定位信息。

在注意力机制的启发下,我们考虑了如何为从CNN中提取的高级特征提供精确的像素级attention。

在当前的语义分割中结构上,金字塔结构可以提取不同尺度的特征信息,在像素级有效地增加感受野(此处原论文应该是把receptive field错写成respective field),而这种结构缺乏全局性上下文信息来聚焦选择特征通道,如Senet[8]和Encnet[31]中所述。另一方面,使用channel-wise attention vector不足以有效的提取多尺度信息而且缺乏像素信息。

通过以上观察,我们提出了特征金字塔注意(FPA)模块。FPA模块通过实现像特征金字塔网络这样的U形结构,融合了三种不同金字塔尺度下的特征。为了更好的提取上下文信息,在金字塔结构中分别使用3×3、5×5、7×7的卷积。由于高层特征图的分辨率很小,因此使用大的卷积核不会计算负担太大。

然后金字塔结构整合了不同尺度的信息,更能准确融合邻域尺度的上下文特征。将通过1×1的卷积操作之后CNN的原始特征与金字塔的注意特征相乘。我们还引入了全局池化分支与输出特征相concatenate,可进一步提高我们的FPA模块性能。

利用空间金字塔结构,特征金字塔注意模块可以融合不同尺度的上下文信息,为高层次特征提供更好的像素级注意。

不同于PSPnet或ASPP concatenates 不同的金字塔尺度特征图(在通道减少卷积层之前的特征图),我们的上下文信息特征与原始特征图进行卷积,计算量小。

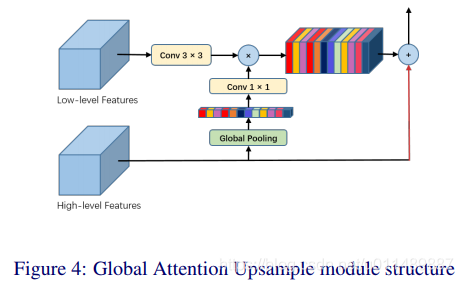

3.2 Global Attention Upsample

目前语义分割网络中有几种解码器结构设计。PSPnet[33]或Deeplab[2]直接使用双线性上采样,这可以看作是原始的解码器。DUC[28]采用大通道卷积结合整形作为一步解码器模块。原始解码器和一步式解码器都缺乏不同的尺度低层次的特征图信息,会对恢复到原空间分辨率到造成不利影响。而普通的编码器-解码器网络主要考虑使用不同的尺度特征信息,逐步恢复解码器中目标边界。此外,这种类型的大多数方法通常使用复杂的解码器块,而需要大量的计算资源。

最近的研究表明,将CNN与精心设计的金字塔模块相结合能够获得相当大的性能和获取类别信息的能力。我们认为解码器模块的主要特点是恢复类别像素定位。还可以使用具有丰富类别信息的高层特征来权衡选择精确分辨率细节的低层信息。

GAU模块执行全局池化,以提供全局上下文,来指导低层特征选择类别定位信息。详细地说,我们对低层特征进行3×3卷积,以减少特征图的通道。从高层特征生成的全局上下文是通过1×1卷积,然后进行BN和非线性,再乘以低层特征。最后高层特征加上加权后低层特征,逐渐向上采样。该模块可以更有效地部署不同尺度的特征图,并使用高层特征图,以简单的方式向低层特征图提供指导信息。