版权声明:来自原创,转载需注明来源 https://blog.csdn.net/Formlsl/article/details/82149551

Learning to Adapt Structured Output Space for Semantic Segmentation——CVPR2018

前面【1】一篇,有提到用对抗loss和半监督来做分割。而这篇可以说是对抗loss和域适配结合起来做的另一个工作了。

背景:

- 知识迁移和域适配:目标域(target domains,没有标注)和源域(source domains,有标注)是具有相近的性质,知识迁移和域适配都是试图从源域学习到一定知识,任何能很好的适合目标域,从而减少不必要的人力物力。

- 像图像的appearance ,shape and context,很难通过一个网络把每个视觉信息完全编码好,像医学图像,就是纹理和shape结构信息特别丰富,比自然图像可能高出几个难度集。Lecun也曾说过结构信息很难目前的通过深度神经网络编码。但是appearance确一般能识别很出色,而这篇文章的尽管源域和目标源appearance相差很大,但是理论上也可以做到很出色。

数据集:

GTA5,SYNTHIA

方法

网络结构:

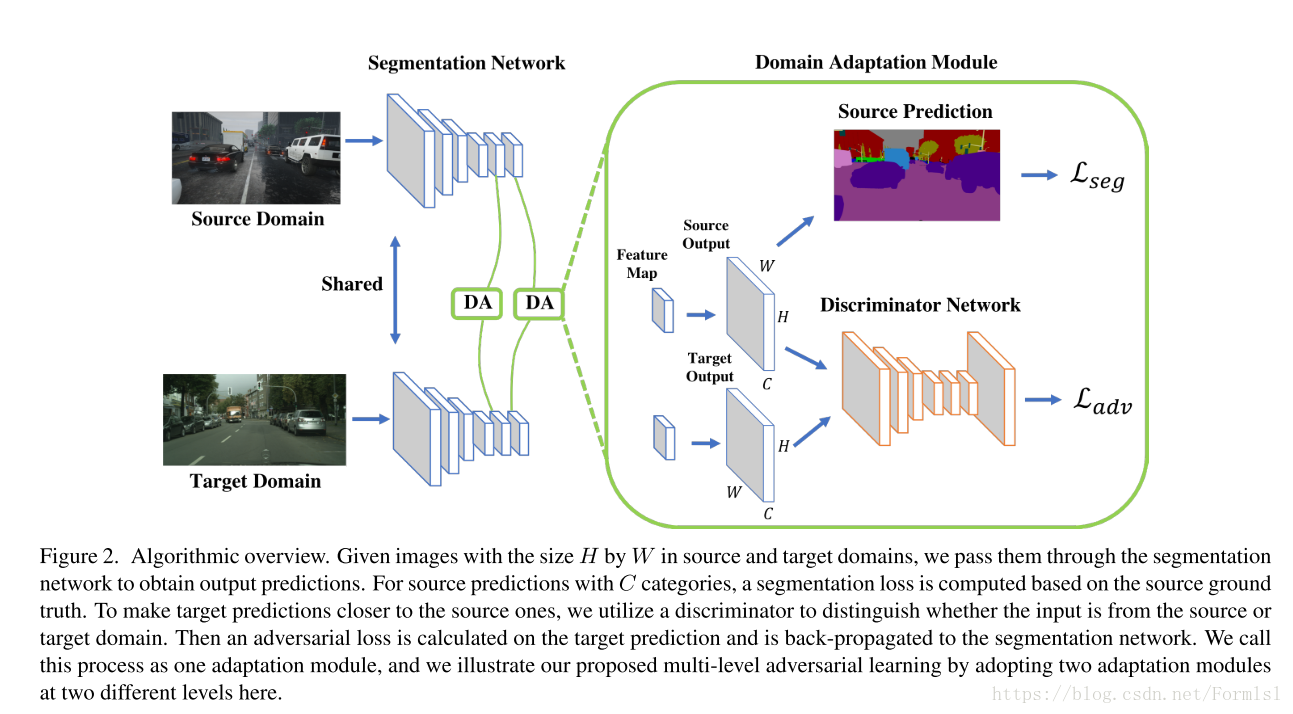

同上篇文章一样,分成两个网络,分割网络G,和判别器网络$D_i$(这篇文章称为域适配模块,i表示判别器有多层次水平对抗学习)。

G:基于Deeplab-v2+ResNet-101+ASPP的baseline网络

D: 具体可以看UNSUPERVISED R EPRESENTATION LEARNINGWITH DEEP CONVOLUTIONAL GENERATIVE ADVERSARIAL NETWORKS的判别器部分,没有很大的改动。

G和D与上偏网络结构几乎相似,文章的重点同样也不在这。而在于用了多个D,多个适配域模块(图一中是用了2个,paper用这个原因是什么?)。

训练

生成器loss:和【1】一样

分割loss:和【1】一样

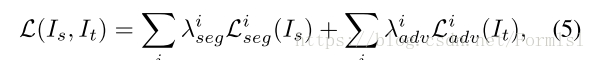

多层次对抗学习(multi-level Adversarial Learning) loss:

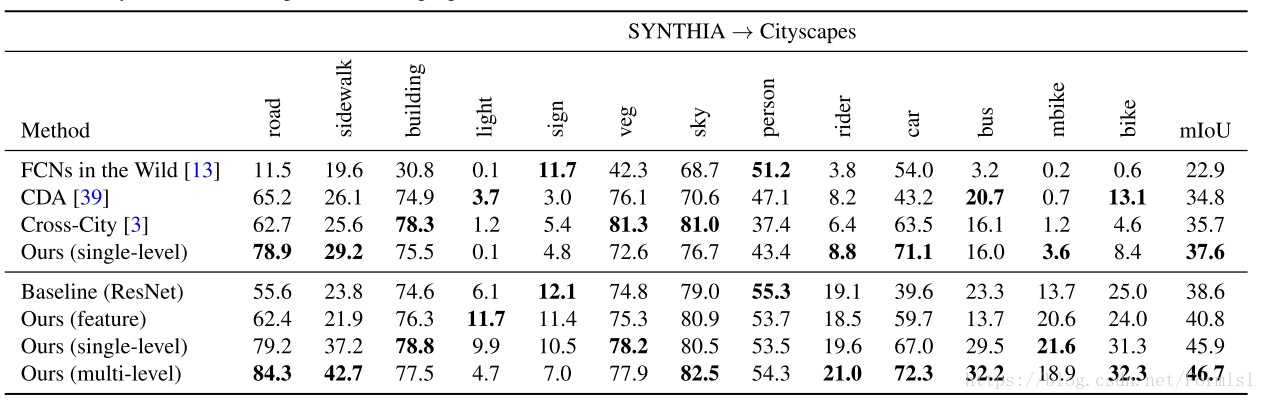

结果:

看下在多层次对抗学习和单层次对抗学习的差距:在这个数据集上,对于面积较大物体的好像提高的较为明显。

总结:创新点在于多层次对抗学习,这大概是能发CVPR的原因?

引用

【1】Adversarial Learning for Semi-Supervised Semantic Segmentation